版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/Julialove102123/article/details/88893441

- 研究方向:

Dehazing,cGAN

- motivation

对于直接通过算法复原有雾的图像现有的算法可分为基于自适应色彩对比度增强的方法和基于正则化的方法,前者存在视觉伪影,后者由于 transmission map不准确,活影响图像去噪的清晰性。为了解决这些问题,作者基于cGAN,提出了一个端到端的可训练的神经网络。但与基本的cGAN不同,作者提出的是encoder and decoder结构,可以生成更好的结果。

- 网络结构

网络结构 :

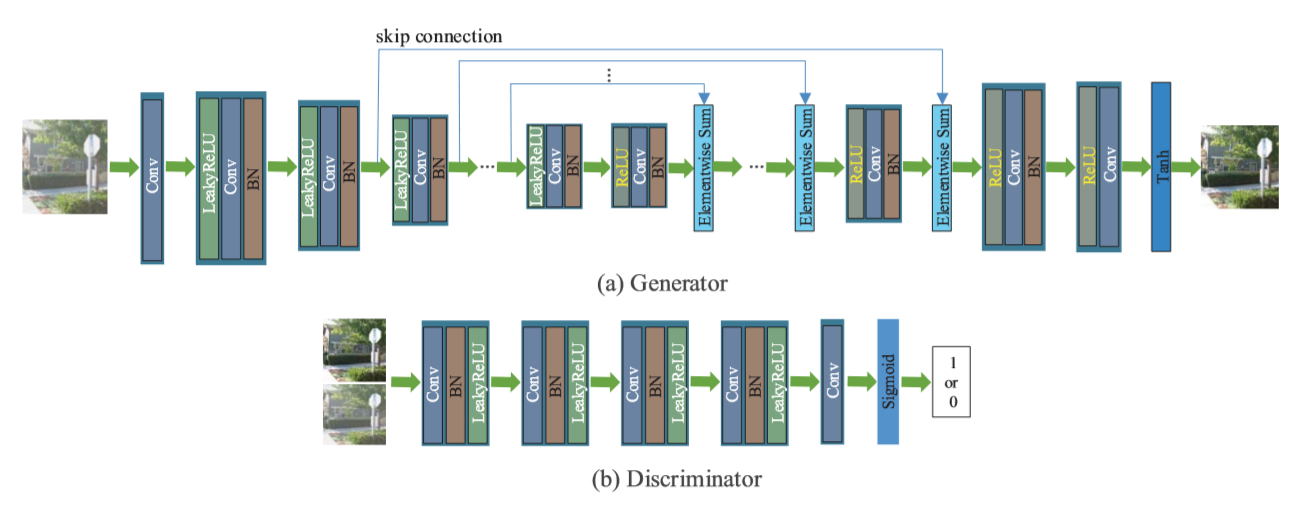

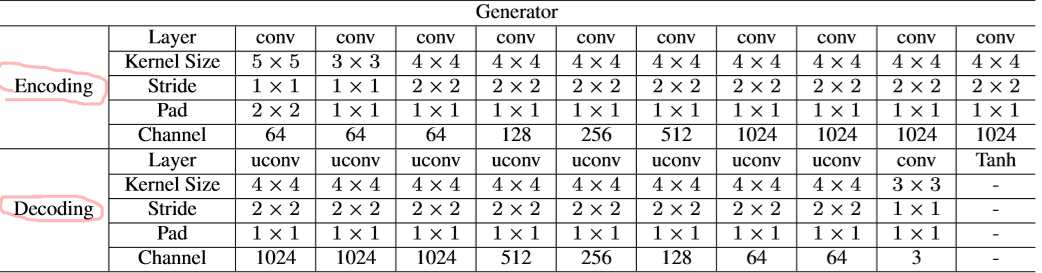

生成器:包括encoding和decoding,作者受ResNet和U-Net启发,在对称层引入了跳层连接,没有简单地将对称层的所有通道连接起来,而是采用求和方法来获取更多有用的信息。

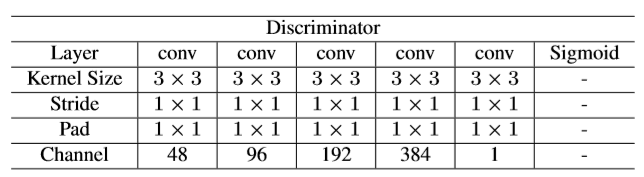

鉴别器:采用基本的卷积、批量正则化、LeakyReLU激活函数运算,用于鉴别输入的图像是真的还是假的。

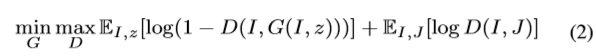

目标函数:

损失函数:

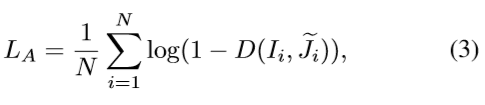

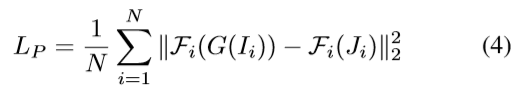

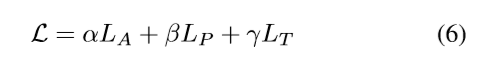

损失函数分三部分,对抗损失+感知损失(改善SSIM)+像素级损失(VGG网络,改善PSNR)

对抗损失:

感知损失:

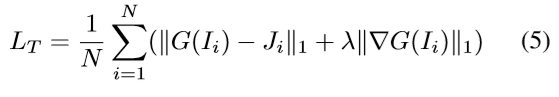

像素级损失:

其中J是清晰图像,I是有雾的图像。

综合以上3个损失:

- 实验细节

合成数据集:

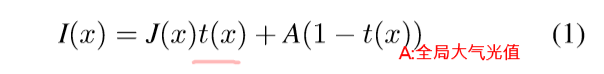

作者认为去雾的过程可以描述为以下模型:

I是有雾的图像,J是去雾图像,t是传播图,A是全局大气光值,利用以上模型生成有雾的图像。

条件对抗网络的网络配置:

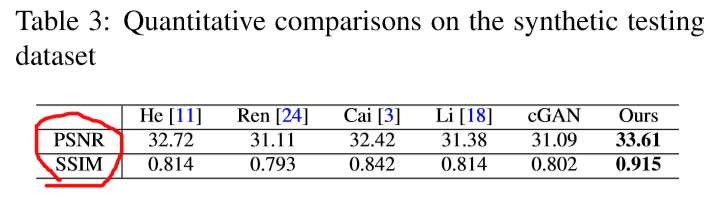

实验效果(与其他方法对比):

评价指标(与其他方法对比):

- code

https://github.com/hong-ye/dehaze-cGAN