1.摘要

多模态(MM)图像融合旨在生成保持不同模态优点的融合图像,例如功能亮点和详细纹理。为了解决建模跨模态特征和分解期望模态特定和模态共享特征的挑战,我们提出了一种新颖的基于相关性驱动的特征分解融合(CDDFuse)网络。首先,CDDFuse使用Restormer块提取跨模态浅层特征。然后,我们引入了双分支Transformer-CNN特征提取器,Lite Transformer(LT)块利用长程注意力来处理低频全局特征和可逆神经网络(INN)块专注于提取高频局部信息。进一步提出了一种基于嵌入信息的相关性驱动损失,使低频特征相关而高频特征无关。然后,基于LT的全局融合和基于INN的局部融合层输出融合图像。广泛的实验证明,我们的CDDFuse在多个融合任务中取得了令人满意的结果,包括红外-可见图像融合和医学图像融合。我们还展示了CDDFuse在统一基准测试中可以提升下游红外-可见语义分割和物体检测的性能。

2.引言

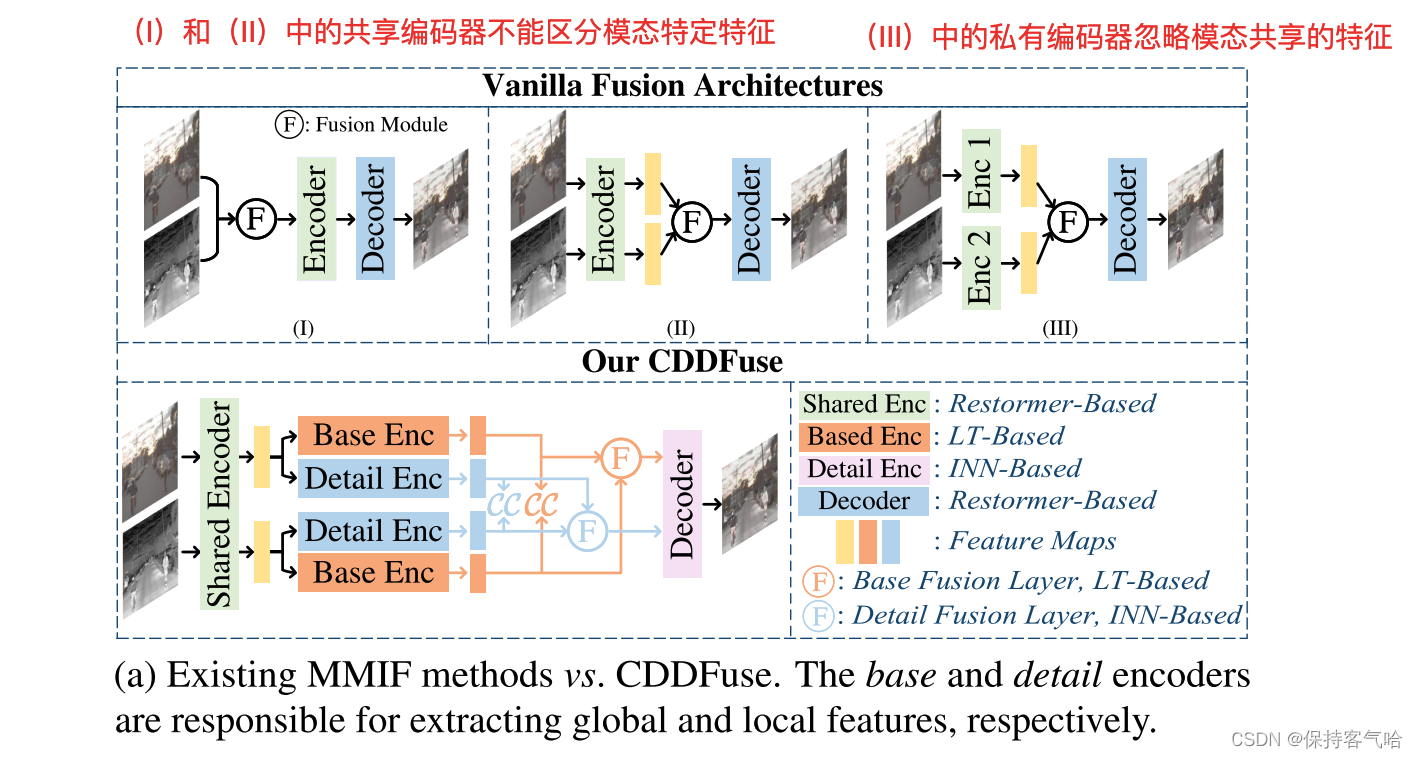

近年来,已经开发了许多方法来解决多模态图像融合(MMIF)的挑战。一种常见的流程展示了使用基于卷积神经网络(CNN)的特征提取和重构的自编码器(AE)方式取得了有希望的结果,如图1a所示。然而,现有方法存在三个主要缺点。首先,CNN的内部工作机制难以控制和解释,导致跨模态特征的提取不足。例如,在图1a中,(I)和(II)中的共享编码器无法区分模态特定特征,而(III)中的私有编码器则忽视了模态之间共享的特征。其次,上下文无关的CNN只能提取相对较小感受野范围内的局部信息,很难提取用于生成高质量融合图像所需的全局信息。因此,仍然不清楚CNN的归纳偏好是否足够强大以提取所有模态的特征。第三,融合网络的前向传播往往导致高频信息的丢失。我们的工作探索了一种更合理的范式来解决特征提取和融合中的挑战。

首先,我们旨在为提取的特征添加相关性限制,并限制解空间,从而提高特征提取的可控性和可解释性。我们的假设是,在多模态图像融合任务中,两种模态的输入特征在低频率上是相关的,代表着模态共享的信息,而高频特征是不相关的,代表着各自模态的独特特征。以红外-可见融合(IVF)为例,由于红外图像和可见光图像来自同一场景,两种模态的低频信息包含统计共现信息,例如背景和大尺度环境特征。相反,两种模态的高频信息是相互独立的,比如可见光图像中的纹理和细节信息以及红外图像中的热辐射信息。因此,我们旨在通过增加和减少低频特征和高频特征之间的相关性,分别促进模态特定和模态共享特征的提取。

其次,Vision Transformers 最近在计算机视觉领域展现出令人印象深刻的结果,利用了自注意机制和全局特征提取。然而,基于Transformer的方法在计算方面非常昂贵,这给图像融合架构在考虑效率和性能之间的权衡留下了空间。因此,我们提出将CNN中局部上下文提取和计算效率的优势与Transfor-mer中全局注意力和远程依赖建模的优势进行整合,以完成MMIF任务。

第三,为了解决丢失所需高频输入信息的挑战,我们采用了可逆神经网络(INN)的构建块。INN的提出与可逆性的设计,防止信息丢失,通过相互生成的输入和输出功能,并与我们的目标保持在融合图像中的高频功能。

为此,我们提出了相关性驱动的特征分解融合(CDDFuse)模型,其中modalityspecific和modality-shared特征提取实现了一个双分支编码器,与解码器重建的融合图像。工作流程如图1a和2。我们的贡献可以概括为四个方面:

- 我们提出了一个双分支Transformer-CNN框架,用于提取和融合全局和局部特征,更好地反映了不同模态的特征。

- 我们对CNN和Transformer模块进行了改进,以更好地适应MMIF任务。具体而言,我们首次利用INN模块进行无损信息传输,并使用LT模块在融合质量和计算成本之间进行权衡。

- 我们提出了一种基于相关性的分解损失函数,以强制执行模态共享/特定特征分解,使跨模态的基础特征相关,并在不同模态中去相关详细的高频特征

- 我们的方法在IVF和MIF的图像融合性能方面取得了领先地位。我们还提出了一个统一的度量基准,以证明IVF融合图像如何促进下游的MM目标检测和语义分割任务。

3.方法

在本节中,我们首先介绍了CDDFuse的工作流程和各个模块的详细结构。为了简单起见,在下面的讨论中,我们将低频长范围特征表示为基本特征,将高频局部特征表示为细节特征。

我们的CDDFuse包含四个模块,即双分支编码器用于特征提取和分解,解码器用于重建原始图像(在训练阶段I)或生成融合图像(在训练阶段II),以及基础/细节融合层分别用于融合不同频率的特征。详细的工作流程如图2所示。请注意,CDDFuse是一个通用的多模态图像融合网络,我们只以IVF任务作为示例来解释CDDFuse的工作原理。

在CDDFuse网络中,训练阶段1的作用是利用配对的红外图像和可见光图像进行训练,以提取浅层特征和分解不同模态的特征。在这个阶段,我们将红外图像和可见光图像输入到SFE(特征提取器)中,提取浅层特征。然后,我们使用基于LT块的BTE(低频特征提取器)和基于INN的DCE(高频特征提取器)来分别提取低频基础特征和高频细节特征。

3.1 Encoder

首先,为了清晰地表示公式,我们定义一些符号。输入的红外和可见图像对分别表示为 I ∈ R H × W I∈R^{H×W} I∈RH×W和 V ∈ R H × W × 3 V∈R^{H×W×3} V∈RH×W×3。共享特征编码器由 S ( ⋅ ) S(·) S(⋅) 表示,基础 Transformer 编码器由 B ( ⋅ ) B(·) B(⋅) 表示,细节 CNN 编码器由 D ( ⋅ ) D(·) D(⋅) 表示。

-

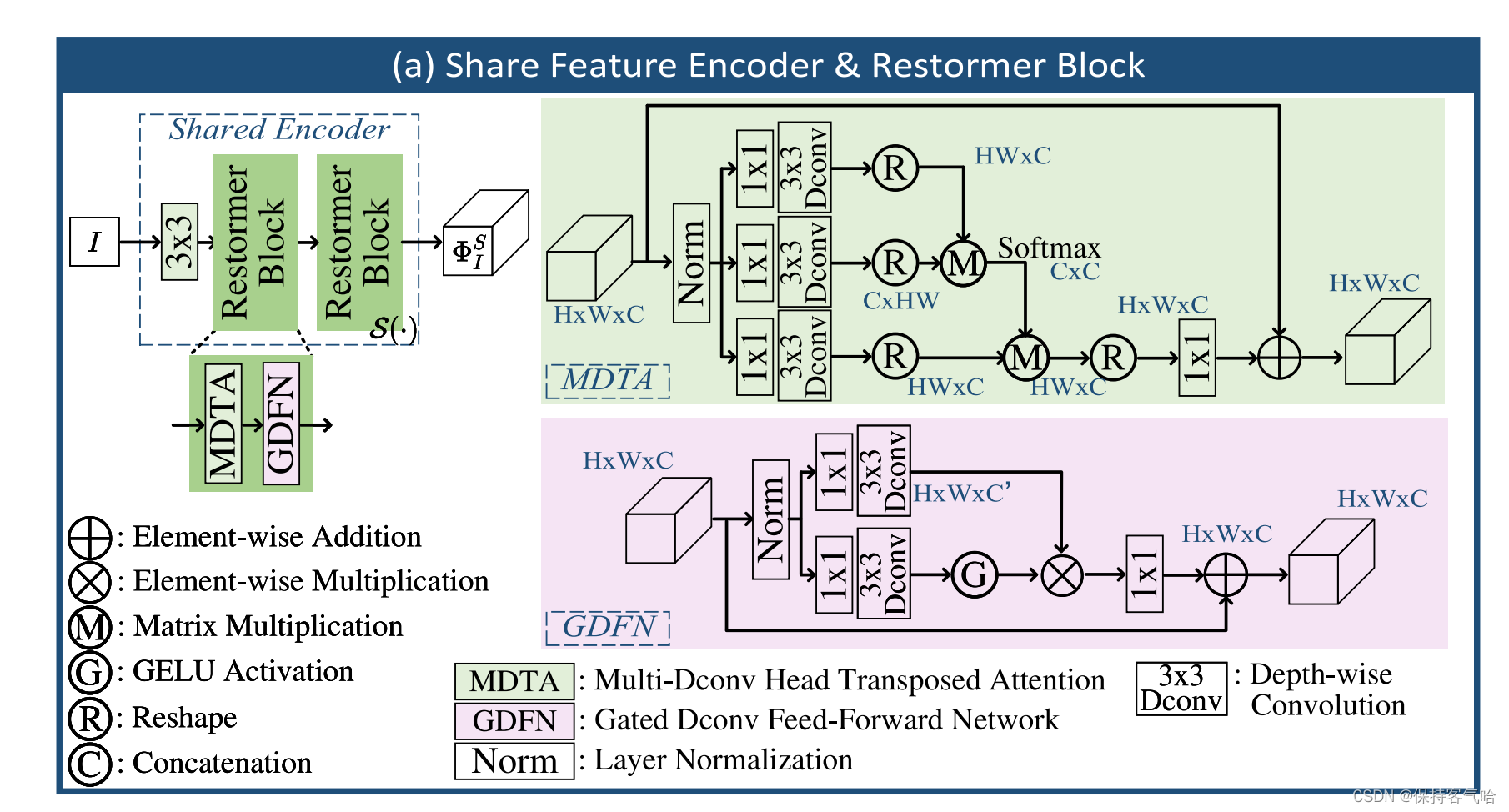

Shared Encoder: SFE旨在从红外和可见输入 {I, V} 中提取浅层特征 Φ I S , Φ V S {Φ^S_I, Φ^S_V} ΦIS,ΦVS,即: Φ I S = S ( I ) , Φ V S = S ( V ) ( 1 ) Φ^S_I = S(I),\quad Φ^S_V=S(V)\quad (1) ΦIS=S(I),ΦVS=S(V)(1)

在SFE中使用Restormer block的原因是利用维度间的自注意力机制提取全局特征,因此可以不增加算力的情况下提取跨模态浅层特征。因此,它可以提取跨模态浅层特征,而不会增加太多的计算。我们使用的Restormer块的结构可以参考补充材料或原始论文[Restormer: Efficient transformer for high-resolution image restoration]()。

-

Base transformer encoder: BTE用于从共享特征中提取低频基本特征 Φ I B , Φ V B {Φ^B_I, Φ^B_V} ΦIB,ΦVB ,即: Φ I B = B ( Φ I S ) , Φ V B = B ( Φ V S ) ( 2 ) Φ^B_I = B(Φ^S_I),\quad Φ^B_V = B(Φ^S_V)\quad (2) ΦIB=B(ΦIS),ΦVB=B(ΦVS)(2)

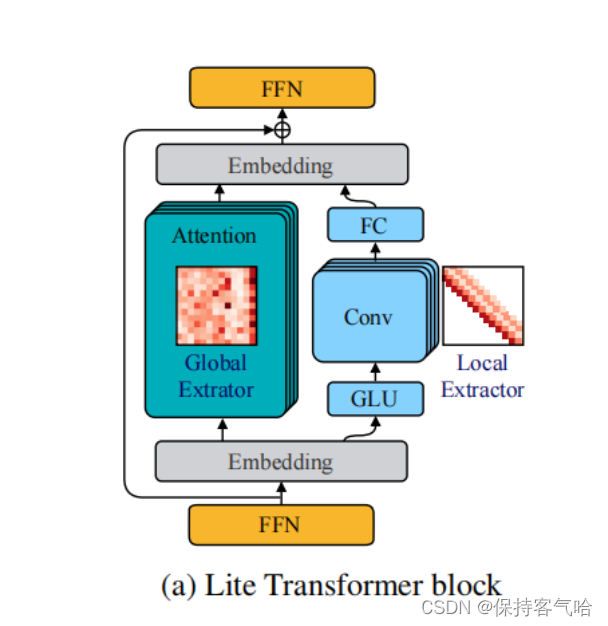

为了提取远程依赖特征,我们使用具有空间自注意力的Transformer。考虑到平衡性能和计算效率,我们使用LT块(Lite transformer with long-short range attention)作为BTE的基本单元。通过扁平化前馈网络的结构,将Transformer块的瓶颈部分展平,LT块缩小了嵌入维度,从而减少了参数数量,同时保持了相同的性能,满足了我们的期望。

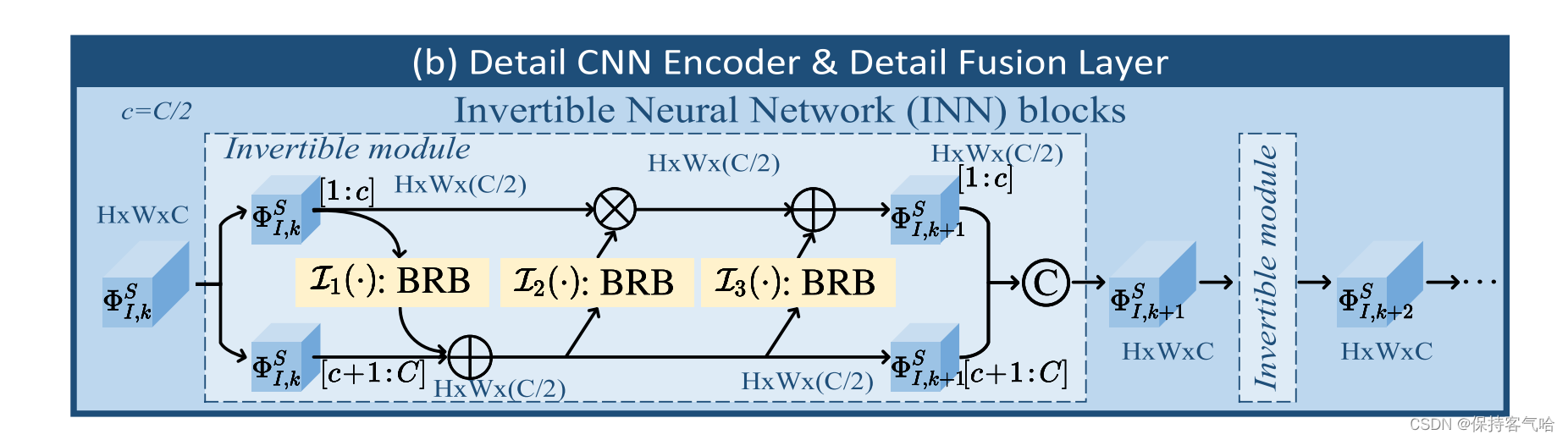

Detail CNN encoder: 与BTE相反,DCE从共享特征中提取高频细节信息,其被公式化为: Φ I D = D ( Φ I S ) , Φ V D = D ( Φ V S ) ( 3 ) Φ^D_I = D(Φ^S_I),\quad Φ^D_V = D(Φ^S_V)\quad (3) ΦID=D(ΦIS),ΦVD=D(ΦVS)(3)

考虑到细节特征中的边缘和纹理信息对于图像融合任务非常重要,我们希望DCE中的CNN架构能尽可能地保留更多的细节信息。INN 模块是通过可逆性设计让输入和输出特征的相互生成来防止信息丢失,符合融合图像中保留高频特征的目标。因此,它可以被看作是一个无损特征提取模块,在这里非常适用。因此,我们采用了具有仿射耦合层的INN块。在每个可逆层中,变换为:

Φ I , k + 1 S [ c + 1 : C ] = Φ I , k S [ c + 1 : C ] + I 1 ∗ Φ I , k S [ 1 : c ] , Φ^S_{I,k+1} [c + 1:C] = Φ^S_{I,k} [c + 1:C] + I_1 * Φ^S_{I,k }[1 : c], ΦI,k+1S[c+1:C]=ΦI,kS[c+1:C]+I1∗ΦI,kS[1:c],

Φ I , k + 1 S [ 1 : c ] = Φ I , k S [ 1 : c ] ∗ e x p ( I 2 ∗ Φ I , k + 1 S [ c + 1 : C ] ) + I 3 ∗ Φ I , k + 1 S [ c + 1 : C ] Φ^S_{I,k+1} [1 : c] = Φ^S_{I,k} [1 : c] * exp(I_2 * Φ^S_{I,k+1} [c + 1:C]) + I_3 * Φ^S_{I,k+1} [c + 1:C] ΦI,k+1S[1:c]=ΦI,kS[1:c]∗exp(I2∗ΦI,k+1S[c+1:C])+I3∗ΦI,k+1S[c+1:C]

Φ I , k + 1 S = C A T ( Φ I , k + 1 S [ 1 : c ] , Φ I , k + 1 S [ c + 1 : C ] ) ( 4 ) Φ^S_{I,k+1} = CAT(Φ^S_{I,k+1} [1 : c], Φ^S_{I,k+1} [c + 1:C]) \quad (4) ΦI,k+1S=CAT(ΦI,k+1S[1:c],ΦI,k+1S[c+1:C])(4)

上式过程和图2的b中过程是对应的,图中BRB的结构如图2中的d(来源于MobileNetV2),每个可逆层中的BRB都可以看做是无损信息映射。其中,符号⊙表示哈达玛积(Hadamard product), Φ I , k S [ 1 : c ] ∈ R h × w × c Φ^S_{I,k} [1 : c] ∈ R^{h×w×c} ΦI,kS[1:c]∈Rh×w×c表示第k个可逆层(k = 1, · · · , K)中输入特征的第1到第c个通道,CAT(·)表示通道拼接操作, I i I_i Ii(i = 1, · · · , 3)是任意的映射函数。具体的计算细节可以参考图2(d)和补充材料。在每个可逆层中, I i I_i Ii可以设置为任意映射,而不会影响该可逆层中的无损信息传输。考虑到计算消耗和特征提取能力之间的权衡,我们在 I i I_i Ii中采用了MobileNetV2中的瓶颈残差块(BRB)。最后,通过将方程(4)中的下标从I替换为V,以相同的方式获得 Φ I D = Φ I , K S Φ^D_I = Φ^S_{I,K} ΦID=ΦI,KS和 Φ V D Φ^D_V ΦVD。

3.2 Fusion Layer

基础/细节融合层的功能是分别融合基础和细节特征。考虑到基础/细节特征融合的归纳偏差应该与编码器中的基础/细节特征提取类似,我们在基础和细节融合层中使用了LT和INN块,其中:

Φ B = F B ⊙ ( Φ I B , Φ I B ) , Φ D = F D ⊙ ( Φ I D , Φ V D ) ( 5 ) Φ^B = F_B ⊙ (Φ^B_I, Φ^B_I),\quad Φ^D = F_D ⊙ (Φ^D_I, Φ^D_V)\quad (5) ΦB=FB⊙(ΦIB,ΦIB),ΦD=FD⊙(ΦID,ΦVD)(5)

其中, F B F_B FB和 F D F_D FD分别表示基础和细节融合层。

3.3 Decoder

在解码器 D C ( ⋅ ) DC(·) DC(⋅) 中,分解后的特征在通道维度上被串联作为输入,而原始图像(训练阶段I)或融合图像(训练阶段II)则是解码器的输出,表示为:

- Stage 1: I ^ = D C ( Φ I B , Φ I D ) , V ^ = D C ( Φ V B , Φ V D ) \hat{I} = DC (Φ^B_I, Φ^D_I),\hat{V} = DC (Φ^B_V, Φ^D_V) I^=DC(ΦIB,ΦID),V^=DC(ΦVB,ΦVD);

- Stage 2: F = D C ( Φ B , Φ D ) ( 6 ) F = DC (Φ^B, Φ^D) \quad (6) F=DC(ΦB,ΦD)(6)

由于这里的输入涉及跨模态和多频特征,我们保持解码器的结构与SFE的设计一致,即使用Restormer块作为解码器的基本单元。

在文本2中,第一阶段训练的输出结果被描述为“浅层特征”、“低频基础特征”和“高频细节特征”,而没有提到生成源图像。此外,在文本1中,第一阶段训练的输出结果被描述为“红外图像和可见光图像的特征表示”,而不是源图像本身。因此,可以推断出第一阶段训练的输出结果不是源图像,而是图像的特征表示。

3.4 Two Stage Training

开始之前我有个疑问就是为什么要分两个训练阶段?

答:因为训练目标不同,一阶段为了重构原图(训练AE),二阶段为了融合(训练AE+融合层);encoder和decoder是继续训练的。

代码当中testIVF默认是把红外和可见光图像都转变成灰度图1通道的方式来进行处理数据,尝试把输入数据改成RGB模式跑不通,模型默认的输入数据是1通道,预训练权重文件也是1通道,三通道的结果是要重新训练吗?作者的效果展示最终输出的结果也有RGB三通道,作者是在哪里实现的呢?

答:一般都是先把RGB图转为YCbCr空间后用Y通道单独融合,融合图像再和Cb和Cr两个颜色通道拼接后转回RGB,不建议直接用RGB融合。

MMIF任务面临的一个重要挑战是缺乏准确的真实标签,因此传统的监督学习方法效果有限。在这里,受到[[Hui Li, Xiao-Jun Wu, and Josef Kittler. Rfn-nest: An end-to-end residual fusion network for infrared and visible images.Inf. Fusion, 73:72–86, 2021.]()]的启发,我们采用了一个两阶段的学习方案来端到端地训练我们的CDDFuse模型。

- 训练阶段I:在训练阶段I中,将成对的红外和可见图像{I, V}输入到SFE中提取浅层特征 Φ I S , Φ V S {Φ^S_I, Φ^S_V} ΦIS,ΦVS。然后,利用基于LT块的BTE和基于INN的DCE分别提取低频基础特征 Φ I B , Φ V B {Φ^B_I, Φ^B_V} ΦIB,ΦVB和高频细节特征 Φ I D , Φ V D {Φ^D_I, Φ^D_V} ΦID,ΦVD,针对两种不同的模态。之后,将红外图像的基础特征 Φ I B , Φ I D {Φ^B_I, Φ^D_I} ΦIB,ΦID(或可见图像的基础特征 Φ V B , Φ V D {Φ^B_V, Φ^D_V} ΦVB,ΦVD)进行串联,并输入到解码器中重构原始的红外图像 I ^ \hat{I} I^(或可见图像 V ^ \hat{V} V^)。

- 训练损失在训练阶段I中:

- 总的损失函数 L t o t a l I L^I_{total} LtotalI如下: L t o t a l I = L i r + α 1 L v i s + α 2 L d e c o m p ( 7 ) L^I_{total} = L_{ir} + α_1L_{vis} + α_2L_{decomp} (7) LtotalI=Lir+α1Lvis+α2Ldecomp(7)

- 其中 L i r L_{ir} Lir和 L v i s L_{vis} Lvis分别是红外图像和可见图像的重构损失, L d e c o m p L_{decomp} Ldecomp是特征分解损失,而α1和α2是调节参数。重构损失主要确保在编码和解码过程中不会丢失图像中的信息,因为第一阶段的模型可以看作是先分解再合成的过程,那么在分解和合成的过程中必然带来着信息丢失,一阶段损失整体是为了编码和解码过程中信息不会损失。即 L i r = L i n t I ( I , I ^ ) + µ L S S I M ( I , I ^ ) ( 8 ) L_{ir} = L^I_{int}(I, \hat{I}) + µLSSIM(I, \hat{I}) \quad (8) Lir=LintI(I,I^)+µLSSIM(I,I^)(8) L i n t I = ∣ ∣ I − I ^ ∣ ∣ 2 2 , L S S I M ( I , I ^ ) = 1 − S S I M ( I , I ^ ) L^I_{int} = ||I - \hat{I}||_2^2,L_{SSIM}(I, \hat{I}) = 1 - SSIM(I, \hat{I}) \quad LintI=∣∣I−I^∣∣22,LSSIM(I,I^)=1−SSIM(I,I^) L v i s L_{vis} Lvis可以以相同的方式获

- 此外,我们提出的特征分解损失 L d e c o m p L_{decomp} Ldecomp如下: L d e c o m p = ( L C C D ) 2 L B C C = ( C C ( Φ I D , Φ V D ) ) 2 C C ( Φ I B , Φ V B ) + ϵ ( 9 ) L_{decomp} = \frac{(L^D_{CC})^2}{LB_{CC}}=\frac{(CC({Φ^D_I, Φ^D_V}))^2}{CC({Φ^B_I, Φ^B_V})+\epsilon} \quad (9) Ldecomp=LBCC(LCCD)2=CC(ΦIB,ΦVB)+ϵ(CC(ΦID,ΦVD))2(9)

-

其中CC(·, ·)是相关系数运算符,而这里的 ϵ \epsilon ϵ被设置为1.01以确保该项始终为正值。简单理解:这个系数越接近于0,那么两者的特征就越相似,反之,则两者的特征越不相似。这个系数的值域为[-1,1]

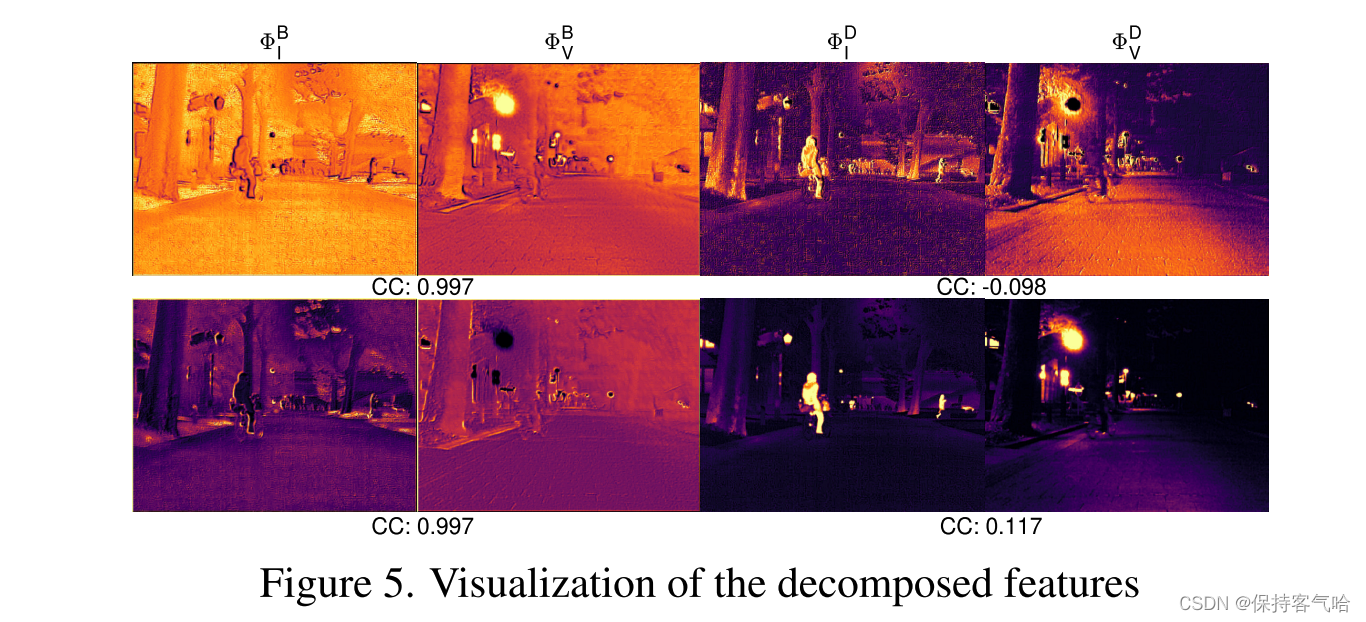

这一损失项的动机是基于我们的多模态图像融合(MMIF)假设。根据假设,分解特征 Φ I B , Φ V B {Φ^B_I, Φ^B_V} ΦIB,ΦVB将包含更多的模态共享信息,例如背景和大尺度环境,因此它们通常高度相关。相反, Φ I D , Φ V D {Φ^D_I, Φ^D_V} ΦID,ΦVD表示V中的纹理和细节信息,以及I中的热辐射和清晰的边缘信息,这是模态特定的。因此,特征图之间的相关性较低。经验上,在梯度下降的引导下, L d e c o m p L_{decomp} Ldecomp逐渐使 L C C D L^D_{CC} LCCD趋近于0,而 L C C B L^B_{CC} LCCB变得更大,这符合我们对特征分解的直觉。特征分解效果的可视化将在图5中展示。

-

式中的CC是融合中常用的指标correlation coefficient。这一项损失就是前文中描述的让共有特征之间距离尽量近、特有特征之间距离尽量远,搭配相关系数可以测量特征之间距离了,因此将低频base特征作为分母,高频detail特征作为分子。该部分分解的效果如上 图。

- 训练阶段II:在训练阶段II中,将成对的红外和可见图像{I, V}输入到一个近乎训练完善的编码器中,以获得分解特征。然后,将分解的基础特征 Φ I B , Φ V B {Φ^B_I, Φ^B_V} ΦIB,ΦVB和细节特征 Φ I D , Φ V D {Φ^D_I, Φ^D_V} ΦID,ΦVD分别输入到融合层FB和FD中。最后,融合特征 Φ B , Φ D {Φ^B, Φ^D} ΦB,ΦD输入到解码器中,得到融合图像F。

- 随后,在训练阶段II中,由[ A semantic-aware real-time infrared and visible image fusion network]引入,总损失变为: L t o t a l I I = L i n t I I + α 3 L g r a d + α 4 L d e c o m p , ( 10 ) L^{II}_{total} = L^{II}_{int} + α_3L_{grad} + α4L_{decomp},\quad (10) LtotalII=LintII+α3Lgrad+α4Ldecomp,(10)

其中 L i n t I I = 1 H W ∣ ∣ I f − m a x ( I i r , I v i s ) ∣ ∣ 1 L^{II}_{int} = \frac{1}{HW}||I_f - max(I_{ir}, I_{vis})||_1 LintII=HW1∣∣If−max(Iir,Ivis)∣∣1 and L g r a d = 1 H W ∣ ∇ I f ∣ − m a x ( ∣ ∇ I i r ∣ , ∣ ∇ I v i s ∣ ) ∣ ∣ 1 L_{grad} =\frac{1}{HW}|∇I_f|−max(|∇I_{ir}|,|∇I_{vis}|)||_1 Lgrad=HW1∣∇If∣−max(∣∇Iir∣,∣∇Ivis∣)∣∣1 Sobel梯度算子α3和α4是调谐参数

4.Infrared and visible image fusion

在这里,我们详细阐述了我们的网络的IVF任务的实施和配置细节。通过实验验证了模型的有效性和网络结构的合理性。

4.1 设置

数据集和评价指标。我们在 IVF 实验中使用了三个流行的基准数据集来验证我们的融合模型,分别是 MSRS 、RoadScene 和 TNO 。我们在 MSRS 的训练集(1083 对图像)上进行网络训练,并在 RoadScene 的 50 对图像上进行验证。MSRS 的测试集(361 对图像)、RoadScene(50 对图像)和 TNO(25 对图像)被用作测试数据集,以全面验证融合性能。需要注意的是,我们没有对 RoadScene 和 TNO 数据集进行微调,以验证融合模型的泛化性能。

在预处理阶段,训练样本被随机裁剪为 128×128 的图像块。训练的总轮数设置为 120,其中第一阶段为 40 轮,第二阶段为 80 轮。批次大小设置为 16。我们采用 Adam 优化器,初始学习率设为 10^-4,并在每 20 轮后按 0.5 的衰减率进行调整。对于网络超参数的设置,SFE 中的 Restormer 块数量为 4,每个块有 8 个注意力头和 64 个维度。BTE 中的 LT 块维度也为 64,注意力头数为 8。解码器的配置与编码器相同。至于损失函数 Eq. (7) 和 (10),α1 到 α4 分别设置为 1、2、10 和 2,以确保每一项的数量级大致相同。

4.2. Comparison with SOTA methods

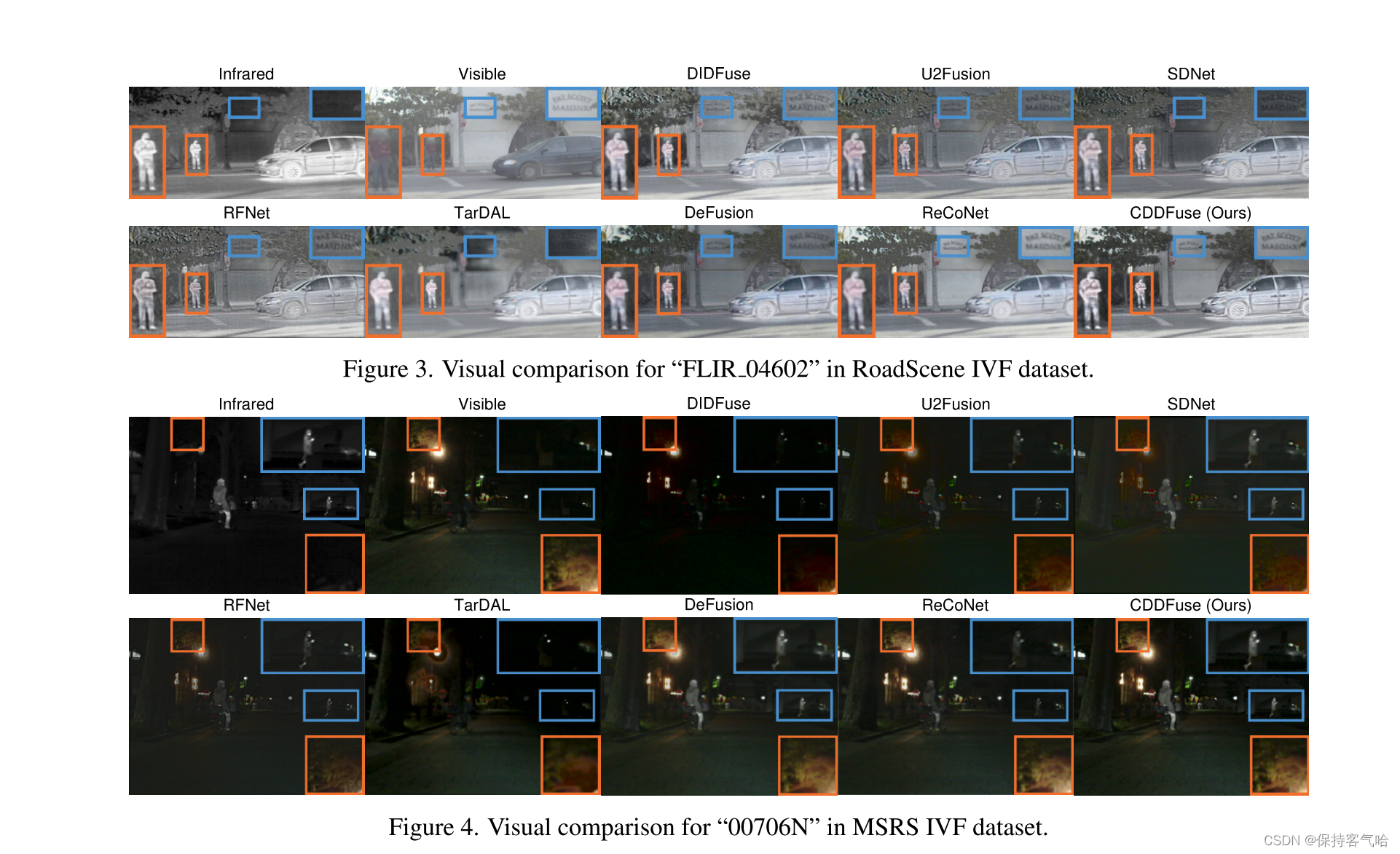

4.2.1 Qualitative comparison

我们的方法更好地集成了红外图像中的热辐射信息和可见光图像中的详细纹理。黑暗区域中的对象被清楚地突出显示,使得前景目标可以容易地与背景区分开。另外,由于低照度而难以识别的背景细节具有清晰的边缘和丰富的轮廓信息,这有助于我们更好地理解场景。

4.2.2 Quantitative comparison

使用八个度量来定量地比较上述结果,这些结果显示在Tab1中。我们的方法具有优良的性能,几乎所有的指标,证明我们的方法是适合于各种照明和目标类别。

4.2.3 Visualization of feature decomposition

图5展示了特征分解的可视化结果。显然,基础特征组中激活了更多的背景信息,并且激活区域也是相关的。在细节特征组中,红外特征更多地关注物体的亮点,而可见光特征则更关注细节和纹理,这表明模态特定的特征被很好地提取出来。这种可视化结果与我们的分析是一致的。

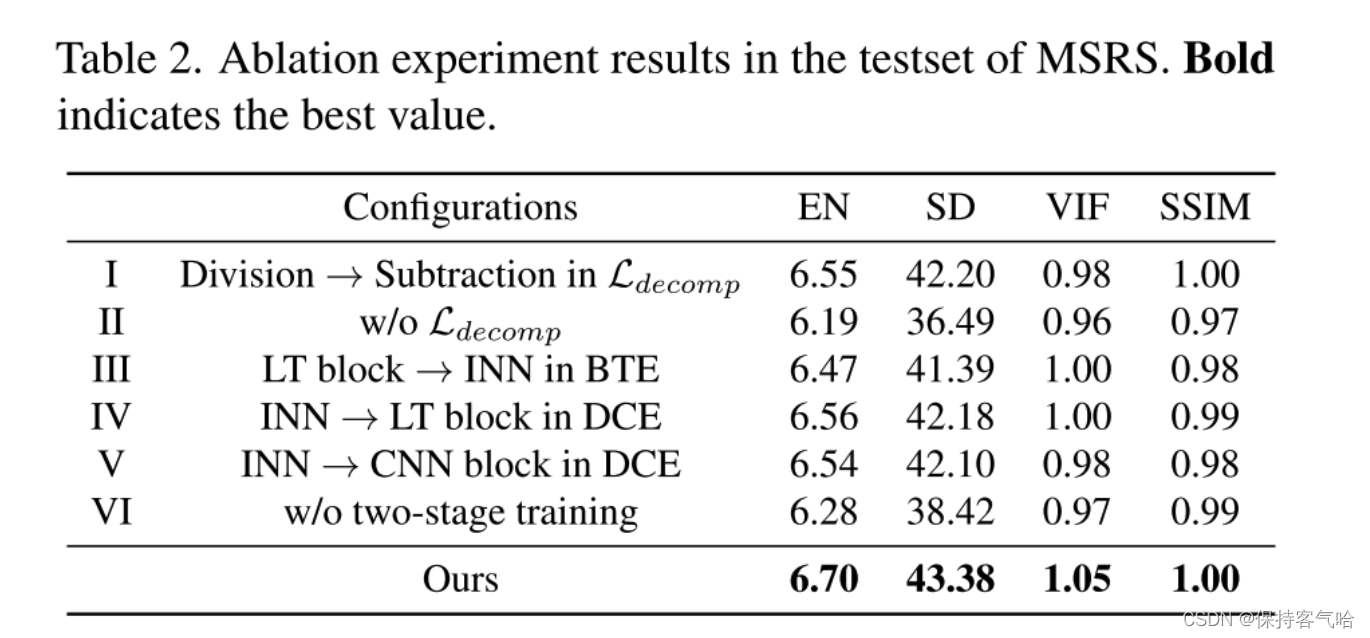

4.3. Ablation studies

消融实验有三部分。第一部分是分解损失,将base和detail损失由相除变为相减,另一个是直接去除分解损失。编码器中的LT和INN块也进行了消融实验,分别是将BTE中的LT换为INN、DCE中的INN换为LT、DCE中的INN换为CNN。最后一个是两阶段训练的实验,也就是直接采用一阶段训练法,用第二阶段的融合图像作为约束训练网络,可以看到效果差了很多。

4.3.1 Decomposition loss/ LT and the INN blocks

4.3.2 Two-stage training.

最后,如果我们放弃两阶段训练,直接同时训练编码器、解码器和融合层,结果非常不理想。实验证明,两阶段训练方法可以有效降低训练难度,提高训练鲁棒性。总之,消融结果见表1。2论证了我们网络设计的有效性和合理性。