GTC分享内容和个人看法

3月21号11点,Nvidia开启了GTC主题演讲,这些年英伟达加速库的发展和对AI的投入应用,不难看出掌握GPU加速计算技术的N家肯定是宣扬AI方向的产品和生产工具,下面我将简要汇总下演讲的内容,和从我自身角度浅谈一下,写完后定时22号下午发送,希望能够对在行业中或者即将选择AI行业的人有些许帮助。

文章目录

会议演讲概要

1.抛砖引玉&&开门见山

“对Nvidia CEO他今天没带刀!” 因为今天的主题不是消费级显卡,首先讲的就是这两年的热点话题AIGC,近年来从视觉、语言、语音的多模态数据类型的交叉的研究频繁产出,AIGC赛道上的“Runner”越来越多了,这似乎是AI发展在行业中的一次巨大进步,因为计算机行业一直以来都是影响世界的行业,故这次的主题关键词也被列出来了”芯片和系统、加速库、云服务、AI服务“.

随后点出现在爆火的ChatGPT和GTC大会发展进步,并介绍了更多和Openai等世界领先的研究者和创业者的演讲内容(balabala…主要以生成式AI为主,包含机器人强化学习,omniverse等生产工具,覆盖AI应用的很多行业如自动驾驶/数字孪生/光学仪表/医疗健康/金融/零售等等)

接着一个宣传短片“I am AI”介绍了NV对于AI的研究和上述提到的相关应用实践,”chatgpt呢其实扮演着一个灵活的可组装大脑,可以应用到各行各业中去提高效率,赋予任何计算机软件智慧大脑结合生成式AI多模态交叉一套组合拳,相当于是打爆AI各行业发展的弹药桶"。个人理解,Chatgpt这种万金油属性确实在很多AI相关应用行业上能够集成后助力,它可以是我们任何人的帮手,相信在网上大家已经对chatgpt都有基本的使用体验或者了解。不过我们今天的主题其实并不是chatgpt,它只是一个最好的“铺垫”。

重点来了,黄老板一句表述,直接切入主题,总结下就是从过去到现在AI的发展——模型训练和推理始终离不开加速计算!(”还是得论硬件芯片,仿佛就在说不管是啥AI大模型Gpt没有GPU啥也不是!”),也表明了AI计算和硬件加速的巨大进步和重要性,在当下和未来是可以撼动世界的,毕竟现在N卡在我们的工作 、游戏、生活中已经无处不在。这也就对应开头说的芯片和系统内容,随后基于cuda加速库(亮点“在不加大成本和功耗下提升性能”,“节能减排”)以及AI服务、云服务。

2.围绕上述,行业AI应用以及关键词来进行具体自家产品介绍

Nvidia Quantum:量子仿真加速库,推进量子模型加速计算,为研究人员助力,等反正就是各种相关的电路仿真计算加速库,这方面不了解。

SPARK-rapids:应该是减少了大数据处理开销,并对大数据的系统数据库存储、检索等操作进行加速,比如推荐系统。

RAFT:Meta也是facebook-research,我用过,那就是开源做相似性搜索时候的FAISS库,做人脸识别那种相似性索引比对时候会提供训练后量化的api等方法进行大规模索引加速,类似PCA聚类的离线处理,估计是在此基础上NV进行了Faiss、redis、milvus这些比较知名的数据索引库的包装和优化。

cuOpt:针对实时物流调度问题提供解决方案,优化物流服务, 看起来蛮牛的,“Achieve world-record accuracy with a 2.98% error gap on the Gehring & Homberger benchmark.”

Tensorrt和Trtion: 加速和云服务,Tensorrt这个大家很熟悉了就不谈了,Trtion就是在tensorrt和deepstream后续衍生的一种云端推理服务,兼容性比较好,在NGC注册后可以训练和推理部署,不过个人不太喜欢用,可能NV主要是以加速计算和低代码AI应用为主,以生产工具的形式去便利化,所以NV大部分和算法相关的模型都是闭源的,不利于研究人员学习。后续要引入并发模型逻辑和LLM模型的多GPU多节点推理。

Trtion Managment :这个没用过,应该是trtion的软件化产品。

VPF with Cuda: 这个我在2022年接触过,视频处理加速库,是用python封装的,底层应该用的ffmpeg的源码,可以使用python对视频进行GPU编解码,支持网络流RTMP\RTSP\等,并且可以直接转成torch里的tensor,但是实话实说,这个使用还是不少问题的,目的就是实现高效的GPU处理流程,因为Tensorrt只能使我们的模型吞吐量最大化,完成程序执行实时而不只是模型推理实时。

Parabricks: 用于云端或者仪器设备内的端到端基因组分析,应该是打造特点的谁被,结合HOLOSCAN软件,一款医疗AI的软件,和Medtronic合作去打造了一个手术导航机器人辅助平台,说年底会推出一个新AI医疗系统。

cuLitho: 制造芯片的难点技术,计算光刻生产掩模版的技术,不太懂这方面,减少了制作掩模板的世界和功耗开销,在CPU上一个掩模版2周时间,放在GPU上8小时,因此取替了4W台CPU服务器的成本,降低工作开销负载是核心思路,视频里的TSMC台积电6月份发布认证。

简单总结:”基于自家的加速库在多领域行业内合作有着领先的AI应用工具和成果,并且每一个成本都价值不菲同时做到了节能减排”

3. 介绍硬件芯片产品

谈摩尔定律终结,CPU性能提升带来的功耗提升和节能减排相矛盾,所以缓解这一问题,首先从加速数据和AI云服务GPU并行去释放CPU,就是GPU尽量处理更多更大的数据和任务,缩短处理时间,自然经典场面来了,所有电脑爱好者都熟悉的”带货环节“,生怕展现惊准刀法。

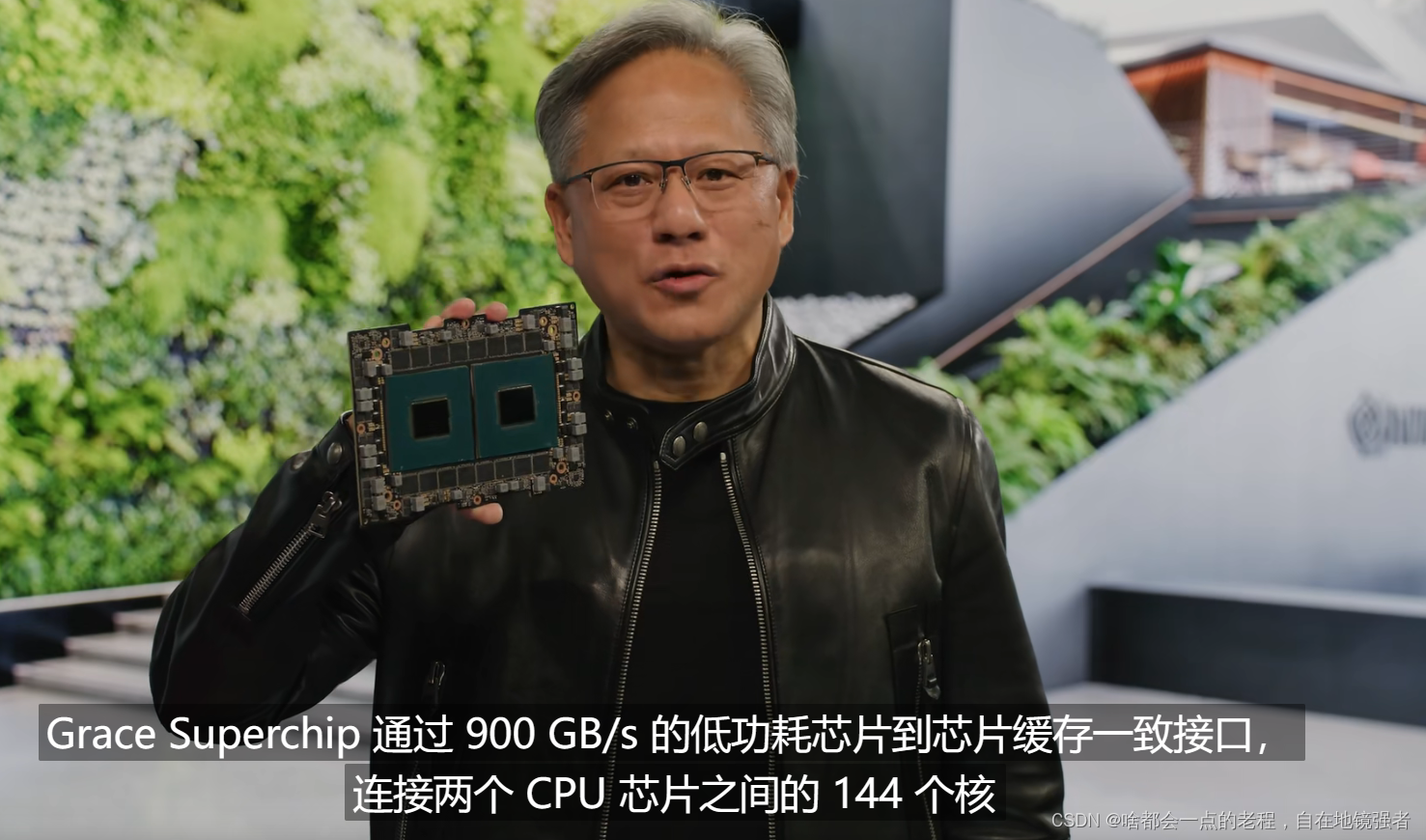

3.1 服务器级芯片Grace Superchip CPU——NV首款CPU

基于ARM结构的CPU,以Grace命名,致敬美国计算机编程先驱者Grace Hopper,基于第三代NVLINK传输技术,(nvlink简单来说就是CPU到GPU高效传输核心技术,双向带宽解决硬件性能瓶颈,感兴趣的自行查阅)900GB/S的传输速度,如图总带宽约高于先进服务器的30倍。

- 72个ARM核心,超高速可扩展的、缓存一致(保证内存的更新一致性避免访问不一致的问题)的网络连接.

- 截面带宽3.2TB/S.就理解为带宽吧,具体介绍如图

- 内存1TB,功耗较少,风冷

3.2 NVIDIA BlueField DPU

零信任安全平台结合了三种技术 —— NVIDIA BlueField DPU、NVIDIA DOCA 和 NVIDIA Morpheus网络安全人工智能框架

这里是只介绍了BlueField 的用处,还是以加速计算,解放CPU为表述核心思想。

3.3 DGX—多H100模组

这个是比较重磅和关注的,H100配置了transformer的引擎,(H100是2022年的GTC发布的Hopper架构芯片),专职LLM训练。8个H100之间通过NVLINK技术成为超算计算引擎,因此多个DGX可以构建一个超算中心,衍生生云服务可以为每一个企业使用超级计算提供可行性。

继续夸生成式AI前景和GPT的出现,从High-level走向low-level,再融合多模态,畅想未来不只是程序员才能做实现,通过“人类编程语言”可认知的基本输入语言以及语音、图像,通过大模型并行计算去完成工作和满足需求,怕不怕?后面讲了些案例,其实和开篇提到的类似,就是GPT作为AI智慧插件去和各领域应用结合,成为每一个人的“助手”,因此生成AI覆盖所有领域

4. 介绍软件SDK

4.1 Nemo

一个NLP任务的SDK,提供更多的文本生成预训练模型去直接应用。

4.2 Picasso

看介绍是一个多模型的创作应用,就是输入文本,输出是视觉图像的应用 ,这种生成类任务方向较多,比如大家熟悉的clip、stable diffusion等,并举出了3D素材生成的合作和进展。

4.3 Omniverse

这个平台自己本身有使用过,简单来说是一个结合数字孪生的创作平台,特点是低代码和扩展丰富度较高,结合了很多3D引擎去使用,领域交叉性极强。后面有详细介绍。

4.4 BIONEMO

生物学领域: 医疗健康应用,不太了解,感兴趣的上网搜,说是预测药物抗体作用等实验,就是药物研发行业,比如蛋白质结构生成可视化和与预测,预测药物分子的相互作用,帮助药物研发人员提供工作效率,这很NICE。

5. 硬件一波流

One-Architecture

这个比较特殊,是针对所有任务的一个平衡性平台设计

- 针对AI视频使用L4 GPU,ADA最新架构,光追性能提升3倍,节省了CPU切换到GPU的能耗费问题,做视频编解码和内容审核,视频通话,抠像和眼神交流(可参考我使用maxine的SKD文章)等视觉任务,这里叫现实增强AR。基于L4 的工作,进行进一步介绍,比如和google合作大预言模型等任务进行加速。

- 针对Omniverse生成创作和渲染类的任务推出L40,性能T4 x10倍,合作对象runaway。

- 针对ChatGpt等LLM模型,制造Hopper结构的PCIE的H100芯片——H100-NVL,降低模型处理成本,还是那个熟悉的动作。

- Hopper-Grace展示,处理大型数据集,最新的900G/S的芯片,适合LLM和大数据集。

6 .数字孪生平台——Omniverse详细介绍

- “元宇宙”、“数字工厂”、”虚拟世界“、”CG制作“”3D设计“”XR/VR/AR“等都和这个相关,Omniverse是一个非常强大的平台,需要图灵架构以后的显卡才能安装的软件,其核心闭源,上面集成了很多应用以及拓展,首先介绍了数字工厂的机器人仿真——ISAAC模拟物流部署,提供大量逼真的数据去训练机器人的模型和迭代测试,完成自主导航,仿真仿真,可以模拟商业运营。

- 提供USD通用格式,创建数字孪生,比如实现UE\UNITY\CC4\MAYA\ICLONE中的设计工作和人物模型制作,并且能够兼容且协同到软件中。

- 声音驱动面部表情、动作捕捉等AI任务,Audio2face\Audio2Gesture等。

- 这个生态环境太大了,涉及到了各行各业的技能和领域,跨领域交叉性极强。

反正剩下都是在讲Omniverse,这些应用无疑降低了研究和开发成本,对使用者来说是好事,但是对于研究者来说并不友好,当然这也不是NV的主导方向,很多SDK在开发中确实帮到了本人很多比如deepstream、Omniverse\Tensorrt。

总结

总的就是围绕加速计算和AI应用方面在各领域的应用以及成果,穿插软硬件的介绍,同时也强调了AIGC的赛道重要性,掌握了AI加速计算的钥匙,取得了软件产品的突破,看好当下更看好赛道的未来。

作为CV背景,其实从去年yolov7出的时候就已经意识到了检测、分类、分割“CV三板斧”的研究瓶颈已经体现出来了,并多次在GITHUB和博客强调“即使不需要涉猎多模态,也要在CV几个横向延伸一下”。随着clip、diffuison扩散模型等大火,再到CHATGPT影响了全世界各行各行,那么对于使用者提供的便利性是好事,但是对于相关从业研究者和可被替代工作者恐怕是一次重大挑战,技术在进步,AI多领域交叉已是定局,比如gpt4.0的多模态,就对于CV角度来看,更是压力倍增,更不用提虚拟数字化、元宇宙这种更大的生态概念了,可以集成任何的领域技术应用,文本语言、音视频、美术设计、物流交通等等此类,相信在大会中提到的Omniverse以及chatgpt,也是符合GPT作为集成的智慧插件,在各种应用中嵌入,使得各领域的应用赋予智慧。

从工作体会来说数字人等业务核心要求了除了深度学习等相关任务研究的经验,还需要计算机图形学、渲染、UE的基础设计和常规的多语言编码开发能力,其实周边很多cv的朋友包含自己至今依旧从事于检测等成熟任务和其部署上,每想到此焦虑++,技术进步给大众带来便利,但是给领域内的人也带来了压力,比如chatgpt可能你不需要了解RLHF和PPO算法,你只需要集成就行了,但是作为算法方向你能允许自己这样吗?退一步讲,即使你了解了也没用,你也没有平台和经验去搞LLM,那么换个说法:当你涉及多模态任务时候,因为CV作为AI最普及化的任务方向就必然会大概率出现在交叉领域的任务中,这个可没有那么多现成的,自身技能和储备研究以及跟进能力面临一次极大挑战,那么做CV无疑是很累的且充满压力,抱着成熟的任务生存停滞不能“忘本”,可能还要面临部署的C++开发,现在更需要拓展相关领域和积累,自驾都用Nerf了,GPT上可以调cv clip和diffusion了,AI绘画\作曲\换脸\换装\换嘴\换声\超分、插帧等层出不穷,你的业务可以不在领先状态,但自己一定要跟进,此时此刻,需要紧迫感来促进我们前进,以此点燃自己。