搭建Spark集群(独立模式)

准备工作

①三台虚拟机 Master:192.168.101.140(spark01),Slaves:192.168.101.141(spark02),Slaves:192.168.101.142(spark03),必须装有Java8

②spark-2.2.0-bin-hadoop2.7.tgz 下载地址spark下载地址配置虚拟机

①设置主机名,运行一下命令

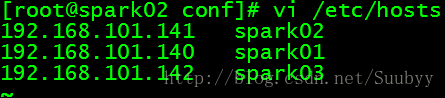

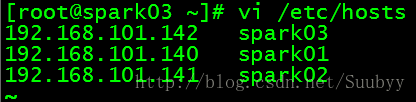

vi /etc/host②增加如下配置(三台虚拟机都需要修改主机名,自己的ip地址放在第一位)如下:

设置虚拟机之间的ssh免密码登录

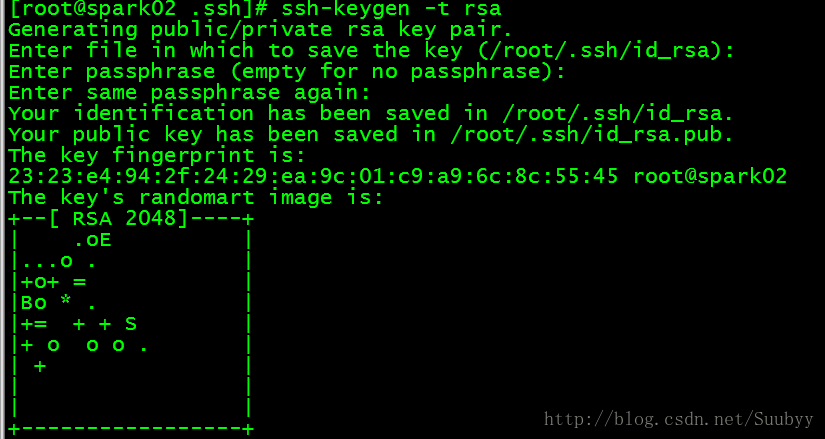

①分别在三个虚拟机上运行以下指令生成公私钥对(一路回车)

ssh-keygen -t rsa

②分别在三个虚拟机上查看生成的公私钥对,运行以下指令

shell>>cd /root/.ssh

shell>>ls

③将三个虚拟机生成的id_rsa.pub公钥放进authorized_keys文件夹里,步骤如下(最重要的一部)

1).首先运行一下命令将192.168.101.140(spark01)的虚拟机上的id_rsa.pub放进authorized_keys文件夹里

[root@spark01 .ssh]# cat id_rsa.pub >> authorized_keys 2).然后在运行一下命令将192.168.101.140上的authorized_keys文件远程拷贝到192.168.101.141虚拟机上/root/.ssh目录中,

[root@spark01 .ssh]# scp ~/.ssh/authorized_keys [email protected]:~/.ssh 3).然后在到192.168.101.141(spark02)下的/root/.ssh目录里,运行一下命令将id_rsa.pub公钥放进刚才远程传过来的authorized_keys文件中

[root@spark02 .ssh]# cat id_rsa.pub >> authorized_keys 4).然后运行如下命令将192.168.101.141(spark02)的authorized_keys文件远程传到192.168.101.142虚拟机的/root/.ssh目录中

[root@spark02 .ssh]# scp ~/.ssh/authorized_keys [email protected]:~/.ssh 5).然后在到192.168.101.142(spark03)下的/root/.ssh目录里,运行一下命令将id_rsa.pub公钥放进刚才远程传过来的authorized_keys文件中

[root@spark03 .ssh]# cat id_rsa.pub >> authorized_keys 6).由于这现在192.168.101.142(spark03)下的authorized_keys文件已经包含了三台虚拟机的公钥,所以需要将该authorized_keys文件覆盖前两个虚拟机的authorized_keys文件,运行一下命令

[root@spark03 .ssh]# scp ~/.ssh/authorized_keys [email protected]:~/.ssh

[root@spark03 .ssh]# scp ~/.ssh/authorized_keys [email protected]:~/.ssh然后重启虚拟机,ssh免密码登录就完成了

- 搭建spark

①将三台虚拟机的spark解压到/opt/目录下

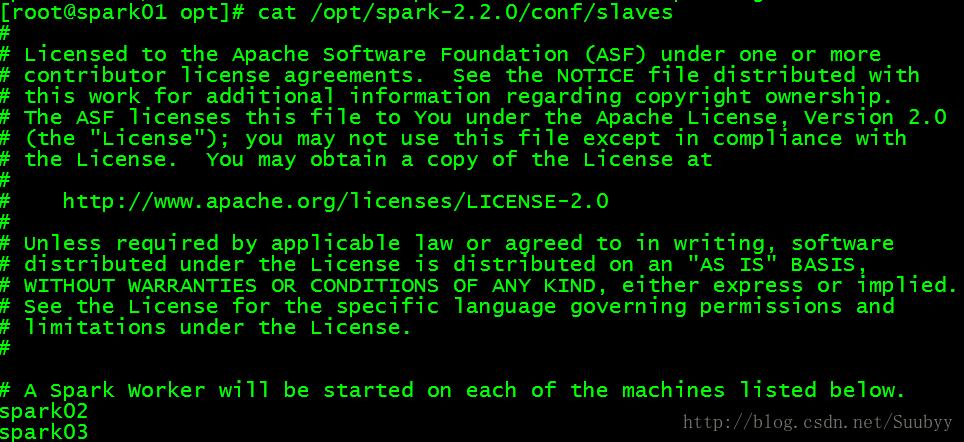

tar -zxvf spark-2.2.0-bin-hadoop2.7.tgz ②解压完之后在192.168.101.140(spark01)虚拟机上操作如下命令,将slaves.template拷贝一份,命名为 slaves

cd /opt/spark-2.2.0-bin-hadoop2.7/conf

cp slaves.template slaves③然后编辑192.168.101.140(spark01)上的slaves文件,将两台从机的主机名填入到该文件中,如图

④然后将192.168.101.140(spark01)上的slaves文件远程传送到192.168.101.141(spark02),192.168.101.142(spark03)上。命令如下

[root@spark01 conf]# scp -r slaves [email protected]:/opt/spark-2.2.0/conf/

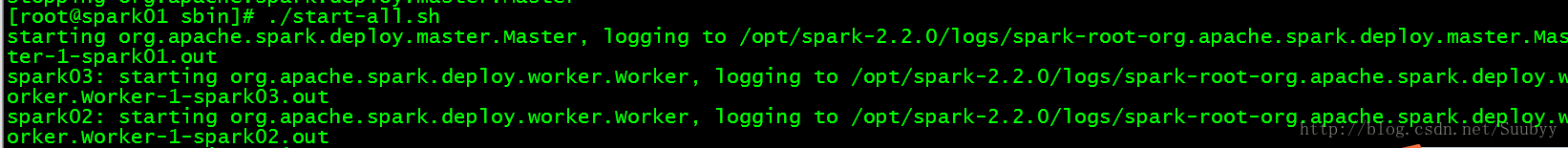

[root@spark01 conf]# scp -r slaves [email protected]:/opt/spark-2.2.0/conf/⑤:然后开始启动spark集群运行如下命令(必须在Master机器上运行启动脚本):

[root@spark01 ~]# cd /spark-2.2.0-bin-hadoop2.7/sbin/

[root@spark01 sbin]# ./start-master.sh⑥如果看到一下信息说明成功了

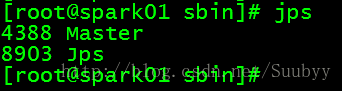

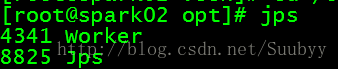

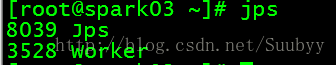

⑦人别在三台虚拟机上执行jps指令可以看到

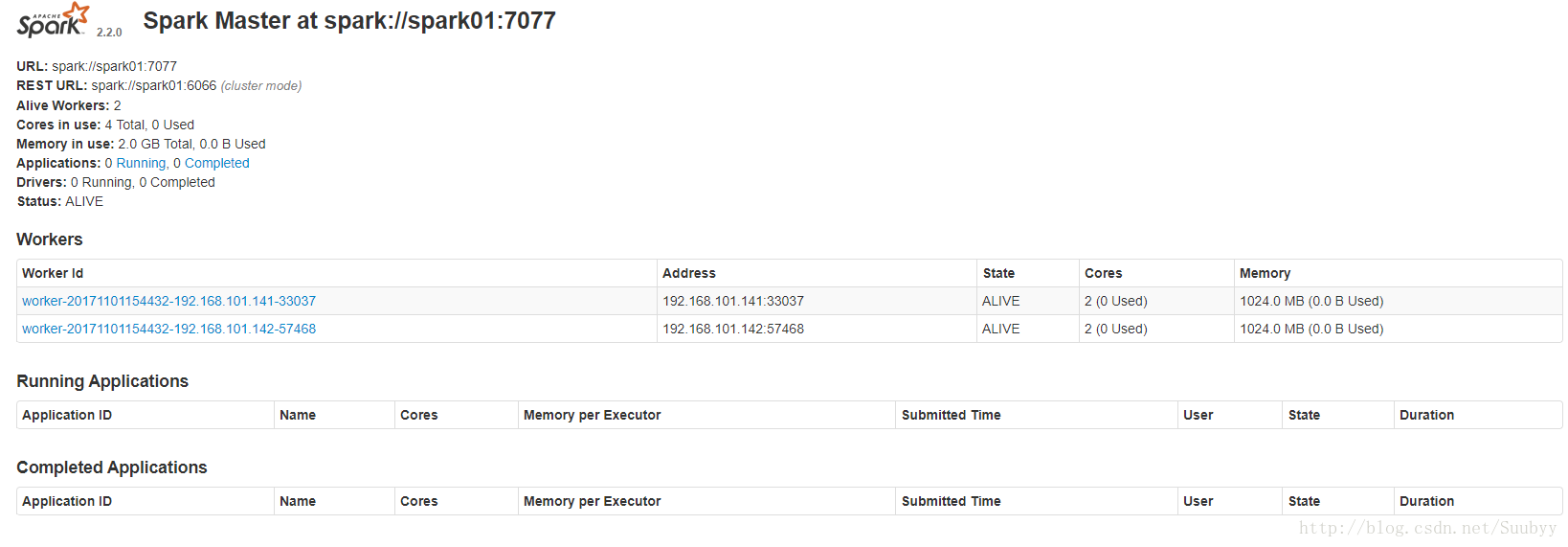

⑧访问192.168.101.140:8080,看到如下界面,说明搭建完毕

- 其余的spark配置还有很多

请参考下网址进行学习:spark学习