【深度学习,NLP,LM】Alpaca-Lora ,Colab上部署与调用

前言

安装环境

- 首先按照需要安装相应依赖

!pip install sentencepiece

%cd /content/drive/MyDrive/Repo/alpaca-lora-main

!pip install -r requirements.txt

- 在

修改 -> 笔记本设置中修改硬件加速器为GPU,否则后续运行到一半就寄了… - 稍微修改下代码

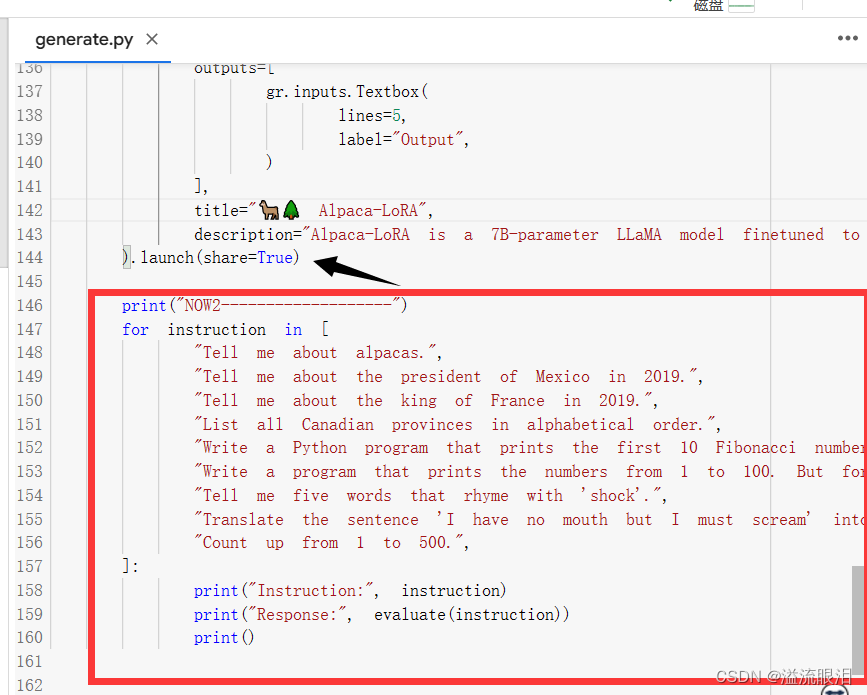

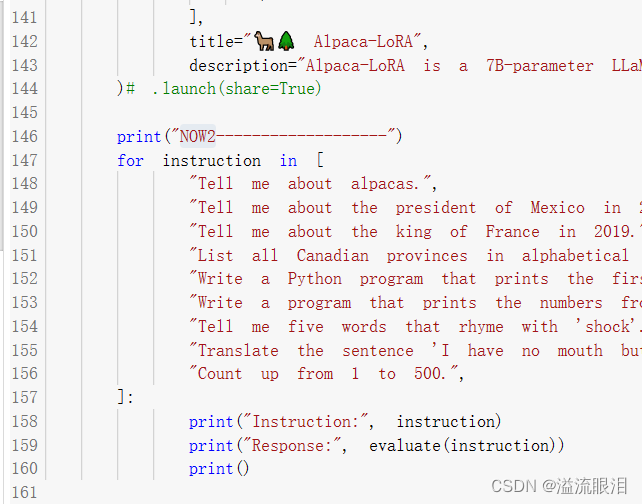

上方设置share=True,由于跑完后会出现一个本地连接进行测试,而在colab运行的本地连接在本机上是打不开的,需要设置开启公共链接。

下方为测试代码,查看在代码中调用接口是否成功。

运行generate代码

- 由于我不需要进行训练,直接拉下来默认训练后的模型即可,即只用调用

generate.py

需要设置相应模型参数,base_model是必须参数。

%cd /content/drive/MyDrive/Repo/alpaca-lora-main

!python generate.py \

--load_8bit \

--base_model 'decapoda-research/llama-7b-hf' \

--lora_weights 'tloen/alpaca-lora-7b'

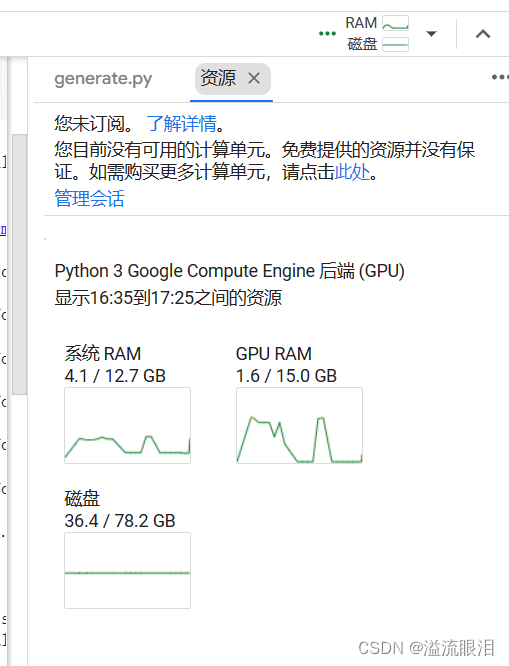

- 运行时可以查看资源消耗是否正常

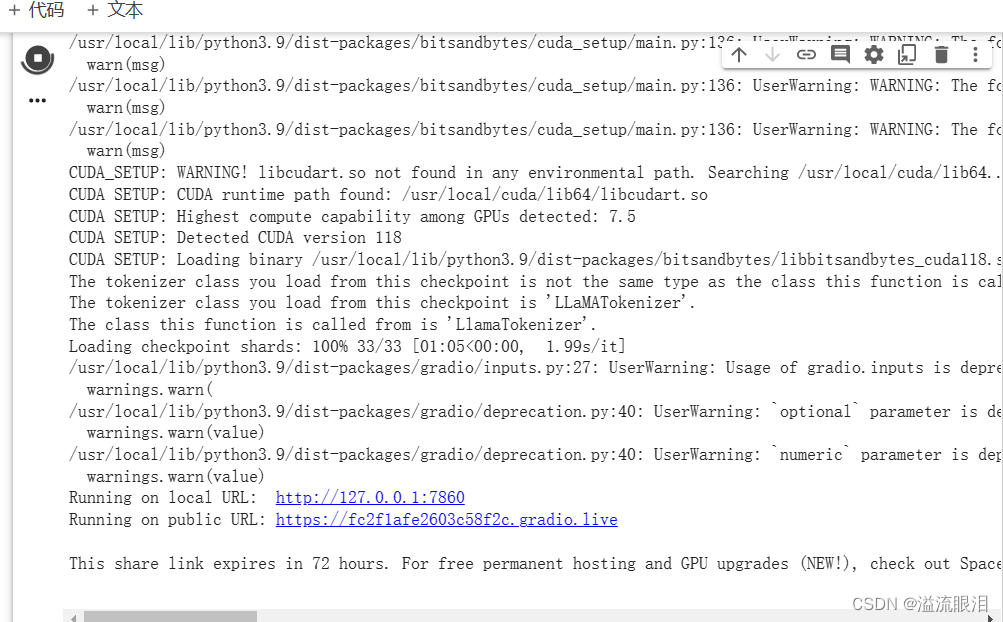

- 运行完成后会掉出URL,点击打开。

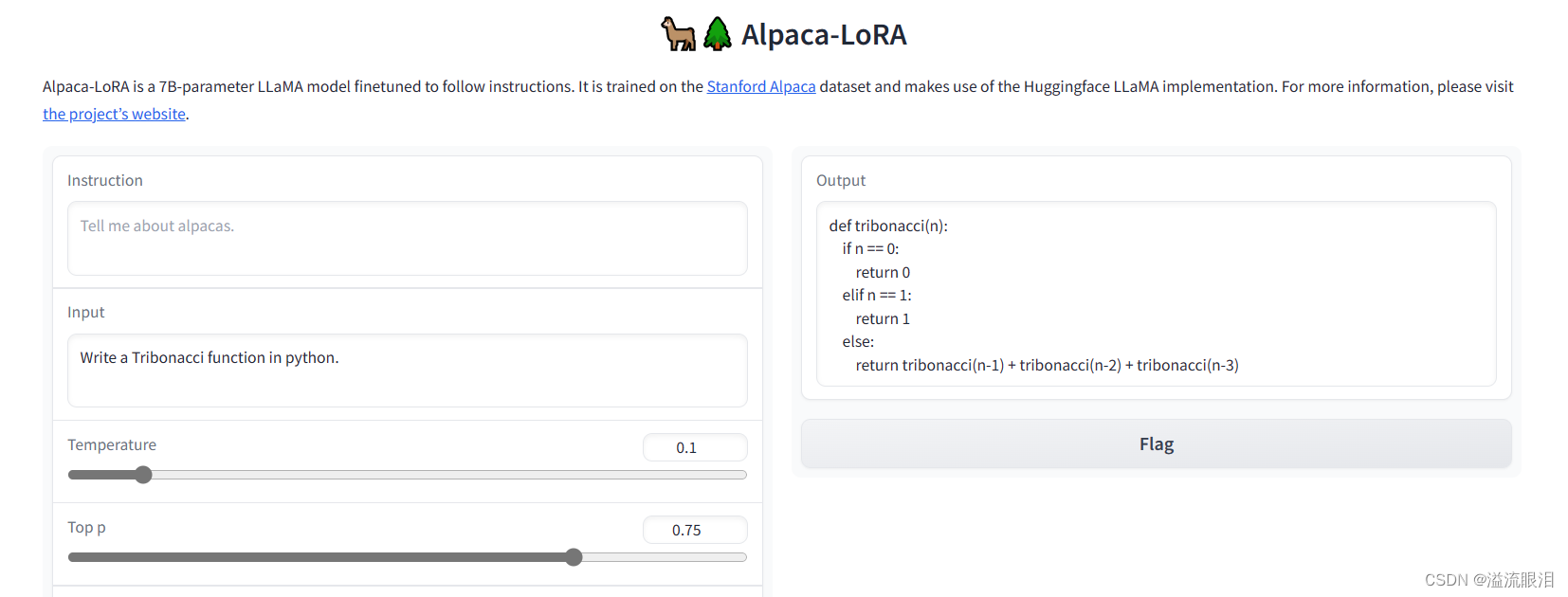

- 进行询问测试,回答还可以。(不大支持中文QA)

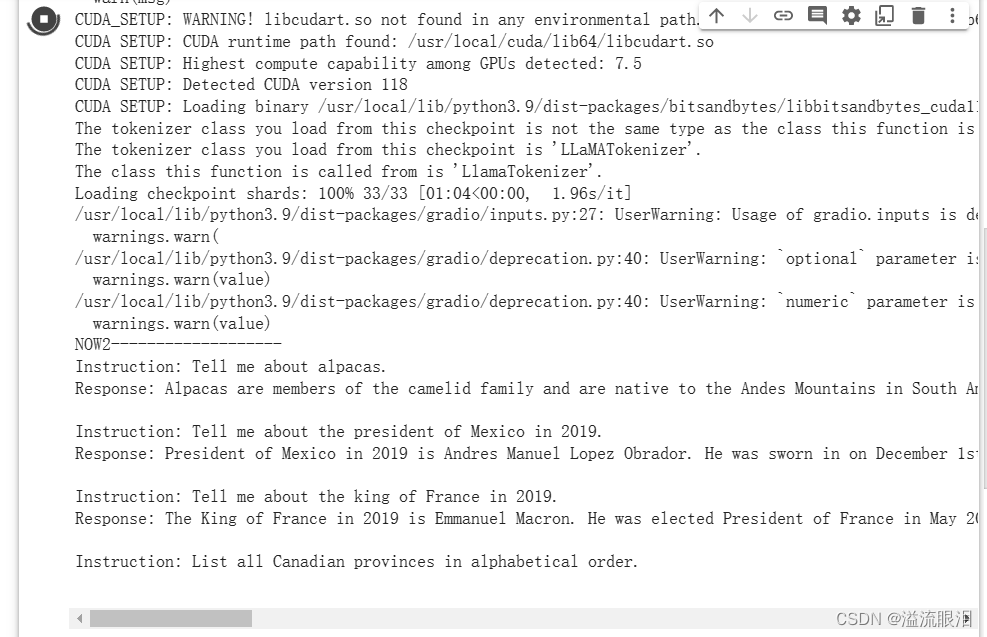

- 但是可以看到跑完了之后甚至没有跑那行

print("now2"),所以我选择注释掉启动启动器。

- 再次运行,发现会运行上述代码,虽然有丢丢慢,但是还行。