alpaca-lora项目地址:https://github.com/tloen/alpaca-lora

微调

1、将项目下载到本地

git clone https://github.com/tloen/alpaca-lora.git

2、配置环境

先安装torch

pip install torch==1.13.1+cu116 torchvision==0.14.1+cu116 torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu116

安装其他包

pip install -r requirements.txt

由于微调时间较长,这里直接后台运行。

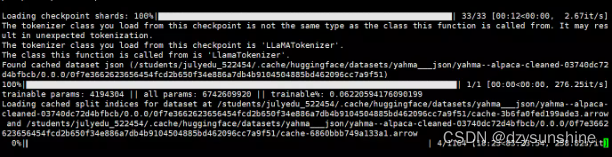

nohup python -u finetune.py \

--base_model 'decapoda-research/llama-7b-hf' \

--data_path 'yahma/alpaca-cleaned' \

--output_dir './lora-alpaca' \

>> log.out 2>&1 &

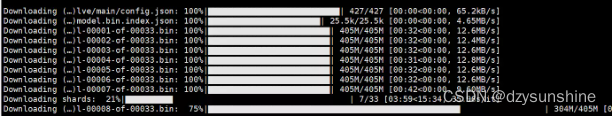

预训练模型:decapoda-research/llama-7b-hf 会自动下载。共计33个405M的bin文件,大约占用约14G内存。

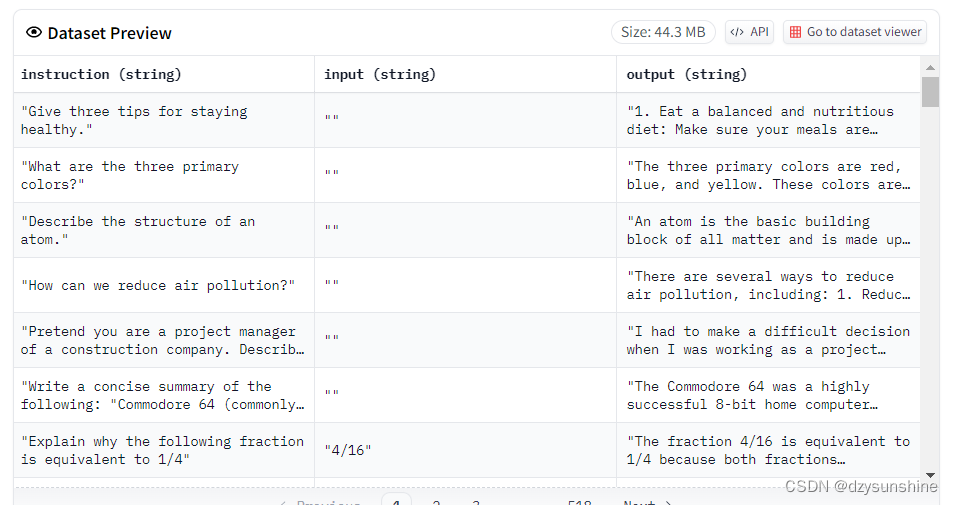

微调数据:https://huggingface.co/datasets/yahma/alpaca-cleaned

该数据基于斯坦福alpca数据进行了清洗。

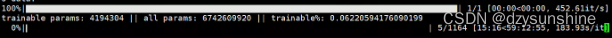

微调过程预计需要60个小时,占用显存约9个G。

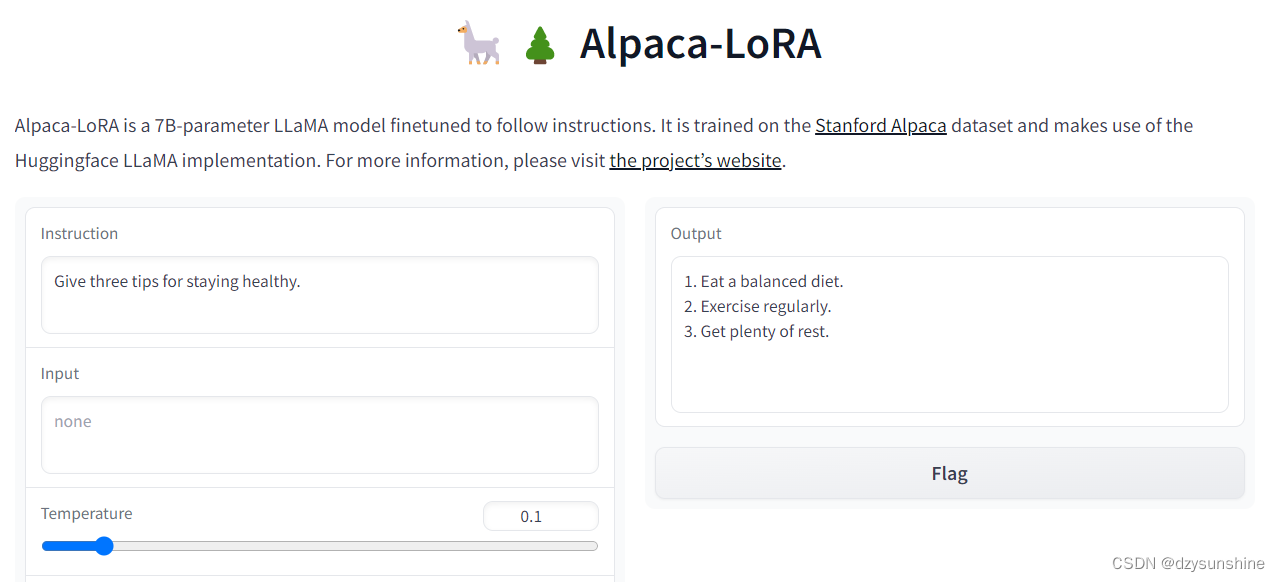

推理

设置generate.py文件,将share=True,便于公网访问。

python generate.py \

--load_8bit \

--base_model '/data/sim_chatgpt/llama-7b-hf/models--decapoda-research--llama-7b-hf/snapshots/5f98eefcc80e437ef68d457ad7bf167c2c6a1348/' \

--lora_weights 'tloen/alpaca-lora-7b'

如果报错,不能创建链接,降低下gradio版本即可,如:pip install gradio==3.13

效果如下,显存占用约8个G