一元一次线性回归

作为机器学习的入门课程,线性回归是我们必须要学习的第一个算法。今天我们就来详细的讲解一下线性回归。

在讲解之前,我们先来解释以下几个问题。

可为线性?线性是指自变量x和因变量y之间是线性的关系,即图像是一条直线,叫做线性。

何为回归?百度百科的解释是:指研究一组随机变量(Y1 ,Y2 ,…,Yi)和另一组(X1,X2,…,Xk)变量之间关系的统计分析方法,又称多重回归分析。通俗的讲就是我们研究一个函数,当我们输入自变量x时,因变量y可以无限的接近真实值。

线性回归可以解决什么问题?线性回归主要是对大量的观测数据进行处理,从而得到比较符合事物内部规律的数学表达式。也就是说寻找到数据与数据之间的规律所在,从而就可以模拟出结果,也就是对结果进行预测。通过已知的数据得到未知的结果。比如:对房价的预测、判断信用评价、电影票房预估等。

线性模型的一般形式

一般我们的输入是由多个属性描述的示例x。在预测房价的例子中,我们输入的一个示例x就包含多种维度:房间数,简直面积,房屋评分,日期等等。可用公式表示成x=(x1;x2;x3...;xd),其中xi是x在第i个属性上的取值。由于线性模型是一个试图学得一个通过属性的线性组合来进行预测的函数,即f(x)=w1x1+w2x2+...+wdxd+b。所以线性模型的一般形式可以表示为:

我们首先考虑一种最简单的情形:输入x的属性只有一个,即x只有一维。那么接下来的问题就是如何确定w和b。我们回归的目的就是使预测值无限逼近真实值,所以当然要使预测值f(x)和真实值y之间的差值尽可能的小。由于差值可正可负,与其取绝对值,不如使用平方。所以在这种情况下,均方误差是最常用的性能度量,公式如下:

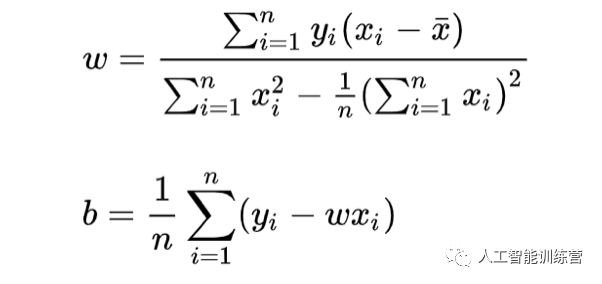

我们的目的就是求得此函数的最小值,而基于均方误差最小化来进行模型求解的方法称为“最小二乘法”。最小二乘法就是试图找到一条直线,使所有样本到直线上的欧式距离之和最小。通俗讲,最小二乘法的中心思想就是能够使得如上函数最小的w和b就是我们所求函数的解。

这是一个二次函数,对其求导:

导数为0的时候取得最小值,令上式子右方为零,可解得:

这样我们就可以得到完整的线性回归函数。

期望一起交流学习~