目录

目前中文分词一共有三种方式进行实现:

jieba (结巴分词)

THULAC(清华大学自然语言处理与社会人文计算实验室)

pkuseg (北京大学语言计算与机器学习研究组)

中文分词的难点

- 分词不规范,词的定义还不明确,容易误分

- 歧义切分问题,交集型切分问题,多义组合型切分歧义等,容易找出分出的词语有歧义

中文分词方法

- 基于字典、词库匹配的分词方法(基于规则)

- 基于词频度统计的分词方法(基于统计)

- 基于知识理解的分词方法

简单使用

import jieba

text = "聚焦鲜活农产品主产区、特色农产品优势区,支持建设农产品产地小型仓储保鲜冷链设施,

到2025年,全市新增田间地头冷藏保鲜项目60个以上。市财政对完成项目建设任务的区级政府,

按照每个项目属地财政补助额度的50%,给予不超过50万元的奖励"

word_list = jieba.cut(text)

print(word_list) ![]()

# 转换为list

print(list(word_list))

直接使用需要将其转换为list才能看到结果

三种分词模式

① 精确模式:试图将句子最精确地切开,适合文本分析

# 精确模式

word_list = jieba.cut(text,cut_all=False)

print("精准模式分词结果为:" + "/ ".join(word_list))  ② 全模式:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义

② 全模式:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义

把词语分的很细,分的不能在分的样子

# 全模式

word_list = jieba.cut(text,cut_all=True)

print("全模式分词结果为:"+"/ ".join(word_list))

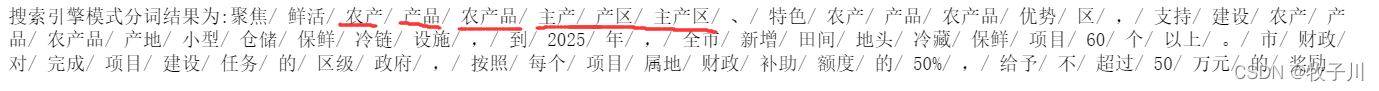

③ 搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词

• 支持繁体分词

• 支持自定义词典

# 搜索引擎模式

word_list = jieba.cut_for_search(text)

print("搜索引擎模式分词结果为:"+ "/ ".join(word_list))

结巴分词使用

• jieba.cut 方法接受三个输入参数: 需要分词的字符串;cut_all 参数用来控制是否采用全模式;HMM 参数用来控制是否使用 HMM 模型

• jieba.cut_for_search 方法接受两个参数:需要分词的字符串;是否使用 HMM 模型。该方法适合用于搜索引擎构建倒排索引的分词

• jieba.cut 以及 jieba.cut_for_search 返回的结构都是一个可迭代的generator,可以使用 for 循环来获得分词后得到的每一个词语,或者jieba.lcut 以及 jieba.lcut_for_search 直接返回 list

使用此方法会直接得到列表,列表里面为已经分好了的词。不需要再次进行转换

word_list = jieba.lcut(text)

print(word_list)

word_list = jieba.lcut_for_search(text)

print(word_list)

结巴分词使用

• 开发者可以指定自己自定义的词典,以便包含 jieba 词库里没有的词

• 用法: jieba.load_userdict(file_name)

• file_name 为文件类对象或自定义词典的路径

• 词典格式:一个词占一行;每一行分三部分:词语、词频(可省略)、词性(可省略),用空格隔开,顺序不可颠倒。

• file_name 若为路径或二进制方式打开的文件,则文件必须为 UTF-8编码

jieba.load_userdict("data.txt")

word_list = jieba.lcut(text)

print(word_list)

自己定义的词典,可以在分词时不会分开自己定义的词语,如:我不想让”农产品“这三个字分开,就写入词典中并进行加载,拿在之后分词时就不会把这三个字分开了。而没有加载这个词典,jieba就可能会将其分开