【1】基于词典分词方法:

- 将待分析的汉字串与词典进行匹配。若在词典中找到某个词,则分出一个词。主要有正向最大匹配;逆向最大匹配;最少切分;基于索引树等。

- 改进:一、将正向最大匹配方法和逆向最大匹配方法结合起来构成双向匹配法;二、改进扫描方式,称为特征扫描或标志切分,优先在待分析字符串中识别和切分出一些 带有明显特征的词,以这些词作为断点,可将原字符串分为较小的串再来进机械分词,从而减少匹配的错误率。三、将分词和词类标注结合起来,利用丰富 的词类信息对分词决策提供帮助,并且在标注过程中又反过来对分词结果进行

【2】基于理解的分词方法:分词的同时进行句法、语义分析

【3】基于统计的分词方法:gram;实际应用的统计分词系统都要使用一部基本的分词词典(常用词词典)进行串匹配分词,同时使用统计方法识别 一些新的词,即将串频统计和串匹配结合起来,既发挥匹配分词切分速度快、效率高的特点,又利用了无词典分词结合上下文识别生词、自动消除歧义的优点。

【4】神经网络/联想回溯法/N-最短路径分词算法

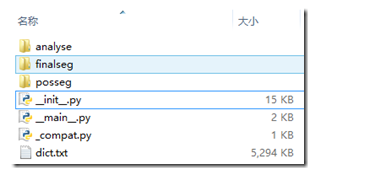

【5】jieba分词原理:

- 基于前缀词典实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图 (DAG)

- 采用了动态规划查找最大概率路径, 找出基于词频的最大切分组合

- 对于未登录词(即没有被收录在分词词表中但必须切分出来的词),采用了基于汉字成词能力的 HMM 模型,使用了 Viterbi 算法