# jieba_use.py

import jieba

'''

优秀的中文分词库

可以将一段中文分割出一个一个词语,返回一个词语列表

查找(返回列表类型)

精确查找模式:把文本精确的切分开,不存在冗余单词 (较常用)

全模式模式:把文本所有可能的词语都扫描出来,有冗余

搜索引擎模式:在精确模式下,对长词再次切分

添加新词

下次查找时会将这个词语识别,进行分割

'''

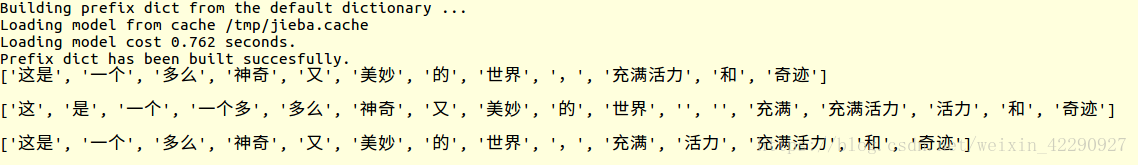

# 精确查找模式

s = jieba.lcut("这是一个多么神奇又美妙的世界,充满活力和奇迹")

# 全模式查找模式

s = jieba.lcut("这是一个多么神奇又美妙的世界,充满活力和奇迹", cut_all = True)

# 搜索引擎模式

s = jieba.lcut_for_search("这是一个多么神奇又美妙的世界,充满活力和奇迹")

# 向分词词典添加新词

jieba.add_word("张全蛋")