目录

III. PLANT/WEED CLASSIFICATION FOR UAVS

3.2 Objects-based vs. Keypoint-based Feature Extraction

3.4 Random Forest Classifification

4.3 Classifification of Crops and Different Weed Types

4.4 Impact of Geometric Features

4.6 Effect of the Availability of NIR Information

Abstract

智能农业应用中的无人飞行器(UAV)和其他机器人提供了按植物监测农田的潜力,从而可以减少必须使用的除草剂和杀虫剂的数量。对于农民和自主农业机器人来说,一个中心信息是关于田间杂草类型和分布的知识。在这方面,无人机以低成本提供出色的勘测能力。在本文中,我们解决了使用安装在轻型无人机上的摄像头检测甜菜等有价值作物以及典型杂草的问题。我们提出了一个系统,该系统执行植被检测、植物定制特征提取和分类,以获得作物和杂草在田间的分布估计。

我们在两个农场(一个在德国,一个在瑞士)使用无人机实施和评估了我们的系统,并证明了我们的方法允许分析田地和对单个植物进行分类。

I. INTRODUCTION

除草剂可能对生物和非生物环境产生多种副作用,并有危害人类健康的风险[7]。因此,减少现代农业中使用的除草剂数量是迈向可持续农业的一个相关步骤。在传统的杂草控制中,整个田地通常用单一剂量的除草剂均匀处理,以相同的方式喷洒土壤、作物和杂草。这种做法对用户来说很简单,因为既不需要了解杂草的空间分布,也不需要知道杂草的类型,因此通常用于传统农业。然而,这些知识的可用性提供了减少应用于农田的农用化学品数量的潜力。实现这一目标的一种方法是选择性地喷洒不同的杂草,因为它们对不同的除草剂表现出不同的敏感性。另一种方法是通过机械或激光摧毁移动平台上的杂草,从而对其进行物理控制。

因此,农业系统管理和智能农业等现代方法通常需要详细了解农田的现状。监控农田的一种流行方式是使用无人机等空中交通工具。与地面车辆相比,无人机可以在相对较短的时间内覆盖较大的区域,并且不会像地面车辆那样通过土壤压实影响田地。为了成功地进行田间干预,尽早了解田间杂草的类型和空间分布很重要。越早执行机械或化学除草行动,获得高产量。触发除草和干预任务的先决条件是详细了解杂草的传播情况。因此,重要的是要有一个自动感知管道,自动监测和分析作物,并提供有关田间状态的报告。

在本文中,我们解决了分析无人机图像以根据杂草类型、空间作物和杂草分布检查田地状况的问题。我们侧重于每株植物的检测,以估计作物数量以及各种杂草种类,从而向农民提供这些信息。因此,本文的主要贡献是建立了一个基于视觉的分类系统,用于识别作物和杂草,仅RGB以及RGB与无人机捕获的农田近红外(NIR)图像相结合。我们的感知管道能够仅根据植物的外观检测这些图像中的植物。我们的方法能够利用植物布局的几何形状,而无需明确指定已知的空间分布。但是,也可以选择利用有关作物安排的事先信息。此外,它还可以处理位于行内空间内的植被。

我们使用不同类型的摄像机和无人机实施并测试了我们的方法,如图1所示,在真实的甜菜地上。我们的实验表明,我们提出的系统能够在商业低成本无人机系统捕获的RGB图像中对甜菜和不同杂草类型进行分类。我们表明,分类系统在总体精度方面取得了良好的性能,即使在无法利用作物行检测或种植园规则模式进行基于几何的检测的图像中。此外,我们使用RGB+NIR图像评估我们的系统,这些图像是由一个相当昂贵的相机系统拍摄的,与使用安装在消费型四轮直升机上的标准配备的RGB相机(DJI Phantom 4和相机,价格约为1500美元)获得的图像相当。

II. RELATED WORK

配备不同传感器的无人机是快速获取耕地环境详细信息的绝佳平台。随着时间的推移,监测作物高度、冠层覆盖率、叶面积、氮素水平或不同的植被指数有助于自动化数据解释,从而改善作物管理,参见例如[9]、[20]、[22]、[3]。Geipel等人[3]以及Khanna等人[9]专注于使用无人机图像估计作物高度的工作。这两项工作都应用了束平差程序来计算地形模型并执行植被分段,以便根据获得的3D信息估计作物高度。Tokekar和Hook[22]引入了无人地面车辆(UGV)和无人机协作的概念,以测量农场土壤的氮水平。由于无人机的能源预算有限,其基本思想是使用无人机进行测量,使用无人地面车辆运输无人机。

在使用RGB和农田多光谱图像进行植被检测的背景下,开展了多项工作[5],[6],[23]。Hamuda等人[6]通过使用基于阈值的方法和基于学习的方法对田间图像中的植物分割进行了全面研究。Torres Sanchez等人[23]研究了一种基于归一化植被差异指数(NDVI)和过量绿指数(ExG)的自动阈值方法,以将植被与背景分离。它们的精度达到90−100%用于基于其方法的植被检测。相比之下,Guo等人[5]将基于决策树的学习方法应用于植被检测。他们使用光谱特征对基于RGB图像的不同颜色空间进行分类。我们使用基于ExG和NDVI的阈值方法,以将植被与背景分离,即主要是土壤。

数据解释的下一个层次是通过将检测到的植被分为作物和杂草两类来对其进行分类。在这方面提出了几种办法。Peína等人[16]介绍了一种基于多光谱图像的玉米田杂草图计算方法。它们基于空间和光谱特征提取超像素,对植被进行分割,并检测图像中的作物行。最后,他们使用有关检测到的作物行的信息来区分作物和杂草。在佩纳等人[17]的后续工作中,他们根据[16]对不同飞行高度的类似方法进行了评估,并取得了最佳性能,即使用在40米左右高度、空间分辨率为15毫米像素的图像,作物/杂草分类的总准确度约为90%。此外,他们得出结论,使用额外的近红外(NIR)信息可以获得更好的植被检测结果。

此外,机器学习技术也已应用于作物和杂草的分类,如种植园的无人机图像[8]、[4]、[18]、[19]。Perez Ortiz等人[18]提出了一种杂草检测系统,该系统基于将图像斑块分类为作物、杂草和土壤的值。他们使用多光谱图像的像素强度和作物行的几何信息来构建分类特征。他们评估不同的机器学习算法,并达到75的总体精度− 分类为87%。Perez Ortiz等人[19]使用支持向量机分类器对向日葵和玉米田的RGB图像进行作物杂草检测。他们提出了一种利用像素强度、纹理、形状和几何信息的统计信息作为特征的行间和行内杂草检测方法。Guerrero等人[4]提出了一种在玉米田图像中进行杂草检测的方法,该方法允许在由于降雨、干旱或除草剂处理而导致杂草在图像空间中的视觉外观发生变化后识别杂草。Garcia等人[8]进行了一项基于具有相当多窄带的多光谱图像分离甜菜和蓟的研究。他们对分类应用了偏最小二乘判别分析,通过在521、570、610和658 nm处使用四个窄带进行特征提取,甜菜和蓟的召回率分别为84%和93%。另一个值得注意的方法是Mortensen等人的方法[15]。他们应用深度卷积神经网络对不同类型的作物进行分类,以估计个体生物量。使用在土壤上方3米处采集的野外地块的RGB图像,并报告以每像素为基础评估的总体精度为80%。

我们的方法提取检测到的植被的视觉特征和几何特征,并使用随机森林[2]将植被进一步分类为有价值的作物和杂草。或者,我们执行作物行检测并提取附加特征,以将此信息集成到分类系统中。过去,我们曾为农场中的地面车辆提出分类管道[10]、[11]。在本文中,我们从以下方面扩展了我们的产品线:(i)无人机上使用的几何特征,(ii)无需遮光罩和100%人工照明的能力,以及(iii)无需NIR信息处理RGB图像的方法。

III. PLANT/WEED CLASSIFICATION FOR UAVS

拟议植物分类的主要目的是在无人机图像中识别甜菜作物和杂草,以便为准确监测实际农田上的种植园提供工具。目标是确定每张图像中每株作物和杂草的详细地图,还包括行间空间中的杂草。此外,我们还针对北欧甜菜田常见杂草种类的检测,这对于德国的精确农业系统来说是一个重要问题和挑战性任务。系统的输入为4通道RGB+NIR图像或常规RGB图像,具体取决于UAV的传感器设置。在更先进的系统上可用的可选NIR信息支持植被分析,但不是必需的。

所述任务与基于UGV的植物分类密切相关,例如我们以前的方法[10]、[11]。我们使用无人机数据代替UGV记录的数据更具挑战性,因为图像自然暴露于不同的闪电条件和不同的尺度。此外,基于UGV的系统可以利用更多关于数据的假设,并且能够控制照明,因为太阳光通常是屏蔽的,并且使用人工光源。本文提出的方法建立在[10]、[11]的基础上,但扩展了分类系统,添加了更多相关特征,可以仅处理RGB图像,并且适合无人机。

我们系统的关键步骤如下:首先,我们应用预处理,以便在全球范围内标准化强度值,并检测每个图像中的植被。其次,我们利用基于对象[11]和基于关键点[10]的方法相结合,仅为对应于植被的区域提取特征。第三,我们应用多类随机森林分类,并获得预测类标签的概率分布。我们将以前的感知管道用于从地面车辆到无人机的作物/杂草分类,并引入以下创新:

- 用于区分不同杂草种类的多类检测

- 基于RGB+NIR或仅RGB图像的分类,以及

- 用于利用植物排列和作物行的几何特征(如果可用)。

3.1Vegetation Detection

植被检测的目标是通过计算植被遮罩去除背景,即土壤或其他物体,得到图像 I。

对于每个像素位置(i,j)。根据输入数据(RGB+NIR或RGB图像),我们应用不同的植被指数从背景中分离植被部分。如果近红外信息可用,我们根据[21],通过归一化植被指数差异(NDVI)利用近红外和红色通道中植物的光谱特征。如果我们只有RGB数据可用,我们依赖以下公式给出的超额绿色指数(ExG)

![]()

并基于阈值计算掩蔽。

ExG和通过阈值化获得的植被掩码的图示见图2。与NDVI相比,ExG为RGB图像中的植被识别提供了适当的指数分布,证实了[12]、[14]、[9]的结果。然而,如果图像中的绿色物体与植被不符,这种方法可能会导致错误的分割。然而,在农业领域,除植物外,绿色物体通常很少,因此,如果没有近红外通道可用,ExG指数是我们应用的一个很好的选择。

3.2Objects-based vs. Keypoint-based Feature Extraction

给定植被掩码V,我们提取特征作为分类系统的输入。这里,我们考虑两种方法。第一种方法从植被遮罩V中计算每个分段对象的单个特征向量,而第二种方法在植被区域内的关键点密集网格上计算特征向量,类似于我们之前在[11]中描述的方法。

最初,基于对象的方法在V中搜索对象,即连接的植被像素。然后,我们使用属于线段的所有像素计算每个对象O的特征向量。相比之下,基于关键点的方法对植被像素不做拓扑假设。关键点K由其位置(i,j)和某个邻居N(K)给出。我们定义了关键点K在网格上的位置,网格在图像中的整个植被像素上具有恒定的晶格距离,并在考虑其邻域N(K)的情况下提取K的特征向量。在我们当前的实现中,我们使用10像素乘10像素的晶格距离作为关键点,并选择20像素乘20像素对于邻域N(K)。图3直观地描述了这两种方法的概念。基于对象的方法的优点是,特征主要描述整个植物,而表示植被所需的对象相对较少。基于关键点的方法在处理分割不足和重叠的植物方面具有优势。在[11]中,我们表明,将这两种方法结合在一起,将分别从各自的优势中获益。在这项工作中,我们使用级联方法。

对于特征提取,我们从与[11]中描述的相同的一组统计特征和形状特征开始,并为每个对象O和每个关键点K提取一组特征F。这组特征包含关于(i)捕获图像的强度值,(ii)其梯度表示,(iii)不同的颜色空间表示和(iv)纹理信息的统计信息。

3.3 Geometric Features

除了[11]中描述的特征外,我们还考虑了其他几何特征,以利用场几何进行图像分析。通常,与无人地面车辆相比,无人机的种植园图像捕获的区域更大。因此,他们在图像中观察到足够数量的作物,以执行行检测并测量多个单个植物之间的空间关系。我们研究了额外的几何特征,以利用作物大多具有规则的空间分布而没有明确指定的事实。请注意,杂草也可能以系统的方式在空间上出现,例如。在现场或经常在现场的边界区域。首先,我们执行线集检测以查找平行的作物行,并使用从潜在行到O和K的距离作为随机森林分类器的特征。其次,我们计算对象和关键点周围的局部邻域中基于分布的距离和角度,并从中提取统计信息,将其用作附加特征。

在大多数农田环境中,植物成排排列,它们共享一个恒定的行间距r,即两个相邻作物行之间的距离。主要目标是线条特征

是利用对象O或关键点K到裁剪行的距离d。我们通过行间距 r 规范化 d,并使用 fl 作为分类器的附加特征。值 d 和 r 以像素为单位进行测量,可以在图像空间中直接获得。从数学角度来看,作物行可以表示为一组有限的平行线

![]()

其中,θ表示线集的方向,ρ表示从每条线li到图像帧原点的距离。

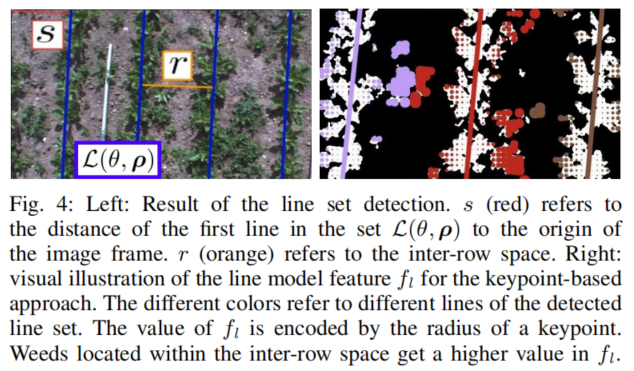

1) 裁剪行的线条特征:图4描述了检测到的线条集的示例性结果,并说明了基于线条的特征的概念。我们引入了ρi等距的约束,以利用作物行间空间是恒定的这一事实。注意,我们没有对r的大小做任何假设,即行间空间。为了检测平行线的集合L(θ,ρ),我们在植被掩码V上使用了Hough变换。该Hough空间累积了投票数Vρ,θ,即给定线的对应植被像素数与参数θ和ρ。为了计算L(θ,ρ),我们分析了Hough空间并执行以下三个步骤。

①步骤1:估计作物行的主方向:我们计算图像中植被的主方向θL,以估计作物行方向。

这个方向可以通过考虑Hough空间中平行线的投票来估计。在这里,我们采用了类似于Midtiby和Rasmussen[13]提出的方法。为了获得θL,他们计算响应

并选择最大E(θ)。术语![]() 是指具有参数θ,ρ的某条线的投票数。与[13]相反,我们不仅选择E(θ)的最大值,而且考虑E(θ)的N个最佳值,以评估在后续步骤中给定植被的Hough空间中N个最佳投票方向。在我们的实现中,我们使用N=15。我们考虑了植被支持的15个最佳主要方向,以便处理大量杂草的情况。在高杂草压力下进行的测试表明,最大响应并不总是正确的选择,因为许多杂草植物可能会为错误检测行赢得更多选票。

是指具有参数θ,ρ的某条线的投票数。与[13]相反,我们不仅选择E(θ)的最大值,而且考虑E(θ)的N个最佳值,以评估在后续步骤中给定植被的Hough空间中N个最佳投票方向。在我们的实现中,我们使用N=15。我们考虑了植被支持的15个最佳主要方向,以便处理大量杂草的情况。在高杂草压力下进行的测试表明,最大响应并不总是正确的选择,因为许多杂草植物可能会为错误检测行赢得更多选票。

②步骤2:将作物行估计为平行线集:给定步骤1中可能的线集的N个最佳投票方向,我们需要估计在哪个方向找到具有等距间距的最佳平行线集。

我们搜索相邻行之间未知但恒定的间距r以及图像空间中第一个潜在裁剪行的偏移量s,如图4所示。因此,我们搜索

有罚款期限

![]()

通过改变r和s的大小。术语Lr是指给定r的图像中与之相交的线的数量。惩罚术语P是一个额外的成本术语,针对集合中的每一行引入,以惩罚不断增加的行数。这里,![]() 是与Hough空间中

是与Hough空间中![]() 相对应的柱上的平均响应。根据等式(6),这导致E对响应更好的线的影响增大,与

相对应的柱上的平均响应。根据等式(6),这导致E对响应更好的线的影响增大,与![]() 相比,如果响应较低,反之亦然。根据公式(6),最大响应提供了最佳投票行集,该行集具有恒定的行间距。

相比,如果响应较低,反之亦然。根据公式(6),最大响应提供了最佳投票行集,该行集具有恒定的行间距。

③第三步:根据数据重新调整最佳行集:作物通常以一定行数的固定集合播种,称为地块。由于播种机的位置精度有限,地块之间的行间距可能略有不同。为了克服这一点,我们最终使用基于Huber核的稳健估计量将从步骤2获得的最佳集的每一行拟合到数据,并获得作物行的稳健估计![]() 。

。

2) 空间关系特征:为了描述各个植物之间的空间关系,我们首先计算从查询对象Oq或关键点Kq到世界坐标中所有其他附近对象或关键点的距离和方位角(这需要知道无人机的飞行高度)。我们计算查询对象与其相邻对象之间测量距离的差异,以获得直方图形式的分布。同样,我们从观测到的方位角中获得了角度分布。根据这些分布,我们计算常见的统计性质,如最小值、最大值、范围、平均值、标准差、中值、偏度、峰度和熵,并将它们用作分类器的特征。除此之外,我们还计算了对象空间中其邻域中植被对象O或关键点K的数量。

空间关系特征和线特征都允许编码额外的几何属性,并以此方式改进用于进行实际决策的随机森林分类器。

3.4 Random Forest Classifification

我们采用了一种相当标准的随机森林[2],这是一种相对稳健的集成方法,能够解决多类问题。中心思想是通过随机使用训练数据中的特征和元素,在训练时构建大量决策树。它还允许通过考虑单个决策树的输出隐式估计类标签的可信度。

IV. EXPERIMENTS

该评估旨在说明我们基于无人机的植物杂草分类系统的性能,并支持本文的主要观点。这些声明是:(i)我们的分类系统以RGB的形式识别甜菜以及甜菜农场的常见杂草种类无人机捕捉到的图像,即使作物不是成排播种,线检测也无法支持分类,(ii)我们证明,我们的植物分类系统能够利用我们提出的线模型,利用作物行之前的排列,此外,还受益于几何特征,几何特征捕获了局部邻域的空间关系,并且(iii)我们的方法在诸如重叠植物等具有挑战性的条件下提供了良好的结果,并且能够在行内空间进行杂草检测。最后,我们从植被检测和分类性能的角度分析了利用额外的近红外通道的效果。

4.1 Evaluation Metric

我们通过ROC曲线和精确召回(PR)图说明了分类结果的性能。对于这些图,我们改变了与随机森林的估计置信度相关的类标记阈值。影响作物/杂草分类性能的参数专门针对图像中检测到的植被部分进行评估,以分析分类输出的质量。我们在图像中手动标记所有植物,并在对象级别进行评估,即。预测对象与地面真实对象,以获得尽可能接近每个工厂的性能。对于基于关键点的分类,我们计算与地面真值对象相关的预测关键点的类比,以保持对象级别的评估度量。

4.2 Datasets

我们收集了三个不同的数据集,具有不同的特征和挑战,以彻底评估每一个我们的植物/杂草分类系统的性能。所有记录的数据集都代表了真实的田间条件,包括甜菜作物和杂草。

JAI数据集是用4通道JAI AD130 GE相机在瑞士埃西肯的一个甜菜农场捕获的。数据集包含97张RGB+NIR图像,这些图像是2016年5月在1.5个月内每周拍摄的甜菜排成作物行和杂草的图像。甜菜的生长阶段是从早期4叶到晚期6叶。摄像机向下指向田地,高度约为土壤上方2− 3m。1296×966像素的图像分辨率与4 mm焦距的Fujinon TF4DA 8镜头相结合,地面分辨率约为![]() 。矩阵数据集由DJI MATRICE 100无人机的Zenmuse X3相机捕获。2016年5月,在与JAI数据集相同的字段上记录了两天的数据,时间差为一周。数据集包含31个RGB图像,其中作物处于早期6叶生长阶段。我们用无人机在离地面大约15米的地方飞行。获得的地面分辨率约为5

。矩阵数据集由DJI MATRICE 100无人机的Zenmuse X3相机捕获。2016年5月,在与JAI数据集相同的字段上记录了两天的数据,时间差为一周。数据集包含31个RGB图像,其中作物处于早期6叶生长阶段。我们用无人机在离地面大约15米的地方飞行。获得的地面分辨率约为5 ![]() 。JAI数据集和MATRICE数据集为评估线特征和分析作物/杂草分类性能提供了基础。数据集包含位于行间和行内空间内的杂草。在这些数据集中,杂草的数量与作物相比要少得多。PHANTOM数据集是在德国波恩的一块田地上采集的,那里的甜菜不是在作物行中播种的。数据集提供未经修改的消费者DJI Phantom 4 UAV获得的图像。获得的地面分辨率为0.2

。JAI数据集和MATRICE数据集为评估线特征和分析作物/杂草分类性能提供了基础。数据集包含位于行间和行内空间内的杂草。在这些数据集中,杂草的数量与作物相比要少得多。PHANTOM数据集是在德国波恩的一块田地上采集的,那里的甜菜不是在作物行中播种的。数据集提供未经修改的消费者DJI Phantom 4 UAV获得的图像。获得的地面分辨率为0.2 ![]() ,相当高,因为在飞行高度为3 m的情况下拍摄的图像分辨率为4000×3000像素。由于分辨率的原因,我们可以直观地识别常见甜菜田上的典型杂草,即盐灌木(Atriplex)是一种常见的问题杂草,其质量为洋甘菊(Matricaria chammilla)和其他杂草。

,相当高,因为在飞行高度为3 m的情况下拍摄的图像分辨率为4000×3000像素。由于分辨率的原因,我们可以直观地识别常见甜菜田上的典型杂草,即盐灌木(Atriplex)是一种常见的问题杂草,其质量为洋甘菊(Matricaria chammilla)和其他杂草。

4.3 Classifification of Crops and Different Weed Types

我们评估中的第一个实验旨在证明我们的系统能够对甜菜和杂草物种进行分类,这在甜菜农场很常见。因此,我们分析了PHANTOM数据集在甜菜、盐灌木、洋甘菊和其他杂草分类方面的性能。图6(左列)描述了在一对所有模式下计算的ROC和PR图,以说明获得的性能。

ROC曲线表明,对于所有明确指定的类别,根据所选阈值,可以获得约90%的召回率,对于saltbush,甚至95%的召回率。基于预测的随机林最大置信度的类标记会导致以下结果。该系统实现了95%的盐灌木召回和87%的洋甘菊召回。这两种物种的预测精度均为85%。对于甜菜,召回率为78%,精确度为90%。一般来说,对其他杂草获得的召回率为45%时,精确度会受到影响。此结果受(i)影响在数据集中有少量的例子,并且(ii)可能有更高的类内方差,因为在这个数据集中发生的所有其他杂草都由这个类表示。需要更多不同杂草类型的数据集来澄清这一点。就总体准确度而言,86%的预测对象和93%的区域被正确分类。

如果我们只关注作物与杂草的分类,那么在对象级别上检测的总体准确度将提高11%到96%。对于甜菜,性能没有改变,但杂草物种的融合导致召回率达到99%,获得的准确度为97%。

4.4 Impact of Geometric Features

我们设计了第二个实验,以说明使用几何特征时对性能的影响。因此,我们使用所有几何特征(即线特征和空间关系特征)评估所有数据集,并将结果与忽略它们的性能进行比较。图6通过使用所有几何特征(“带SRF\/LM”),仅使用空间关系特征(“含SRF”),而不使用线特征,说明了每个数据集的结果。

我们的评估表明,使用几何特征支持基于视觉特征的分类,因为它提高了所有测试数据集中的总体精度和精度,特别是杂草。即使对于不涉及植物任何规则模式的PHANTOM数据集,性能也得益于空间关系特征的使用。在数字上,saltbush的准确率和召回率都提高了约6%。对于所有其他类别,在给定精度下,召回率平均提高约3%。对于JAI数据集和MATRICE数据集,我们分别通过对整个数据集进行单独交叉验证,测量了空间关系特征和所有几何特征(包括直线模型特征)的影响。

对于MATRICE数据集,可以观察到最大的性能提升。这里,仅基于视觉外观的检测,即忽略几何图形的特征,受到相对较低的地面分辨率的影响。因此,几何特征成为检测的重要支持者,因为它们对图像分辨率相当稳定。平均而言,空间关系特征的性能提高了10%左右,而线条特征的总体精度提高了13%。相应的PR图表明,这个数量主要是由更好的检测造成的。该语句也适用于JAI数据集。PR图显示,即使精度高于85%,杂草的召回率仍显著提高约5%。总之,几何特征对MATRICE数据集和PHANTOM数据集的影响较小,即5%。这是因为基于纯视觉外观的分类性能更好,并且相对于类标记的不同阈值更稳定。我们得出结论,使用几何特征进行分类是开发农田环境中人工林空间特征的合适方法。

4.5 Intra-Row Weed Detection

大多数利用作物行的先验知识边缘的现有方法执行以下两个步骤:(i)检测行和(ii)使用几何图形强制对应行的植被成为杂草。与此相反,我们的方法适用于利用几何图形和识别行内杂草。在随机森林中使用fl作为特征导致了这样一个事实,即位于行内空间的植被仍然有机会根据其视觉特征被检测为杂草。

图5直观地展示了我们的方法性能的典型示例。将来自JAI数据集(中间行)和MATRICE数据集(底部行)的示例图像与相应的地面实况图像进行视觉比较,结果表明在行内空间中正确检测到杂草。这一结果来源于同时使用几何特征的分类。

4.6 Effect of the Availability of NIR Information

在我们的上一次实验中,我们评估了使用额外的近红外信息进行植被检测和作物杂草分类的效果。我们把这个实验分成两部分。首先,我们评估给定RGB+NIR和仅RGB图像的植被检测性能,并将其与地面真实情况进行比较。其次,我们分析了额外的近红外信息对分类的影响。对于这一部分,我们通过使用ExG获得的掩模,基于RGB和RGB+NIR图像提取特征,以避免掩模对所考虑的形状特征的影响,参见[11]。最后,为了只依赖视觉信息,我们忽略了几何特征的使用。

我们在JAI数据集上测试了几种常用的植被指数,作为基于阈值的植被分割的基础,见[6]、[9]、[23],其中RGB和NIR图像都可用。为了在对象级别评估分割性能,我们将获得的植被掩码Vindex与标记数据进行了比较。如果75%的像素被检测为植被像素,我们将对象定义为检测到的对象。表二概述了使用NDVI、ExG、归一化绿红差值指数(NGRDI)、过量绿减过量红指数(ExGR)和植被提取颜色指数(CIVE)对植被目标的检测率。

使用近红外信息利用NDVI进行检测优于所有基于RGB的方法。图8描述了当图像中的某些部分被着色时V的典型结果。视觉上,基于NDVI的掩蔽(白色)比基于ExG的(绿色)植被检测效果更好。这是因为近红外通道观察到植被像素具有相当高的反射率,即使在阴影区域也是如此。仅考虑RGB数据,我们使用ExG,因为它是给定数据的最佳选择。

图7描述了使用附加近红外信息(RGB+NIR)以及仅依赖RGB的分类性能的精确召回图。将NIR通道用于功能部件可以将总体精度提高3%左右。总之,使用额外的近红外可以获得更好的分类结果,并在阴影图像区域的植被分割方面提供更强的鲁棒性,但如果缺少近红外信息,我们的方法也可以操作。

V CONCLUSION

精确农业应用中使用的无人机必须能够区分农田中的作物和杂草,以估计杂草的类型和分布。在这项工作中,我们使用常规RGB相机和RGB+NIR相机,重点观察德国和瑞士的甜菜植物和田间典型杂草。我们描述了一个基于目标特征和关键点以及随机森林的航空图像植被检测、特征提取和分类系统。我们的系统可以通过几何特征利用作物的空间排列。我们实施了我们的方法,并根据两个农场捕获的无人机数据对其进行了全面评估,并说明我们的方法可以识别农田中的作物和杂草,这对于一些精确农业应用来说是一个重要信息。