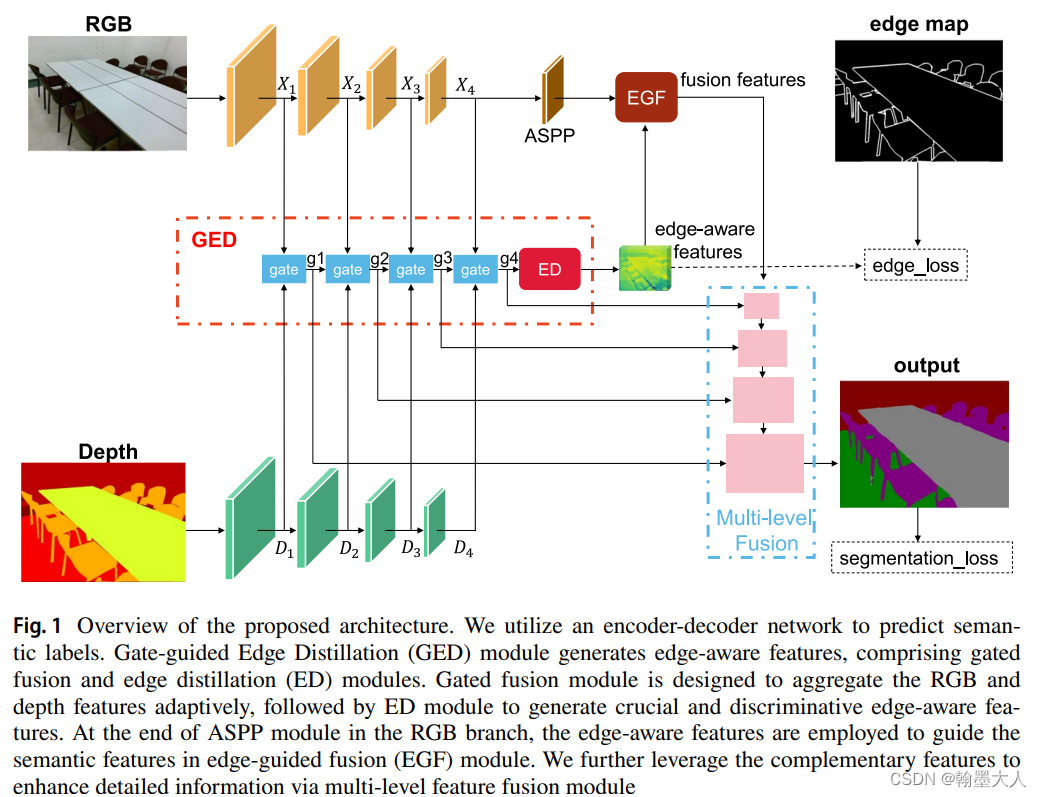

本文提出gate-guided edge distillation(GED)通过融合rgb和depth特征来产生edge-aware特征。GED包含两个部分,gate fusion和edge distillation,gate fusion自适应学习rgb和depth的关系来生成互补特征。edge distillation增强相同物体的语义特征,同时保留不同物体的语义特征之间的差异。将经过edge distillation之后的特征与高层语义特征进行融合。最后互补的特征用于多层特征融合模块来增强细节信息。

文章受到gate-scnn的启发,提出使用edge-aware特征来融合语义特征作为细节引导。

文章结构:首先两个backbone用来提升RGB和depth分支,gate fusion用于融合rgb和depth分支,为了得到更准确的edge-aware特征,我们使用edge distillation来进行一个增强。最后通过EGF模块来融合经过edge distillation增强过的edge-aware和语义特征。为了进一步增强细节信息,经过gate fusion后的特征用于decoder的高分辨率标签的预测。

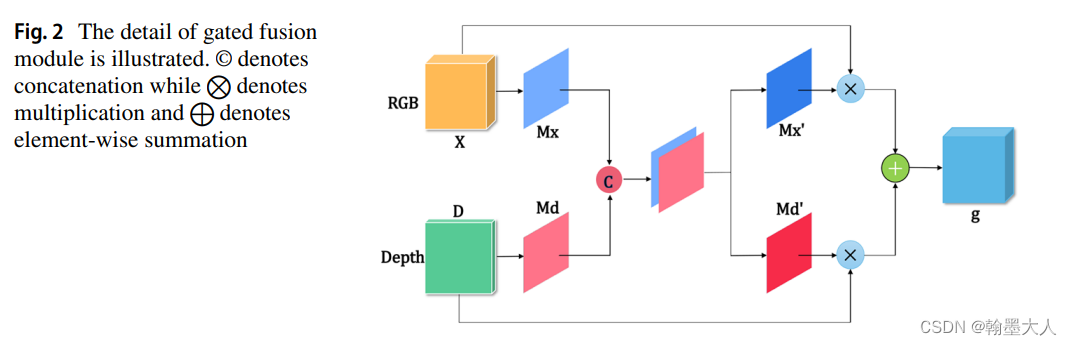

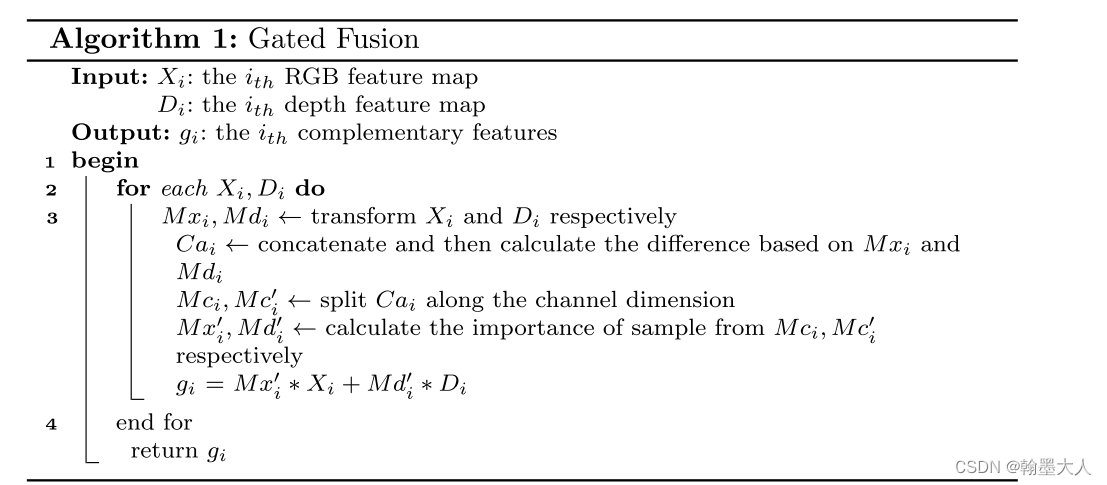

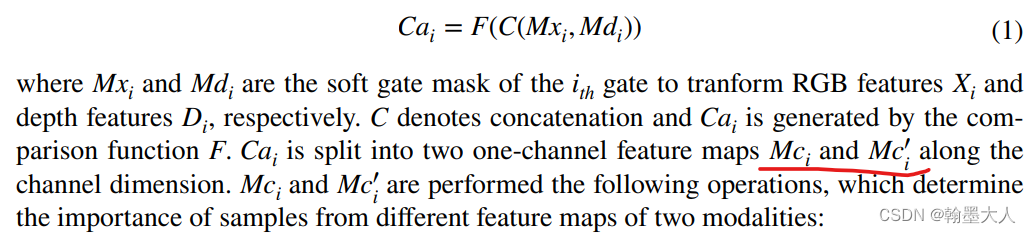

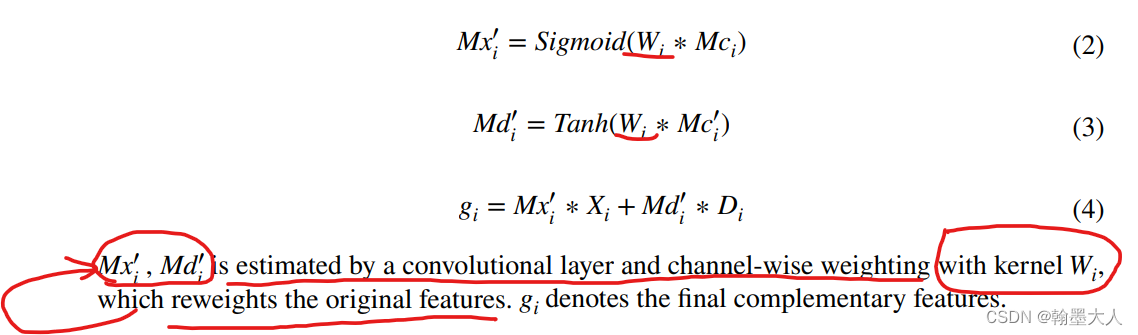

gate-fusion模块:

rgb和depth首先经过1x1卷积,得到一个soft gate mask。(推测直接将输出维度变为1了),然后将两个mask进行concat,然后对拼接后的特征进行一个comparsion function,就是一个1x1卷积,然后将特征沿着通道维度划分为两个通道为1的特征。接着和原图进行一个逐像素相乘,维度不匹配,这里采用了广播机制。最后进行一个逐像素融合。

用公式表示为:

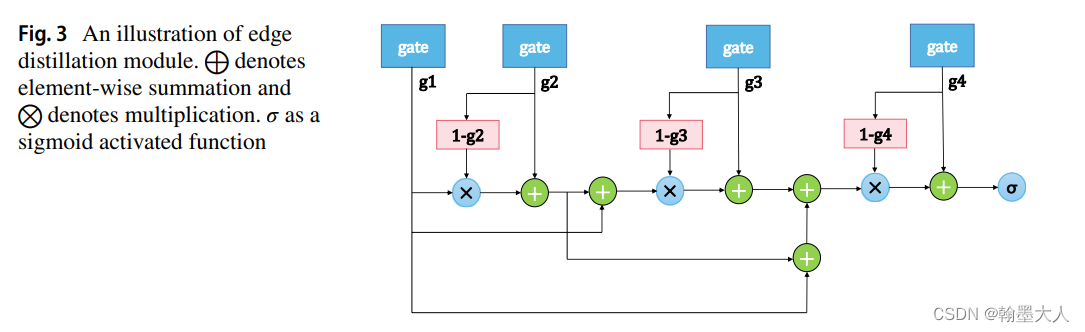

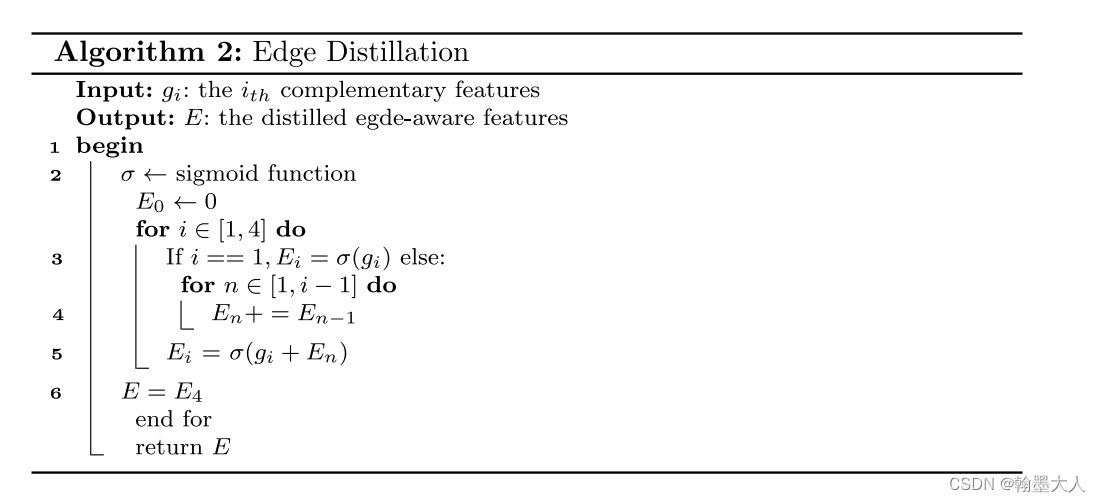

edge distillation:

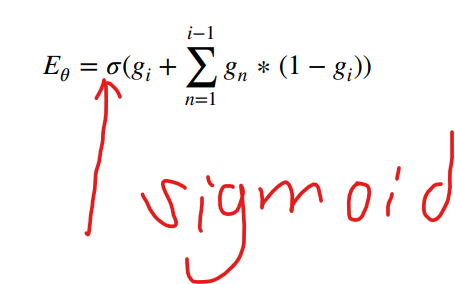

将RGB和depth融合的四个特征进行一个distillation,用公式表示为:

根据原图我们可以看出g1和(1-g2)相乘,然后再和g1相加,文章给出的解释为:1- g通过滤除掉其他的层的特征来处理不相关的信息。因此可以学习到不同语义散度。一个额外的相加融合去学习物体和他周围的关系。

这里猜测g1 * (1 - g2) = g1 - g1 * g2,g1 * g2是否类似于transformer中的两个矩阵的点积,他们之间的值越大,代表他们越类似。g1 减去g1和g2类似的部分就是g1和g2不同的地方,g2加上g1不类似的部分,就是不同尺度的不同语义信息,后面的g3,g4同理。

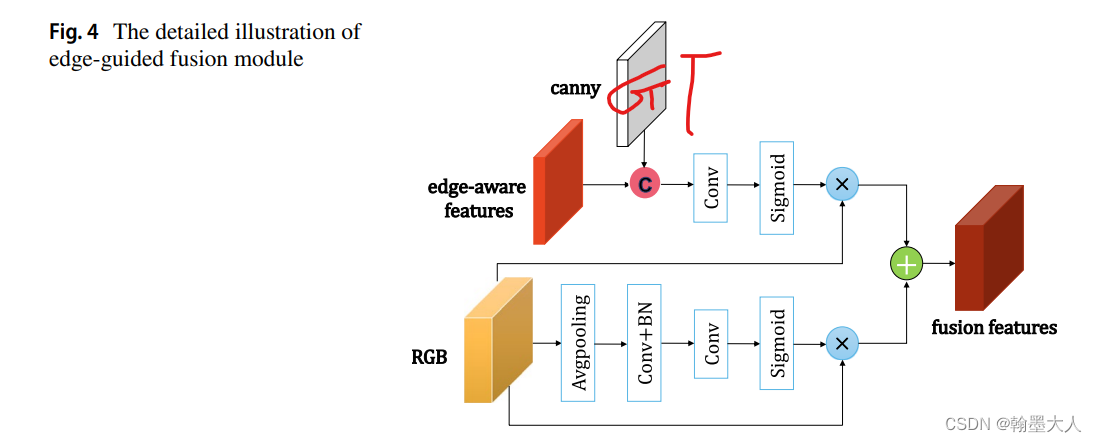

edge-guided fusion:

用于融合edge-aware和语义信息。edge体现在对gt进行canny操作,将生成的结果和edge-aware特征进行拼接和sigmoid。原始的RGB和进过sigmoid之后的edge分支相乘,相当于突出RGB的边缘信息,下面的分支进行了一个注意力操作。

注意在原图中GT生成了一个edge map用于监督edge-aware特征。

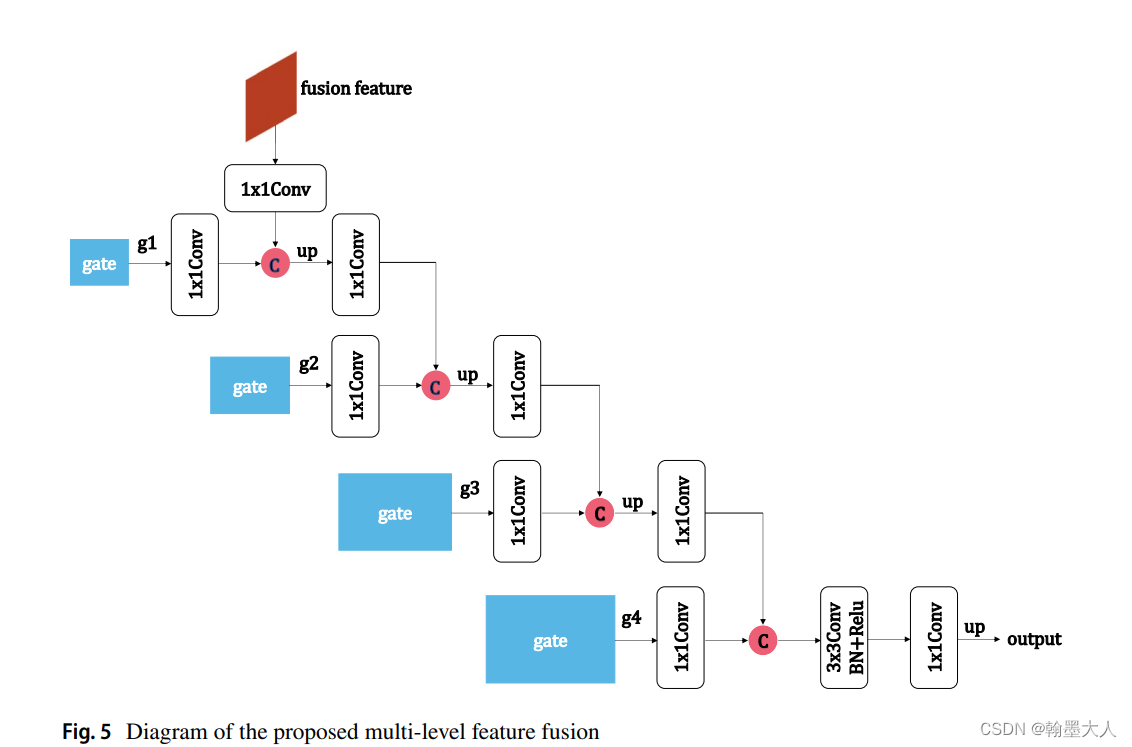

multi-level feature fusion:

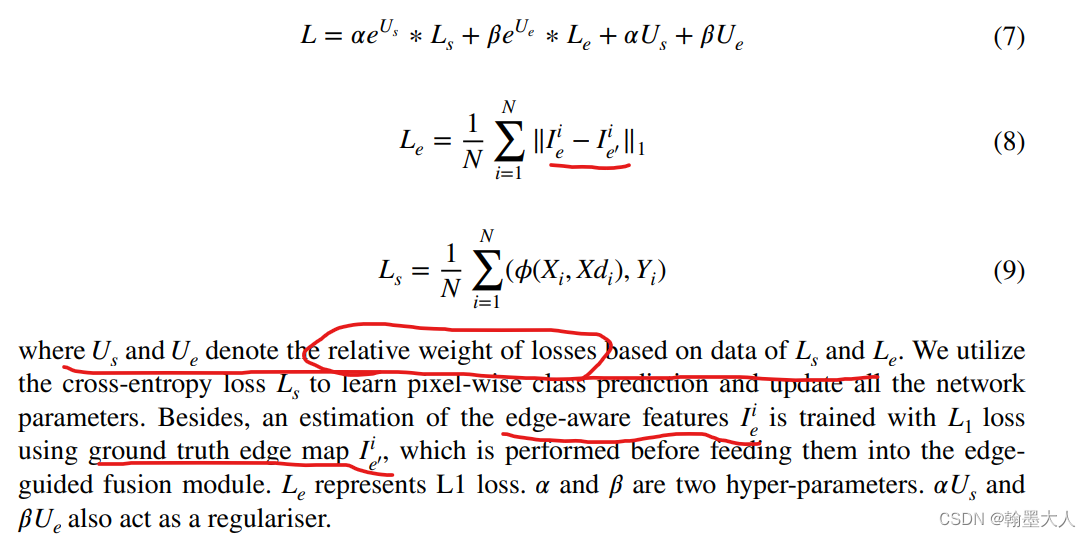

损失:

对于分割损失使用交叉熵损失,对于边界损失使用L1损失。

实验:

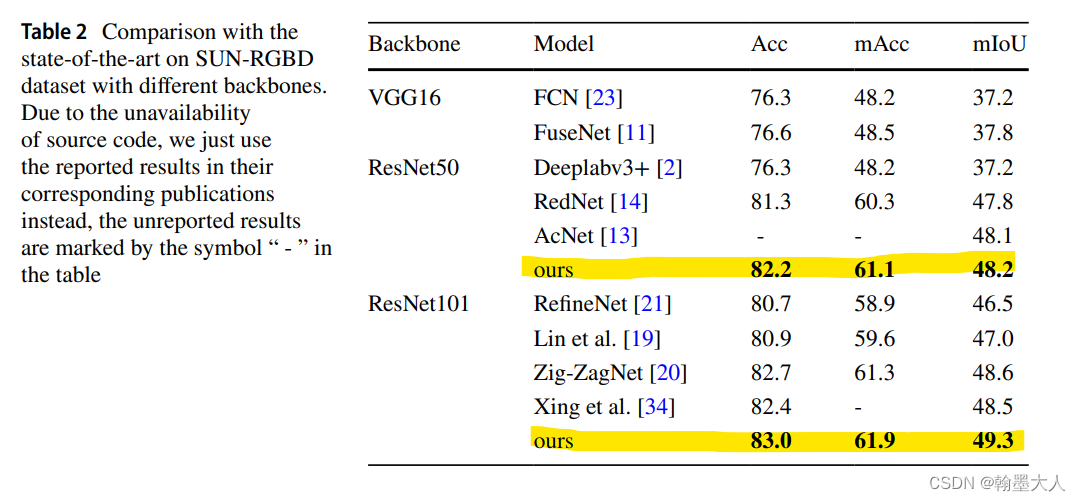

在sunrgb-d上结果:

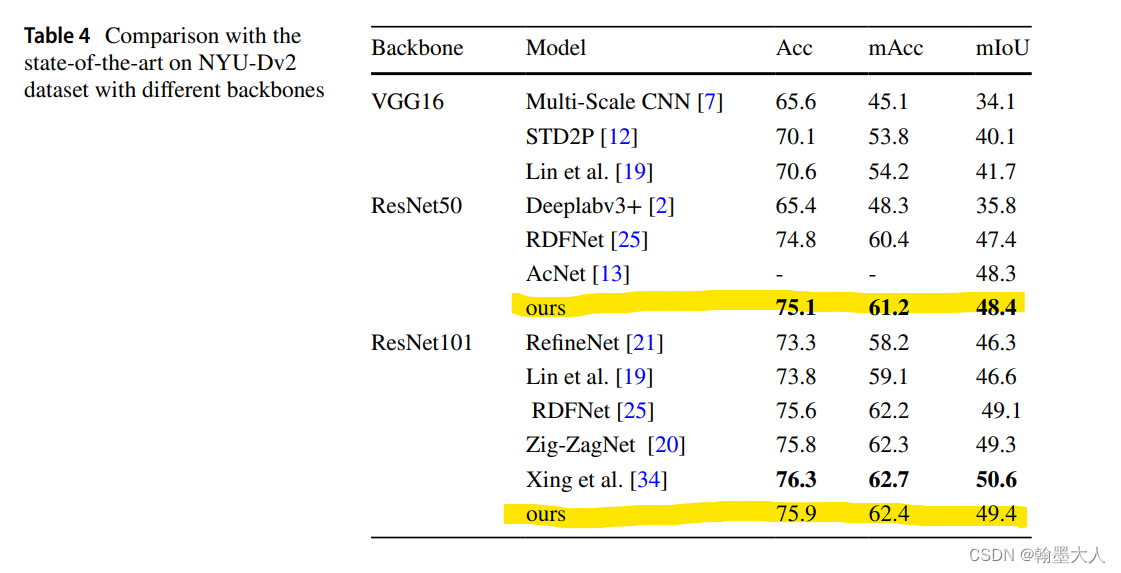

在nyu上结果: