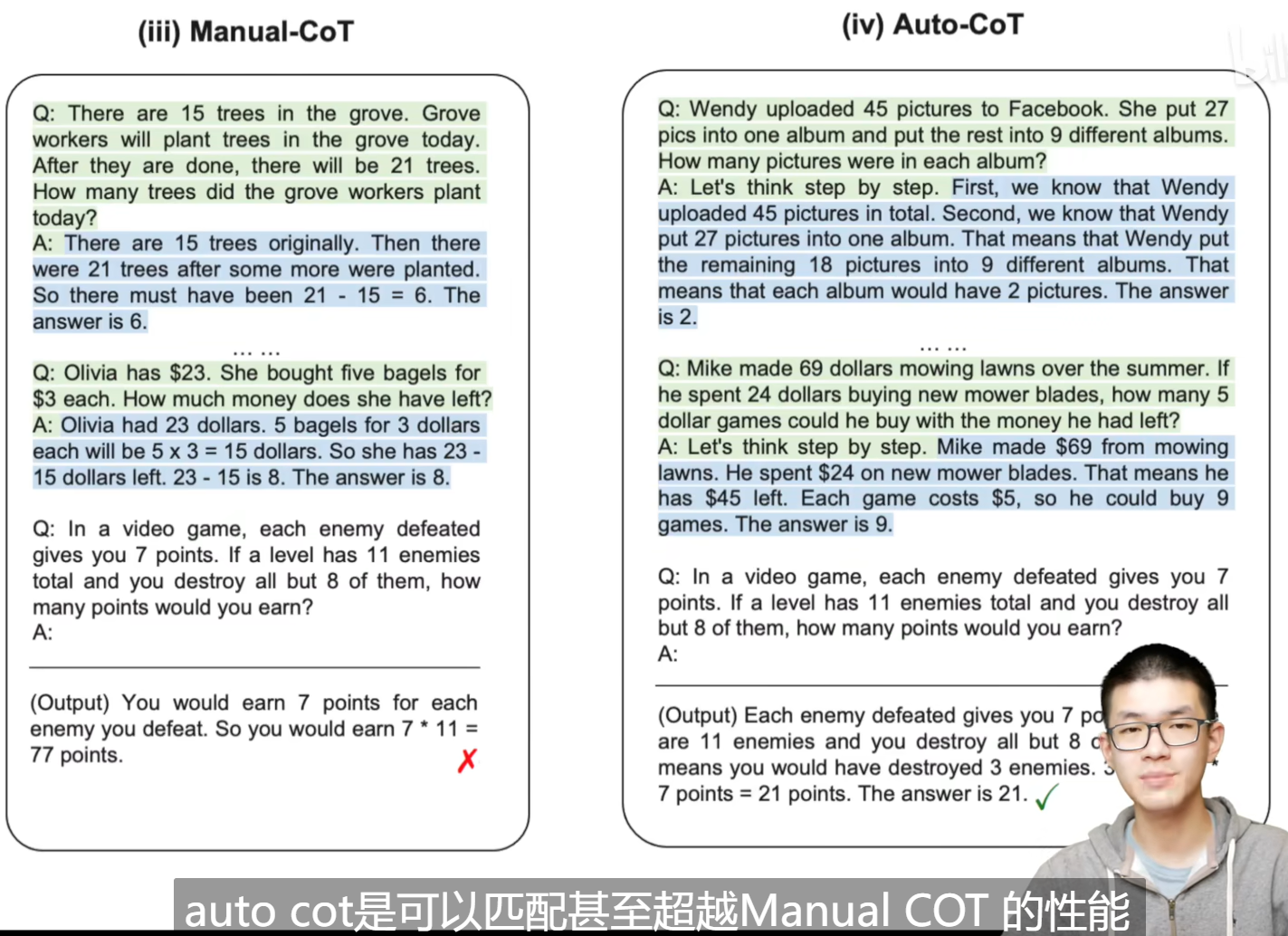

manual-cot属于few shot,Q和A属于人工设计的问题,autocot使用let's think step by step,前面的Q和A是采样的。not just step by step,lets one by one,不仅仅使用一个step by step,多次使用。

1.abstract

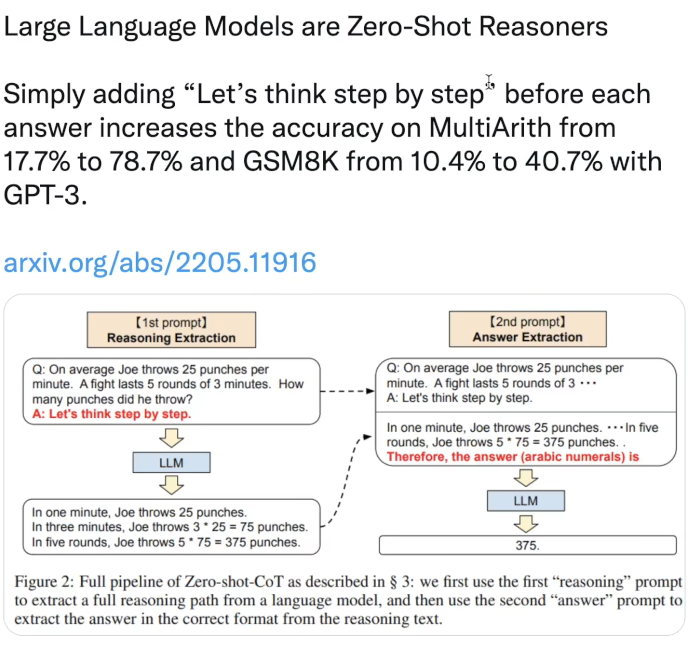

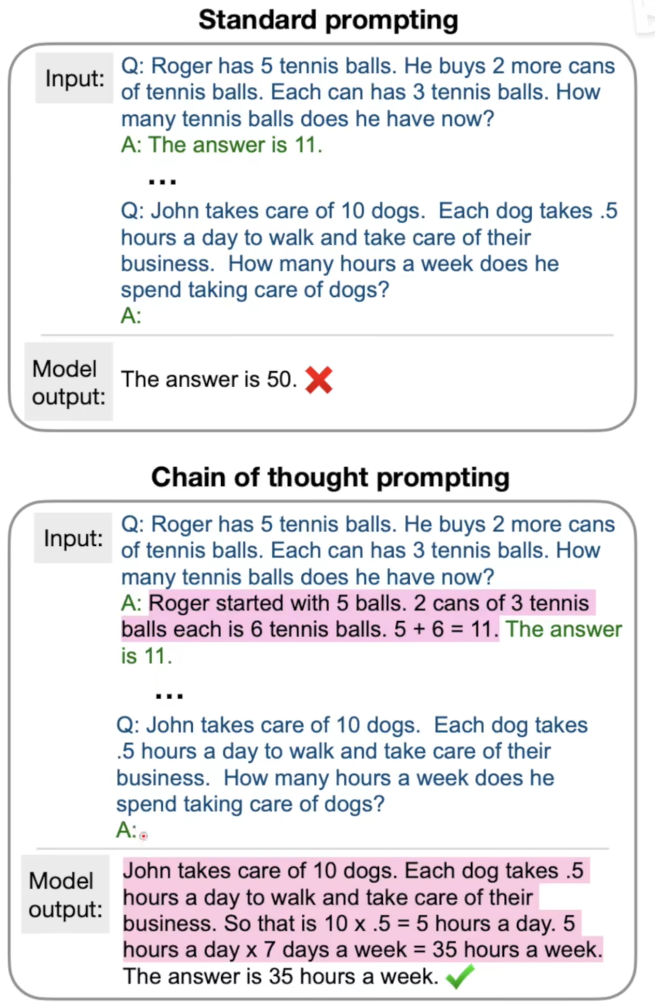

chain of thought(cot):人类在遇到问题时所产生的的推理步骤,表现形式是一些列的短句子。用了cot之后,palm540b在GSM8k上取得了58.1%。

2.introduction

system 1:能够很快被理解的。system 2:很慢需要理解的,需要一步一步思考的,比如解数学题。

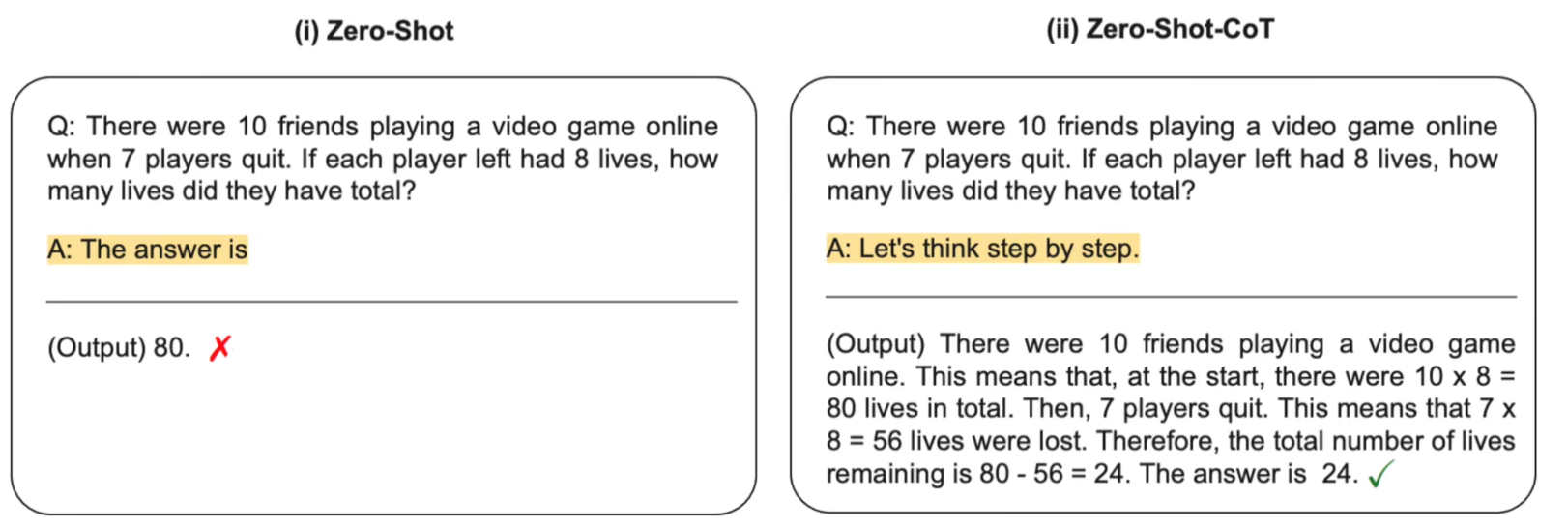

在prompt中不仅给出答案,再让大模型续写,而且给出推理过程,大模型续写正确率会提高。

cot需要更多计算量,因为更多的推理过程;cot有更好的可解释性。

人工构造cot的成本很高的,需要自己写推理过程。

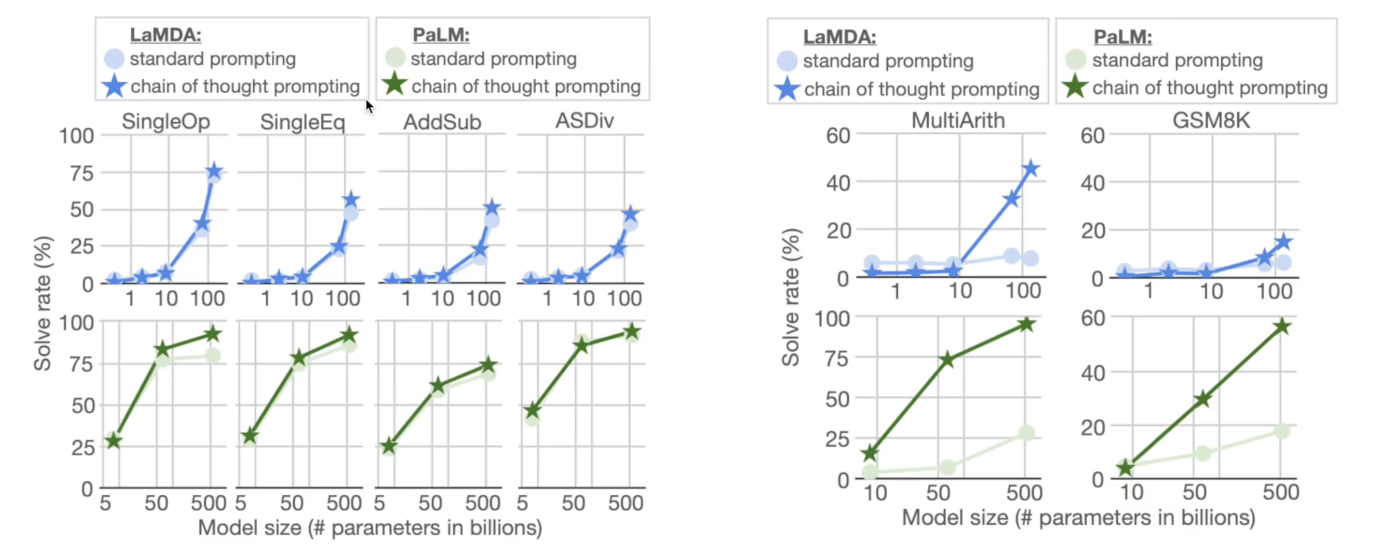

在简单数据集上,模型越大,能力也是越高的,但是在难的数据集上,如果只使用标准的prompt,是不如cot prompt的,即便增大模型参数量效果也是不佳的,并非正相关的。

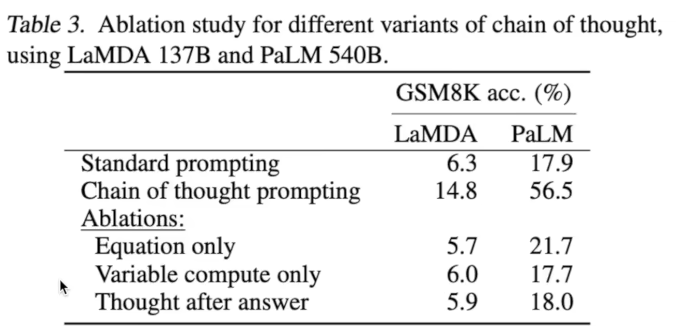

第一种,只有公式,第二种把cot替换成与中间式子等长的...,第三种把推理过程写在答案后面,效果都不太好,体现出cot中自然语言的作用。

在cot之前的prompt只是大模型语言能力的下线。

https://www.bilibili.com/video/BV1t8411e7Ug/?spm_id_from=333.999.0.0&vd_source=4aed82e35f26bb600bc5b46e65e25c22

https://www.bilibili.com/video/BV1t8411e7Ug/?spm_id_from=333.999.0.0&vd_source=4aed82e35f26bb600bc5b46e65e25c22