除了BN你还知道哪些归一化方法?

总结

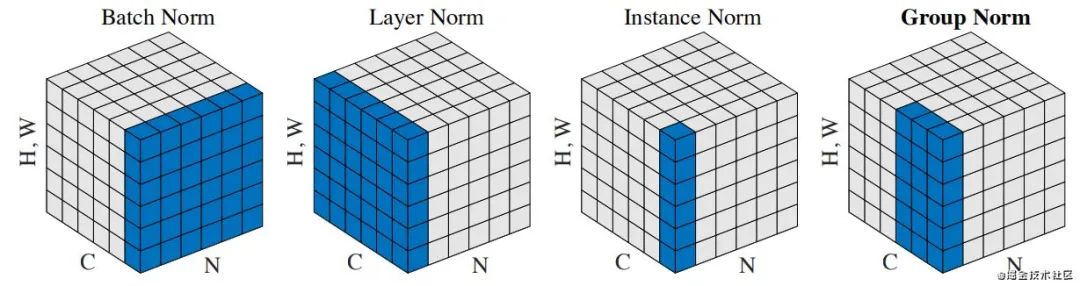

具体的深度学习中的归一化方法主要Batch Normalization(BN,2015年)、Layer Normalization(LN,2016年)、Instance Normalization(IN,2017年)、Group Normalization(GN,2018年)、Switchable Normalization(SN 2018)。它们都是从激活函数的输入来考虑、做文章的,以不同的方式对激活函数的输入进行 Norm的。

细节回答(区别)

那么这几个归一化方法主要用在什么地方呢?将输入的 feature map shape 记为[N, C, H, W],其中N表示batch size,即N个样本;C表示通道数;H、W分别表示特征图的高度、宽度。这几个方法主要的区别就是在:

BN是在batch上,对N、H、W做归一化,而保留通道 C 的维度。BN对较小的batch size效果不好。BN适用于固定深度的前向神经网络,如CNN,不适用于RNN;

LN在通道方向上,对C、H、W归一化,主要对RNN效果明显;

IN在图像像素上,对H、W做归一化,用在风格化迁移;

GN将channel分组,然后再做归一化。

SN是将上面的综合起来,实现了归一化防范的统一。

当然作者对这些操作也进行了形象化的概述,具体的可以参考链接~

参考文献:blog.csdn.net/e01528/ar G-kdom:常用的 Normalization 方法:BN、LN、IN、GN blog.csdn.net/u01328925

转载:Alex

推荐阅读:

面试题库整理:

https://github.com/chehongshu/machine-learning-interview-chinese

其他文章阅读

我的2022届互联网校招分享

我的2021总结

浅谈算法岗和开发岗的区别

互联网校招研发薪资汇总

2022届互联网求职现状,金9银10快变成铜9铁10!!

公众号:AI蜗牛车

保持谦逊、保持自律、保持进步

发送【蜗牛】获取一份《手把手AI项目》(AI蜗牛车著)

发送【1222】获取一份不错的leetcode刷题笔记

发送【AI四大名著】获取四本经典AI电子书