点上方人工智能算法与Python大数据获取更多干货

在右上方 ··· 设为星标 ★,第一时间获取资源

仅做学术分享,如有侵权,联系删除

转载于 :CVer

P2T: Pyramid Pooling Transformer for Scene Understanding

作者单位:南开大学,阿里巴巴

论文:https://arxiv.org/abs/2106.12011

代码:https://github.com/yuhuan-wu/P2T

本工作解决了视觉transformer中的两大问题:

1) 传统的Multi-Head Self-Attention (MHSA) 需要大量的计算、空间资源。

2) 最近新提出的视觉transformer在图像分类中被过度地开发和调整,却忽视了图像分类(单一场景,与MLP较为相似)和各类下游场景理解任务(复杂场景,丰富结构和内容信息)的区别。

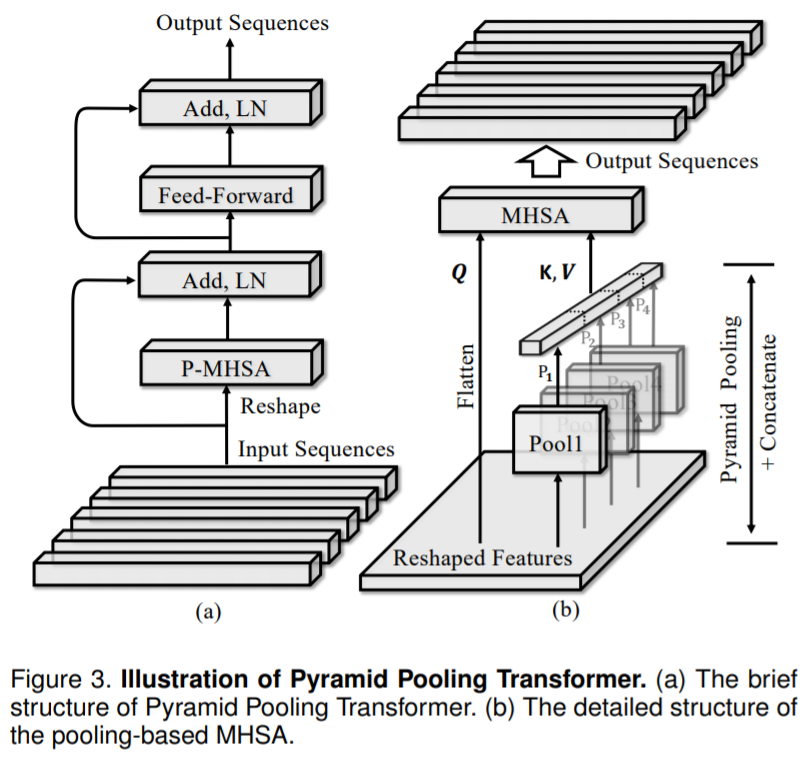

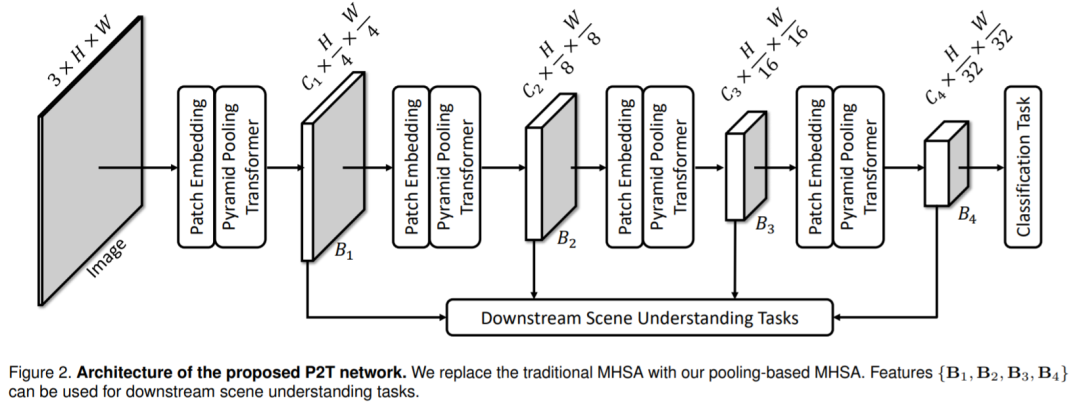

具体而言,本文注意到pyramid pooling因其强大的抽象上下文能力在各类视觉任务上的表现都十分出色,且其空间不变性的自然属性适合解决结构信息的丢失问题(问题2)。本文第一次将pyramid pooling引入到视觉transformer中,从而减少使用传统MHSA带来的过高计算量和存储空间(问题1)。

通过将基于pyramid pooling的P-MHSA嵌入到transformer内,本文构建了一个下游任务导向的视觉transformer,本文将其命名为pyramid pooling transformer (P2T)。

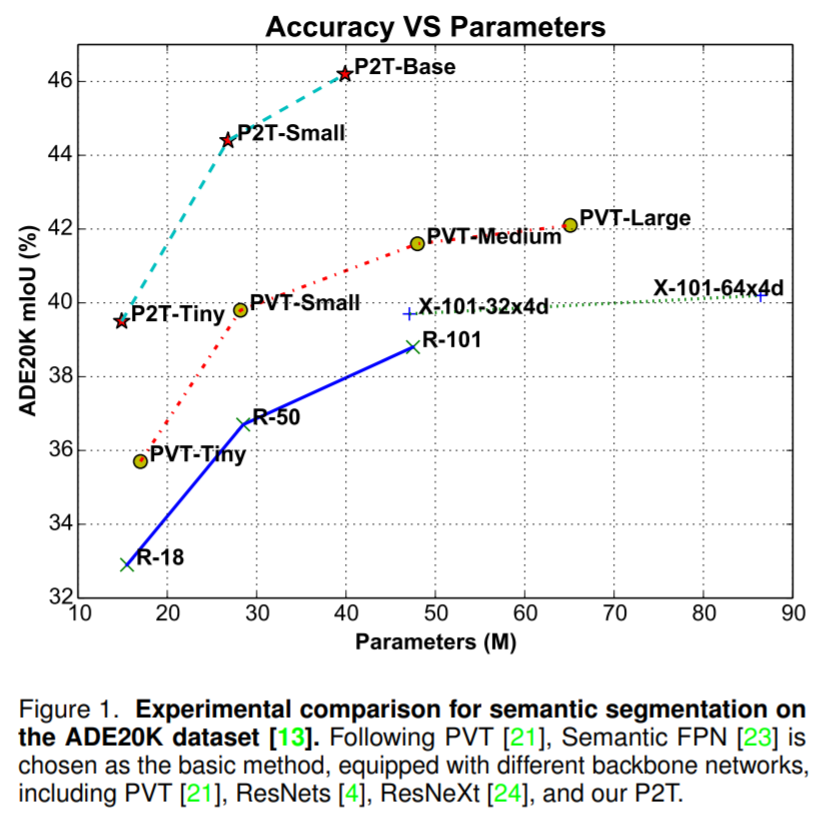

为了证明P2T的有效性,本文还在语义分割、目标检测、实例分割、显著性物体检测等多个任务与多种方法进行对比,结果显示P2T在多种下游任务上都展现了其显著的卓越性。

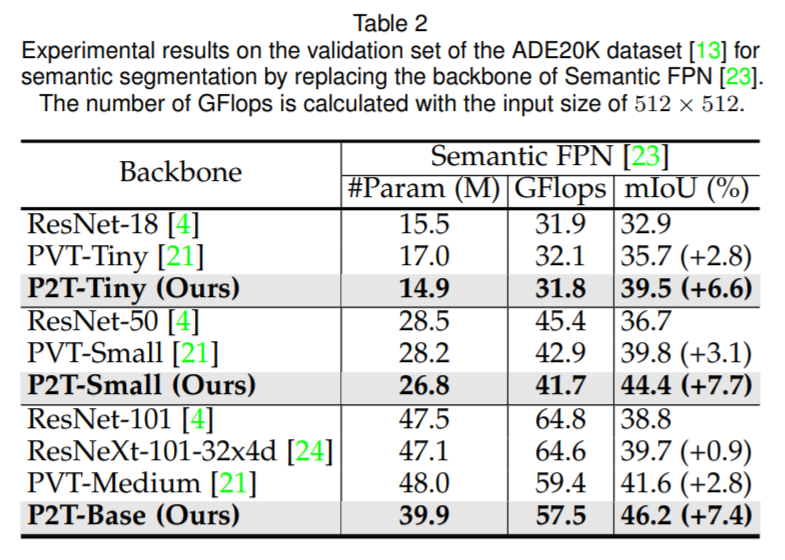

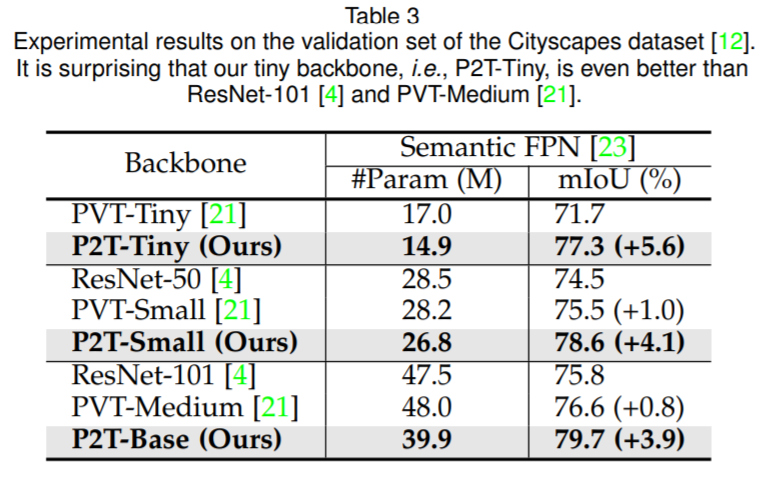

语义分割

在ADE20K validation set上的对比结果

在Cityscapes validation set上的对比结果

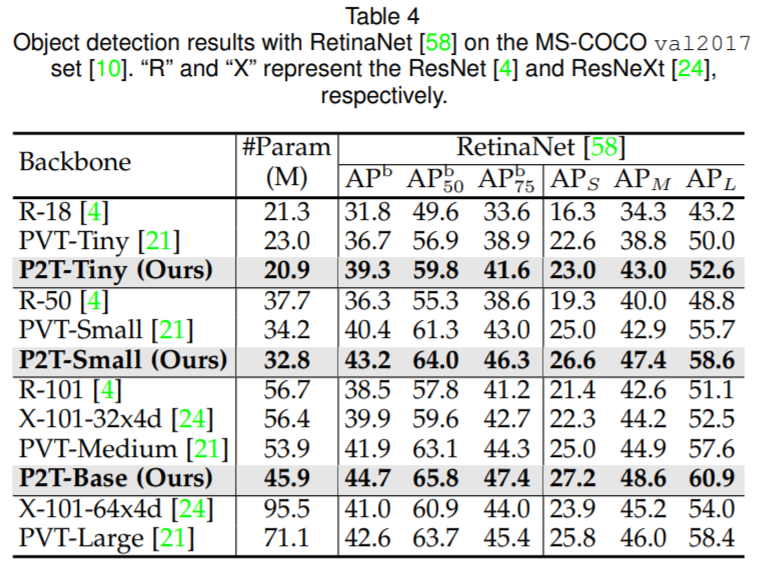

目标检测

在COCO val2017上的对比结果

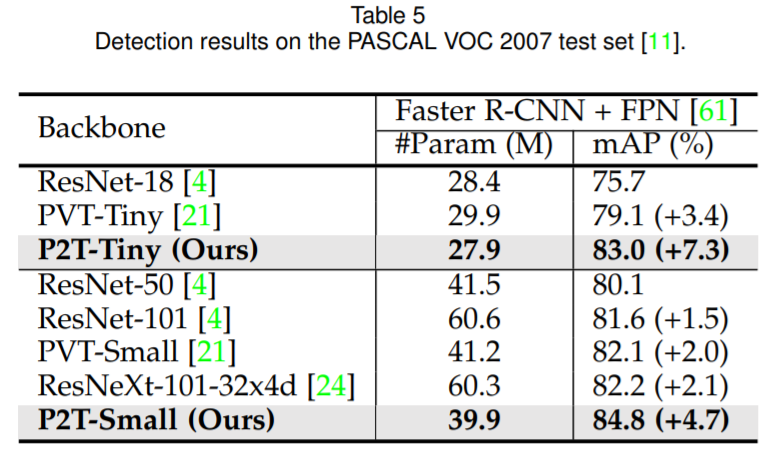

PASCAL VOC 2007上的对比结果

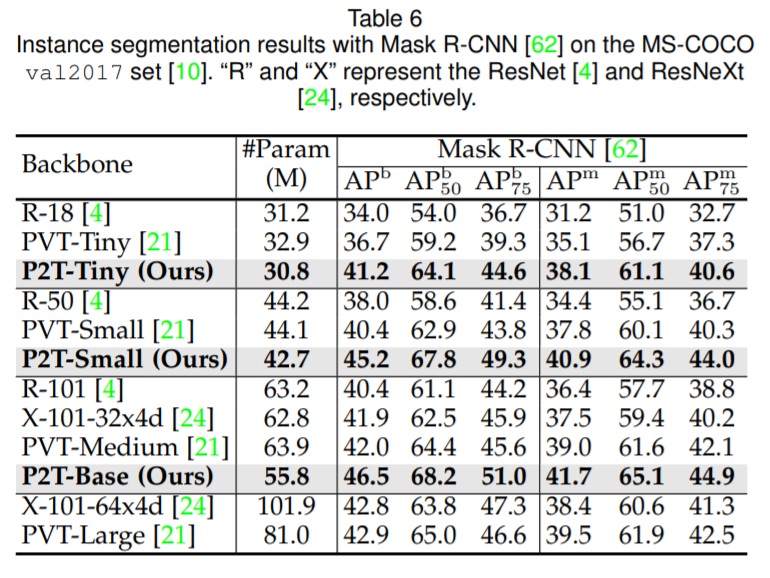

实例分割

在COCO val2017上的对比结果

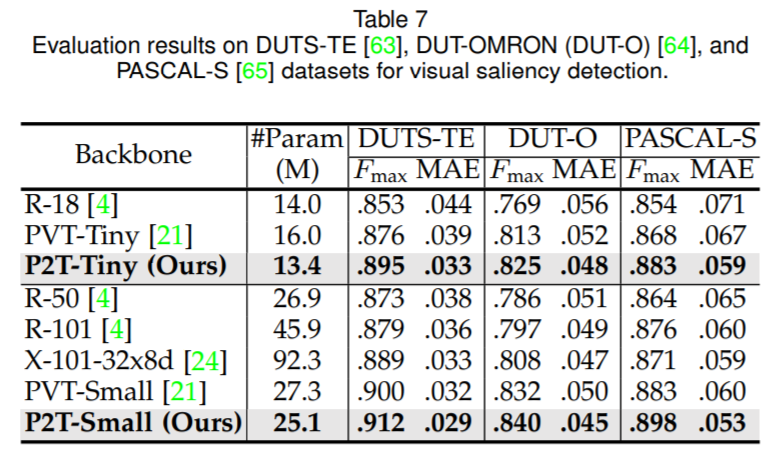

显著性物体检测

在DUTS-TE、DUT-OMORN、PASCAL-S数据集上的对比结果

图像分类

虽然本文设计的P2T并未针对图像分类进行设计,但仍然在ImageNet-1K取得了极强竞争力的结果。

---------♥---------

声明:本内容来源网络,版权属于原作者

图片来源网络,不代表本公众号立场。如有侵权,联系删除

AI博士私人微信,还有少量空位

点个在看支持一下吧