可视化是认知程序的最直观方式。

基本概念

TensorBoard是TensorFlow自带的一个强大的可视化工具,也是一个web应用程序套件。TensorBoard目前只支持7种可视化,即SCALARS、 IMAGES、AUDIO、GRAPHS、DISTRIBUTIONS、HISTOGRAMS和EMBEDDINGS。

- SCALARS:展示训练过程中的准确率、损失值、权重/偏置的变化情况

- IMAGES:展示训练过程中记录的图像

- AUDIO:展示训练过程中记录的音频

- GRAPHS:展示模型的数据流图,以及训练在各个设备上消耗的内存和时间

- DISTRIBUTIONS:展示训练过程中记录的数据的分布图

- HISTOGRAMS:展示训练过程中记录的数据的柱状图

- EMBEDDINGS:展示词向量(如Word2vec)后的投影分布

TensorBoard通过运行一个本地服务器,来监听6006端口。但是如何写可视化的程序呢?可视化时,需要在程序中给必要的节点添加摘要(summary),摘要会收集该节点的数据,并标记上第几步、时间戳等标识,写入事件文件(event file)中。tf.summary.FileWriter类用于在目录中创建事件文件,并且向文件中添加摘要和事件,用来在TensorBoard中展示。比如下面代码创建FIleWirter和事件文件,会在当前目录创建一个叫log的文件夹,并把事件文件写在该目录里。

writer = tf.summary.FileWriter("./log", tf.get_default_graph())

示例演示

我们在程序中添加summary,并一步步展示如何利用Anaconda和TensorBoard实现可视化。

import tensorflow as tf

from numpy.random import RandomState

#定义训练数据batch的大小

batch_size = 8

#定义神经网络的参数,随机初始化

w1 = tf.Variable(tf.random_normal([2, 3], stddev=1, seed=1))

w2 = tf.Variable(tf.random_normal([3, 1], stddev=1, seed=1))

#在shape上的一个维度上使用None可以方便使用不同的batch大小

x = tf.placeholder(tf.float32, shape=(None, 2), name='x-input')

y_ = tf.placeholder(tf.float32, shape=(None, 1), name='y-input')

#定义神经网络前向传播的过程

a = tf.matmul(x, w1)

y = tf.matmul(a, w2)

y = tf.sigmoid(y)

#定义损失函数:交叉熵

cross_entropy = -tf.reduce_mean(y_ * tf.log(tf.clip_by_value(y, 1e-10, 1.0))

+(1-y_) * tf.log(tf.clip_by_value(1 - y, 1e-10, 1.0)))

#反向传播算法应用

train_step = tf.train.AdamOptimizer(0.001).minimize(cross_entropy)

#通过随机数生成一个数据集

rdm = RandomState(1)

dataset_size = 128

X = rdm.rand(dataset_size, 2)

#认为x1+x2<1的样本都认为是正样本,用0表示负样本,1来表示正样本

Y = [[int(x1+x2 < 1)] for (x1, x2) in X]

loss = tf.placeholder(tf.float32, shape=(1))

loss_summary = tf.summary.scalar("loss", tf.squeeze(loss))

with tf.Session() as sess:

#初始化变量

init = tf.global_variables_initializer()

sess.run(init)

print("Before training:")

print(sess.run(w1))

print(sess.run(w2))

writer = tf.summary.FileWriter("./log", tf.get_default_graph())

#设定训练的次数

STEPS = 5000

for i in range(STEPS):

#每次选取batch_size个样本进行训练

start = (i * batch_size) % dataset_size

end = min(start + batch_size, dataset_size)

#通过选取的样本训练神经网络并更新参数

_, cur_loss = sess.run([train_step, cross_entropy], feed_dict={

x: X[start:end], y_: Y[start:end]})

summary = sess.run(loss_summary, feed_dict={

loss: [cur_loss]})

writer.add_summary(summary, i)

print("After training:")

print(sess.run(w1))

print(sess.run(w2))

result = sess.run(y, feed_dict={

x: [[0.5, 0.3]]})

print(result)

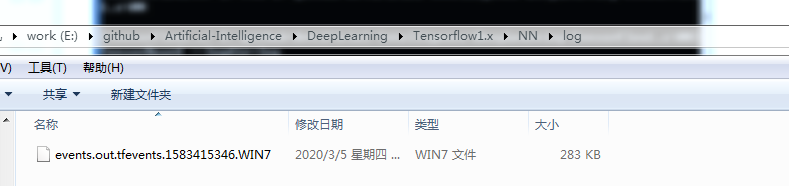

程序运行成功后,会在log目录下写入一个新的事件文件。

下面说明如何可视化。打开Anaconda Prompt,激活你用的环境。然后进入事件文件所在的磁盘,并进入事件文件所在目录的上一级目录。最后输入

TensorBoard --logdir=log

完整过程如下图

我们在浏览器里输入 http://localhost:6006,就可以看见我们想看的Tensorboard 可视化页面

参考资料

- TensorFlow技术解析与实践[M]