EM

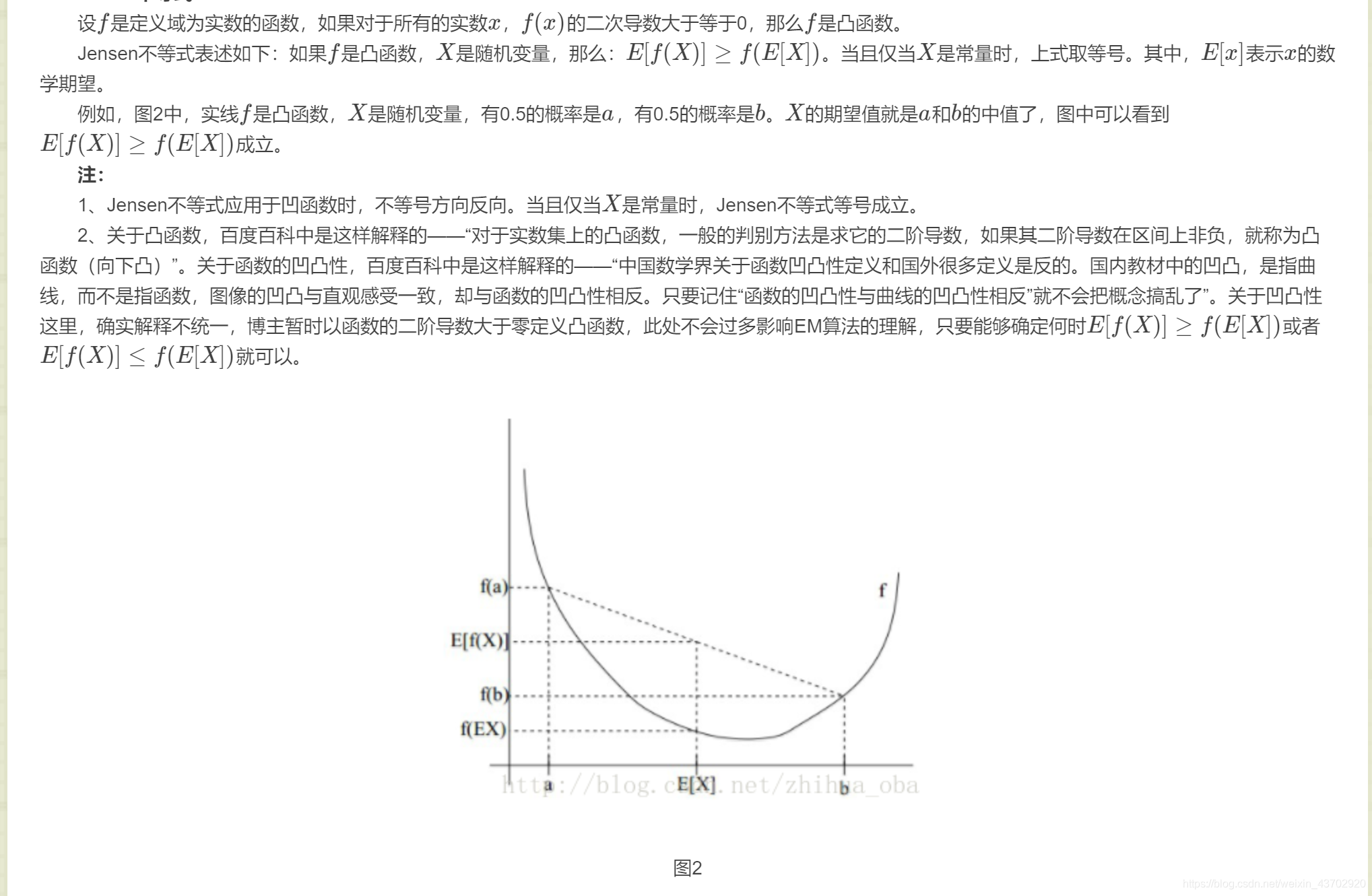

琴生不等式Jensen Inequality

参考下图黑洞传送门

MLE最大似然估计

- 一个数据集出现了,我们就最大化这个数据集的似然概率。

- 数据集中每个点都是独立出现的,因此可以概率连乘。

- 求得使得似然概率最大(当前数据集出现的估计概率)的参数。

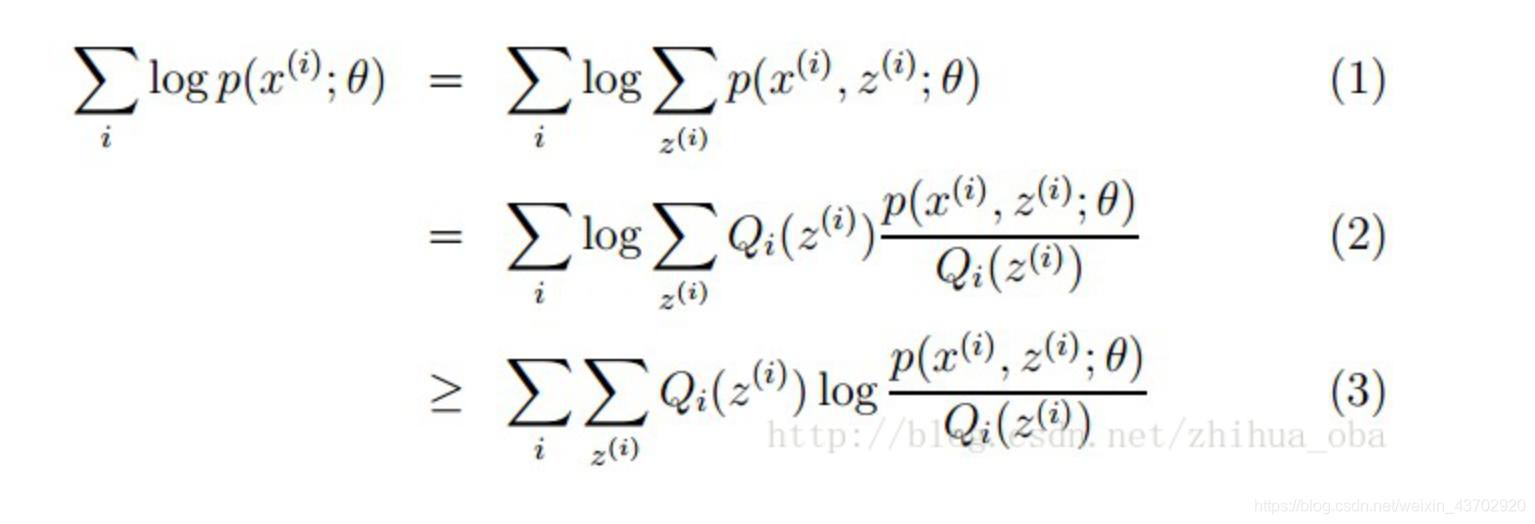

MLE的对数累加形式

- log是凹函数,因此

- 简便记忆法,

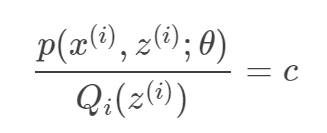

log(累加)>=累加log - 等号成立: 随机变量是常数

- 简便记忆法,

-

最大化下界 -

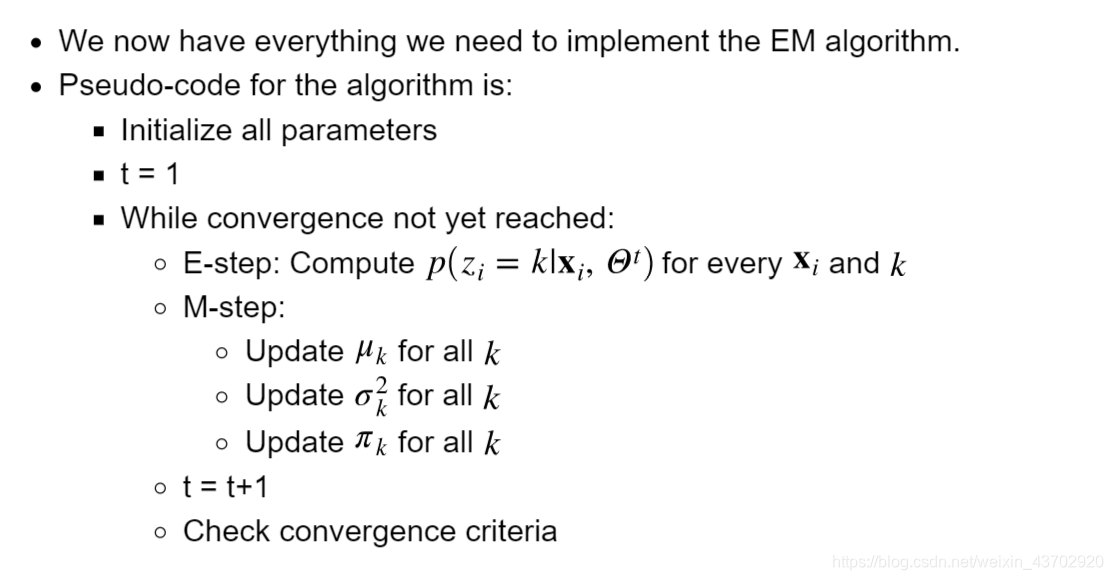

EM 步骤

无监督的降维:PCA

数据矩阵中心化投影到例如某几个轴上,

- 如何投影?

- 使得

方差最大化: 一般信息方差大于噪声!

假设 ,其中 是 维数据向量

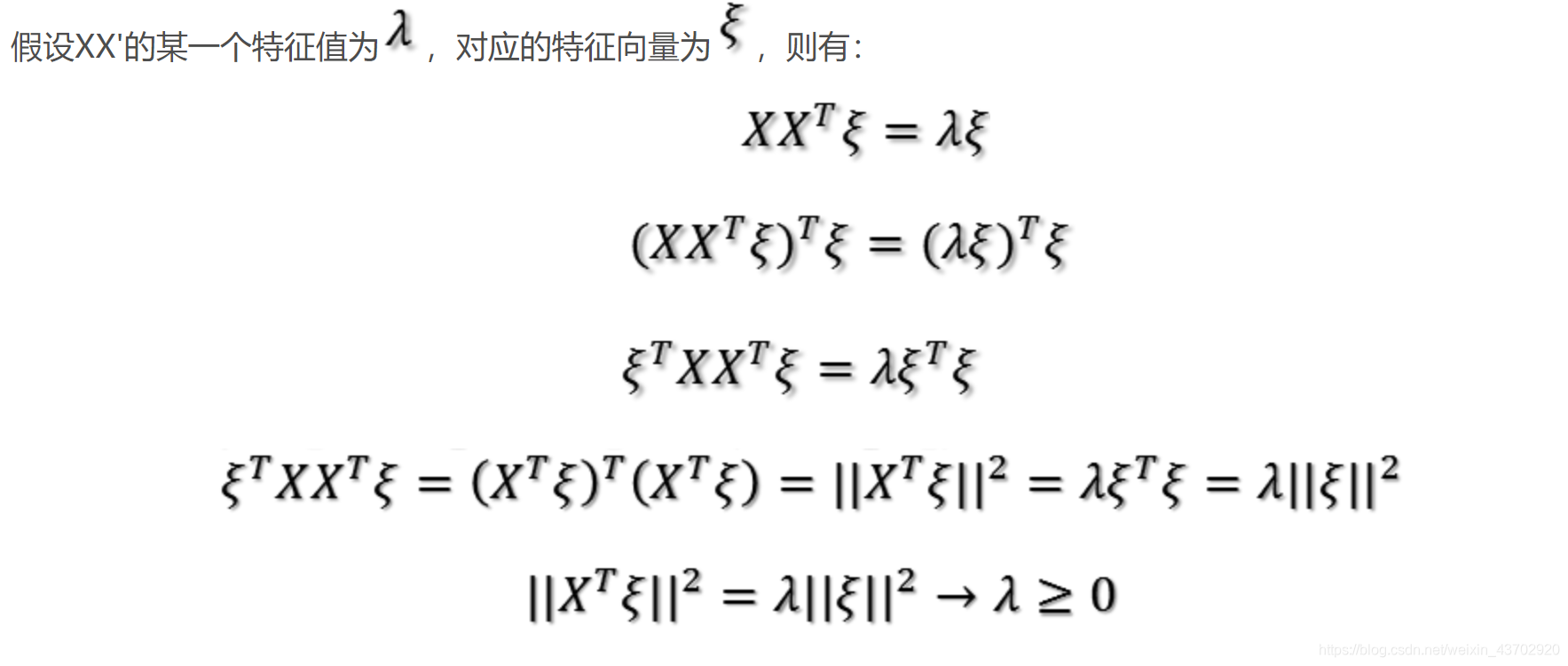

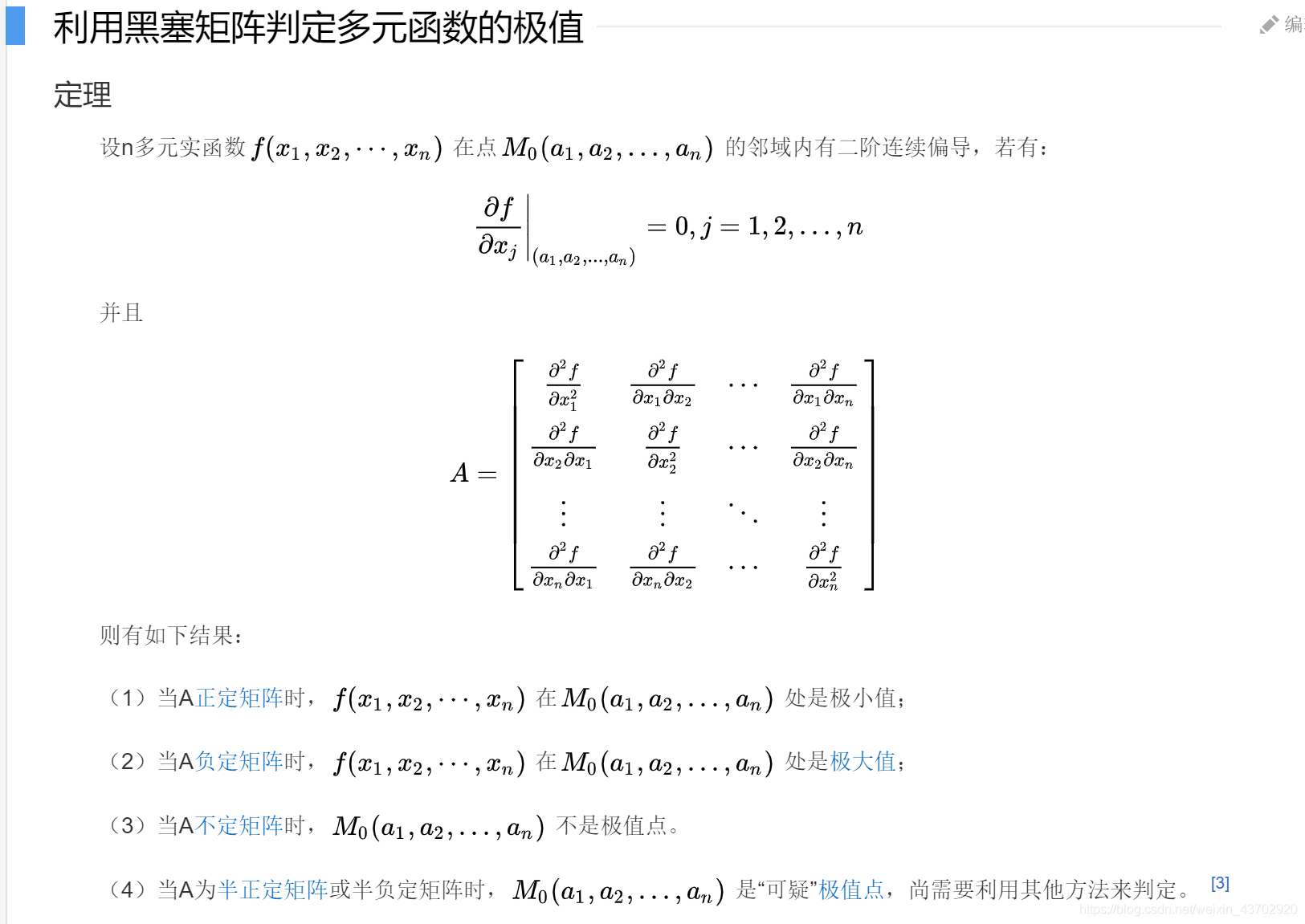

对称矩阵,必定半正定,上式存在最大值

reference

拉格朗日来了:

==>

求导=0

发现:

结论:

往特征值最大的轴上投影最佳

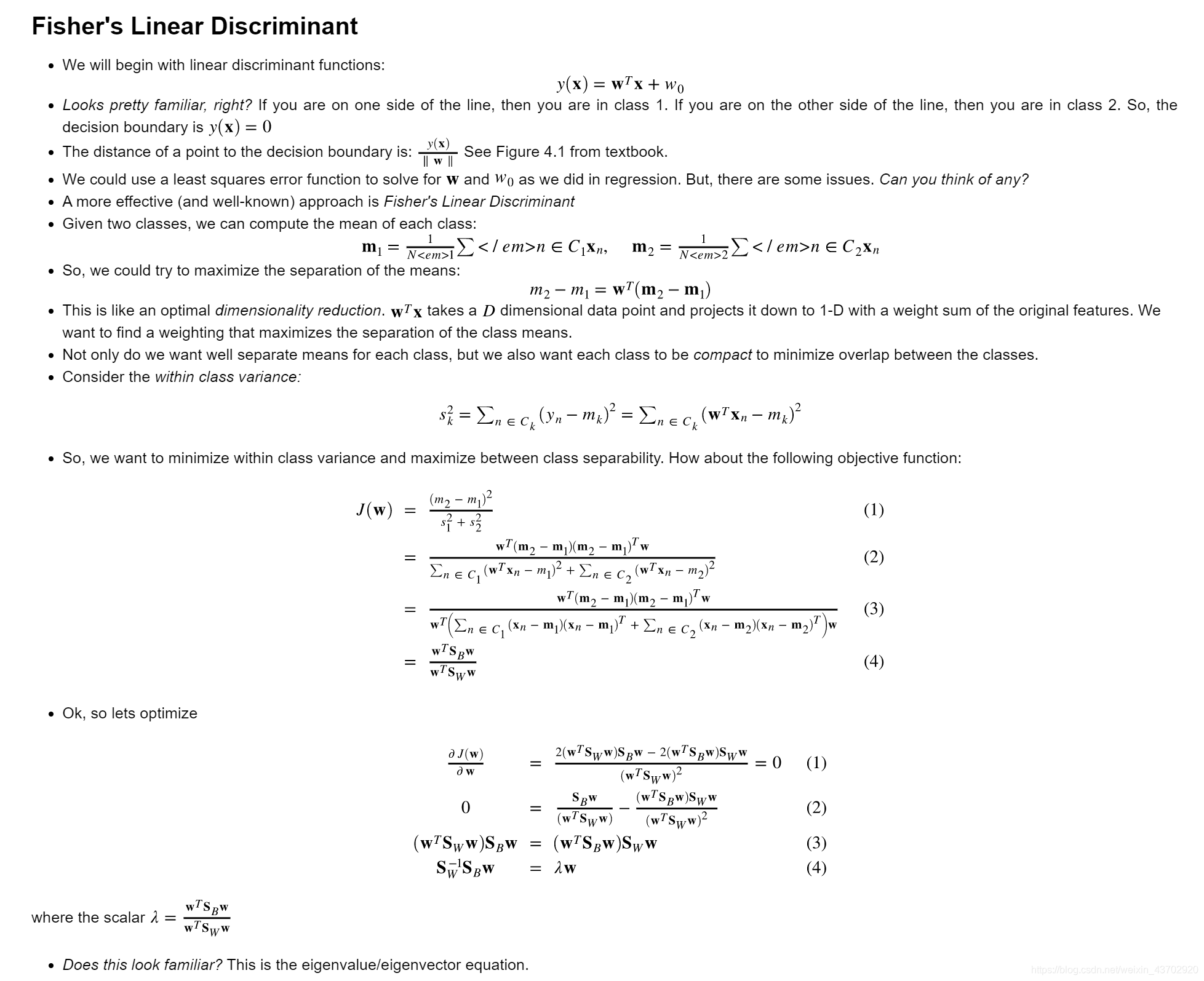

有监督的降维:LDA

投影后,不同类之间,类中心相互离得越远越好。Between Class Seaparability投影后,类内方差越小越好,所有的方差之和越小越好. Within Variance- 两类的LDA:

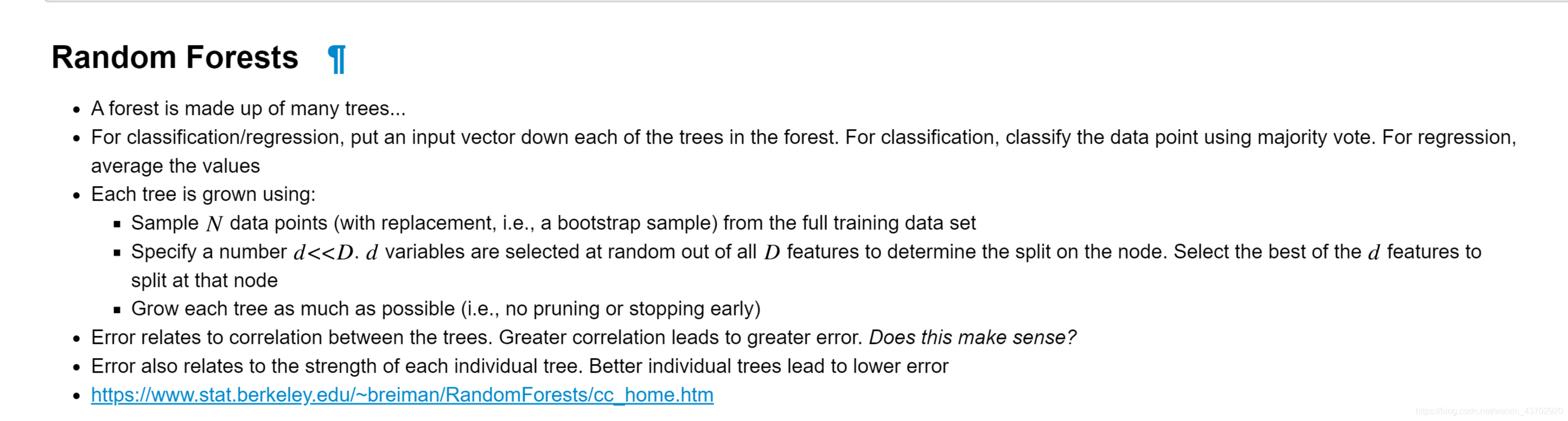

Ensemble Learning

- RF随机森林:Boostrapping自助法/bagging

- 分类:投票 / 回归:平均

- 有放回地抽样样本,当做森林里某颗树的数据集

- 对这颗树,每次随机抽取d个特征作为特征集合,按照决策树增益标准分支。

- 自由生长,不要停止或者限制

- 随机森林创造者本人的主页

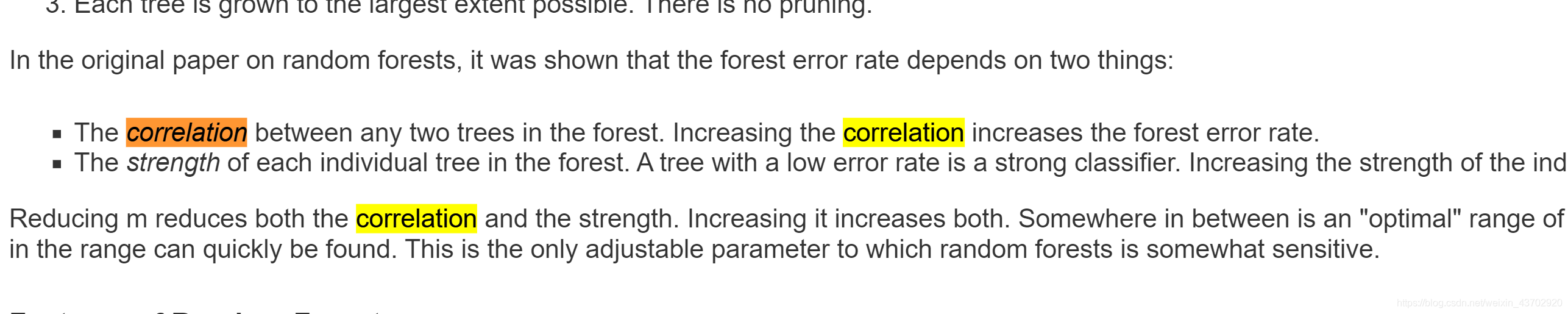

- 误差与树之间的correlation有关,大的correlation导致大的误差

- 个体树效果越好的话,整体误差会低,整体strength大

- 并行

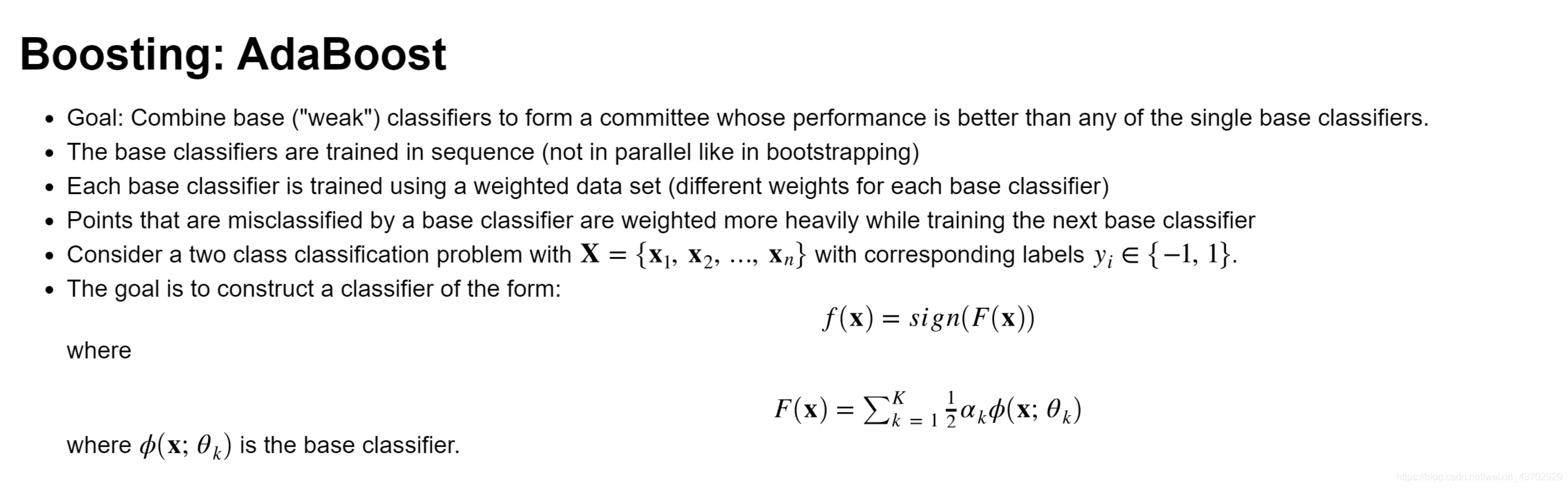

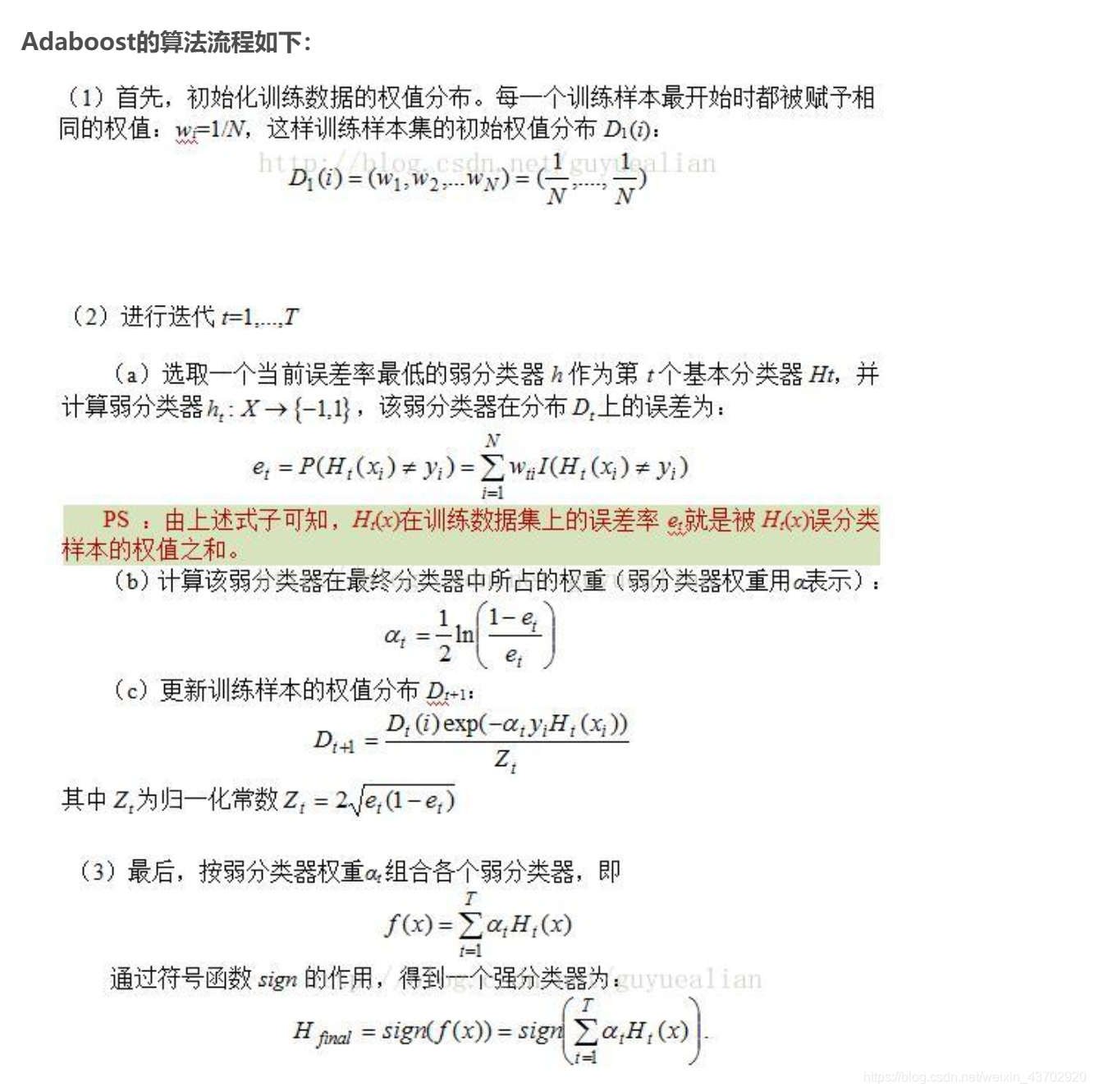

- AdaBoost

- 串行 boosting

- 代价函数是指数函数.

- 子分类器的权重由错误率得出

- 加大错误分类的权重,减小分对的样本权重

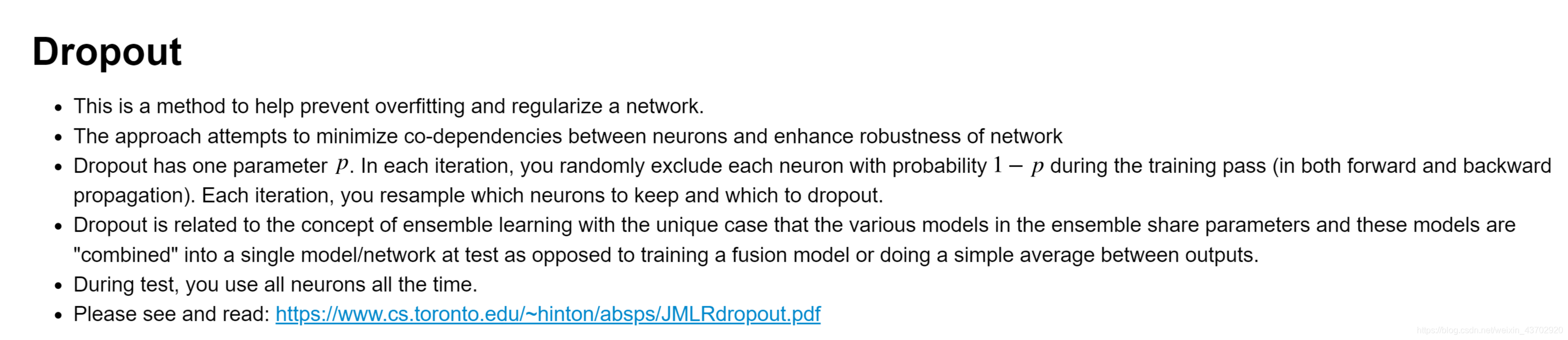

- Dropout

- 一般见于神经网络,防止过拟合

- 机制只工作在训练中,前向传播和后向传播中, p表示正常运作的概率,通过多重伯努利分布选择。

- “集成”学习

- Dropout论文