前言

上一节用try except框架爬取亚马逊的信息,这一节用爬虫爬取网页图片

完整代码

import requests as req

import os

path = "D:/" # 保存路径

url = "http://bbs.jooyoo.net/attachment/Mon_0905/24_65548_04f46bb3e74aa77.jpg" # 爬取路径

name = url.split("/")[-1] # 获取图片再url中的名字

try:

if not os.path.exists(path): # 判断路径是否存在

os.mkdir(path) # 不存在就创建

if not os.path.exists(path + name): # 判断文件是否已经存在

r = req.get(url) # 不存在就获取网页响应

r.raise_for_status() # 抛出异常

with open(path + name,'wb') as f: # 打开文件

f.write(r.content) # 写入文件

print("文件保存成功")

else:

print("图片已存在")

except:

print("爬取失败")

解读with open(path + name,‘wb’) as f

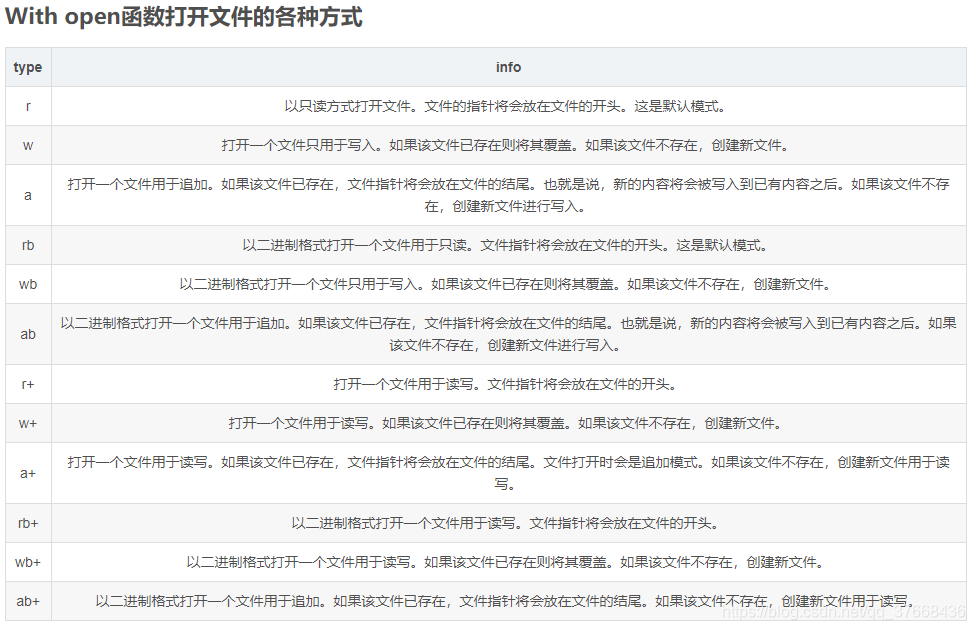

python中文件的读写主要用的函数是open,open的第一个参数是文件路径,第二个是读取的方式,几种读取方式见下图:

那么如果你只用open的话,如果这个路径不存在是会报异常的,同时你还需要自己调用close函数来关闭这个文件,这样写属实麻烦,所以python提供了用with open的方法打开自动帮你调用close函数。

f.write(r.content) # 写入文件r.content就是文件的二进制格式