1、Batch Normalization:

a、可以简单理解为归一化,将值压缩到0-1之间,并且求和的值为1

b、当一批数据(batch)到达时(不一串行,一个一个,而是并行,所有数据全部计算完错误率后统一更新参数),进行一个normalization的操作。

c、逐层尺度归一(零均值方差归一,scale和shift)

d、Normali避免了梯度消失和梯度溢出。

e、BN可以加速收敛5倍~20倍, 作为一种正则化技术也提高了泛化能力。

2、反向传播训练:

a、卷积+池化 = 特征提取器

b、全连接层 = 分类器

c、过程:

①、随机初始化,用随机数初始化所有的滤波器和参数/权重

②、网络将训练图片作为输入,执行前向步骤(卷积,ReLU,池化以及全连接层的前向传播)并计算每个类别的对应输出概率。

③、计算输出层的总误差,总误差=1/2 ∑ (目标概率−输出概率)^2

④、反向传播算法计算误差相对于所有权重的梯度,并用梯度下降法更新所有的滤波器/权重和参数的值,以使输出误差最小化。学习的方式是调整权重/滤波器以降低输出误差。滤波器个数、滤波器尺寸、网络架构这些参数,是在Step 1之前就已经固定的,且不会在训练过程中改变——只有滤波矩阵和神经元权重会更新

3、优化:

a、局部最小值:长期以来,人们普遍认为,神经网络很难优化是因为较大的神经网络中包含很多局部极小值,使得算法容易陷入到其中某些点。这种看法持续二三十年,至少数万篇论文中持有这种说法。

b、鞍点:

直到2014年,Hinton组提出高维优化问题中根本没有那么多局部极值。高维非凸优化问题之所以困难,是因为存在大量的鞍点(梯度为零并且Hessian矩阵特征值有正有负)而不是局部极值。

和局部极小值相同的是,在该点处的梯度都等于零,不同在于在鞍点附近Hessian矩阵有正的和负的特征值,即是不定的,而在局部极值附近的Hessian矩阵是正定的。

在鞍点附近,基于梯度的优化算法(几乎目前所有的实际使用的优化算法都是基于梯度的)会遇到较为严重的问题,鞍点附近梯度很小,可能会长时间卡在该点附近。在鞍点数目极大的时候,这个问题会变得非常严重。

c、Gradient Descent(梯度最优):

①、Gradient Descent的局限:

学习率很难选。若过小,收敛速度很慢。若过大,那么会阻碍收敛,即在极值点附近振荡

每次更新都是使用相同的学习速率。

鞍点经常被一个相等误差的平原包围,导致SGD很难摆脱,因为梯度在所有方向都近似于0。

②、BGD梯度下降算法:在更新每一参数时使用所有的样本,当样本量很大时,训练过程会很慢

③、SGD梯度下降算法:通过每个样本来更新一次,噪音较BGD要多,使得SGD并不是每次迭代都向着整体最优化方向

④、MBGD梯度下降算法:Mini-batch Gradient Descent,两种方法的折中

4、防止过拟合:

a、Data Augmentation数据增强:

这是解决过拟合最有效的方法,只要给足够多的数据,让模型「看见」尽可能多的「例外情况」,它就会不断修正自己,从而得到更好的结果。

通过一定规则扩充数据,对数据进行预处理,将一张图片变为多张图片。

Color Jittering:对颜色的数据增强:图像亮度、饱和度、对比度变化;

Random Scale:尺度变换;

Random Crop:采用随机图像差值方式,对图像进行裁剪、缩放;包括Scale Jittering方法(VGG及ResNet模型使用)或者尺度和长宽比增强变换;

Horizontal/Vertical Flip:水平/垂直翻转;Shift:平移变换;Rotation/Reflection:旋转/仿射变换;

Noise:高斯噪声、模糊处理;

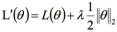

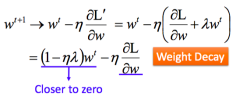

b、L1/L2正则

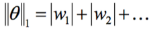

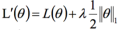

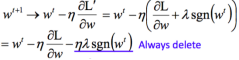

L1 regularization

,w称为正则项,使得训练出来的函数尽可能简单,从而避免过拟合。

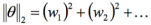

,w称为正则项,使得训练出来的函数尽可能简单,从而避免过拟合。

L2 regularization

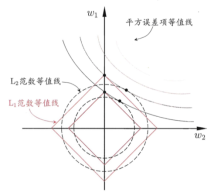

c、Early Stopping提前终止:

每一个epoch结束时(一个epoch即对所有训练数据的一轮遍历)计算 validation data的total loss,当loss不再降低时,就停止训练,这样可以防止overfitting。

d、Dropout丢弃率:

以概率p舍弃部分神经元,其它神经元以概率q=1-p被保留,舍去的神经元的输出都被设置为零。

Dropout在实践中能很好工作是因为其在训练阶段阻止神经元的共适应。

可以简化神经网络的结构和参数数量,增加收敛速度。

机器智能-高频问题:卷积神经网络优化

猜你喜欢

转载自blog.csdn.net/qq_40851744/article/details/106604899

今日推荐

周排行