RNN结构

上图为Tx=Ty,T为序列长度,表示输入x的第t个时间步,

Tx=Ty的体系结构可以是提取句子中人名,例如句子“小明去学校”,句子中每个词先调整为one-hot编码,然后为标签,0代表不是人名,1代表是。或者通过已有一堆英文人名,构建字符级语言模型来生成新的名称。

前向传播

上图为计算公式,其中代表权重,前面a代表计算的是激活值

,x代表权重后面跟的是

首先先通过RNN的前向传播,如果输入的数据序列经过10个时间步,那么将复制RNN单元10次,每个单元将前一个单元中的隐藏状态和当前时间步的输入数据

作为输入。 它为此时间步输出隐藏状态

和预测

。

RNN反向传播

循环神经网络可以看作是单元的重复,首先要实现单个时间步的计算

就像在完全连接的神经网络中一样,成本函数J的导数通过链式法则计算,通过RNN向后传播。

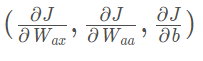

链式法则通过计算 来更新Wax,Waa,ba

来更新Wax,Waa,ba

更新参数

更新Wax、Waa、Wya、ba、by

模型结构总结

模型的结构如下:

-

初始化参数

-

循环:

-

前向传播计算损失

-

反向传播计算关于损失的梯度

-

修剪梯度以免梯度爆炸

-

用梯度下降更新规则更新参数。

-

-

返回学习后了的参数