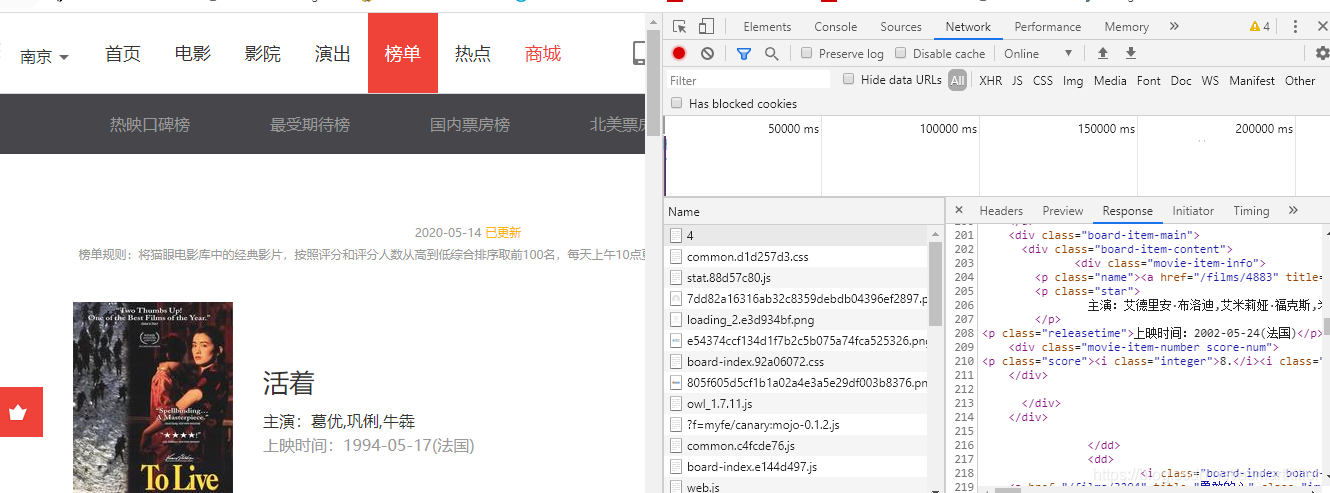

如上图就是猫眼电影排行的网页,网址如下所示:

https://maoyan.com/board/4。我们要利用requests库来抓取该网页中电影的结构化数据。将网页滚动最下方,可以发现有分页的列表。直接点击第2页,观察页面的URL和内容发生了怎样的变化。可以发现页面的URL变成了https://maoyan.com/board/4?offset=20,参数offset变成了20,而显示的结构是排行21-30的电影。offset代表偏移量为n,则显示的电影序号就是n+1到n+10,每页显示10个。所以,如果想获取TOP100电影,只需要分开请求10次,而10次的offset参数分别设置为0、10、20…90即可,这样获取不同的页面之后,再用正则表达式提取出相关信息,就可以得到TOP100的所有电影信息了。

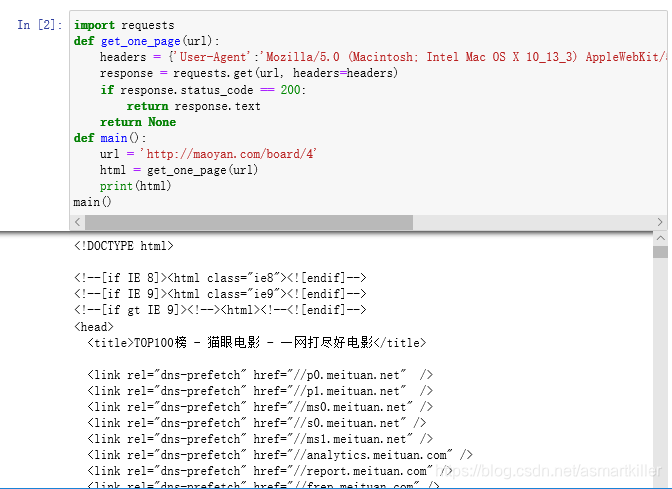

抓取首页

使用get_one_page方法抓取第一页的内容,并给它传入url参数。然后将抓取的页面结果返回,再通过main方法调用。

import requests

def get_one_page(url):

headers = {'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.162 Safari/537 . 36'}

response = requests.get(url, headers=headers)

if response.status_code == 200:

return response.text

return None

def main():

url = 'http://maoyan.com/board/4'

html = get_one_page(url)

print(html)

main()

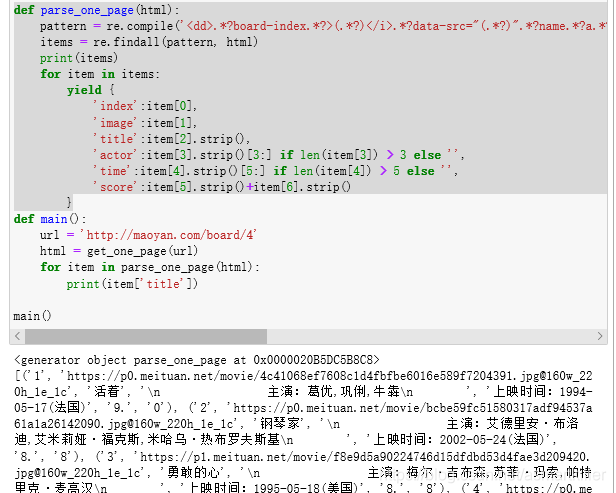

正则提取

一部电影信息对应的源代码是一个dd节点,我们用正则表达式来提取这里面的一些电影信息。首先,需要提取它的排名信息。而它的排名信息是在class 为board-index的i节点内,这里利用非贪婪匹配来提取i节点内的信息,正则表达式写为:<dd>.*?board-index.*?>(.*?)</i>

随后需要提取电影的图片。可以看到,后面有a 节点,其内部有两个img 节点。经过检查后发现,第二个i mg 节点的data-src 属性是图片的链接。这里提取第二个img 节点的data-src 属性,正则表达式可以改写如下:<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)" 再往后,需要提取电影的名称,它在后面的p 节点内, class 为name 。所以,可以用name 做一个

标志位,然后进一步提取到其内a 节点的正文内容,此时正则表达式改写如下:<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>再提取主演、发布时间、评分等内容时,都是同样的原理。最后,正则表达式写为:<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>.*?releasetime.*?>(.*?)</p>.*?integer.*?>(.*?)</i>.*?fraction.*?>(.*?)</i>.*?</dd> 这样一个正则表达式可以匹配一个电影的结果,里面匹配了7 个信息。接下来,通过调用findall()方法提取出所有的内容。

def parse_one_page(html):

pattern = re.compile('<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>.*?releasetime.*?>(.*?)</p>.*?integer.*?>(.*?)</i>.*?fraction.*?>(.*?)</i>.*?</dd>',re.S)

items = re.findall(pattern, html)

print(items)

for item in items:

yield {

'index':item[0],

'image':item[1],

'title':item[2].strip(),

'actor':item[3].strip()[3:] if len(item[3]) > 3 else '',

'time':item[4].strip()[5:] if len(item[4]) > 5 else '',

'score':item[5].strip()+item[6].strip()

}

import requests

import re

def get_one_page(url):

headers = {'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.162 Safari/537 . 36'}

response = requests.get(url, headers=headers)

if response.status_code == 200:

return response.text

return None

def parse_one_page(html):

pattern = re.compile('<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>.*?releasetime.*?>(.*?)</p>.*?integer.*?>(.*?)</i>.*?fraction.*?>(.*?)</i>.*?</dd>',re.S)

items = re.findall(pattern, html)

for item in items:

yield {

'index':item[0],

'image':item[1],

'title':item[2].strip(),

'actor':item[3].strip()[3:] if len(item[3]) > 3 else '',

'time':item[4].strip()[5:] if len(item[4]) > 5 else '',

'score':item[5].strip()+item[6].strip()

}

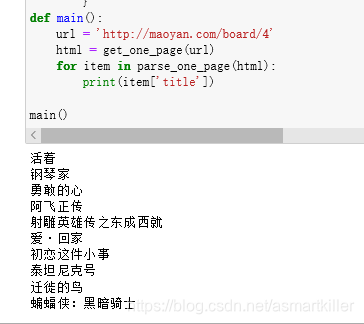

def main():

url = 'http://maoyan.com/board/4'

html = get_one_page(url)

for item in parse_one_page(html):

print(item['title'])

main()

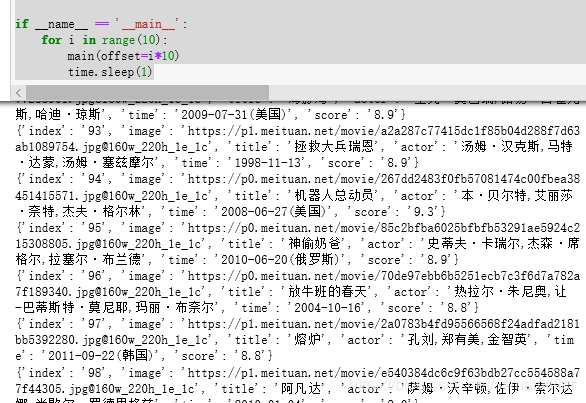

分页爬取

们需要抓取的是TOPIOO 的电影,所以还需要遍历一下,给这个链接传入offset 参数, 实现其他90 部电影的爬取, 此时添加如下调用即可:

import requests

from requests.exceptions import RequestException

import re

import json

import time

def get_one_page(url):

try:

headers = {'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.162 Safari/537 . 36'}

response = requests.get(url, headers=headers)

if response.status_code == 200:

return response.text

return None

except RequestException:

return None

def parse_one_page(html):

pattern = re.compile('<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>.*?releasetime.*?>(.*?)</p>.*?integer.*?>(.*?)</i>.*?fraction.*?>(.*?)</i>.*?</dd>',re.S)

items = re.findall(pattern, html)

for item in items:

yield {

'index':item[0],

'image':item[1],

'title':item[2].strip(),

'actor':item[3].strip()[3:] if len(item[3]) > 3 else '',

'time':item[4].strip()[5:] if len(item[4]) > 5 else '',

'score':item[5].strip()+item[6].strip()

}

def write_to_file(context):

with open('result.txt','a',encoding='utf-8') as f:

f.write(json.dumps(context,ensure_ascii=False)+'\n')

def main(offset):

url = 'http://maoyan.com/board/4?offset='+str(offset)

html = get_one_page(url)

for item in parse_one_page(html):

print(item)

write_to_file(item)

if __name__ == '__main__':

for i in range(10):

main(offset=i*10)

time.sleep(1)