第四章

N-gram模型:用前面的N-1个词去预测第N个词的概率的模型。并且这种预测第N个词的模型。N指的是句子中的连续N个词。最终显示他与预测一系列词出现的概率相似。

4.2 simple(unsmoothed)N-grams

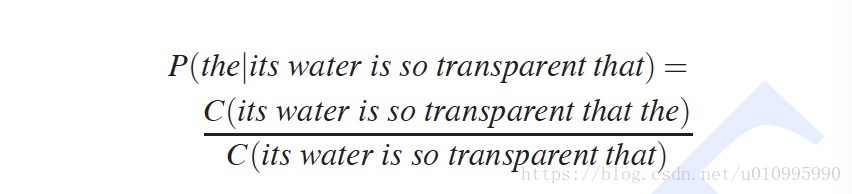

我们的目标是计算在给定一些内容h,来计算词w出现的概率,即P(w | h).比如计算P(the | its water is so transparent that),

方法一:统计词典中所有句子,计算出ite … that句子后面跟的是the的数目,然后除以总数。

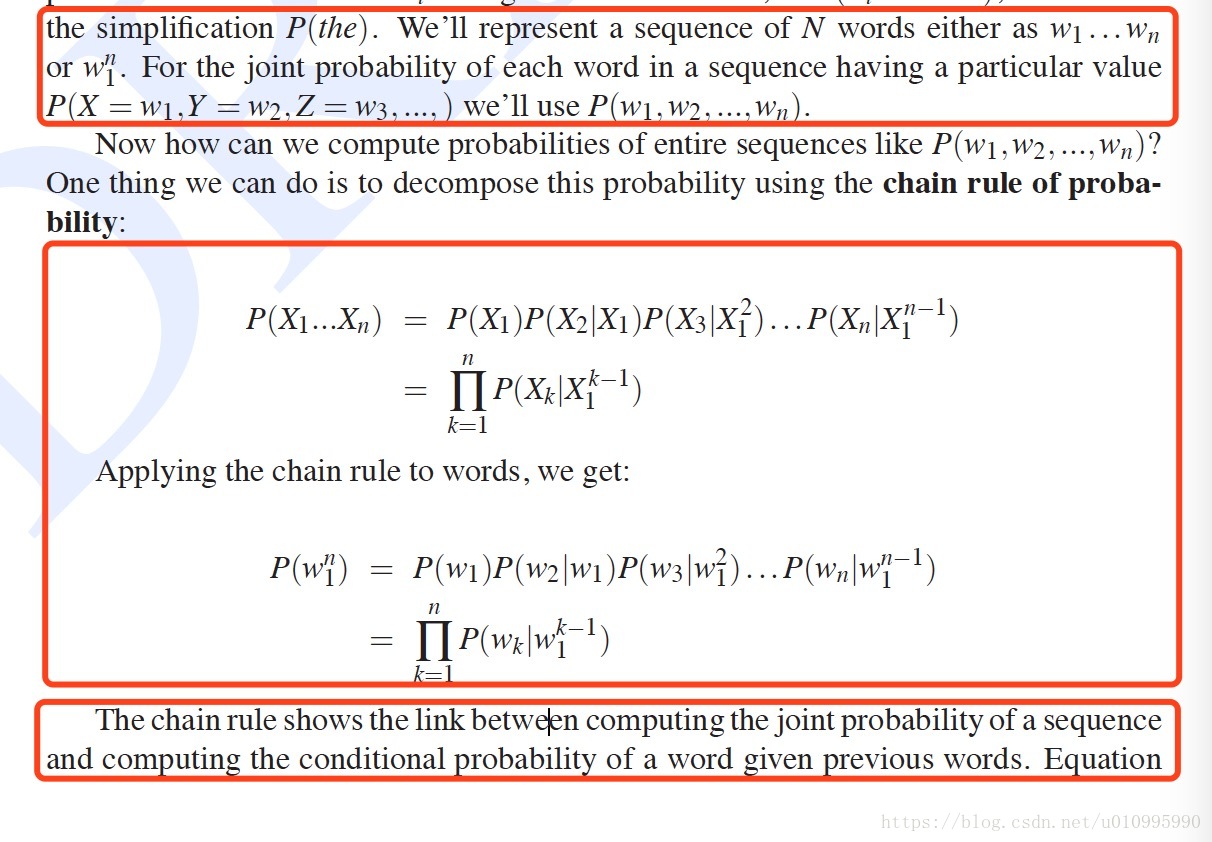

方法二:如下,在h条件的w出现的概率,可以理解为h+w一起出现的概率,然后运用概率论的链式法则,推理如下:

链式法则实现了一个句子的联合概率分布和条件概率分布之间的链接。上式表明了我们可以用一系列的条件概率分布来等价的估计出联合概率分布。颗粒理解为对于单词W,我们并不是一下全部给他所有的h知识,而是一步一步的只给他前一个词。

这里说markov assumption(马尔科夫假设)是一个词出现的概率只依赖与他前面的那个词

方法三:所以这里引出了第三个模型bigram model,只用前一个单词来预测(也就是N-gram里面的N等于2)。具体公式如下:

**方法四:**trigram 指的是N等于3,用前面的两个词来进行预测。

N-gram model,N=1,为unigram model;N=2为bigram model;N=3为trigram model.