jdk1.8中的HashMap底层原理是在jdk1.7的基础上改进的,所以,建议先了解jdk1.7的底层原理,先熟悉jdk1.7 的源码

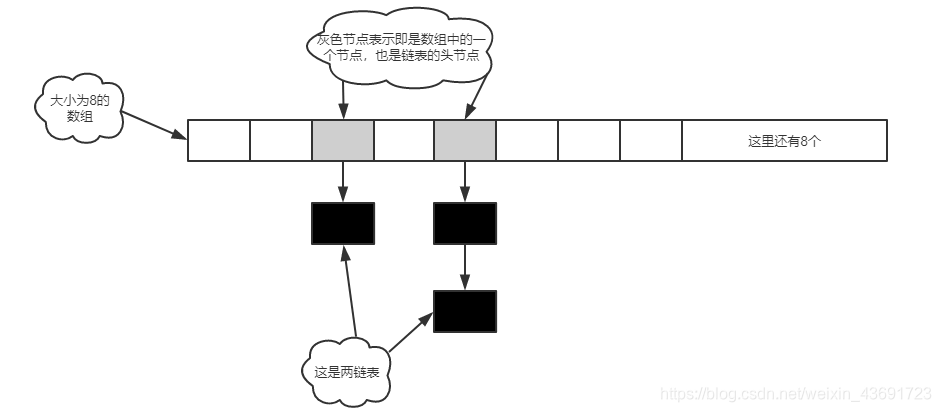

首先大致了解一下HashMap的实现原理,1.7中HashMap是采用数组加链表的方式实现的,因为HashMap存储元素是按key和value 的形式存储,HashMap中就定义了一个Entry类来封装元素的key和value,并且实现链表,定义一个Entry类型的数组,向HashMap中put元素时,首先算出key的哈希值hashCode,然后根据hashCode,再用一个算法(下面会讲),将hashCode 与数组的索引对应,不同的元素可能算出的是同一个索引,就将相同索引的元素以链表的形式存储,1.7中采用插入头结点的方式,也就是说,当一个元素插入对应的数组下的链表时,将这个雨伞变为头结点,arr[i] = entry。

jdk1.7源码

首先要理解这个Entry类,要不然会懵的。

static class Entry<K,V> implements Map.Entry<K,V> {

final K key;

V value;

Entry<K,V> next;

int hash;

Entry(int h, K k, V v, Entry<K,V> n) {

value = v;

next = n;

key = k;

hash = h;

}

HashMap中的属性:

//默认数组大小为16

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4; // aka 16

//加载因子,元素个数与数组长度的比值,默认为0.75,这个数如果过大,存的数越多,空间利用率较高,冲突的机会就会变大,这个值过小,冲突的机会小,空间浪费

static final float DEFAULT_LOAD_FACTOR = 0.75f;

//空的Entry数组,jdk1.7中,建了一个Entry类,来封装key和value

static final Entry<?,?>[] EMPTY_TABLE = {};

//数组

transient Entry<K,V>[] table = (Entry<K,V>[]) EMPTY_TABLE;

//元素个数

transient int size;

//阈值,元素的个数

int threshold;

//加载因子

final float loadFactor;

transient int modCount;

构造函数

public HashMap(int initialCapacity, float loadFactor) {

//如果初始值为0,就报异常

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal initial capacity: " +

initialCapacity);

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal load factor: " +

loadFactor);

this.loadFactor = loadFactor;

//阈值和设置的数组长度相同

threshold = initialCapacity;

//HashMap中,init()是空的,用不到

init();

}

还有其他的构造函数,基本上都是调用上面的构造函数俩完成的,在这里就不列举了。

接下来HashMap中的重点内容put()方法,面试中也会被经常问到

public V put(K key, V value) {

//判断数组是否为空,如果等于空,就初始化数组

if (table == EMPTY_TABLE) {

inflateTable(threshold);

}

//判断键值是否为空

if (key == null)

return putForNullKey(value);

//算出key对应的hashCode

int hash = hash(key);

//根据hashCode找到对应的索引

int i = indexFor(hash, table.length);

//相同的索引,进行覆盖

for (Entry<K,V> e = table[i]; e != null; e = e.next) {

Object k;

if (e.hash == hash && ((k = e.key) == key || key.equals(k))) {

V oldValue = e.value;

e.value = value;

e.recordAccess(this);

return oldValue;

}

}

//不同的话,就进行插入

modCount++;

addEntry(hash, key, value, i);

return null;

}

下面来分析put(K key, V value)方法,先判断数组是否为空,如果等于空,就调用 inflateTable(threshold)方法来初始化数组, inflateTable(threshold)方法中,利用roundUpToPowerOf2(toSize)方法计算出,大于threshold的2的次方,比如,threshold为10,则capacity为16,也就是数组的长度为16,这里你肯定会好奇为什么数组长度得是2的次方数,先留着这个问题,继续看

private void inflateTable(int toSize) {

int capacity = roundUpToPowerOf2(toSize);

//重新计算阈值

threshold = (int) Math.min(capacity * loadFactor, MAXIMUM_CAPACITY + 1);

table = new Entry[capacity];

initHashSeedAsNeeded(capacity);

}

然后判断key是否为空,1.7中,key可以为空,如果HashMap中含有key为空的元素就将,oldValue覆盖,返回oldValue,如果没有,就返回null

private V putForNullKey(V value) {

for (Entry<K,V> e = table[0]; e != null; e = e.next) {

if (e.key == null) {

V oldValue = e.value;

e.value = value;

e.recordAccess(this);

return oldValue;

}

}

modCount++;

addEntry(0, null, value, 0);

return null;

}

判断完之后,就计算key的哈希值,根据哈希值算出对应的数组索引,首先看索引的计算方法,hash值与数组长度减1的与运算,比如一个key的hashCode是20,计算索引时,20 & 15 , 一个int类型的数占4个字节,32位,也就是0000 0000 0000 0000 0000 0000 0001 0100 & 0000 0000 0000 0000 0000 0000 0000 1111 ,结果为 1111(前面的值省略),可以看出,hash值的二进制数的后四位是什么,得出的索引就是什么,只要数组长度为2的次方,算出的索引数肯定小于数组长度,这也是为什么,初始化数组长度为2的n次方,也就是说,索引的值至于后几位数有关,前面很多位都没有参与到计算中,这样的话,得到的索引相同的肯定很多,于是,HashMap中,就将hashCode就往左移,进行多次的异或运算,这样,算出的索引值,不仅仅只与后几位数字有关了。

计算hash值

final int hash(Object k) {

int h = hashSeed;

if (0 != h && k instanceof String) {

return sun.misc.Hashing.stringHash32((String) k);

}

h ^= k.hashCode();

// This function ensures that hashCodes that differ only by

// constant multiples at each bit position have a bounded

// number of collisions (approximately 8 at default load factor).

h ^= (h >>> 20) ^ (h >>> 12);

return h ^ (h >>> 7) ^ (h >>> 4);

}

//计算索引

static int indexFor(int h, int length) {

// assert Integer.bitCount(length) == 1 : "length must be a non-zero power of 2";

return h & (length-1);

}

索引算出以后,就遍历链表中的元素,判断两个对象的哈希值是否相同,注意,两个对象相等,哈希值一定相等,哈希值相等,对象不一定相等,先判断哈希值,再判断是否==,最后判断equals,也是可以提高效率的。最后addEntry,先判断实际元素的值是否大于阈值,如果大于并且,当前元素对应的数组位置不为空,就对数组进行扩容,变为原来的两倍,再根据hashCode重新与数组长度减1做与运算,算出索引,之后,算出要put的元素的索引,调用createEntry插入

`void addEntry(int hash, K key, V value, int bucketIndex) {

if ((size >= threshold) && (null != table[bucketIndex])) {

resize(2 * table.length);

hash = (null != key) ? hash(key) : 0;

bucketIndex = indexFor(hash, table.length);

}

createEntry(hash, key, value, bucketIndex);

}`

//对数组进行扩容

void resize(int newCapacity) {

Entry[] oldTable = table;

int oldCapacity = oldTable.length;

if (oldCapacity == MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return;

}

Entry[] newTable = new Entry[newCapacity];

//将旧的数组中的数据移到新数组中

transfer(newTable, initHashSeedAsNeeded(newCapacity));

table = newTable;

threshold = (int)Math.min(newCapacity * loadFactor, MAXIMUM_CAPACITY + 1);

}

到这里,HashMap的put的源码就结束了。

接下来再看一下jdk1.8中的HashMap底层原理

1.7中,虽然采取了好几个措施比如扩容来尽量减少某一个链表会很长的情况出现,但是 还有可能出现某一个链表的长度很长,所以1.8中,为了彻底解决这个问题,HashMap采用的是数组+链表+红黑树的形式,那么为什么要采用红黑树而不采用其他树呢?因为,对于我们的HashMap来说,即要保证插入的效率(put)也要保证查询的效率(get),链表的插入效率高,但是查询的效率不高,而红黑树对这两种操作,比较均衡,插入和查询的效率都可以,是一个比较折中的方法,是基于一个综合角度来考虑的。当一个链表中的元素超过或者等于8个时,并且这个时候数组的长度大于64,这个时候就要把链表改成红黑树,因为当链表中元素大于或等于8个时,查询的效率不高,当红黑树只有6个结点,就把红黑树改成链表,那么,为什么一个是8,一个是6呢?因为这是为了防止频繁的插入和删除元素,比如,当一个链表中有7个元素,你插入一个元素,把链表改成红黑树,如果删除的话,就变成链表,这样的话,影响HashMap的效率。

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

//判断数组是否为空,如果等于空,就对数组进行初始化

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

//如果当前元素对应的值table[i]为空,就把这个值放到数组中

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

else {

Node<K,V> e; K k;

//如果不为空,但是要插入的元素与table[i]的哈希值相等或者==并且equals的话,就将table[i]赋给e,然后最后对e进行判断,如果不为空,就把原来的值给覆盖,并且返回

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

//判断此时是否为树,如果是树节点,就把这个结点插入到红黑树

else if (p instanceof TreeNode)

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

else {

//既不是红黑树也不是数组中第一个元素,就遍历链表

for (int binCount = 0; ; ++binCount) {

//判断结点是不是尾结点

if ((e = p.next) == null) {

//直接插到链表的最后

p.next = newNode(hash, key, value, null);

//判断链表中元素个数大于大等于7,就调用treeifyBin(tab, hash),treeifyBin这个方法中还进行了判断,如果数组等于空或者数组的长度小于64,就把数组扩容,而不是直接转换成红黑树,因为扩容之后还可以放更多元素,链表还是很短

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

//判断链表中的除第一个以外的元素是否与要插入的元素key相等,如果有,就结束循环,没的话,就把p赋给e,进行下次循环

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

//判断是否为空,如果不为空,就说明,HashMap中有相同的key,如果为空,就没有相同的key

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

//判断是否需要扩容

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

1.7中是先扩容后进行插入,1.8中是先插入元素后进行扩容,另外1.8中初始化数组和扩容都是利用resize方法

源码如

final Node<K,V>[] resize() {

Node<K,V>[] oldTab = table;

int oldCap = (oldTab == null) ? 0 : oldTab.length;

int oldThr = threshold;

int newCap, newThr = 0;

//oldCap如果大于0,就是对元素组进行扩容

if (oldCap > 0) {

//如果数组已经是最大了,就不扩容了

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return oldTab;

}

//如果不是最大数组,就扩为原来的两倍

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold

}

//如果oldCap = 0 但是oldThr大于0,说明是对数组进行初始化,将oldThr赋给newCap

else if (oldThr > 0) // initial capacity was placed in threshold

newCap = oldThr;

else {//都等于0的话,就初始化为默认值

// zero initial threshold signifies using defaults

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

if (newThr == 0) { //判断新的阈值是否为0,如果为0的话,就重新计算

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

threshold = newThr;//把新的阈值赋给threshold

@SuppressWarnings({"rawtypes","unchecked"})

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

table = newTab;//把新的数组赋给table

//下面就是将老的数组中的长度移到新的数组中

if (oldTab != null) {

for (int j = 0; j < oldCap; ++j) {

Node<K,V> e;

if ((e = oldTab[j]) != null) {

oldTab[j] = null;

if (e.next == null)

newTab[e.hash & (newCap - 1)] = e;

else if (e instanceof TreeNode)

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

else { // preserve order

Node<K,V> loHead = null, loTail = null;

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

do {

next = e.next;

if ((e.hash & oldCap) == 0) {

if (loTail == null)

loHead = e;

else

loTail.next = e;

loTail = e;

}

else {

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

if (loTail != null) {

loTail.next = null;

newTab[j] = loHead;

}

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}

本人第一次写博客,有不足的地方或者写的不好的地方,欢迎指正。