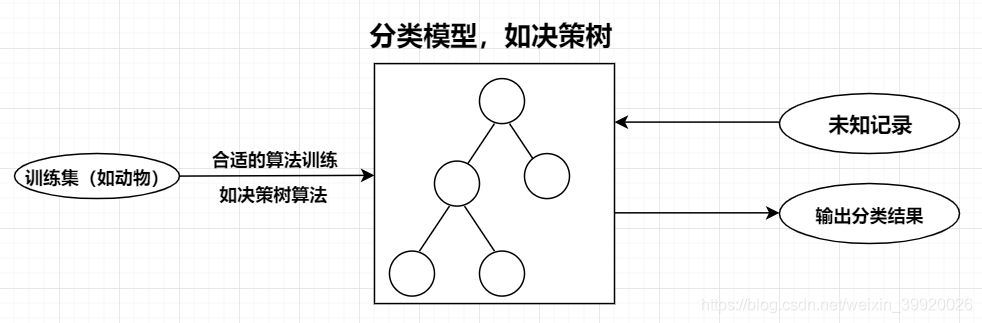

1.决策树模型

2.外卖决策树

- 三个属性:食堂是否营业,账号是否有红包,是否疲劳。

- 两个结果:点外卖,吃食堂。

决策树的形成重点在属性的选取,在能分类出来的情况下,属性越少越好。

| 样本 | 学生 | 红包 | 食堂营业 | … | 结果 |

|---|---|---|---|---|---|

| 1 | 1 | 0 | 1 | … | 吃食堂 |

| 2 | 0 | 1 | 1 | … | 点外卖 |

| 3 | 1 | 1 | 0 | … | 点外卖 |

| … | … | … | … | … | … |

| n | 1 | 0 | 0 | … | 吃食堂 |

3.分类算法——ID3算法(1986)

-

ID3算法是在每个节点处选取能获得最高信息增益的分支属性进行分裂。

-

衡量样本集合纯度的指标:熵 ,熵值越小,不确定程度越小。定义如下:

其中

即为大样本中分类第

种结果的频率,即为概率。

- 举个简单例子帮助理解熵值,比如说如果有一个大小为10的布尔值样本集合 ,其中真值有6个,假值有4个,则该布尔型样本分类的熵值为:

- 是否知道一个属性对前后两个熵值的影响较大,说明该属性较重要,本质就是属性对熵值的影响程度大小与该属性的重要程度成正比。

通过上式“有放回地”计算每个属性的信息增益值,其中

是一种熵值比赋权,确定最大的信息增益的属性,选取该属性作为最重要的属性,构建决策树的节点。

确定最大的信息增益的属性,选取该属性作为最重要的属性,构建决策树的节点。