安装:pip install lxml

实例化一个etree对象

from lxml import etree

- 1、将本地的

html文档中的源码数据加载到etree对象中

etree.parse(filePath)

- 2、可以将从互联网上获取的源码数据加载到该对象中

page_text = requests.get(url, headers=headers).text

etree.HTML('page_text')

xpath表达式

/:表示的是从根节点开始定位,表示的是一个层级。

tree = etree.parse('test.html') # 加载 html 文件

tree.xpath('/html/body/div') # 获取 body 中的 div

//:表示的是多个层级。可以表示从任意位置开始定位。

tree = etree.parse('test.html')

tree.xpath('/html//div') # 获取 body 中的 div

tree.xpath('//div') # 获取 body 中的 div

- 属性定位

//tag[@attrName="attrVaLue"]

tree = etree.parse('test.html')

tree.xpath('//div[@class="song"]') # 获取 body 中 class=“song” 的 div

- 索引定位

//div[@class=" song"]/p[3] # 索引是从1开始的。

tree = etree.parse('test.html')

tree.xpath('//div[@class="song"]//li[5]/a/text()')

tree.xpath('//li[7]//text()') # 获取第七个 li 标签中的所有文本

- 获取标签之间的文本

/text() # 获取的是标签中直系的文本内容

//text() # 标签中非直系的文本内容(所有的文本内容)

tree = etree.parse('test.html')

tree.xpath('//div[@class="song"]//li[5]/a/text()')

tree.xpath('//li[7]//text()')

- 获取属性

/@attrName

tree = etree.parse('test.html')

tree.xpath('//div[@class="song"]/img/@src') # 获取 img 的 src 属性

二手房名称

- 爬取 58同城 北京在售二手房名称

- 爬取链接:

https://bj.58.com/ershoufang/

from lxml import etree

import requests

if __name__ == '__main__':

url = 'https://bj.58.com/ershoufang/'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'

}

page_text = requests.get(url, headers=headers).text

tree = etree.HTML(page_text)

li_list = tree.xpath('//ul[@class="house-list-wrap"]/li')

fp = open('二手房名称.text', 'w', encoding='utf-8')

for li in li_list:

# 局部解析

title = li.xpath('./div[2]/h2/a/text()')[0]

print(title)

fp.write(title + '\n')

print('数据爬取结束!')

小姐姐

- 爬取 彼岸图网 的小姐姐图片

- 爬取链接:

http://pic.netbian.com/4kmeinv/

from lxml import etree

import requests

import os

if __name__ == '__main__':

url = 'http://pic.netbian.com/4kmeinv/'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'

}

response = requests.get(url, headers=headers)

# 手动设置响应数据的编码格式

# response.encoding='utf-8'

page_text = response.text

tree = etree.HTML(page_text)

li_list = tree.xpath('//div[@class="slist"]/ul/li')

if not os.path.exists('./彼岸图网'):

os.mkdir('./彼岸图网')

for li in li_list:

img_src = 'http://pic.netbian.com' + li.xpath('./a/img/@src')[0]

img_name = li.xpath('./a/img/@alt')[0] + '.jpg'

# 通用处理中文乱码的解决方案

img_name = img_name.encode('iso-8859-1').decode('gbk')

img_data = requests.get(img_src, headers=headers).content

img_path = './彼岸图网/' + img_name

with open(img_path, 'wb') as fp:

fp.write(img_data)

print(img_name, '爬取成功!')

print('数据爬取结束!')

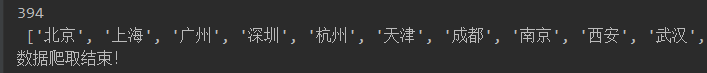

城市名

- 爬取所有城市名

- 爬取链接:

https://www.aqistudy.cn/historydata/

from lxml import etree

import requests

if __name__ == '__main__':

url = 'https://www.aqistudy.cn/historydata/'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'

}

response = requests.get(url, headers=headers)

page_text = response.text

tree = etree.HTML(page_text)

# 解析热门城市,所有对应城市的 a 标签

# //div[@class="bottom"]/ul/li/ 热门城市 a 标签的层级关系

# //div[@class="bottom"]/ul/div[2]/li/a 热门城市 a 标签的层级关系

a_list = tree.xpath('//div[@class="bottom"]/ul/li/a | //div[@class="bottom"]/ul/div[2]/li/a')

all_city_name = []

for a in a_list:

city_name = a.xpath('./text()')[0]

all_city_name.append(city_name)

print(len(all_city_name), '\n', all_city_name)

print('数据爬取结束!')