Adversarial Transfer Learning for Chinese Named Entity Recognition with Self-Attention Mechanism

概述

这篇文章,主要有两个创新点,第一个创新点,命名实体识别任务既要求识别出实体的边界又要求识别出实体的类型。对于中文而言,命名实体识别任务和分词任务共享较多信息(主要是边界信息),但是分词任务也有自己任务特有的信息,以前的命名实体识别任务和分词任务联合学习的方法,并没有过滤掉分词任务独有的信息,本篇文章利用对抗训练,过滤掉分词任务特有的信息,将与实体识别的共享的信息融入到命名实体识别任务中。

第二个创新点是将自注意力机制引入了命名实体识别任务中,作者认为自注意力机制可以使序列中的任意字符可以注意序列中的其他字符,有利于准确实体实体的类型。

网络总体架构

字符嵌入层使用的是word2vec,三个特征提取器都是BiLSTM,特征提取器后面都加了一层Self-attention,这里的自注意力机制,就是Transfromer中的多头注意力机制(可以参考Transformer理解),从框架中可以看出命名实体识别任务中selfAttention输出的特征融入了共享模块输出的特征(文中是直接连接)。

对抗训练

作者引入对抗训练是为了保证输出的共享特征中不会融入任务特定的特征

作者首先设计了一个任务鉴别器,具体的公式如下,就是简单的多分类。确定输入的句子是属于命名实体识别任务还是分词任务。

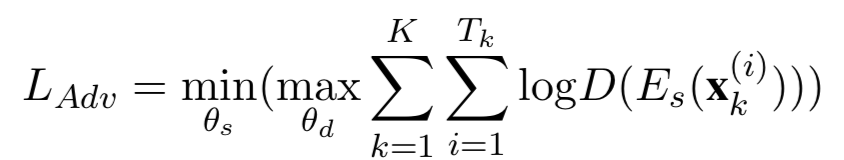

为了阻止任务特定特征融入共享特征中,作者设计了一个对抗损失。对抗损失训练是为了产生一个共享特征,使得任务鉴别器无法分辨这个句子来自哪个任务。对抗损失的公式如下

是shared BiLSTM:特征提取器

是第k个任务的第i个sample

刚才已经提到了是鉴别器的参数、 是shared BiLSTM的参数

对这个公式,文章的解释是

There is a minmax optimization that the shared BiLSTM generates a representation to mislead the

task discriminator and discriminator tries its best to correctly determine the type of task

作者为了训练在softmax层之前加入了gradient reversal layer,对解决极小极大优化问题。

问题