1 前言

我们现在先来看看常见的loss函数具有什么样的特点;

2 语义分割中常见的loss函数

2.1 Cross Entropy loss交叉熵损失

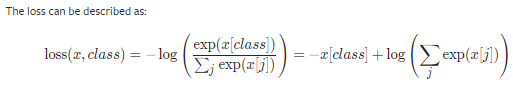

首先我们来看看 Cross Entropy loss的公式,(这里我们参考PyTorch中的公式):

好像有点不容易看懂,这里我把它归纳一下,

这里的公式等价于,

这里的

指的是真实的概率,在实际情况中真实的概率一般是“0和1”,也就是我们人类的标注的信息;

2.2 Focal loss

我们首先来看看 Focal loss的公式,(公式来自于RetinaNet的原始论文):

2.3 Dice loss

我们先来看看 Dice loss的公式:

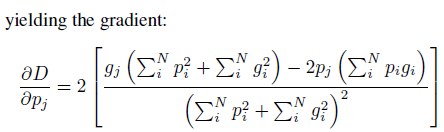

不过这跟原始论文的公式看起来有点不一样,

原始论文的公式是这样写的,

其实不是很好理解,这里把 Dice loss的计算包含在了梯度的公式中,其实它是由文中的 Dice coefficient

引申出来的,其中D的公式为:

其中

是预测的概率值,

是真实值;

2.3.1 Dice loss存在的问题

会使loss变得不稳定;