一、简介

线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法。

回归分析中,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。这篇的主题是一元线性回归,下篇将讲到多元线性回归。

二、原理

-

损失函数:最小平方差

根据最小平方法,使用梯度下降法求解y=a+bx中的a和b。那么什么是最小平方法?

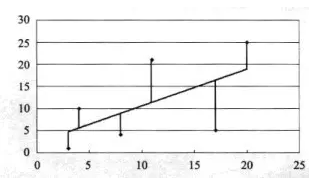

分别从散点图的各个数据标记点,做一条平行于y轴的平行线,相交于图中直线(如下图)

平行线的长度在统计学中叫做“误差”或者‘残差”。误差(残差)是指分析结果的运算值和实际值之间的差。接这,求平行线长度曲平方值。损失函数的目的是使所有的样本点的平方值总和最低。 -

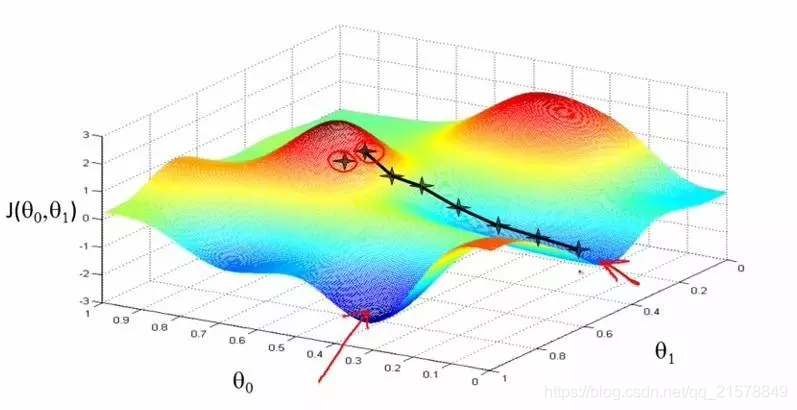

梯度下降

假设上图是我们的损失函数图形,那我们需要找到的就是左边箭头指向的那个点,这个点对应的对应的参数便是我们找的全局最优解。

三、手写实现梯度下降法

作为基础的机器学习知识,必须要掌握具体的实现过程。在面试和笔试中都会有所涉及。

栗子传送门 >>>>>>