决策树是一种基本的分类与回归方法。在分类问题中,可以认为是if-then规则的集合,也可以认为是定义在特征空间与类空间上的条件概率分布。

决策树的学习包括3个步骤:特征选择、决策树的生成及决策树的修剪,常用的算法有ID3,C4.5和CART。

决策树的定义:分类决策树模型是一种描述对实例进行分类的树形结构。决策树由结点和有向边组成,结点有两种类型:内部结点和叶结点,内部结点表示一个特征或属性,叶结点表示一个类。

决策树学习算法是递归的选择最优特征,并根据该特征对训练数据进行分割,使得对各个子数据集有一个最好的分类的过程。决策树学习的策略是以损失函数为目标函数的最小化。

决策树的剪枝是为了防止过拟合,提高决策树的泛化能力。决策树的生成对应于模型的局部最优选择,决策树的剪枝对应于模型的全局最优选择。

1.特征选择

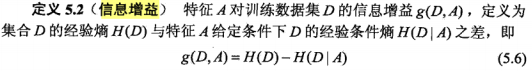

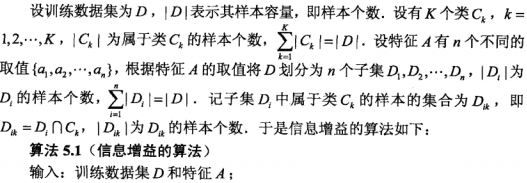

特征选择在于选取对训练数据具有分类能力的特征,通常特征选择的准则是信息增益或信息增益比。

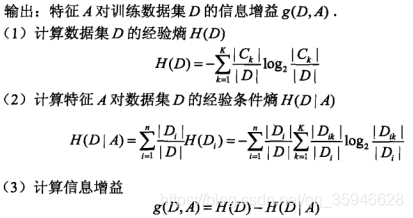

信息增益:

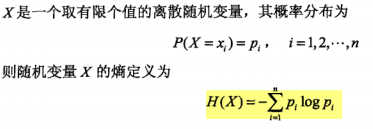

熵是表示随机变量不确定性的度量。

定义中的对数以2为底或以e为底(自然对数),熵的单位分别是比特(bit)或纳特(nat)。熵越大,随机变量的不确定性就越大。

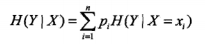

条件熵H(Y|X)表示在已知随即变量X的条件下随机变量Y的不确定性,定义如下:

当熵和条件熵有数据估计(如:极大似然估计)得到时,所对应的的熵与条件熵称为经验熵和检验条件熵。

信息增益表示得知特征X的信息而使得类Y的信息的不确定性减少的程度。

熵H(Y)与条件熵H(Y|X)之差称为互信息。(注:互信息法特征选择的一种常用方法。)

显然,信息增益大的特征具有更强的分类能力。

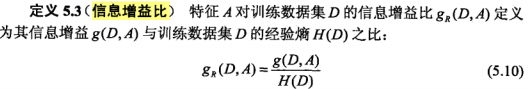

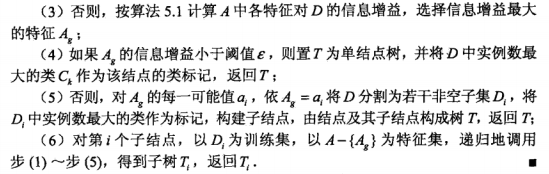

信息增益比:

信息增益比为了解决分类问题困难,即当训练数据集的经验熵大的时候,信息增益值会偏大;反之,信息增益值会偏小。

2.决策树的生成

通常使用信息增益最大、信息增益比最大或基尼指数最小作为特征选择的准则。

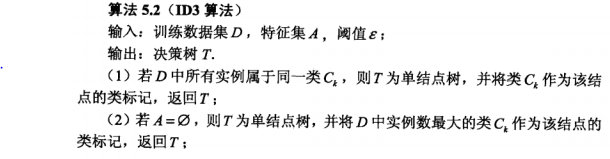

ID3算法:

ID3算法的核心是在决策树各个结点上应用信息增益准则选择特征,递归地构建决策树。

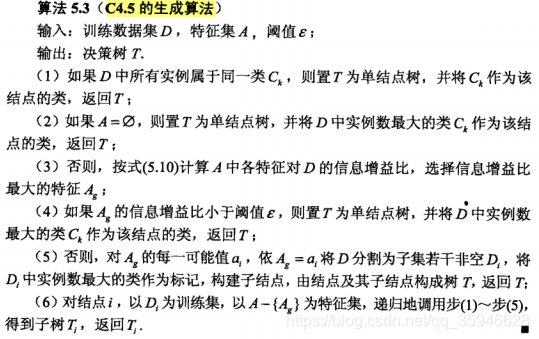

C4.5算法:

C4.5在生成过程中,用信息增益比来选择特征。

3.决策树的剪枝

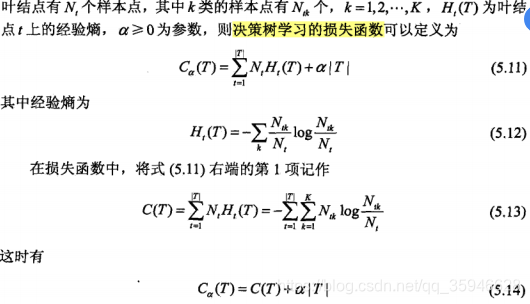

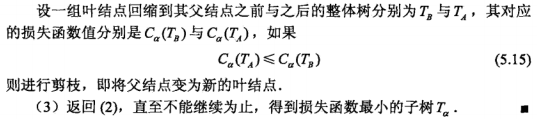

在决策树学习中将已生成的树进行简化的过程称为剪枝。具体地,剪枝是从已生成的树上裁掉一些子树或叶结点,并将其根结点或父结点作为新的叶结点,从而简化分类树模型。

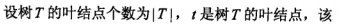

决策树的剪枝通过极小化决策树整体的损失函数或代价函数来实现。

决策树的损失函数:

参数a>=0是平衡模型与训练数据的拟合程度以及模型复杂度。

CART算法:

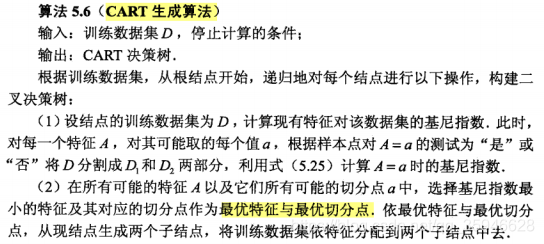

分类与回归(Classification and regression tree,CART)模型既可以用于分类也可以用于回归。CART是在给定输入随机变量X条件下输出随机变量Y的条件概率分布的学习方法,其生成的决策树是二叉树。

决策树的生成就是递归的构建二叉决策树的过程,对回归树用平方误差最小化准则,对分类树用基尼指数最小化准则,进行特征选择,生成二叉树。

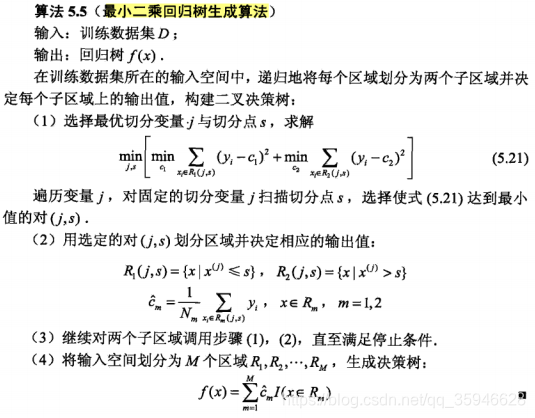

(1)回归树的生成

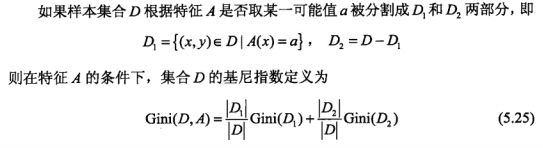

(2)分类树的生成

基尼指数定义如下:

基尼指数越大,样本集合的不确定性越大。

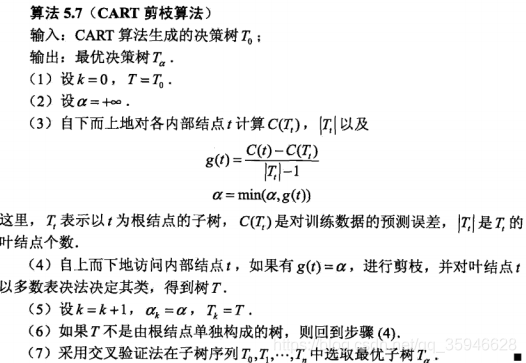

CART剪枝:

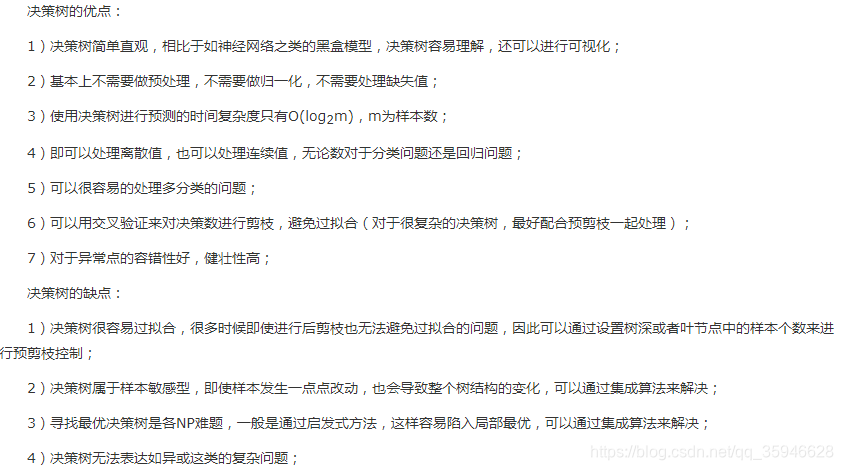

决策树的优缺点:

机器学习算法总结5:决策树

猜你喜欢

转载自blog.csdn.net/qq_35946628/article/details/104449067

今日推荐

周排行