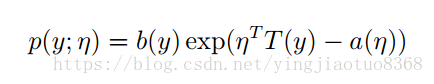

η是分布的自然参数(natural parameter ),比如伯努利分布中的Φ;T(y)是充分统计量(sufficient statistic ),个人理解是能充分体现数据特点的更低维的数据,在这里通常T(y)=y。式子看起来不友好,个人理解,无非是将一个分布写成了一个指数形式。概率P>0,而指数函数的也都是大于0的,通过b,a,T来修改指数函数得到我们想要的形式。

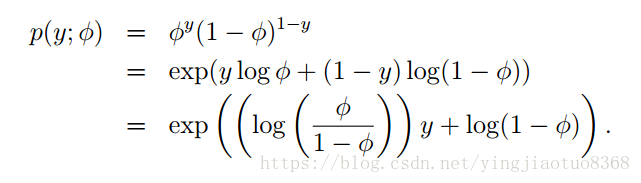

以Bernoulli分布为例:

所以我们可得,b(y)=1,η^T=log(Φ/1-Φ),a(η)=log(1-Φ),该分布中η为标量,所以η=log(Φ/1-Φ),两边以e为底,得

Φ=1/(1+e^η)。令人惊讶的是,这恰好就是我们的logistics function。其建立的是一种概率和自然参数的关系,在逻辑回归中我们的参数就是我们手里的样本数据,想对样本做一个二分类,自然而然联系二项分布,从而推出logistics function。

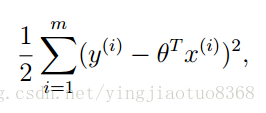

接着我们来看高斯分布,在线性回归中我们通过假设误差ε~N(0,σ^2),然后通过最大似然推出目标是最小化

我们可以看到,不同的分布对应的解析式是不一样的。比如我们要对一个问题建模,首先我们分析这些数据服可能从什么分布,最简单的就对0,1问题建模必然首选伯努利分布,根据GLM推出我们需要的hypothesis。下面就介绍怎么使用GLM。

要想使用GLM解决问题,我们必须遵守三个假设:

1.y丨x;θ~exponentialfamily(η),即给定x和θ,y是服从指数族的某个分布的。

2.h(x)=E[y丨x]。以logistics regression为例,我们预测的h(x)是一个概率,所以有

hθ(x) = p(y = 1|x; θ) = 0 · p(y =0|x; θ) + 1 · p(y = 1|x; θ) = E[y|x; θ].)

3.η = θTx ;即η和x满足线性关系

根据这三个假设,我们就能得到线性回归和逻辑回归中的假设是如何来的。线性回归中:

逻辑回归中:

这也解释了当我们做LR二分类的时候为什么会采取该假设,因为二分类是服从伯努利分布的,而我们从伯努利分布推出上式,自然就该应用此假设。