所谓的单变量线性回归问题就是监督学习的一部分。

通过构建数学模型给出一个相对准确的数值,也就是预测模型,通过将数据通过数学模型,衍生至回归问题

通过以下的几个例子,我们来研究单变量线性回归。

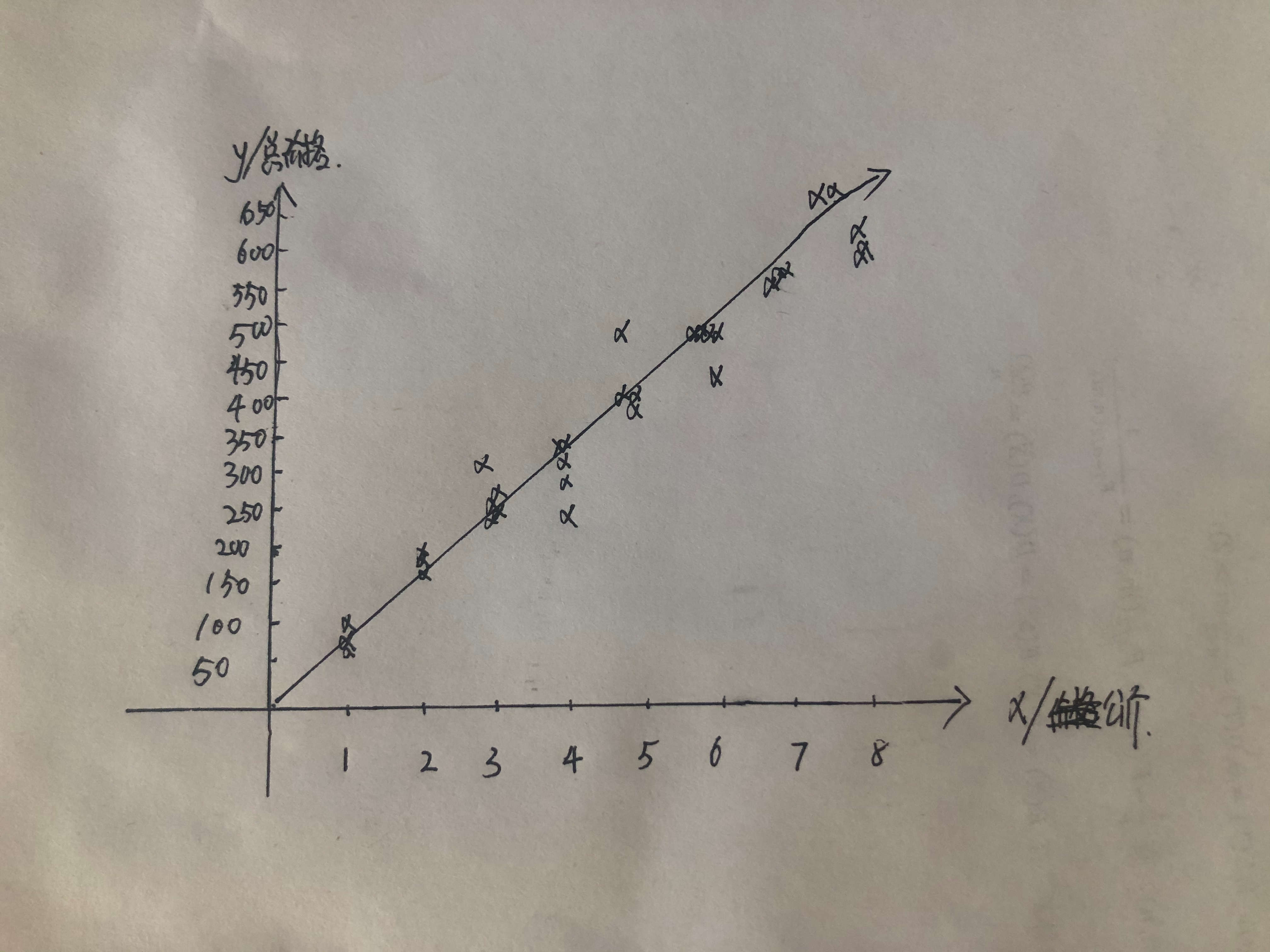

1.王阿姨由于刚来本地时间不久,对本地海鲜市场螃蟹的价格并不了解,所以王阿姨的儿子为王阿姨建立了单变量线性回归的数学模型

从这张图片来看,王阿姨所需要的螃蟹价格回归模型明显和准确的显示出当地价格的数学模型。

2.某学校为当地同学买球鞋,各地价格不一样,所以采用了线性回归的办法来估测同学们此次卖运动鞋所化的费用

我们就同类上述王阿姨的数学模型就可以不难看出,我们通过数学模型,建立起相对应的一次函数,从而预测大数量的价格预算。

在此我们引入一个新的概念Hypothesis,我们简称h,这里的h相当于我们的自变量x。

因为在建立函数的过程中h(x)=k+kx,由于其中只有一个变量,所以我们称之为单变量线性回归,回归就是代表的我们函数直线。

代价函数

我们刚引入了一个知识点,叫做单变量线性回归,也就是我们所说的h(x)=&+kx,那我们在此的基础上,对与我们的&和k进行一个新的定义,参数(parameters),&就是Y轴上的截距,而我们的k就是我们熟知的斜率,这些都是建立在数学模型之上。

通过这张图我们可以明显的看出来,由于过多离散的数据导致斜率出现了相对误差,而由于在函数中h(x0)=&+kx0,由于&和k都存在误差,所以我们把这种现象叫做建模误差(modeling error)。

我们继续对代价函数进行探讨,我们为了方便,要将我们的模型参数做到做小,并且误差的绝对值也要最小,所以在代价函数的基础上我们得到了一个&和一个k,并将这两个数据建立一个立体的三维模型

从里面的模型我们会找到一个最小点(这个铺开的模型下的最小值)

这个代价函数也可以是平方误差函数,平方误差就是我们&和k的平方值,这个是我们衡量我们数学模型和单变量线性回归准确率最好的佐证。

这个问题对大多数的线性回归问题都是合理且准确的选择。