1. 基础模型

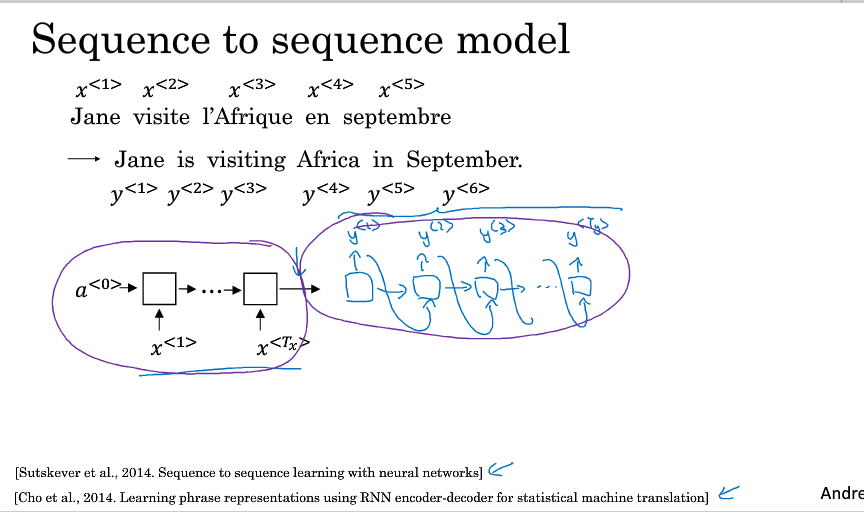

法语翻译成英语

图像描述:根据图片自动学习描述语

AlexNet对图像进行处理,然后再输入RNN

2. 选择最可能的句子

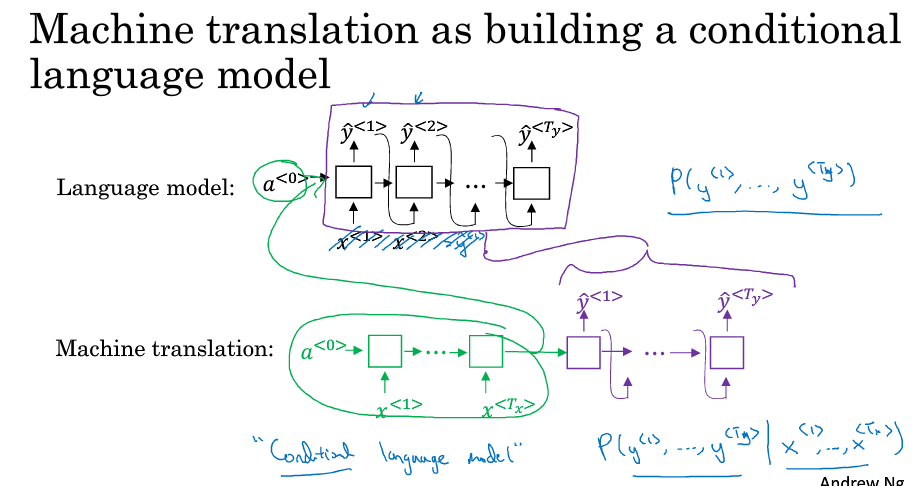

机器翻译:前半部分是encode,后半部分是decode,与语言模型类似

不同点:语言模型总是以空向量作为输入;它输出任意语句的概率,所以,机器翻译也可称为有条件的语言模型,它是以encode的输入为条件,输出的句子的概率

目标:找到一个y,使得该条件概率最大

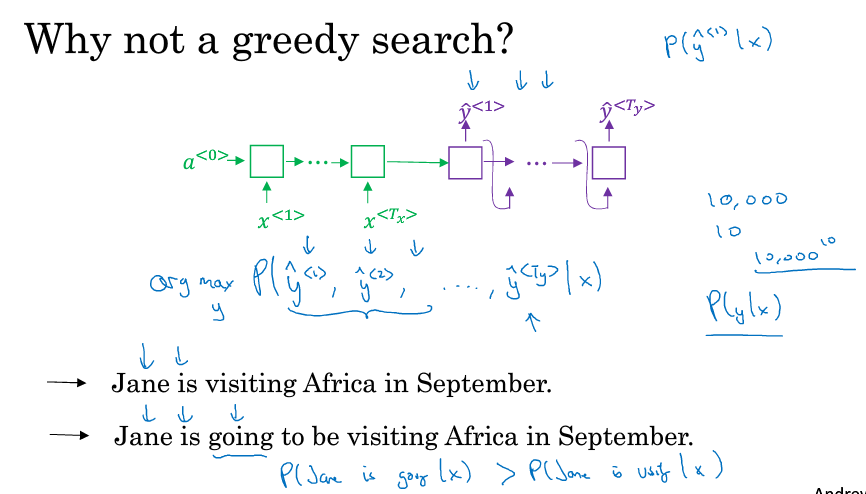

为什么不能用贪婪算法?

只是用例子来说明问题,比如Jame is 确定后,在后面时is going to比is visiting出现的概率要高,但是最后is visiting才是更好的结果

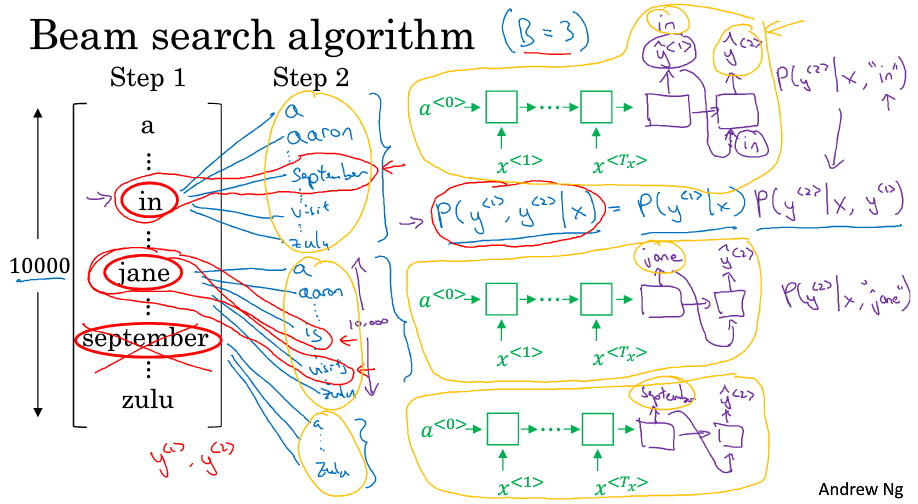

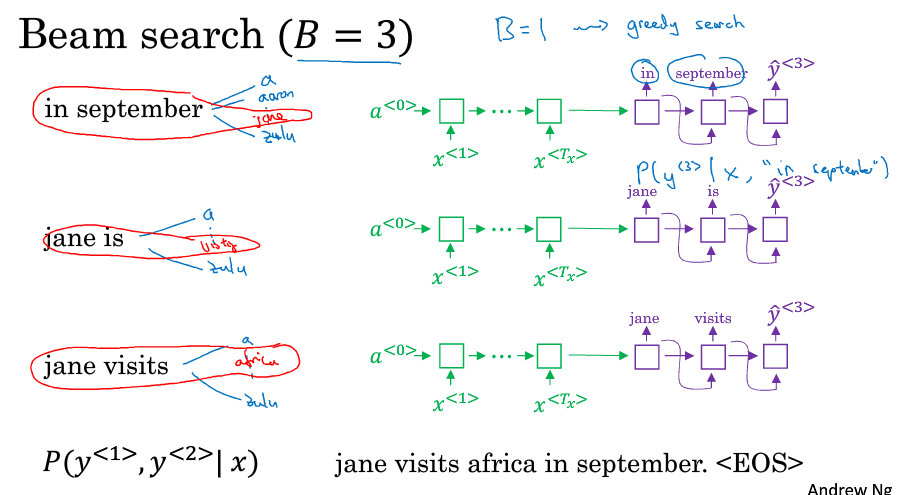

3. bean search集束搜索

基本思想:每次不是保留一个最好结果,而是B(banch width)个(多个,取前几个概率最大的)

假设在1000个词的词典中,第一个最可能的词为in, jane, september (P(y1|x))最大,设B=3

接下来就以这三个作为网络的第一个词判断前两个词组成的词对最可能是什么(P(y1,y2|x))

每个网络分别会判断1000个词,也就是共有3000个可能性,因为找到了in september,所以下面以setptember开头的可以删除,再从剩下的中找出概率大的(保持有3个可能结果)

接下来,判断前三个词的词对。。如果B=1,这个方式就退化成了贪心算法

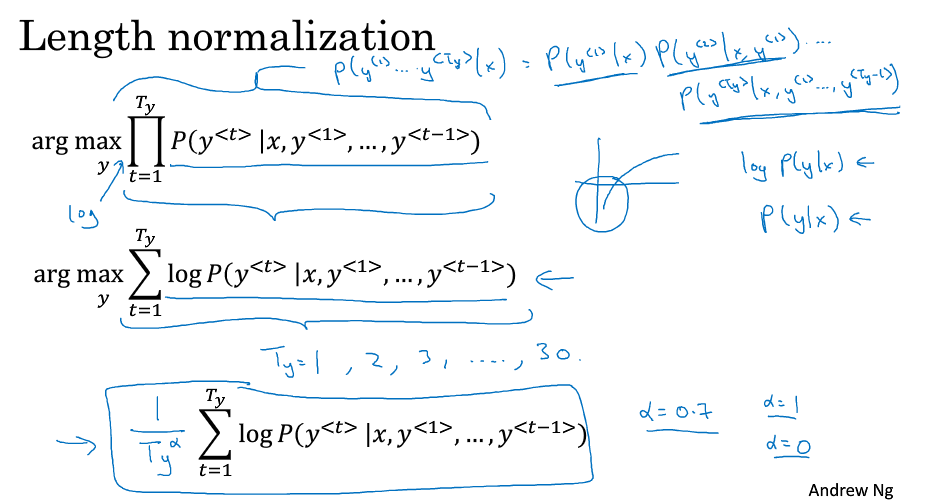

4. 改进bean search

优化目标函数:减少对长句子的惩罚,第三个是最后要的。因为概率<1,所以一直乘,结果越小,所以用log求和,但是,log的值<1(因为x<1),越长也越小,所以再加上归一化(归一化的对数似然函数)

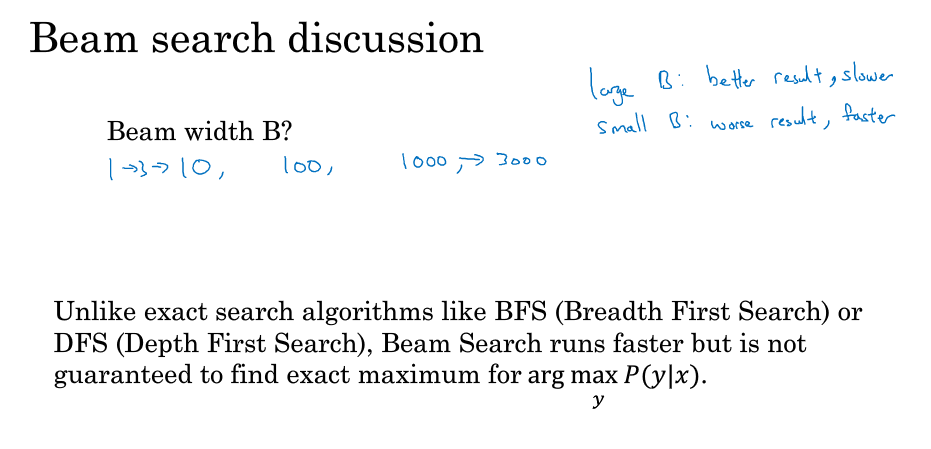

如何选择B,以及bean search与其他搜索算法的区别

5. beam search的误差分析:判断是RNN模型还是bean search有问题,由此决定应该修改什么

把两个结果都放入RNN中计算概率

根据上述的case决定,遍历dev数据集,判断哪个错误多些。如果bean多,则考虑修改B值,反之,修改RNN

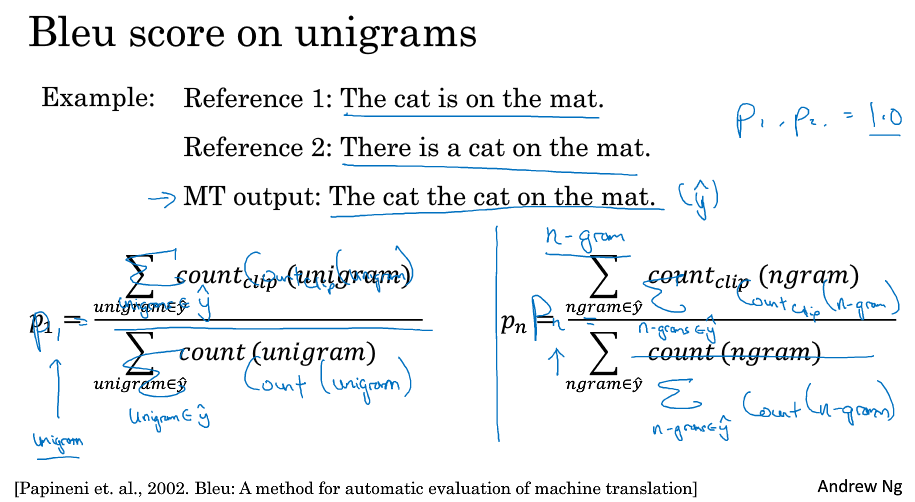

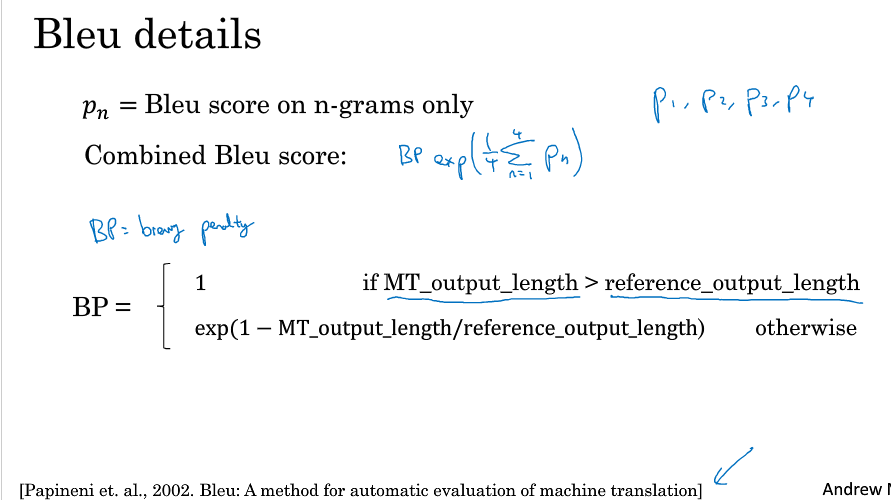

6. BLEU得分 bilangular evaluation understudy(双语评估候补)

机器翻译的结果可能有多个好的结果(不唯一),BLEU本意是想替代人工来判断结果好坏

精度计算:MT中的单词出现在reference(好的翻译结果)中的个数/MT中总的单词数量

第一个:7/7,MT中的每个单词the都在ref中出现,所以分子为7

第二个:2/7,在ref中the总共出现了两次,所以2是the的得分上限,再多的the也最多有2分

bigrams:相邻的两个单词(一个单词对)

按顺序,两两可以组成一对,count表示单词对在MT中出现的次数,count-clip:单词对的得分(参考ref,不超过它的得分上限)

可以计算ngram,就是n个相邻的单词构成的单词对

BP:brevity penalty,用来对过短的结果进行惩罚

怎么把不同的n-grams结果结合:平均值,作为e的指数

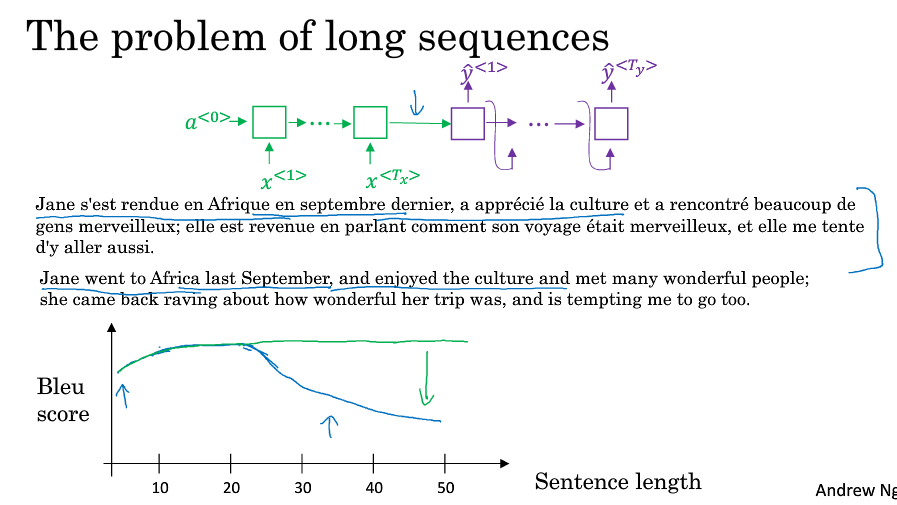

7. 注意力模型直观理解

长句子的问题:翻译时需记住所有单词在翻译,当句子长到一定程度时,BLEU得分会出现骤降。实际上,人工翻译时是一部分一部分翻,而不是记住全部。

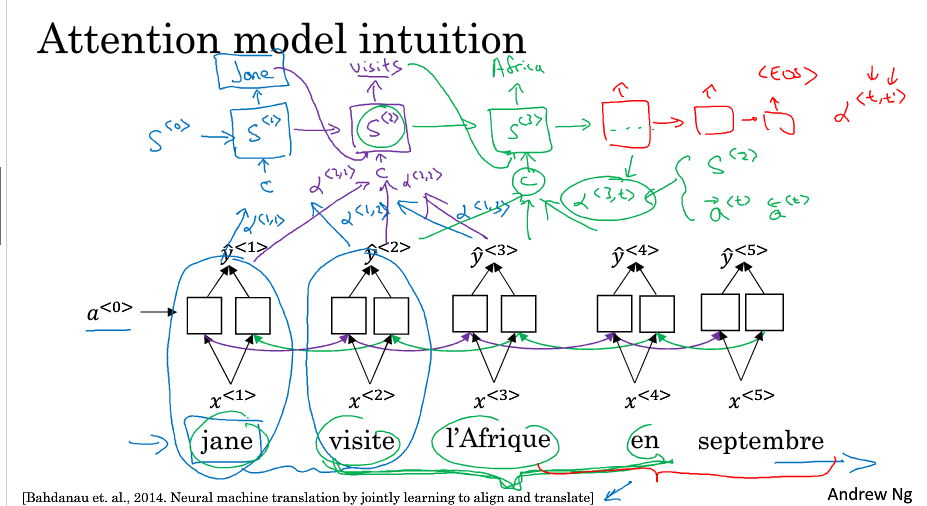

注意力模型:

下面是一个BRNN模型,计算出每5个单词的特征,然后输入到上面的RNN网络进行翻译(部分翻译)

a<t,t'>:当翻译第t个单词时,需要放在第t'个输入单词的注意力

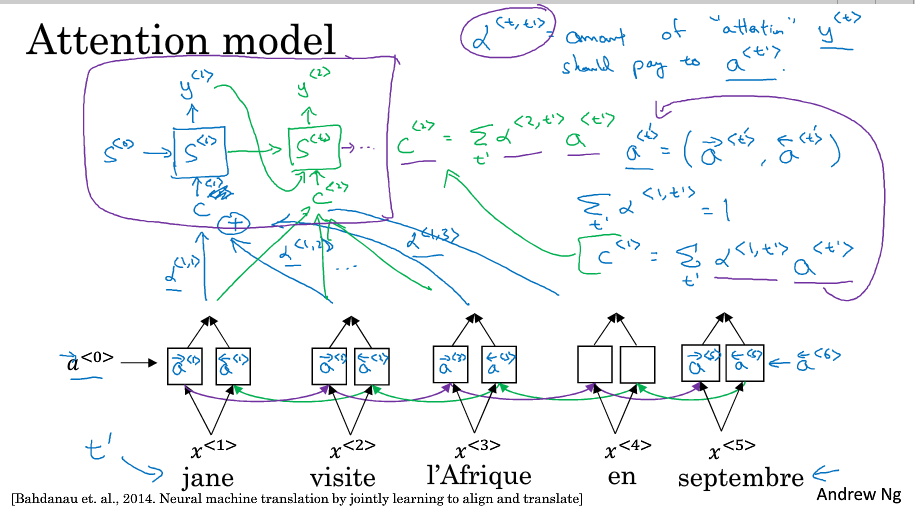

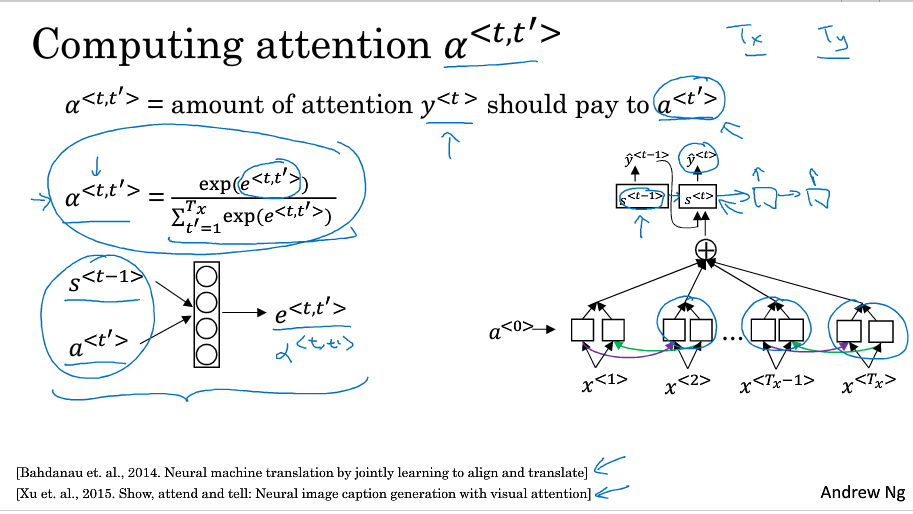

8. 注意力模型:主要是说如何计算alpha<t,t'>

第一个网络使用BRNN,并用a<t'>来统一两个方向的激活值

然后,context C(输入另一个RNN进行翻译)=alpha<t,t'>a<t'>的和(t'表示要翻译的原句中的词)

如何计算

所有alpha<t,t'>求和=1 ->softmax层

e<t,t'>计算:通过一个小网络训练出s<t-1>和a<t'>到e的映射关系

算法复杂度O(n^3)

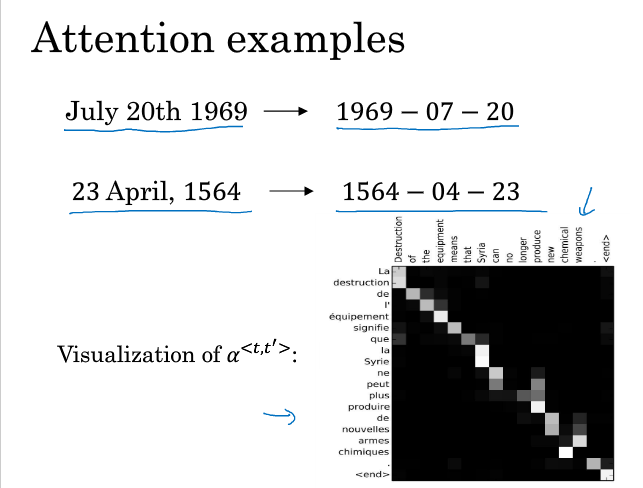

例子

日期转换,可视化

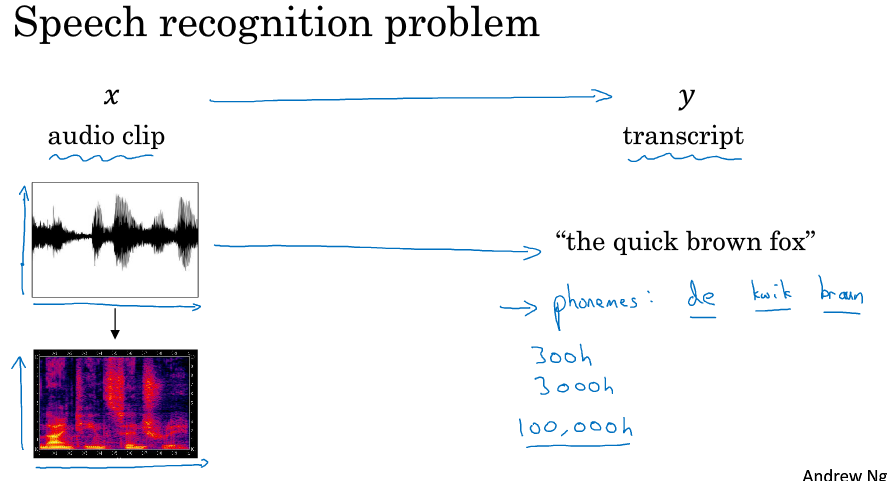

9. 语音辨识

问题:根据音频输出文本

气压随时间变化的音频片段预处理成频率随时间变化(颜声谱图)(这个和人耳的处理方式类似),不再需要音位

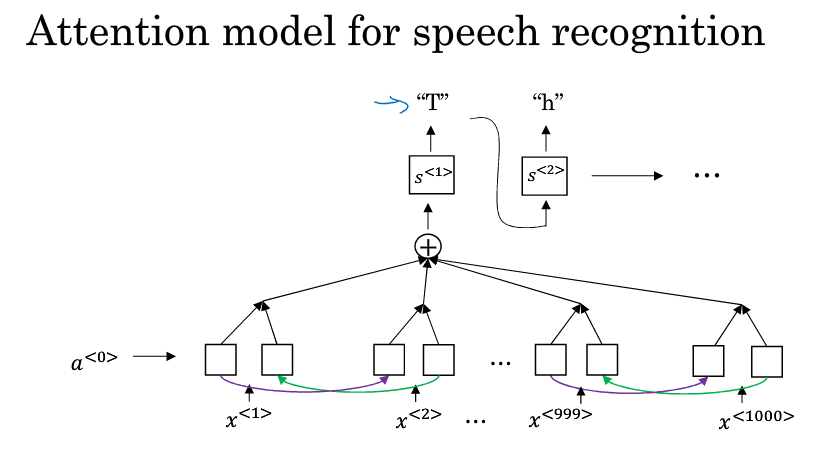

方式一:用注意力模型

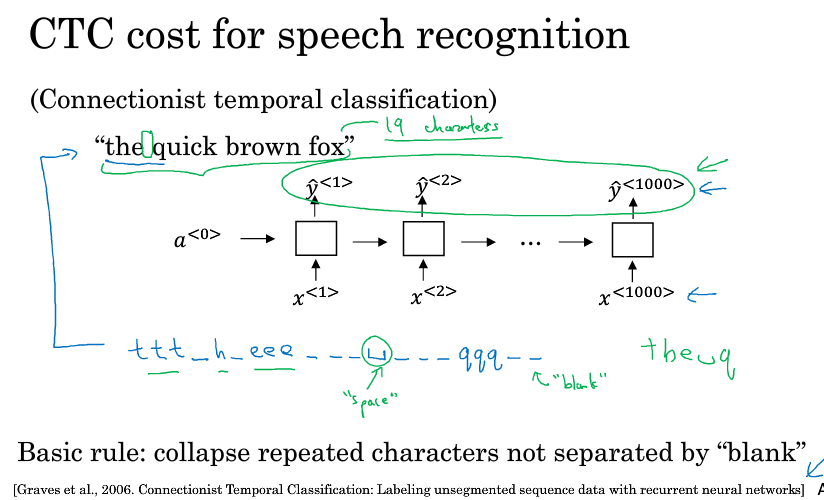

方式二:CTC,比如10s的音频,每秒100个样本(100hz),总共有1000个输入。每个输入对应一个输出,然后把重复的部分(且不是以space隔开的)折叠起来,比如前面几个都识别出t,然后blank,接着h,还有几个e,到遇见的第一个space,前面的折叠起来就变成了the

10. 触发字检测

通过特定的词来唤醒

实现:当触发字说完后就把目标标签标记为1

缺点:1:0个数的比例太低,训练集不平衡。解决:可以将接下来的多个标记为1,其他为0

11. 总结