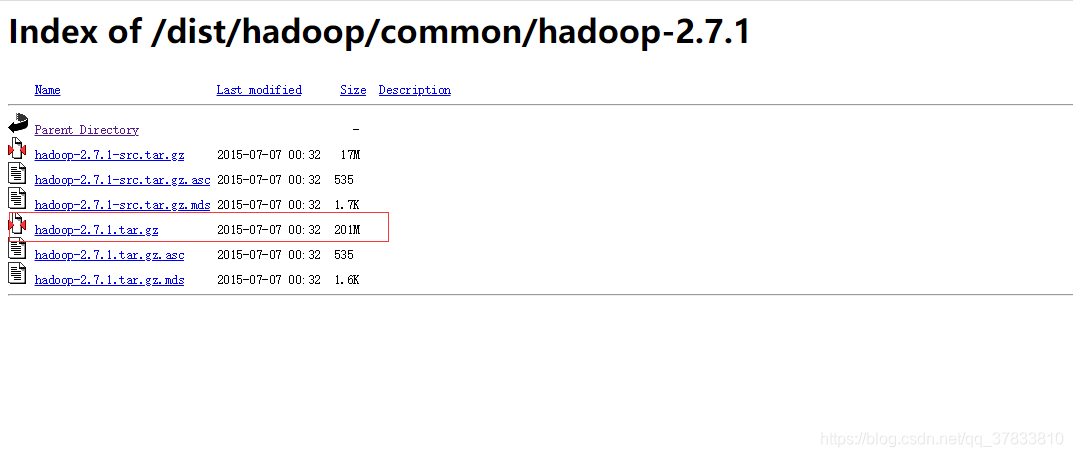

一、Hadoop下载

地址:https://archive.apache.org/dist/hadoop/common/

直接解压,不需要安装,放在自己想要放到的目录底下

直接解压,不需要安装,放在自己想要放到的目录底下

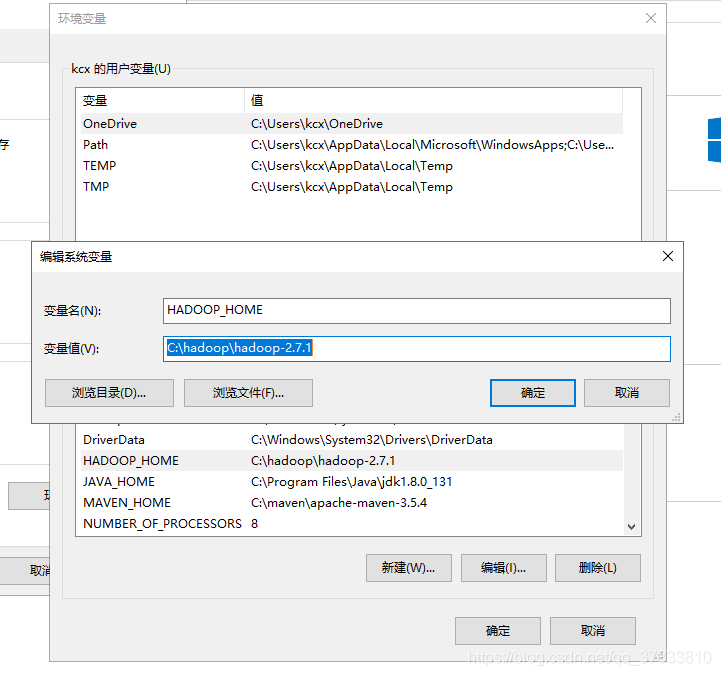

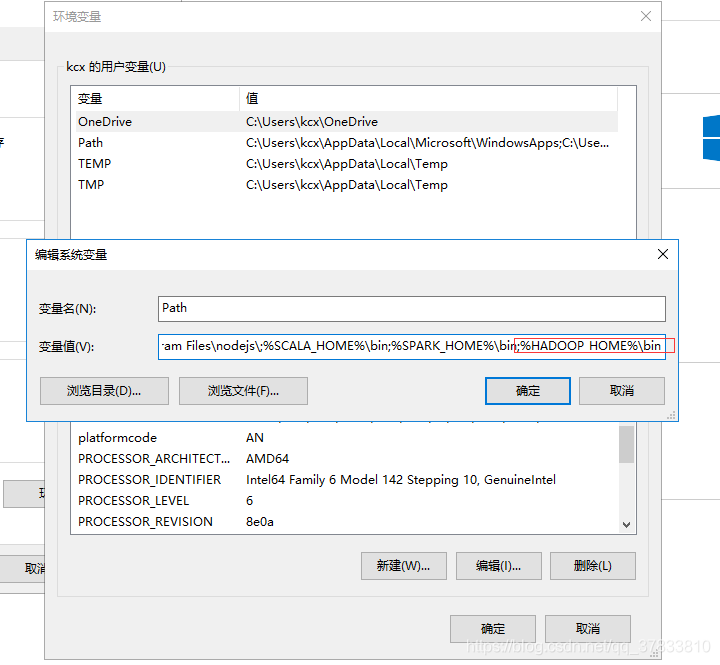

需要设置的变量有

HADOOP_HOME C:\hadoop\spark-2.3.3-bin-hadoop2.7

PATH:%HADOOP_HOME%\bin

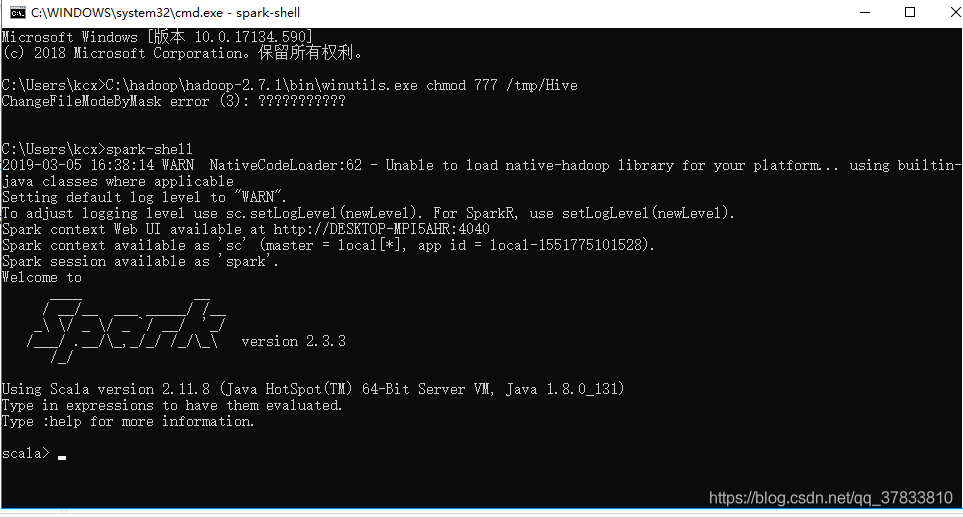

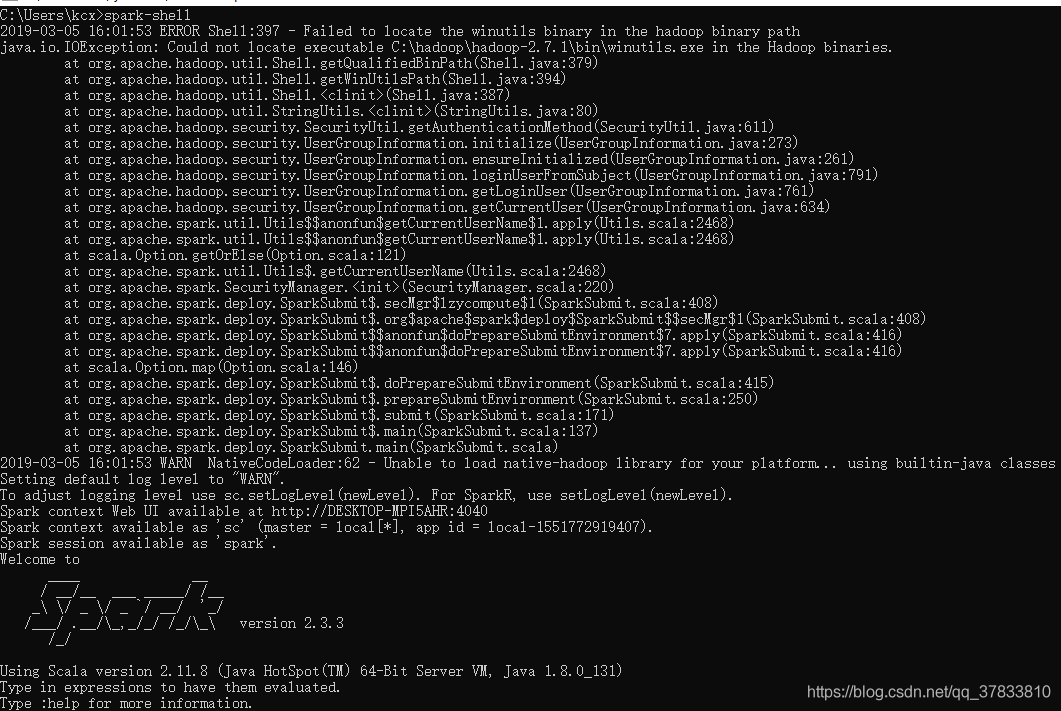

上诉内容都准备好之后再次重新打开控制台输入spark-shell

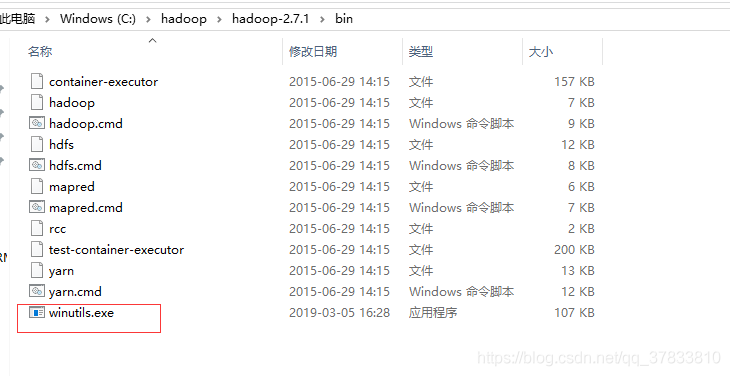

如果还有以上错误日志,那么请找到你的hadoop\bin目录找下里面有没有winutils.exe文件,如果没有的话,我们需要去下载。

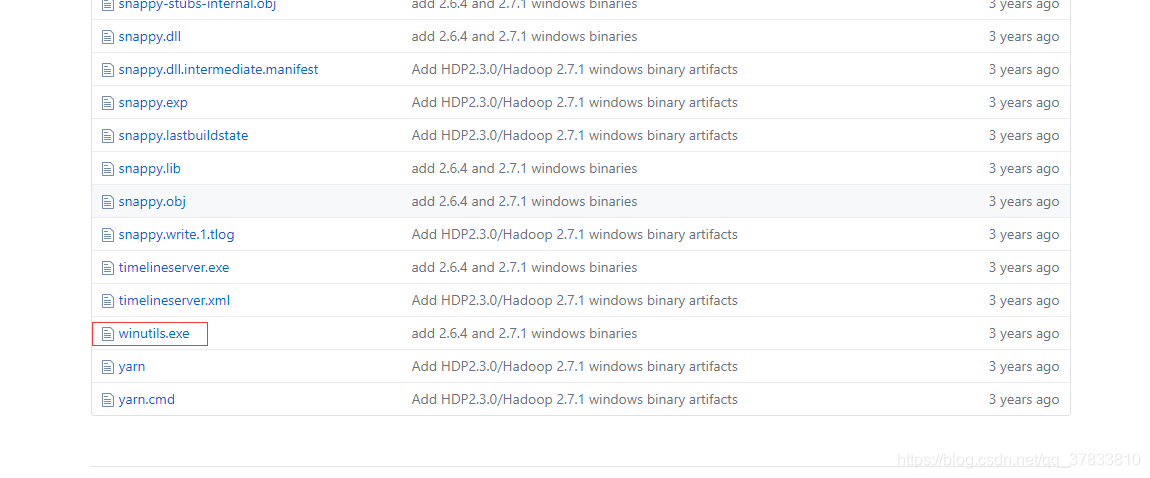

winutils.exe下载地址https://github.com/steveloughran/winutils

进入目录后找到你相应的hadoop目录–进入bin—找到winutils.exe文件下载。

下载好之后我们把它放到C:\hadoop\spark-2.3.3-bin-hadoop2.7 里面,确保该目录中有winutils.exe文件。