1.下载Hadoop

https://download.csdn.net/download/sinat_36710456/10744528

2.解压

hadoop-2.7.3.tar.gz 点右键“解压到hadoop-2.7.3”

文件夹路径 xxx/xxxx/hadoop-2.7.3

复制hadoop-2.7.3文件夹到 d盘 或者 e盘 的根目录 (在这里我安装到了E盘)

3.原版的Hadoop不支持Windows系统,我们需要修改一些配置方便在Windows上运行

所需文件hadooponwindows-master.zip 解压

复制解压开的bin文件和etc文件到hadoop-2.7.3文件中,并替换原有的bin和etc文件

4.配置Hadoop的环境变量

配置Java环境变量

新建变量名:JAVA_HOME

输入路径:D:\Softwares\jdk1.8 (这里是以我的jdk地址为例,请根据自己的jdk地址来设置)

在path中最前面加上:%JAVA_HOME%\bin;

配置Hadoop环境变量

新建变量名:HADOOP_HOME

输入路径:E:\hadoop-2.7.3

在path中最前面加上:%HADOOP_HOME%\bin;

5.确认hadoop配置的jdk的路径

在hadoop-2.7.3\etc\hadoop找到hadoop-env.cmd

右键用一个文本编辑器打开

找到 set JAVA_HOME=C:\PROGRA~1\Java\jdk1.7.0_67

将C:\PROGRA~1\Java\jdk1.7.0_67 改为 D:\Softwares\jdk1.8(在环境变量设置中JAVA_HOME的值)

(如果路径中有“Program Files”,则将Program Files改为 PROGRA~1

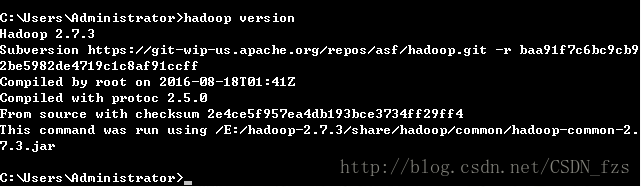

6.配置好上面所有操作后,win+R 输入cmd打开命令提示符,然后输入hadoop version,按回车,如果出现如图所示结果,则说明安装成功

..

格式化系统文件:

hadoop/bin下执行 hdfs namenode -format

待执行完毕即可,不要重复format。

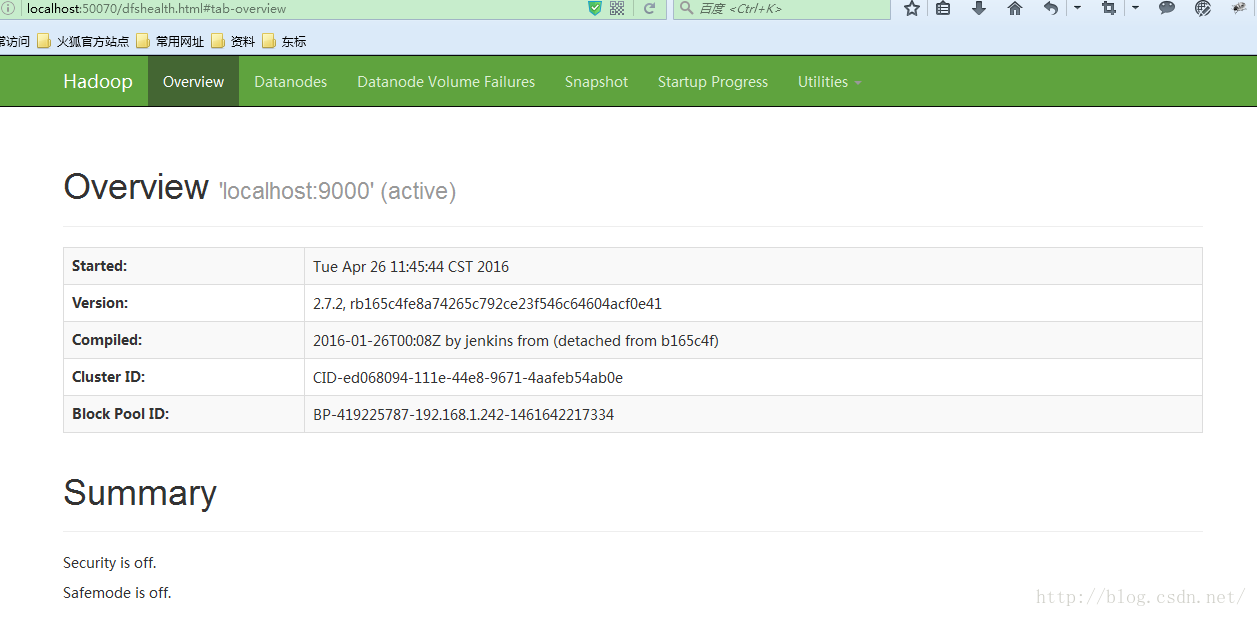

格式化完成后到hadoop/sbin下执行 start-dfs 启动hadoop

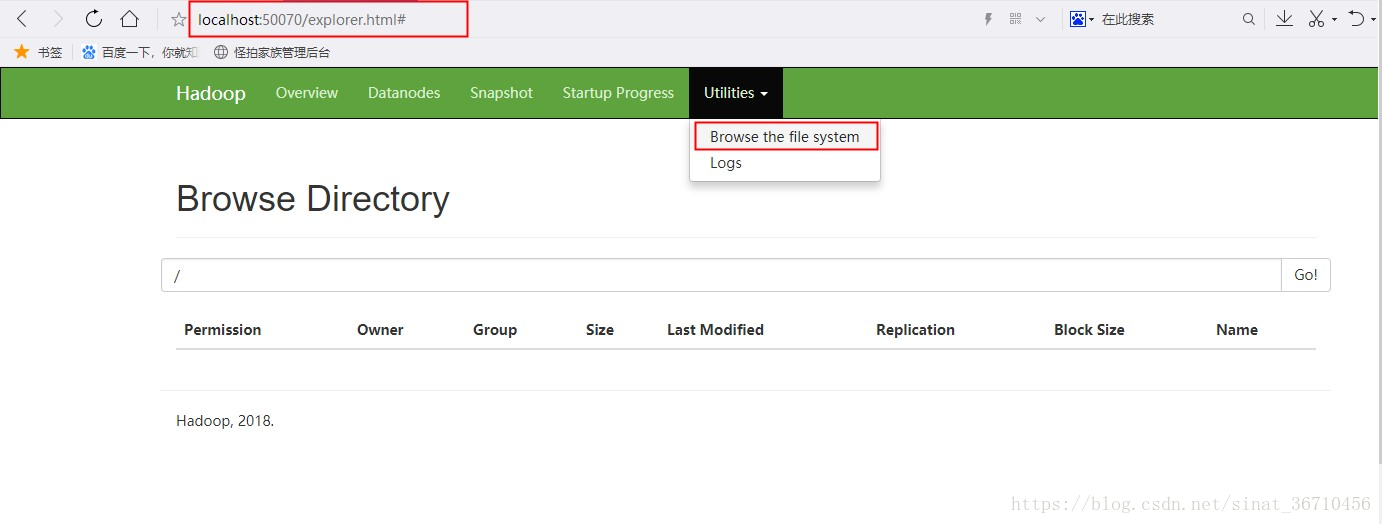

访问:http://localhost:50070

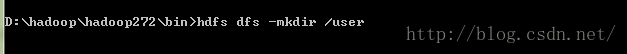

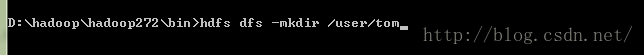

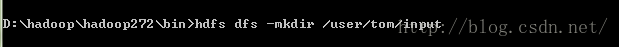

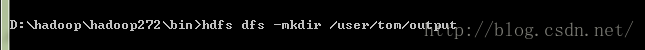

(不是必须的 ) 创建目录:用于输入和输出,linux上是/user/用户名/xx windows上可能没具体要求,我创建也是按照liunx目录方式的。参照的api doc上面

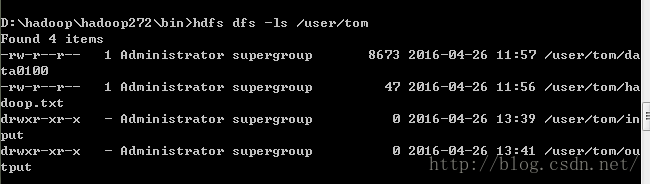

创建完成可以通过hdfs dfs-ls 目录名称查看,也可以在浏览器中查看创建的目录或文件

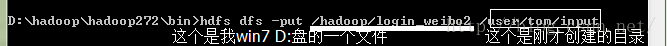

input输入文件到目录:login_weibo2是我自己创建的文本文件,位于hadoop一个盘的。此处是D:/hadoop/login_weibo2

如果了解命令参数输入hdfs dfs回车查看dfs命令参数 。hdfs dfs -put回车查看put相关参数。其他命令也是这样。

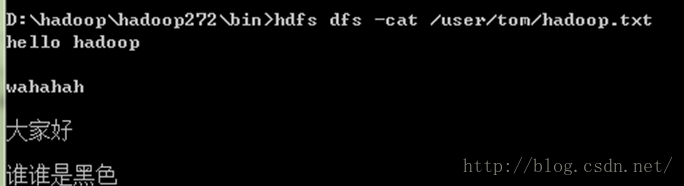

查看input输入的文件内容:

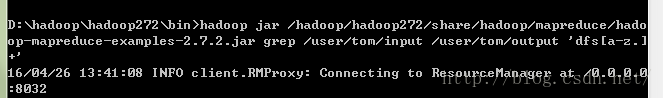

运行hadoop给的examples,做个参考,运行下面命令等待执行完成。hadoop jar jar文件位置 grep 输入目录(包含被处理文件的目录) 输出目录(运行结果输出目录)

然后查看文件夹下多了些东西,就是运行结果输出目录,结果般存在part-r-xxxx里面。

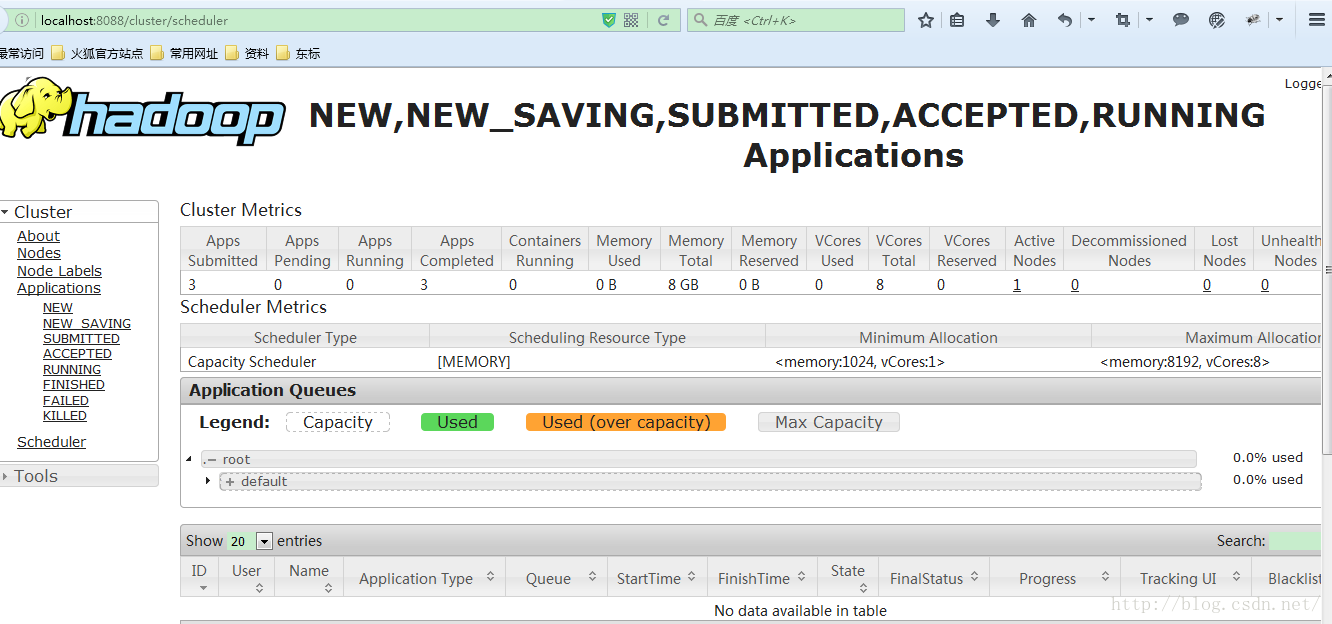

在hadoop/sbin下启动 start-yarn ,访问 http://localhost:8088 可查看 资源、节点管理

参考:https://blog.csdn.net/fly_leopard/article/details/51250443