线性判别分析(Linear Discriminant Analysis, LDA)是一种经典的线性分类方法。

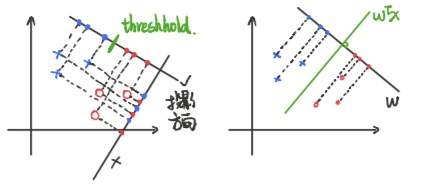

LDA的基本思想:给定训练数据集,设法将样本投影到一条直线上,使得同类样本的投影点尽可能的接近,不同类样本的投影点尽可能远离;在对新来样本进行分类时,首先将其投影到直线上,再根据投影点的位置来判断样本所属的类别。即:类内小,类间大("高内聚,松耦合")

给定数据集,在这里我们将

记为

类,

记为

类,则

,

,

,

,

样本点在直线上的投影:

,此处令

训练样本的均值:

训练样本的方差:

对于 类样本的均值:

对于 类样本的方差:

对于 类样本的均值:

对于 类样本的方差:

类间:,类内:

目标损失函数:

综上可知,

其中,为between-class 类间方差(维度:p*p),

为within-class 类内方差(维度:p*p)

令可得,

两边同时乘以

可得

这里

的维度为p*1,所以

维度[1*p][p*p][p*1],故

, 同理

;

, 这里

的维度为p*1, 则

的维度为[1*p][p*1], 故

如果是单位矩阵或者对角矩阵,各项同性,

,则

完,