abstract

用Variational Autoencoding Wasserstein GAN (VAW-GAN) and cycle-consistent adversarial network (CycleGAN)实现跨语言的vc,保存了src的文本和tar的身份特征。不依赖语言的对齐,也不需要外部的ASR等。对两种语言的数据量要求都很少,而且性能和单语言的差不多。

introduction

GAN网络在图像的风格迁移上有成功的应用。VAW-GAN【28】,CycleGAN【29-31】, StarGAN【32】在vc上也有不错的效果。

之前在cross-lingual任务上的方法有codebook mapping 和 GMM,但是他们需要同一个人同时录制两种语言,这点在实际中很难做到。或者是找两种语言系统的音素或者声学聚类,从而摆脱对平行数据的依赖。

PPGs构建了source和target speaker之间的桥梁,但是它依赖于ASR系统的性能。还可以通过unit selection和迭代帧对齐的方法找到source和target frame pairs的对齐,但是因为不精确的对齐,性能也还有提升的空间。

VAW-GAN用隐向量解释观察结果,而不是学到paired映射函数。CycleGAN用对抗loss和周期一致性loss同时学到前向和反向映射。因此可以学到最佳的伪对。

作者任务的创新点:(1)GAN用于cross-lingual的vc;(2)用VAW-GAN 和 CycleGAN,但是不需要任何的外部处理或者对齐。(3)延伸比较:VAW-GAN 和 CycleGAN在单语种和跨语种的vc。

VAW-GAN

2.1 VC with VAE

VAE有一个encoder(音素识别器),一个decoder(合成器)。但是由于模型简单,合成器精度不高。模型假设是特征在各个维度高斯分布且不相关。这样的假设使得学习目标不完善,从而使得转换的语音不清晰。

【28】提出将GAN加到VAE的decoder中,GAN通常会生成更清晰的谱图,因为它以直接的方式优化两个分布之间的损失函数。【40】在图像生成中做了一个有趣的实验,把VAE的decoder作为GAN的generator。

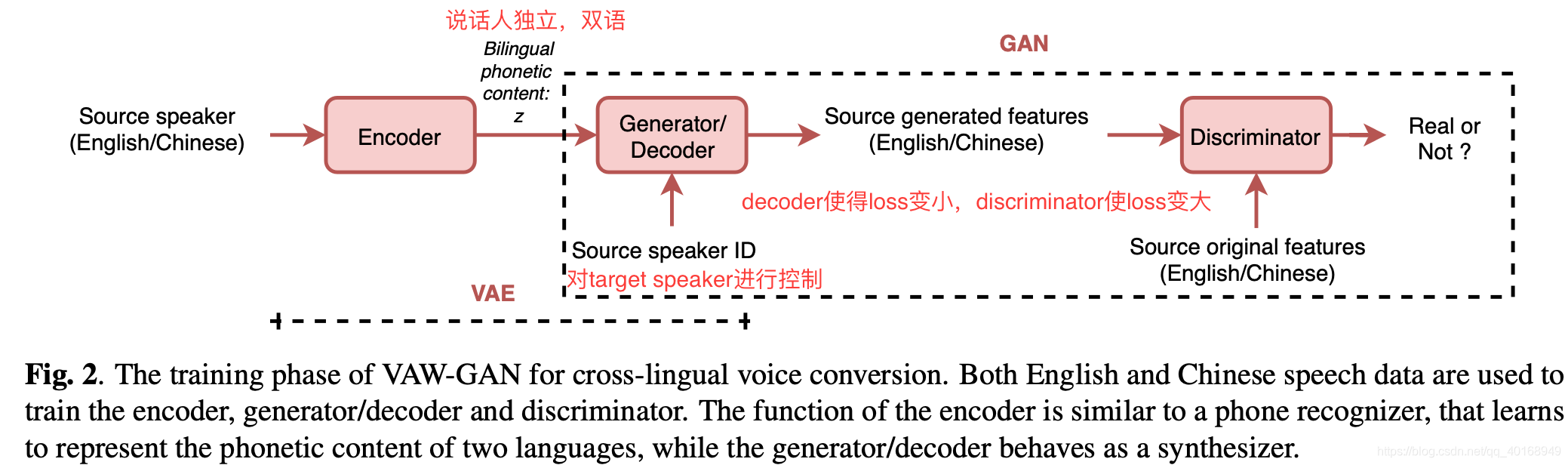

2.2 Cross-lingual Voice Conversion with VAW-GAN

3个结构,都用双语训练,具体功能看图了解。

encoder —音素聚类

3. Cycle-consistent adversarial network for cross-lingual vc

作者认为语音的跨语种转换和image-to-image translation一样,都是找到src域到tar域的映射关系,但是不依赖平行数据。cycle-gan已经在图像转换的几个方面有成功的尝试。(保留图像部分信息,转换一部分,例如horse到zebra。)

3.2. Cross-lingual VC with CycleGAN

把门控CNN加到cycle-gan中。

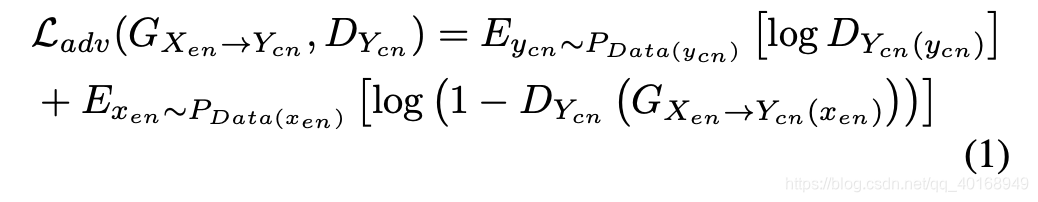

有3个损失函数

-

adversarial loss:相似度越高,loss越小,但是对抗损失只分析src是否向tar的分布进行转换,但是并不保留src的文本特征。

-

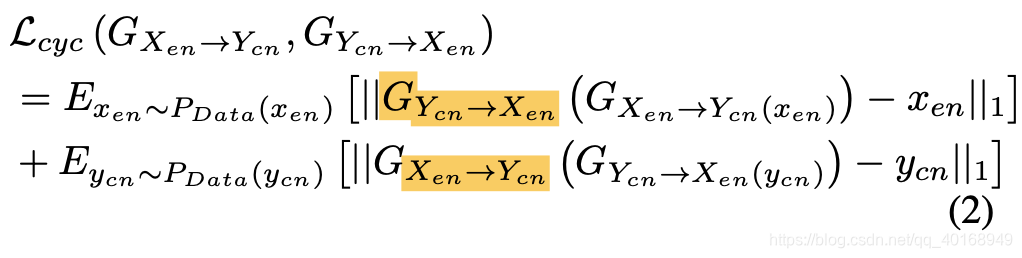

cycle-consistency loss:

-

和 表示了两种语言在相似或者相同的音素信息上的转换,对于跨语种的转换非常重要。

-

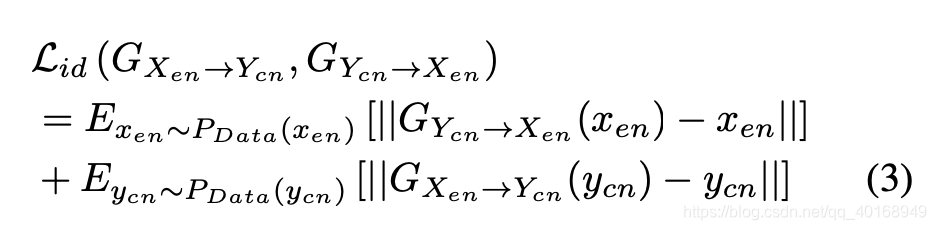

identity-mapping loss

这个损失函数在图像转换中保留了颜色信息,在单语种的vc中保留了语言内容,因此可以相信在跨语种的vc中可以保留rendering of the language identity(语言特征的呈现形式)。