Neural Network

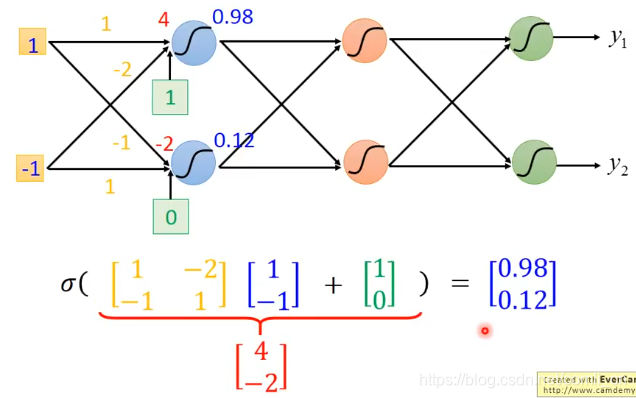

如图所示,下图前端的1和-1为输入层,

和

为输出层,中间的蓝色圆圈、红色圆圈和绿色圆圈为隐藏层。以输入层到第一层隐藏层的计算为例,如果第一层隐藏层的函数为Sigmoid函数,则当以第一层隐藏层作为输入时输入向量的计算如下:

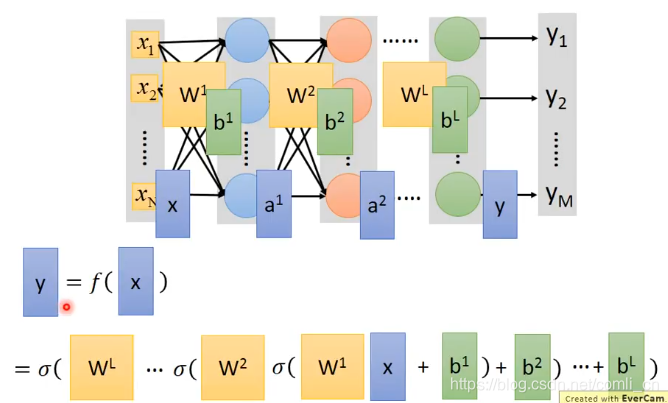

推广到一般情况:

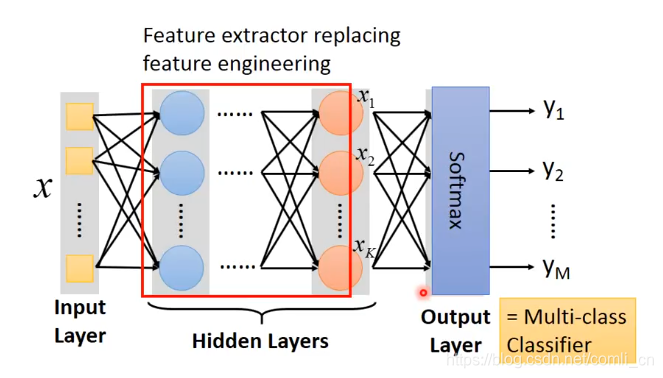

在做多分类时通常会在输出层加上一个Softmax:

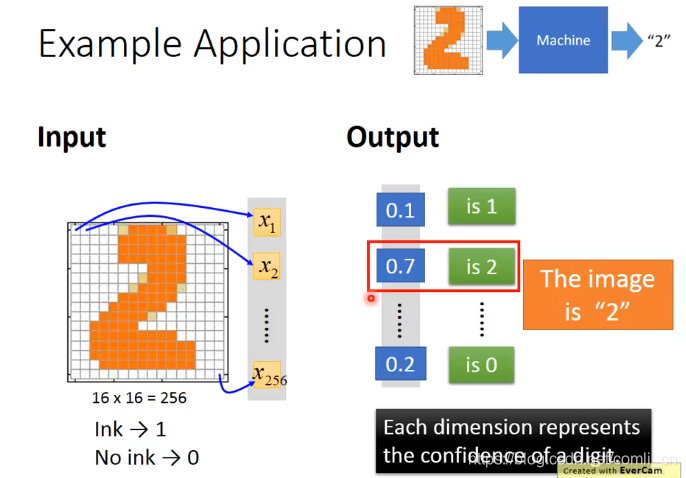

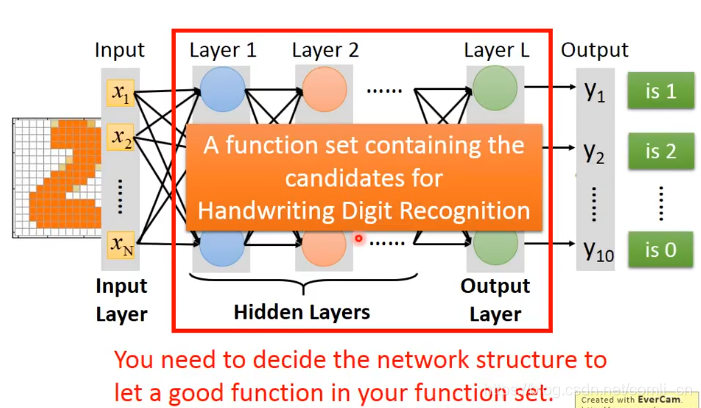

举一个数字识别的例子:

在这样的多层神经网络里面已经限定了输入的维数和输出的维数,我们所需要做的就是设计隐藏层的层数和每一层神经元的个数还有每一层的函数。

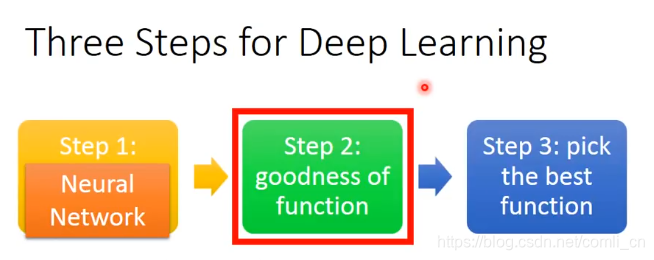

Goodness of function

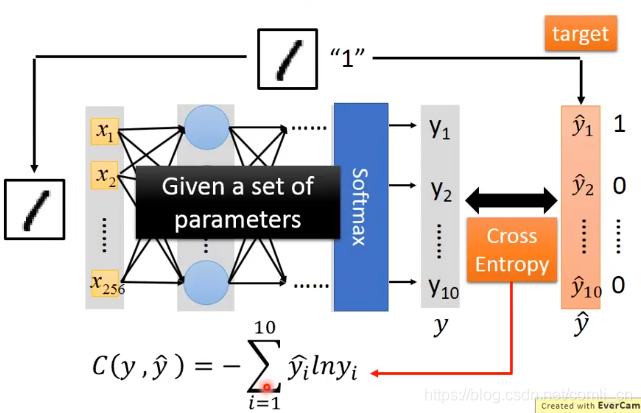

先拿一个训练样本来举例:

Cross Entropy.这里用了交叉熵损失函数来衡量模型的好坏。

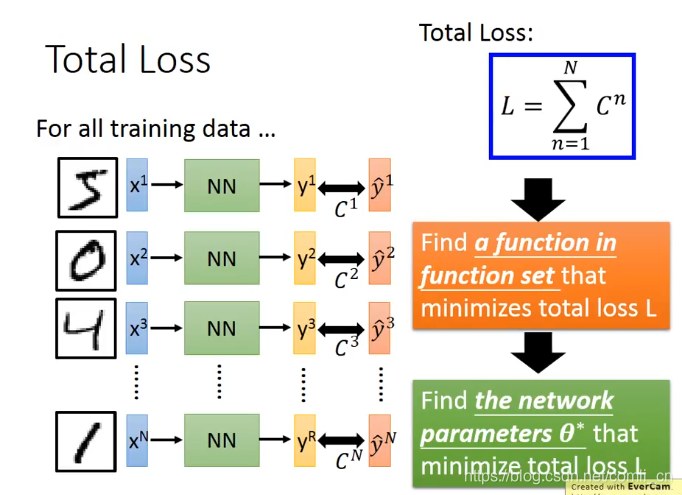

当然真正的训练集肯定不止一个样本:

这时我们就要用整个的损失函数了,对损失函数进行求解找到使损失函数最小化的参数

。

最后用梯度下降的方法来求参数

即可。