讲授线性分类器,分类间隔,线性可分的支持向量机原问题与对偶问题,线性不可分的支持向量机原问题与对偶问题,核映射与核函数,多分类问题,libsvm的使用,实际应用

大纲:

支持向量机简介

线性分类器

分类间隔

线性可分问题

线性可分的对偶问题

线性不可分问题

线性不可分的对偶问题

核映射与核函数

支持向量机简介:

SVM是所有加强学习算法里边,对数学要求比较高的一种算法,主要难在拉格朗日对偶和KKT条件。

由Vapnik等人1995年提出,在出现后的20多年里它是最有影响力的机器学习算法之一,只到2012年它才被深度学习给打败,在1995-2012之间,它和人工神经网络较量中是一直处于上风的。

在深度学习技术出现之前,使用高斯核(RBF)的支持向量机在很多分类问题上一度取得了最好的结果,很多工程上的论文及应用都是用SVM做的。

SVM不仅可以用于分类问题(叫SVC),还可以用于回归问题(叫SVR)。

具有泛化性能好,就是从最大化间隔里边导出的一种算法,推广能力是非常好的,而且适合小样本(样本不需要很多就可以训练出一个很好的模型出来)和高维特征等优点(最后求解的时候,和训练样本数有关,和特征向量维数关系不是特别大)。

线性分类器:

SVM是从线性分类器之中衍生出来的,本质上是最大化间隔线性分类器。

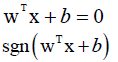

对于n维向量,x∈Rn,线性分类器是以下预测函数: ,解决二分类问题样本标签值为+1或-1。

,解决二分类问题样本标签值为+1或-1。

它是n维空间的一个超平面,超平面的方程只是给出了分界面,哪边为正,哪边为负,是可以灵活控制的,样本带入函数如果大于零判定为+1否则判定为-1,等于零分为+1或-1都行。该超平面只是作为分界面,并没给出哪边大于零哪边小于零,因为超平面方程乘以-1可以随意改变正负分类。方程要写成标准形式kx-y+b=0,不要写成y=kx+b,为标准方程可以表示任意直线或平面,而y=kx+b不能表示与坐标轴垂直的直线。

分类间隔:

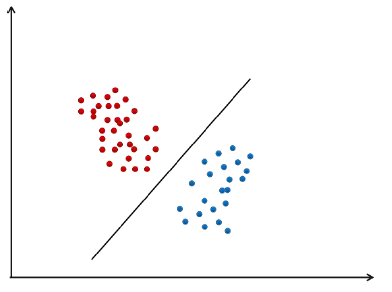

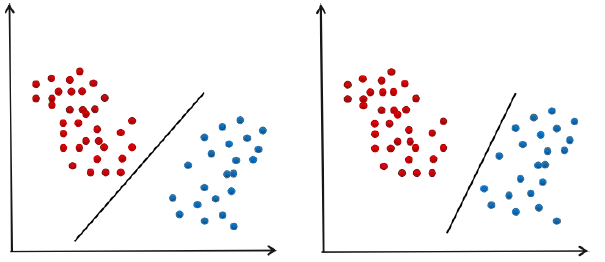

前面说的是二分类问题,对于多分类也是可以的。如果样本集是线性可分的(用线性分类器可以将其分类),一般都存在不止一个可行分类超平面(wT+b=0,w、b是不唯一的)。

对于一个问题,可行的分类器不止一个,哪一个是最好的?

上图1的超平面推广和泛化性能很差, 推广和泛化性能用余量来表示,余量是分类超平面到两边的距离,样本都不止一个,要让距离分类超平面最近的样本距离超平面的距离最大化。

分类平面应该不偏向于任何一类,并且离两个类的样本都尽可能的远。

线性可分问题: