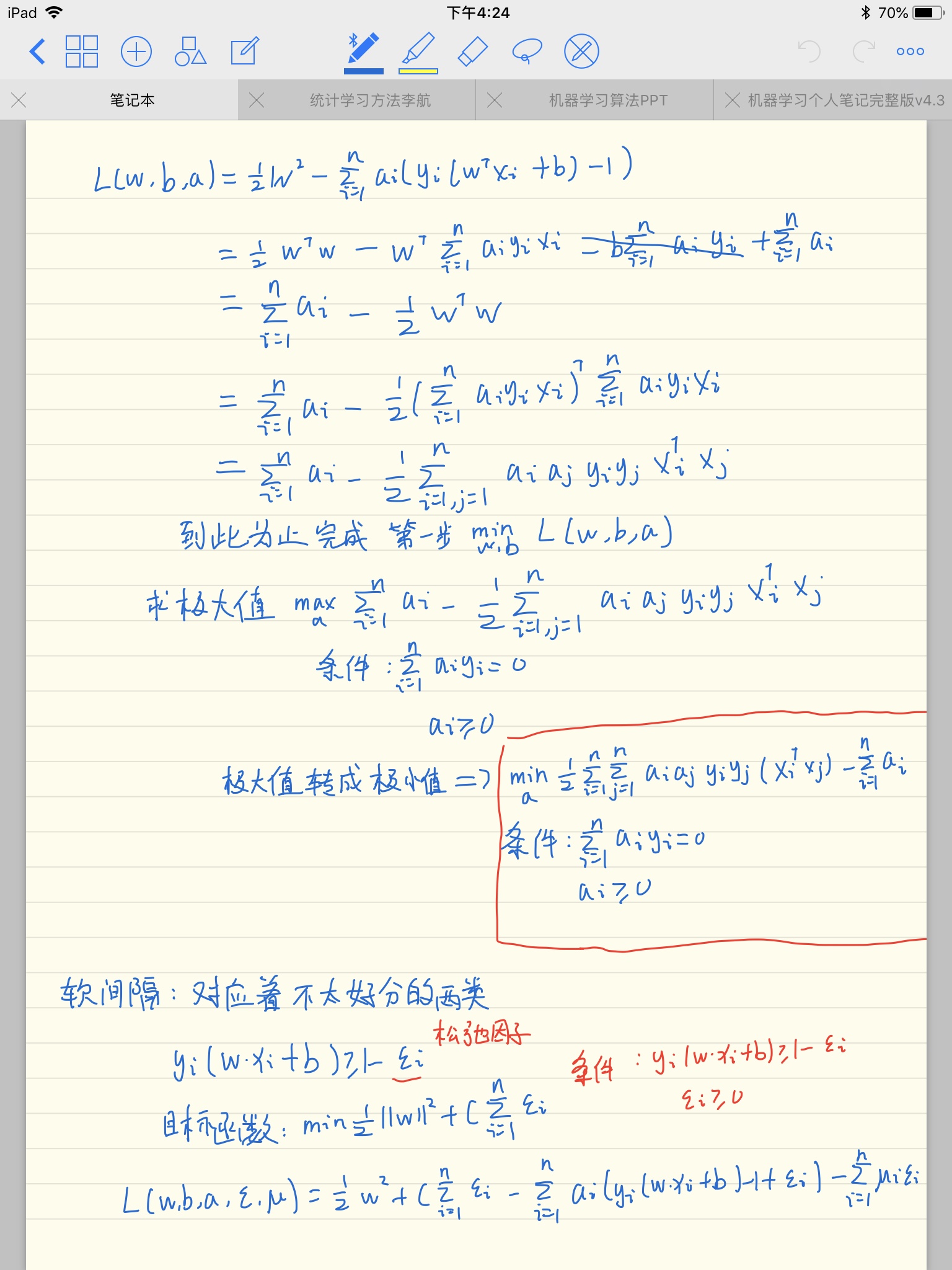

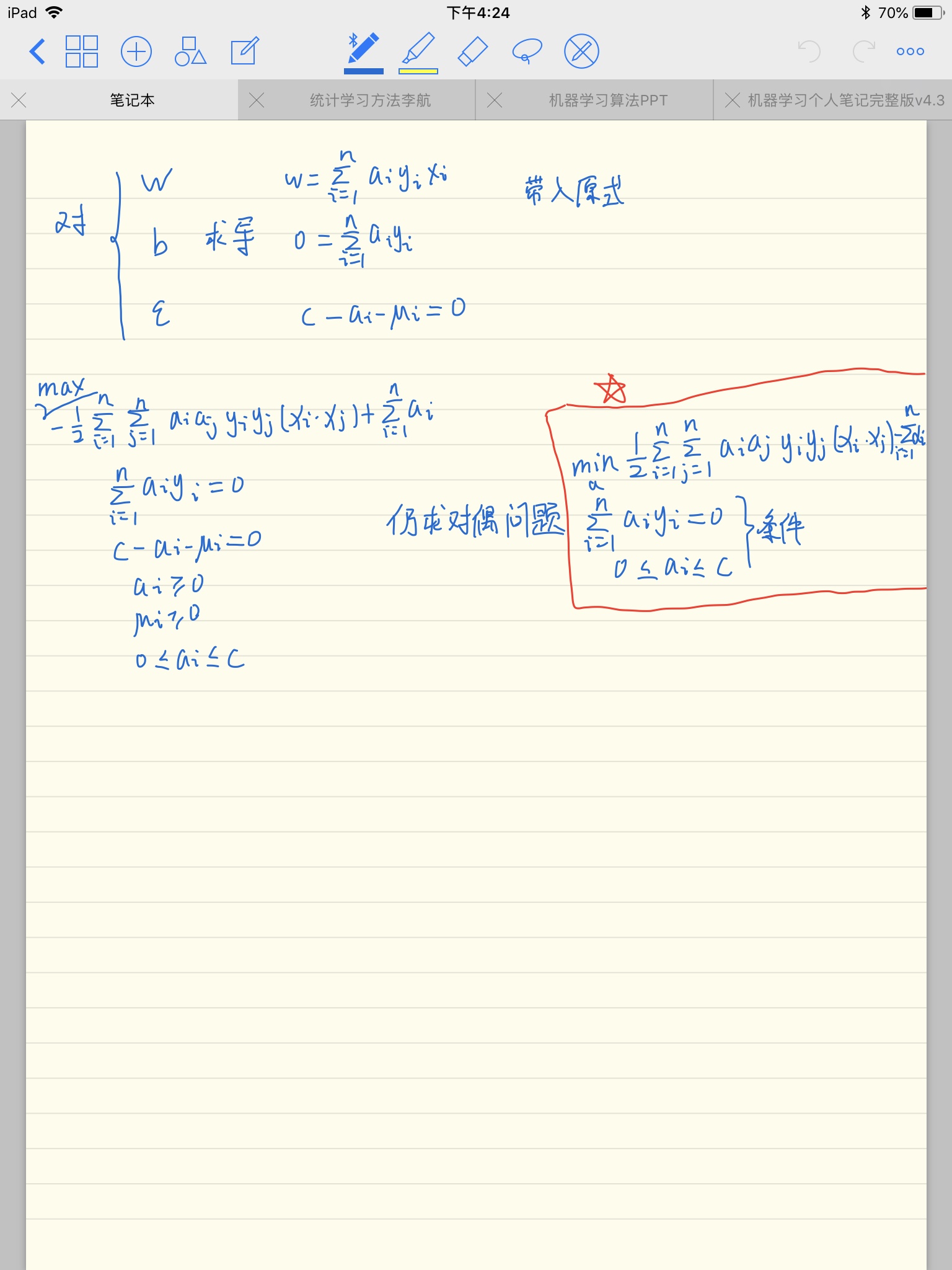

软间隔:

高斯核函数

这里可以粗略理解成:多项式可以实现数据的维度扩增,而高斯核是指数形式,展开就是无穷多的多项式,所以高斯核可以将数据映射到无穷维度

支持向量机以下博客可以:

http://www.cnblogs.com/xingshansi/p/6767980.html

https://blog.csdn.net/mmc2015/article/details/42979523

为什么要用对偶形式

要注意用拉格朗日对偶并没有改变最优解,而是改变了算法复杂度:

在原问题下,求解算法的复杂度与样本维度(等于权值w的维度)有关;

而在对偶问题下,求解算法的复杂度与样本数量(等于拉格朗日算子a的数量)有关。

因此,如果你是做线性分类,且样本维度低于样本数量的话,在原问题下求解就好了,Liblinear之类的线性SVM默认都是这样做的;

但如果你是做非线性分类,那就会涉及到升维(比如使用高斯核做核函数,其实是将样本升到无穷维),升维后的样本维度往往会远大于样本数量,此时显然在对偶问题下求解会更好。

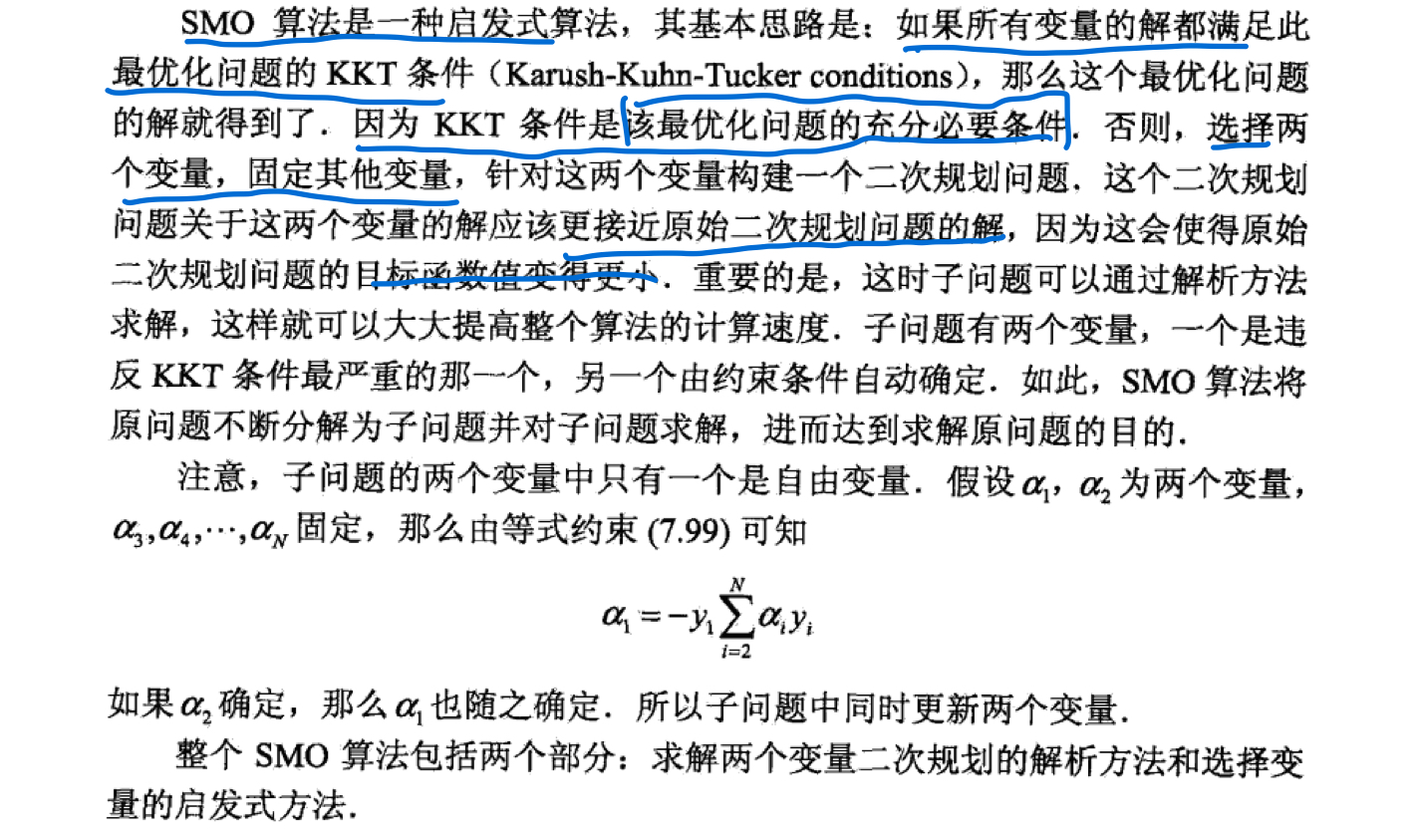

smo算法

kkt条件:

你怎么说