处理丢失的数据

处理丢失的数据 两种丢失的数据 None np.nan(NaN) None是Python自带的,其类型为python object。因此,None不能参与到任何计算中。 np.nan是浮点类型,能参与到计算中。但计算的结果总是NaN。 pandas中None与np.nan都视作np.nan pandas处理空值操作 isnull() notnull() dropna(): 过滤丢失数据 fillna(): 填充丢失数据 ffill bfill 两种补充数据方法 (1)判断函数 isnull() notnull()

import numpy as np import pandas as pd from pandas import Series , DataFrame type(None) type(np.nan) np.nan+1 df=DataFrame(data=np.random.randint(1,100,size=(5,6))) df df.loc[1,2]=None df.loc[3,5]=None df.loc[3,2]=None df.loc[0,2]=None df df.notnull().all(axis=1) # 查看没有空的行 df.loc[df.notnull().all(axis=1)] #过滤df中的空值(只保留没有空值的行) df.dropna(axis=1) df.dropna() 可以选择过滤的是行还是列(默认为行):axis中0表示行,1表示的列 填充函数 Series/DataFrame fillna():value和method参数

数据的清洗

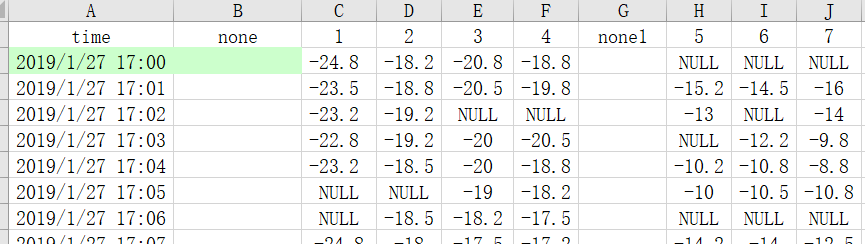

数据说明: 数据是1个冷库的温度数据,1-7对应7个温度采集设备,1分钟采集一次。 数据处理目标: 用1-4对应的4个必须设备,通过建立冷库的温度场关系模型,预估出5-7对应的数据。 最后每个冷库中仅需放置4个设备,取代放置7个设备。 f(1-4) --> y(5-7) 数据处理过程: 1、原始数据中有丢帧现象,需要做预处理; 2、matplotlib 绘图; 3、建立逻辑回归模型。 无标准答案,按个人理解操作即可,请把自己的操作过程以文字形式简单描述一下,谢谢配合。

temp_df=pd.read_excel('测试数据.xlsx') temp_df=temp_df[[1,2,3,4]] temp_df.head() 去空的几种方法 temp_df.dropna(axis=0) #首次填充之后对应的结果 test_df=temp_df.fillna(method='ffill',axis=0) test_df.isnull().any(axis=0) #校验test_df中还是否存在空值:查看列中是否还有空值 test_df.isnull().any(axis=0)

pandas的拼接操作

pandas的拼接分为两种:

- 级联:pd.concat, pd.append

- 合并:pd.merge, pd.join

使用pd.concat()级联

pandas使用pd.concat函数,与np.concatenate函数类似,只是多了一些参数:

objs

axis=0

keys

join='outer' / 'inner':表示的是级联的方式,outer会将所有的项进行级联(忽略匹配和不匹配),而inner只会将匹配的项级联到一起,不匹配的不级联

ignore_index=Falseimport numpy as np import pandas as pd from pandas import DataFrame,Series df1 = DataFrame(data=np.random.randint(0,100,size=(3,4)),index=['A','B','C'],columns=['a','b','c','d']) df2 = DataFrame(data=np.random.randint(0,100,size=(3,4)),index=['A','D','C'],columns=['a','b','e','d']) display(df1,df2) pd.concat((df1,df1),axis=0,join='outer') pd.concat((df1,df1,df1),axis=1,join='inner')

pd.concat((df1,df2),axis=0,join='inner')

# pd.concat((df1,df2),axis=1,join='outer')

不匹配级联

不匹配指的是级联的维度的索引不一致。例如纵向级联时列索引不一致,横向级联时行索引不一致

有2种连接方式:

- 外连接:补NaN(默认模式)

- 内连接:只连接匹配的项

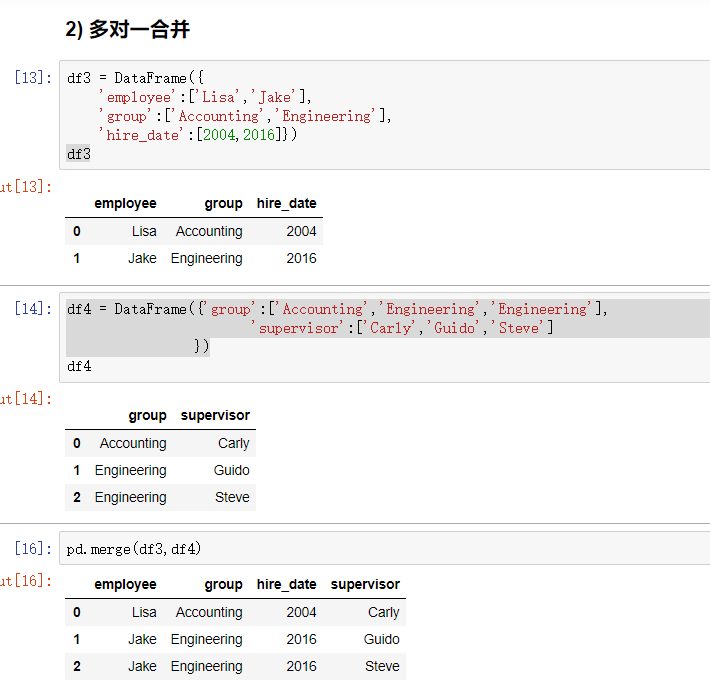

使用pd.merge()合并

merge与concat的区别在于,merge需要依据某一共同的列来进行合并

使用pd.merge()合并时,会自动根据两者相同column名称的那一列,作为key来进行合并。

注意每一列元素的顺序不要求一致

参数:

- how:out取并集 inner取交集

- on:当有多列相同的时候,可以使用on来指定使用那一列进行合并,on的值为一个列表

一对一合并 df1 = DataFrame({'employee':['Bob','Jake','Lisa'], 'group':['Accounting','Engineering','Engineering'], }) df2 = DataFrame({'employee':['Lisa','Bob','Jake'], 'hire_date':[2004,2008,2012], }) display(df1,df2) pd.merge(df1,df2)

key的规范化

- 当列冲突时,即有多个列名称相同时,需要使用on=来指定哪一个列作为key,配合suffixes指定冲突列名

- 当两张表没有可进行连接的列时,可使用left_on和right_on手动指定merge中左右两边的哪一列列作为连接的列

内合并与外合并:out取并集 inner取交集

- 内合并:只保留两者都有的key(默认模式)

- 外合并 how='outer':补NaN