CNN

第一周:

title: edge detection example

卷积核在边缘检测中的应用,可解释,卷积核的设计可以找到像素列突变的位置

把人为选择的卷积核参数,改为学习参数,可以学到更多的特征

title: padding

n * n图片,k*k卷积核,输出图片是( n - k + 1) * ( n - k + 1)

padding补零,保持图像尺寸

title: Strided Convolutions

步长可调

信号处理的卷积,要先把卷积核沿两个轴反转,神经网络里面所称的卷积没有这一步,实际上是卷积核和信号的互相关,

反转使卷积运算保持了结合律的特性

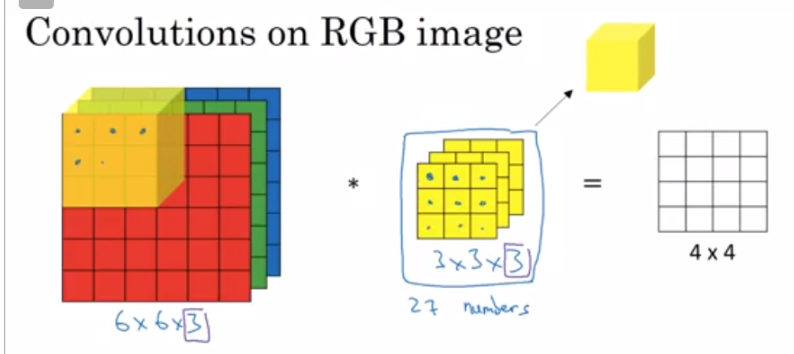

title: Convolutions Over Volume

对于三维的信号,卷积核也要三维

三维的在对应位置相乘

存在多个卷积核的时候,就把结果叠在一起(假如维度一样,同一层应该是必须一样的

title:One Layer of a Convolutional Network

可以加bias,加非线性函数relu之类的

cnn的参数个数和卷积核的大小以及数量有关,但是和图像大小无关,能控制参数的多少

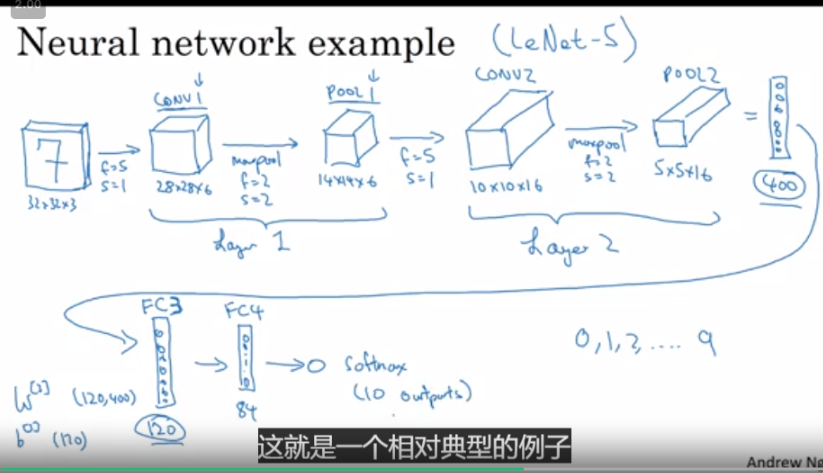

title:Simple Convolutional Network Example

注意到一层的输出的深度,和这层的卷积核的数量有关,卷积核越多,深度越大,最后如果没有padding,我们的图像在长宽会变小,在深度(厚度)会很深

在cnn层之后会有池化层,全连接层,如果是分类问题

title: Pooling Layers

max pooling, 用区域里的最大值,代表这块区域,相当于把矩阵的尺寸压缩了,有参数f,所划分的最小块区域的大小,stride,移动步长

pooling的解释还挺强行的吧,算了算了

pooling有超参数,没有学习参数

average pooling, 区域里的平均值

一般卷积层后面都跟着池化层

title: why cnn

cnn的优势:

参数共享,一个卷积核里的参数应用到了所有的像素(信号)上

稀疏性

转载于:https://www.cnblogs.com/zherlock/p/11033189.html