Hadoop

HDFS

1.基于HDFS的云盘系统设计与实现:

1 系统基本功能模块设计

HDFS是一个高度容错性的系统, 它是运行在通用硬件上的分布式文件系统, 适合部署在廉价的机器上。HDFS能提供高吞吐量的数据访问, 采用“一次写入、多次读取”模式

http://kns.cnki.net/KXReader/Detail?TIMESTAMP=636879294442728750&DBCODE=CJFD&TABLEName=CJFDLAST2019&FileName=DNZS201836031&RESULT=1&SIGN=eZD6EcHv5%2BvDLvpTbtBtVl2ZgBA%3D&UID=WEEvREcwSlJHSldRa1Fhb09jT0pkRlh4REdUbUJGYlJFaVZFMFVoS29XUT0=$9A4hF_YAuvQ5obgVAqNKPCYcEjKensW4IQMovwHtwkF4VYPoHbKxJw!!&filetitle=%E5%9F%BA%E4%BA%8EHDFS%E7%9A%84%E4%BA%91%E7%9B%98%E7%B3%BB%E7%BB%9F%E8%AE%BE%E8%AE%A1%E4%B8%8E%E5%AE%9E%E7%8E%B0_%E6%B1%A4%E6%B5%B7%E6%9E%97

MapReduce

https://baike.baidu.com/item/MapReduce

MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算。概念"Map(映射)“和"Reduce(归约)”,是它们的主要思想,都是从函数式编程语言里借来的,还有从矢量编程语言里借来的特性。它极大地方便了编程人员在不会分布式并行编程的情况下,将自己的程序运行在分布式系统上。 当前的软件实现是指定一个Map(映射)函数,用来把一组键值对映射成一组新的键值对,指定并发的Reduce(归约)函数,用来保证所有映射的键值对中的每一个共享相同的键组。

1)MapReduce是一个基于集群的高性能并行计算平台(Cluster Infrastructure)。它允许用市场上普通的商用服务器构成一个包含数十、数百至数千个节点的分布和并行计算集群。

2)MapReduce是一个并行计算与运行软件框架(Software Framework)。它提供了一个庞大但设计精良的并行计算软件框架,能自动完成计算任务的并行化处理,自动划分计算数据和计算任务,在集群节点上自动分配和执行任务以及收集计算结果,将数据分布存储、数据通信、容错处理等并行计算涉及到的很多系统底层的复杂细节交由系统负责处理,大大减少了软件开发人员的负担。

3)MapReduce是一个并行程序设计模型与方法(Programming Model & Methodology)。它借助于函数式程序设计语言Lisp的设计思想,提供了一种简便的并行程序设计方法,用Map和Reduce两个函数编程实现基本的并行计算任务,提供了抽象的操作和并行编程接口,以简单方便地完成大规模数据的编程和计算处理

浅谈MapReduce与网络信息搜索

MapReduce以其高超的计算方式, 能够对大量的数据进行处理。现如今每天上亿条数据的搜索, 若要查出某一时间段中的数据访问量最大, 只用人工来实现似乎不是很理想, 相比于计算机人们对于重复性的工作[…]

摘自:浅谈MapReduce与网络信息搜索

http://kns.cnki.net/KXReader/Detail?TIMESTAMP=636879303259291250&DBCODE=CJFD&TABLEName=CJFDLAST2019&FileName=NFLJ201903124&RESULT=1&SIGN=e36NoyrSujVl93SonMgRG2AVjCc%3D&UID=WEEvREcwSlJHSldRa1Fhb09jT0pkRlh4REdUbUJGYlJFaVZFMFVoS29XUT0=$9A4hF_YAuvQ5obgVAqNKPCYcEjKensW4IQMovwHtwkF4VYPoHbKxJw!!&filetitle=%e6%b5%85%e8%b0%88MapReduce%e4%b8%8e%e7%bd%91%e7%bb%9c%e4%bf%a1%e6%81%af%e6%90%9c%e7%b4%a2_%e6%9d%9c%e6%98%95%e5%a8%89

面向MapReduce计算的大规模集群通信优化

http://kns.cnki.net/KCMS/detail/detail.aspx?QueryID=4&CurRec=9&recid=&FileName=JSYJ2019012300P&DbName=CAPJLAST&DbCode=CJFQ&yx=Y&pr=&URLID=51.1196.TP.20190124.0904.022

基于MapReduce模型带准备时间的平行机调度优化

http://kns.cnki.net/KCMS/detail/detail.aspx?QueryID=4&CurRec=10&recid=&FileName=XTLL201901014&DbName=CJFDTEMP&DbCode=CJFQ&yx=&pr=&URLID=

基于MapReduce的多样本基因鉴定并行优化模型

http://kns.cnki.net/KCMS/detail/detail.aspx?QueryID=4&CurRec=11&recid=&FileName=XDJS201903004&DbName=CJFDTEMP&DbCode=CJFQ&yx=&pr=&URLID=

HBase

https://baike.baidu.com/item/HBase/7670213?fr=aladdin

HBase – Hadoop Database,是一个高可靠性、高性能、面向列、可伸缩的分布式存储系统,利用HBase技术可在廉价PC Server上搭建起大规模结构化存储集群。

与FUJITSU Cliq等商用大数据产品不同,HBase是Google Bigtable的开源实现,类似Google Bigtable利用GFS作为其文件存储系统,HBase利用Hadoop HDFS作为其文件存储系统;Google运行MapReduce来处理Bigtable中的海量数据,HBase同样利用Hadoop MapReduce来处理HBase中的海量数据;Google Bigtable利用 Chubby作为协同服务,HBase利用Zookeeper作为对应。 [1]

上图描述Hadoop EcoSystem中的各层系统。其中,HBase位于结构化存储层,Hadoop HDFS为HBase提供了高可靠性的底层存储支持,Hadoop MapReduce为HBase提供了高性能的计算能力,Zookeeper为HBase提供了稳定服务和failover机制。

此外,Pig和Hive还为HBase提供了高层语言支持,使得在HBase上进行数据统计处理变的非常简单。 Sqoop则为HBase提供了方便的RDBMS数据导入功能,使得传统数据库数据向HBase中迁移变的非常方便。

基于HBase的海量冠字号码多维索引研究

整体框架如图1所示, 整个系统由数据导入模块、HBase分布式数据库模块、索引模块以及查询模块构成。数据导入模块负责将银行网点随时产生的数据导入到云存储空间的HBase中;HBase分布式数据库模块负[…]

http://kns.cnki.net/KXReader/Detail?TIMESTAMP=636879308223822500&DBCODE=CJFD&TABLEName=CJFDLAST2019&FileName=JSSG201901041&RESULT=1&SIGN=jTEmLoS8ySnQnGRtGvgMGuPq3ko%3D&UID=WEEvREcwSlJHSldRa1Fhb09jT0pkRlh4REdUbUJGYlJFaVZFMFVoS29XUT0=$9A4hF_YAuvQ5obgVAqNKPCYcEjKensW4IQMovwHtwkF4VYPoHbKxJw!!&filetitle=%e5%9f%ba%e4%ba%8eHBase%e7%9a%84%e6%b5%b7%e9%87%8f%e5%86%a0%e5%ad%97%e5%8f%b7%e7%a0%81%e5%a4%9a%e7%bb%b4%e7%b4%a2%e5%bc%95%e7%a0%94%e7%a9%b6_%e5%bc%a0%e8%89%ba

基于协处理器的HBase二级索引方法

4.1 HBase二级索引构建

在构建索引时,将索引视为普通数据存放在数据表中,通过给主数据的rowkey添加基于Region的startKey和endKey的Hash值,称为hashRowkey,使[…]

http://kns.cnki.net/KXReader/Detail?TIMESTAMP=636879312337103750&DBCODE=CJFD&TABLEName=CAPJLAST&FileName=JSGG20181217004&RESULT=1&SIGN=Sb4k5UkzWcffm1U5%2FIjOBw2rHKQ%3D&UID=WEEvREcwSlJHSldRa1Fhb09jT0pkRlh4REdUbUJGYlJFaVZFMFVoS29XUT0=$9A4hF_YAuvQ5obgVAqNKPCYcEjKensW4IQMovwHtwkF4VYPoHbKxJw!!&filetitle=%e5%9f%ba%e4%ba%8e%e5%8d%8f%e5%a4%84%e7%90%86%e5%99%a8%e7%9a%84HBase%e4%ba%8c%e7%ba%a7%e7%b4%a2%e5%bc%95%e6%96%b9%e6%b3%95_%e9%83%ad%e7%ba%a2

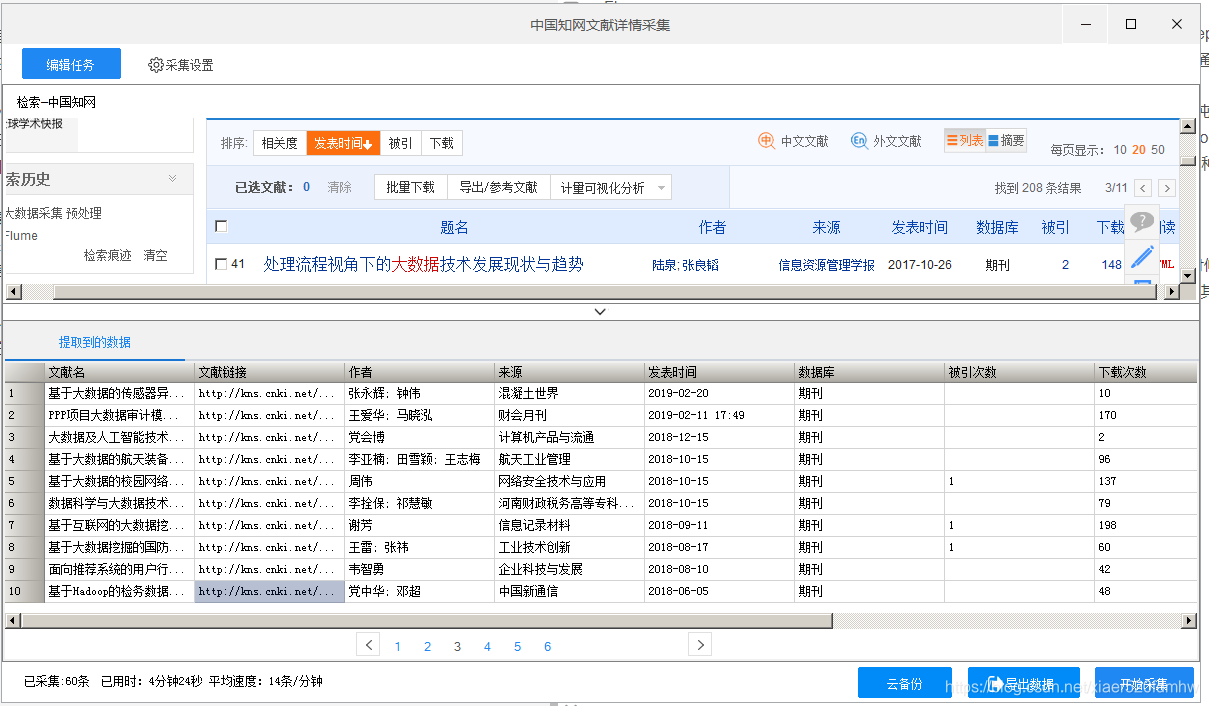

大数据采集

基于互联网的大数据挖掘关键技术分析

计算机、互联网的迅速发展, 推动着海量异构数据的产生, 海量异构数据有着类型多、数量大、处理速度快、价值密度低的特点, 要求在秒级时间内完成数据分析、得到数据分析结果。若是海量异构数据的处理时间过长,[…]

摘自:基于互联网的大数据挖掘关键技术分析

http://kns.cnki.net/KXReader/Detail?TIMESTAMP=636879328381635000&DBCODE=CJFD&TABLEName=CJFDLAST2018&FileName=CXJL201810059&RESULT=1&SIGN=6wk48be%2Fl7pMMgbOSYJoDNXaSmc%3D&UID=WEEvREcwSlJHSldRa1Fhb09jT0pkRlh4REdUbUJGYlJFaVZFMFVoS29XUT0=$9A4hF_YAuvQ5obgVAqNKPCYcEjKensW4IQMovwHtwkF4VYPoHbKxJw!!&filetitle=%e5%9f%ba%e4%ba%8e%e4%ba%92%e8%81%94%e7%bd%91%e7%9a%84%e5%a4%a7%e6%95%b0%e6%8d%ae%e6%8c%96%e6%8e%98%e5%85%b3%e9%94%ae%e6%8a%80%e6%9c%af%e5%88%86%e6%9e%90_%e8%b0%a2%e8%8a%b3

基于Hadoop的检务数据分析平台设计

通过整合案件信息、队伍信息和其他检察业务信息资源, 全面整合检察业务应用系统, 构建全方位对接检察业务管理、检察人事管理、检察行政管理和检察院其他管理工作需求的“智慧检务大数据平台”, 及时准确呈现检[…]

摘自:基于Hadoop的检务数据分析平台设计

http://kns.cnki.net/KXReader/Detail?TIMESTAMP=636879329122885000&DBCODE=CJFD&TABLEName=CJFDLAST2018&FileName=TXWL201811056&RESULT=1&SIGN=BigJiA%2FjL6Ga8Fcvuq28xg9Fwb8%3D&UID=WEEvREcwSlJHSldRa1Fhb09jT0pkRlh4REdUbUJGYlJFaVZFMFVoS29XUT0=$9A4hF_YAuvQ5obgVAqNKPCYcEjKensW4IQMovwHtwkF4VYPoHbKxJw!!&filetitle=%e5%9f%ba%e4%ba%8eHadoop%e7%9a%84%e6%a3%80%e5%8a%a1%e6%95%b0%e6%8d%ae%e5%88%86%e6%9e%90%e5%b9%b3%e5%8f%b0%e8%ae%be%e8%ae%a1_%e5%85%9a%e4%b8%ad%e5%8d%8e

Flume

Flume-og采用了多Master的方式。为了保证配置数据的一致性,Flume引入了ZooKeeper,用于保存配置数据,ZooKeeper本身可保证配置数据的一致性和高可用,另外,在配置数据发生变化时,ZooKeeper可以通知Flume Master节点。Flume Master间使用gossip协议同步数据。

Flume-ng最明显的改动就是取消了集中管理配置的 Master 和 Zookeeper,变为一个纯粹的传输工具。Flume-ng另一个主要的不同点是读入数据和写出数据现在由不同的工作线程处理(称为 Runner)。 在 Flume-og 中,读入线程同样做写出工作(除了故障重试)。如果写出慢的话(不是完全失败),它将阻塞 Flume 接收数据的能力。这种异步的设计使读入线程可以顺畅的工作而无需关注下游的任何问题。

- Flume可以将应用产生的数据存储到任何集中存储器中,比如HDFS,HBase

- 当收集数据的速度超过将写入数据的时候,也就是当收集信息遇到峰值时,这时候收集的信息非常大,甚至超过了系统的写入数据能力,这时候,Flume会在数据生产者和数据收容器间做出调整,保证其能够在两者之间提供平稳的数据.

- 提供上下文路由特征

- Flume的管道是基于事务,保证了数据在传送和接收时的一致性.

- Flume是可靠的,容错性高的,可升级的,易管理的,并且可定制的。