基础知识:

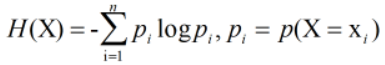

1、随机变量的熵的定义:

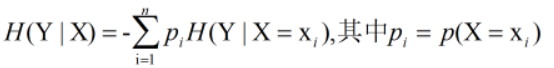

2、随机变量X给定条件下随机变量Y的条件熵H(Y|X),定义为X给定条件下Y的条件概率分布的熵对X的数学期望:

其中计算H(Y|X=Xi)=求和P(Xi|X)*H(Di)

3、信息增益表示得知特征X的信息而使得类Y的信息的不确定性减少的程度,信息增益的用g(D,A),定义为集合D的经验熵H(D)与特征A给定条件下D的经验条件熵H(D|A)之差,即![]()

4、决策树节点分裂时按照信息增益最小的原则来选择特征

代码:

number_feature = len(dataset[0]) - 1

base_shannoent = shannon_Ent.calc_shannon(dataset)

bestinfogain=0.0; bestfeature = -1

for i in number_feature:

fearlist = [example[i] for example in dataset]

uniquevals =set(fearlist)

new_entropy = 0.0

for value in uniquevals:

subdataset = splitDatase.split_dataset(dataset,i,value)

prob = len(subdataset)/float(len(dataset))

new_entropy += prob*shannon_Ent.calc_shannon(subdataset)

infogain = base_shannoent - new_entropy

if( infoGain > bestinfogain):

bestinfogain = infoGain

bestfeature = i其中,用A表示特征的话, i表示的是集合dataset中的第i个特征(Ai),uniquevals代表的是第i个特征(Ai)的所有取值(Ai=Aii)

for value in uniquevals内的代码;

1\先将集合D按照特征Ai的取值Aii划分成不同的子集合Di,

2\再计算p(Aii|Ai)

3\再计算p(Aii|Ai)*H(Yi),再对p(Aii|Ai)*H(Di)求和,得到H(D|Ai)

之后执行H(D)-H(D|Ai)得到g(D,Ai)

最后比较i为何值时g(D,Ai)最大,得到最优特征