版权声明:本文为博主原创文章,未经博主允许不得转载。

欢迎访问:https://blog.csdn.net/qq_21439395/article/details/83591020

交流QQ: 824203453

常驻进程:Master进程 Worker进程

当我们提交spark任务的时候(spark-shell ,spark-submit)

会生成了一个Applications,默认会占用所有Worker的cores,每一个默认占用了1g内存。

可在启动时指定参数。

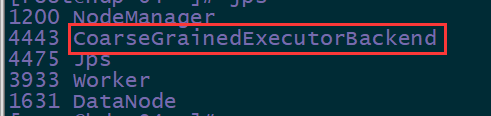

通过jps命令,可以查看到

在执行spark-submit的节点上,有spark-submit(dirver)进程,

在任务执行的节点上(worker节点上),有 CoarseGrainedExecutorBackend(executor) 进程。

然后,当我们的任务执行完毕之后,这两个进程都会退出了。

这一个超长的进程通常叫做Executor,被worker进程启动。真正负责任务的运行。

提交任务的节点,通常称为Dirver

当执行spark-shell时,会携带参数,并向master发送任务请求,master在接收到请求之后,会根据客户端需要的任务资源,选择出合适的Worker节点,然后向worker发送任务指令,接收到任务之后,worker会启动一个executor进程,

executor启动后,会等待分配计算任务,那然后呢,executor会向driver通信,

当有driver任务要执行时,任务就会分发到executor上, 然后并行执行。

版权声明:本文为博主原创文章,未经博主允许不得转载。

欢迎访问:https://blog.csdn.net/qq_21439395/article/details/83591020

交流QQ: 824203453