Hadoop2.X HA搭建

四台机器:hadoop1,hadoop2,hadoop3,hadoop4

NN |

DN |

ZK |

ZKFC |

JN |

RM |

NM(任务管理) |

|

Hadoop1 |

Y |

Y |

Y |

||||

Hadoop2 |

Y |

Y |

Y |

Y |

Y |

Y |

Y |

Hadoop3 |

Y |

Y |

Y |

Y |

|||

Hadoop4 |

Y |

Y |

Y |

0. Hadoop-env.sh

配置jdk

1. core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://Jackie</value>

</property>

<property>

<name>ha.zookeeper.quorum</name>

<value>hadoop1:2181,hadoop2:2181,hadoop3:2181</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop</value>

</property>

</configuration>

2. hdfs-site.xml

<configuration>

<property>

<name>dfs.nameservices</name>

<value>Jackie</value>

</property>

<property>

<name>dfs.ha.namenodes.Jackie</name>

<value>nn1,nn2</value>

</property>

<property>

<name>dfs.namenode.rpc-address.Jackie.nn1</name>

<value>hadoop1:8020</value>

</property>

<property>

<name>dfs.namenode.rpc-address.Jackie.nn2</name>

<value>hadoop2:8020</value>

</property>

<property>

<name>dfs.namenode.http-address.Jackie.nn1</name>

<value>hadoop1:50070</value>

</property>

<property>

<name>dfs.namenode.http-address.Jackie.nn2</name>

<value>hadoop2:50070</value>

</property>

<property>

<!-- 指定namenode元数据存储在journalnode中的路径 -->

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://hadoop2:8485;hadoop3:8485;hadoop4:8485/Jackie</value>

</property>

<property>

<!-- 指定HDFS客户端连接active namenode的java类 -->

<name>dfs.client.failover.proxy.provider.Jackie</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<property>

<!-- 配置隔离机制为ssh 防止脑裂 -->

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property>

<property>

<!-- 指定秘钥的位置 -->

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/root/.ssh/id_dsa</value>

</property>

<property>

<!-- 指定journalnode日志文件存储的路径 -->

<name>dfs.journalnode.edits.dir</name>

<value>/opt/hadoop/data</value>

</property>

<property>

<!-- 开启自动故障转移 -->

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

</configuration>

3. 配置hadoop中的slaves

4. 准备zookeeper

a) 三台zookeeper:hadoop1,hadoop2,hadoop3

b) 编辑zoo.cfg配置文件

i. 修改dataDir=/opt/zookeeper

ii. server.1=node01:2888:3888

server.2=node02:2888:3888

server.3=node03:2888:3888

c) 在dataDir目录中创建一个myid的文件,文件内容分别为1,2,3

5. 发送其他节点服务器 环境变量配置

----------------------------------------------------------------------

6. 启动三个zookeeper:./zkServer.sh start

7. 启动三个JournalNode:./hadoop-daemon.sh start journalnode

8. 在其中一个namenode上格式化:hdfs namenode -format

9. 把刚刚格式化之后的元数据拷贝到另外一个namenode上

a) 启动刚刚格式化的namenode : hadoop-daemon.sh start namenode

b) 在没有格式化的namenode上执行:hdfs namenode -bootstrapStandby

c) 启动第二个namenode hadoop-daemon.shstart namenode

10. 在其中一个namenode上初始化zkfc:hdfs zkfc -formatZK

11. 停止上面节点:stop-dfs.sh

12. 全面启动:start-dfs.sh

13. yarn-daemon.sh start resourcemanager (yarn resourcemanager )

有可能会出错的地方

1, 确认每台机器防火墙均关掉

2, 确认每台机器的时间是一致的

3, 确认配置文件无误,并且确认每台机器上面的配置文件一样

4, 如果还有问题想重新格式化,那么先把所有节点的进程关掉,killjavaall

5, 删除之前格式化的数据目录hadoop.tmp.dir属性对应的目录,所有节点同步都删掉,别单删掉之前的一个,删掉三台JN节点中dfs.journalnode.edits.dir属性所对应的目录

6, 接上面的第6步又可以重新格式化已经启动了

7, 最终Active Namenode停掉的时候,StandBy可以自动接管!

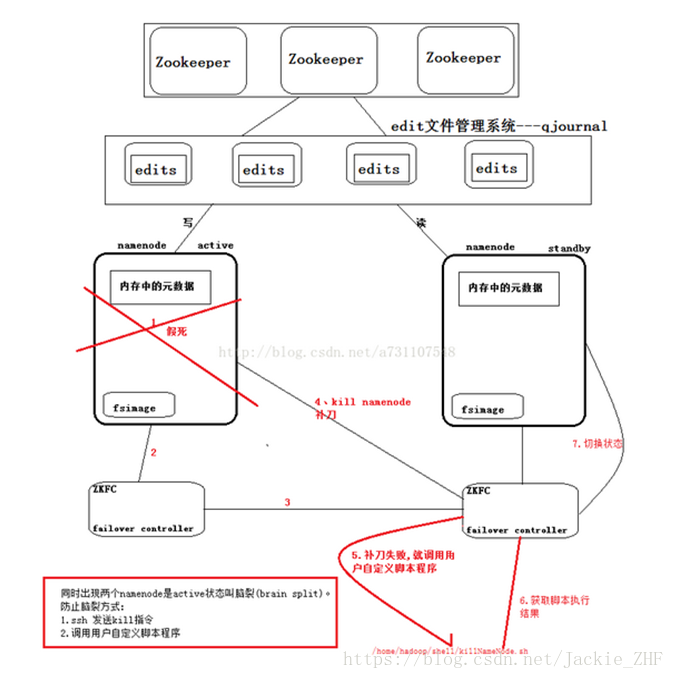

(1)脑裂(brain-split):脑裂是指在主备切换时,由于切换不彻底或其他原因,导致客户端和Slave误以为出现两个active master,最终使得整个集群处于混乱状态。解决脑裂问题,通常采用隔离(Fencing)机制,包括三个方面:

- 共享存储fencing:确保只有一个Master往共享存储中写数据。

- 客户端fencing:确保只有一个Master可以响应客户端的请求。

- Slave fencing:确保只有一个Master可以向Slave下发命令。

Hadoop公共库中对外提供了两种fenching实现,分别是sshfence和shellfence(缺省实现),其中sshfence是指通过ssh登陆目标Master节点上,使用命令fuser将进程杀死(通过tcp端口号定位进程pid,该方法比jps命令更准确),shellfence是指执行一个用户事先定义的shell命令(脚本)完成隔离。