注:

1.环境为linux CentOS release 6.6 (Final),非虚拟机。

2.Hadoop版本2.8.3

3.JDK版本1.8.0_111

4.Hadoop的搭建分为三种形式:单机模式、伪分布模式、完全分布模式,本文为伪分布模式。

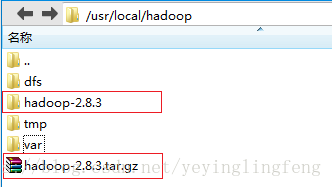

1.首先下载Hadoop2.8.3

下载后将文件解压

tar -xvf hadoop-2.8.3.tar.gz如下。

2.相关文件配置

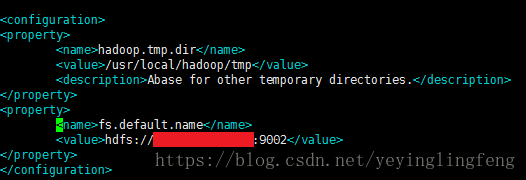

配置core-site.xml (路径Hadoop根目录/etc/hadoop)

vim core-site.xml

i 开始编辑

...

ESC 退出编辑模式

shift+q

x

回车 结束编辑修改为如下形式,同时新建/usr/local/hadoop/tmp 文件夹。

hdfs://xx.xx.xx.xx:9002 的ip为服务器ip,或者可以改成任意的字符串,例如

hdfs://test1:9002 。因为我用的服务器上9000端口被占用所以用了9002,自己配置时可以用9000。

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://xx.xx.xx.xx:9002</value>

</property>

</configuration>

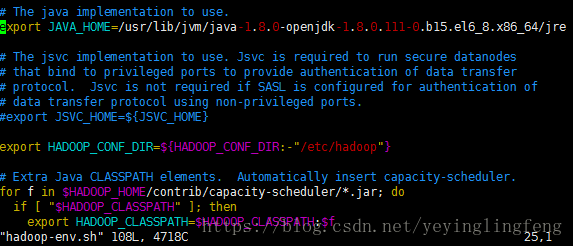

配置hadoop-env.sh (路径Hadoop根目录/etc/hadoop)

修改如下,将JAVA_HOME改为自己的JDK路径。

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.111-0.b15.el6_8.x86_64/jre配置hdfs-site.xml (路径Hadoop根目录/etc/hadoop)

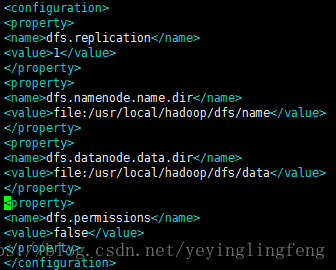

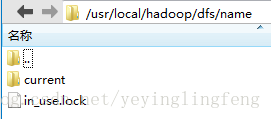

修改如下,并新建usr/local/hadoop/dfs/name 和 data 文件夹。

注dfs.permissions 此处设置为false表示 允许不要检查权限就生成dfs上的文件。只是为了测试方便,实际使用时请设置为true,并使用ssh。

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/dfs/data</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

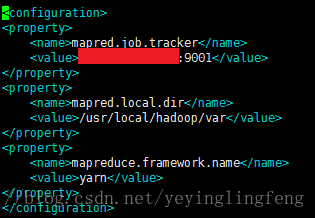

</configuration>配置mapred-site.xml (路径Hadoop根目录/etc/hadoop)

如果不存在就用同目录下的mapred-site.xml.template文件复制重命名一个mapred-site.xml文件

修改如下,并新建/usr/local/hadoop/var文件夹

xx.xx.xx.xx:9001 也可以像前面core-site.xml 配置时一样,将ip改为字符串,例如:

test1:9001

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>xx.xx.xx.xx:9001</value>

</property>

<property>

<name>mapred.local.dir</name>

<value>/usr/local/hadoop/var</value>

</property>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>至此配置完成

3.Hadoop启动

首先第一次启动Hadoop需要初始化

进入Hadoop根目录/bin

运行

./hadoop namenode -format初始化成功后,可以在usr/local/hadoop/dfs/name 目录(core-site.xml中配置的路径)下看到有几个新建的文件,表明初始化已完成。

启动HDFS和YARN

进入Hadoop根目录/sbin

启动HDFS

运行,会提示输入密码,一共3,4次左右。

./start-dfs.sh启动YARN

运行,会提示输入密码。

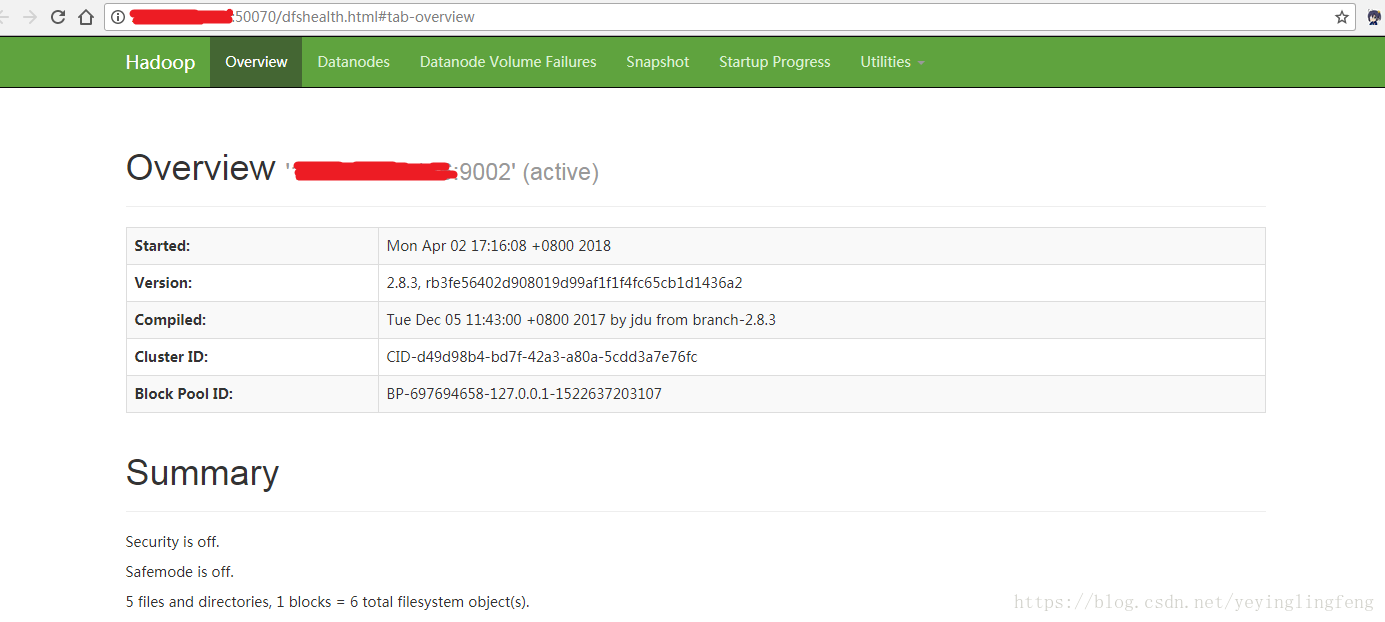

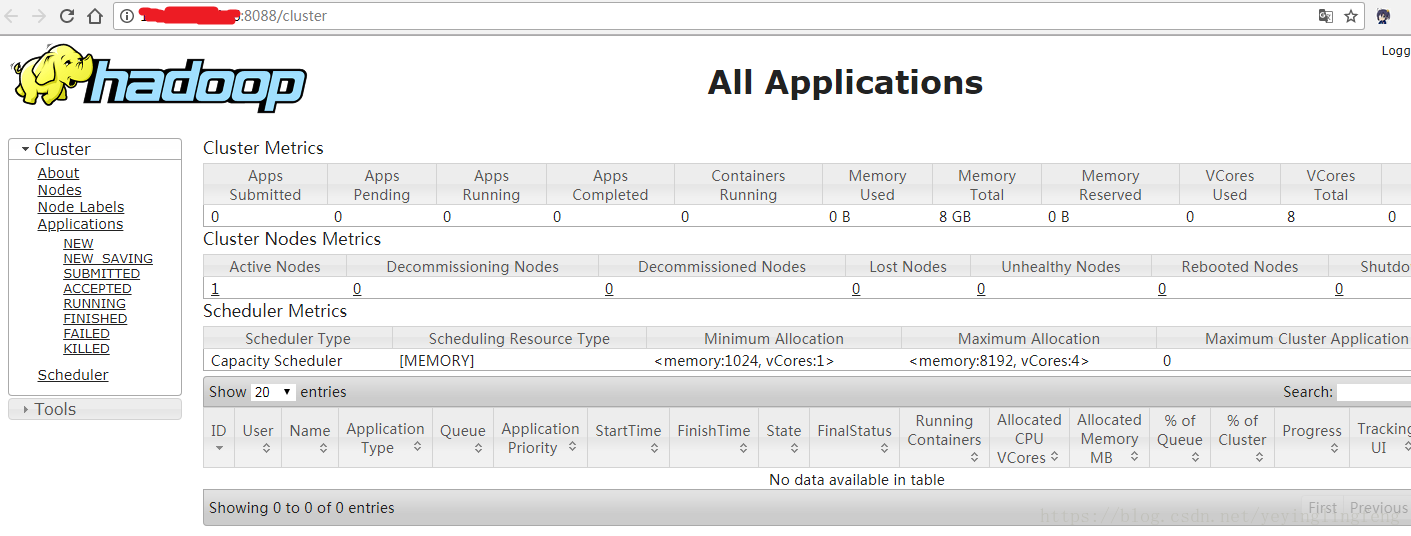

./start-yarn.sh成功启动后,可以查看如下2个网页

http://xx.xx.xx.xx:50070/dfshealth.html#tab-overview

http://xx.xx.xx.xx:8088/cluster

Hadoop2.8.3搭建完毕。