论文

Greedy Function Approximation: A Gradient Boosting Machine

函数估计

假设一组数据中输入变量为

x={x1,⋯,xn}, 输出变量为

y。我们需要找到一个带有参数集合

P={P1,P2,⋯}的函数

F(x;P),将

x映射到

y,并且使得损失函数

L(y,F(x;P))最小:

P∗=argminFEy,xL(y,F(x;P))(1)

其中

Φ(P)=Ey,xL(y,F(x;P))(2)

表示期望损失,然后可以得到

F∗(x)=F(x;P∗)(3)

而想要计算得到

P∗,则可以引入最速下降法。

最速下降法 ( Steepest-descent )

最速下降法是数值优化中的常用方法,用来求解目标函数的极小值。给定一个初始参数

P0,则该处的负梯度方向

−gm就是函数值下降最快的方向,其等于当前损失函数值对各个参数求偏导,然后取负值:

−gm=−{gjm}=−{[∂Pj∂Φ(P)]P=Pm−1}(4)其中

Pm−1=i=0∑m−1pi(5)确定最佳移动步长为

ρm=argminρΦ(Pm−1−ρgm)(6)

那么在负梯度方向上的线性搜索距离

pm=−ρmgm(7)

P∗就是一次次在负梯度方向上移动距离的累加

P∗=i=0∑mpi(8)

函数空间里的数值优化

以上是在参数空间的数值优化,现在考虑函数空间的数值优化。我们把

F(x)在每一个点

x的值作为“参数”,使得

Φ(F)=Ey,xL(y,F(x))(9)因此最优解

F∗(x)=m=0∑Mfm(x)(10)其中

f0(x)是初始值,

{fm(x)}1m是每一次迭代的增量,也就是朝最优解的移动距离。

将该思想和最速下降法结合起来,则

fm(x)=−ρmgm(x)(11)其中,每一次的移动方向为期望损失对当前

F(x)的求导

−gm(x)=−{[∂F(x)∂Φ(F(x))]F(x)=Fm−1(x)}(12)

Fm−1(x)=i=0∑m−1fi(x)(13)而线性搜索方向的移动步长表示为

ρm=argminρEy,xL(y,Fm−1(x)−ρgm(x))(14) 因为是搜索方向是负梯度方向,所以里面是负号。简而言之,这里的思想就是将前一次迭代后损失函数对当前分类器的梯度作为新模型

fm(x)学习的目标,再乘以移动步长

ρm,从而慢慢逼近最优分类器。

Greedy-Wise Approach

因为数据中的样本是有限的,也就是离散的,很难估计出

(y,x)的联合分布,因此貌似还是要用到参数优化的方法。但是一次性优化所有基分类器的参数和权重, 达到全局最优是不可能的,所以需要采取一种名为greedy-stagewise的方法。对于

m=1,2,⋯,M,

(βm,am)=argminβ,ai=1∑NL(yi,Fm−1(xi)+βh(xi;a))(15)

Fm(x)=Fm−1(x)+βh(x;am)(16)

简单来说就是,对于当前分类器

Fm−1(x),想要得到最好的分类器

F∗(x),则基于greedy(贪心)策略,

βmh(x;am)在这里代表最优的迭代(包括方向和距离),stagewise意为逐次迭代。因为直接计算(10)比较困难,根据参考资料2,可能是因为涉及到了函数对于函数的求导吧,

Fm(x)是个涉及之前所有分类器的累加模型,所以求导或许很麻烦,水平有限,不懂。

解决方案是把数据集里的各样本代入

F(x)来计算负梯度,这时演变成了函数对向量的求导:

−gm(xi)=−[∂F(xi)∂L(yi,F(xi))]F(x)=Fm−1(x),i=1,2,⋯,N(17) 但是这个负梯度不可以泛化到除样本点外空间中的其他点,所以需要用

h(x;am)来拟合负梯度。怎么拟合呢?当

h(x;am)和负梯度方向完全平行时,就是最合适的。要求出参数

am, 用公式来表示就是

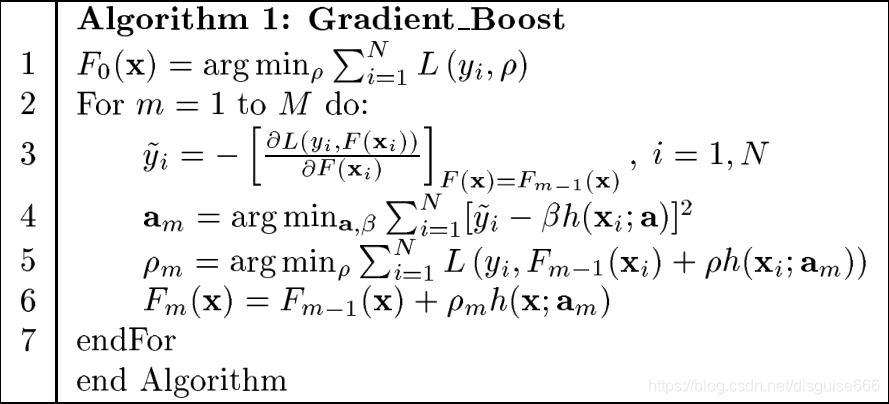

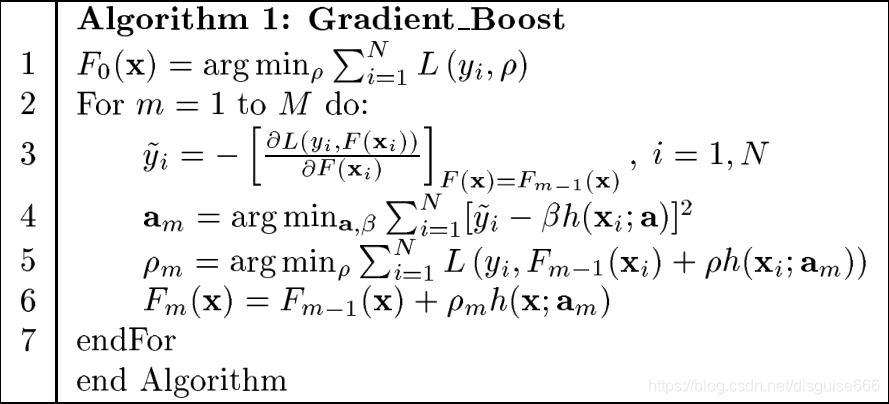

am=argmina,βi=1∑N[−gm(xi)−βh(xi;a)](18)到此,整个Gradient Boost算法如图所示

步骤简述:

- 初始化一个学习器

F0(x);

- 基于之前的学习器

Fm−1(x),计算负梯度

- 利用数据集中的样本点,使用一个基学习器

h(xi;a)来拟合梯度,得到最佳参数

am

- 寻找在

h(xi;a)方向上的最佳移动步长

ρm

- 将之前的学习器

Fm−1(x)和当前新的学习器

ρmh(x;am)累加,得到更强的学习器

- 重复 2 - 5 步

Regression Tree

以j个节点的回归树作为基分类器,公式为:

h(x;{bj,Rj}1j)=j=1∑jbjI(x∈Rj)(19) 可以看出来,回归树本身就是一个累加的模型。其中,

{Rj}1j代表一个个互不相交的区域,也就是回归树里的一个个叶节点,

bj表示每个区域的输出。把回归树模型带入到前面的Gradient Boost算法第六行

Fm(x)=Fm−1(x)+ρmj=1∑JbjmI(x∈Rjm)(20)

Regularization

为了避免过拟合,可以控制回归树的数量M,这可以通过交叉验证来实现。但研究发现,通过shrinkage来正则化效果更佳。原本,当前迭代生成的分类器

Fm(x)=Fm−1(x)+ρmh(x;am)(21)现在新增一个缩小系数,即学习率

v:

Fm(x)=Fm−1(x)+v∗ρmh(x;am),0<v<1(22)实际上这和梯度下降的思想比较像,每一次迭代只基于当前的残差回归树

ρmh(x;am)前进一小部分。另外,

v和M这两者是此消彼长的关系,它们互相影响。事实证明,较小的

v可以提升性能。

参考资料

水平有限,如有错误,欢迎指正!!!