# 1. 概括

- 获取页面: urllib, requests

- 解析页面信息: 正则表达式, BeautifulSoup4(BS4)

# 2. BS4简介

Beautiful Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个

工具箱,通过解析文档为tiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。

你不需要考虑编码方式,除非文档没有指定一个编一下原始编码方式就可以了。

# 3. BS4的4种对象

## 2-1. BeautifulSoup对象

## 2-2. Tag对象

Tag就是html中的一个标签,用BeautifulSoup就能解析出来Tag的具体内容,

具体的格式为soup.name,其中name是html下的标签。

bs4中可以运用的四个解析器

解析器:使用方法:优势:劣势

Python标准库

BeautifulSoup(markup, "html.parser")

Python的内置标准库

执行速度适中

文档容错能力强

Python 2.7.3 or 3.2.2)前 的版本中文档容错能力差

lxml

HTML 解析器 BeautifulSoup(markup, "lxml")

速度快

文档容错能力强

需要安装C语言库

lxml

XML 解析器

BeautifulSoup(markup, ["lxml-xml"])

BeautifulSoup(markup, "xml")

速度快

唯一支持XML的解析器

需要安装C语言库

html5lib

BeautifulSoup(markup, "html5lib")

最好的容错性

以浏览器的方式解析文档

生成HTML5格式的文档

速度慢

不依赖外部扩展

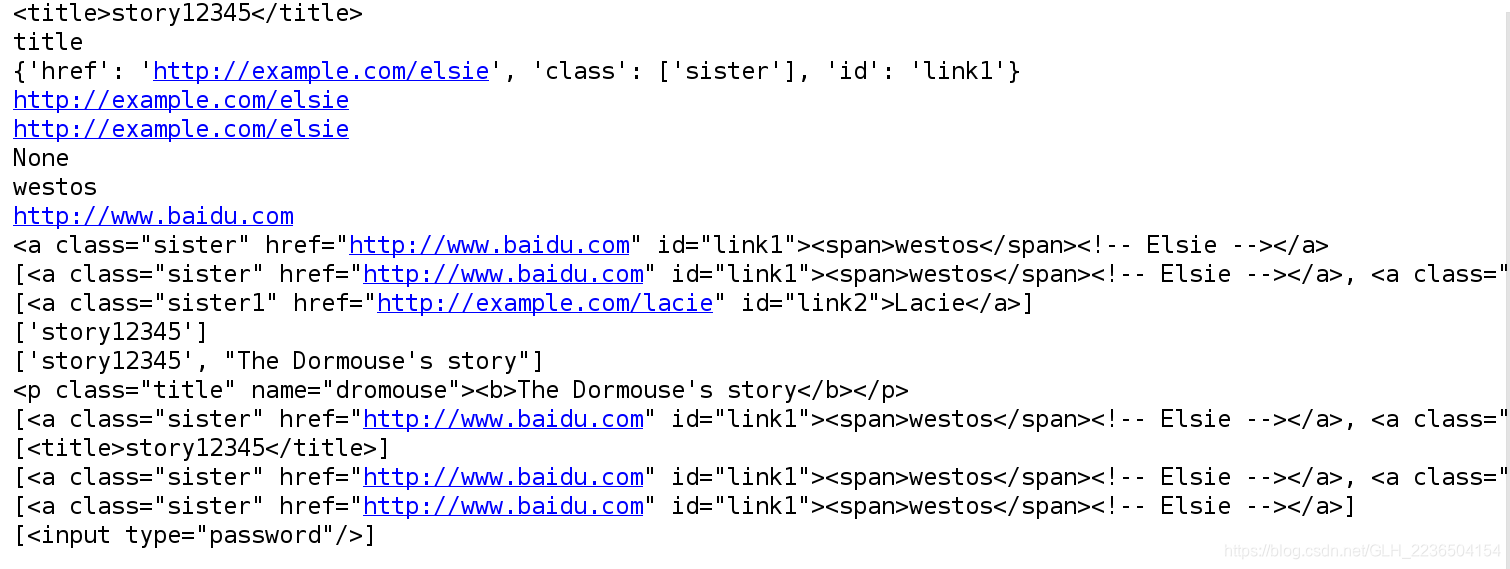

bs4的基本使用方式

import re

from bs4 import BeautifulSoup

html="""

<html>

<head><title>story12345</title></head>

<body>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1"><span>westos</span><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister1" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

<input type='password'>...</input>

"""

#生成一个bs4对象,同时html.parser为html的解析方式

soup=BeautifulSoup(html,'html.parser')

#优化html,使其模式更完整(会补充相应的不完整的标签)

soup.prettify()

# 1. 根据标签获取内容;

# ******************标签的常用属性************************

# # 根据格式化, 如果title只有一个, 根据标签可以获取

print(soup.title)

# 标签的名称

print(soup.title.name)

# 获取标签里面的属性信息

print(soup.a.attrs)

# # *******************标签常用的方法*************************

# #get方法用于得到标签下的属性值,注意这是一个重要的方法,在许多场合都能用到,

# 如你要得到<img src=”#”>标签下的图像url,那么就可以用soup.img.get(‘src’)

print(soup.a.get('href'))

#或者直接得到属性里面的内容

print(soup.a.attrs['href'])

# string得到标签下的文本内容,只有在此标签下没有子标签,

# 或者只有一个子标签的情况下才能返回其中的内容,否则返回的是None;

# get_text()可以获得一个标签中的所有文本内容,包括子孙节点的内容,这是最常用的方法

print(soup.a.string) # 标签里面的内容

print(soup.a.get_text())

# *******************对获取的属性信息进行修改***********************

soup.a['href']='http://www.baidu.com'

print(soup.a['href'])

# # 2. 面向对象的匹配

#查找符合条件的第一个标签;

print(soup.find('a'))

# 查找符合条件的所有标签;

print(soup.find_all('a'))

# 需求: 获取所有的a标签, 并且类名为"sister1"

print(soup.find_all('a',class_='sister1'))

# 3. 根据标签里内容进行匹配

print(soup.find_all(text="story12345"))

#如果不确定标签里内容,可以模糊查找(re模块重新编译以正则表达式的方式查找要编译的内容)

print(soup.find_all(text=re.compile('.*?story.*?')))

##综合运用

#查找第一个p标签下属性class属性以ti开头的标签所有属性信息

print(soup.find('p',class_=re.compile(r'^ti.*?')))

#查找title或者a标签下属性class为title或者sister的标签所有属性信息

print(soup.find_all(['title', 'a'], class_=['title', 'sister']))

# 4. CSS匹配

# 标签选择器

print(soup.select("title"))

# 类选择器(.类名)

print(soup.select(".sister"))

# id选择器(#id名称)

print(soup.select("#link1"))

# 属性选择器()

print(soup.select("input[type='password']"))

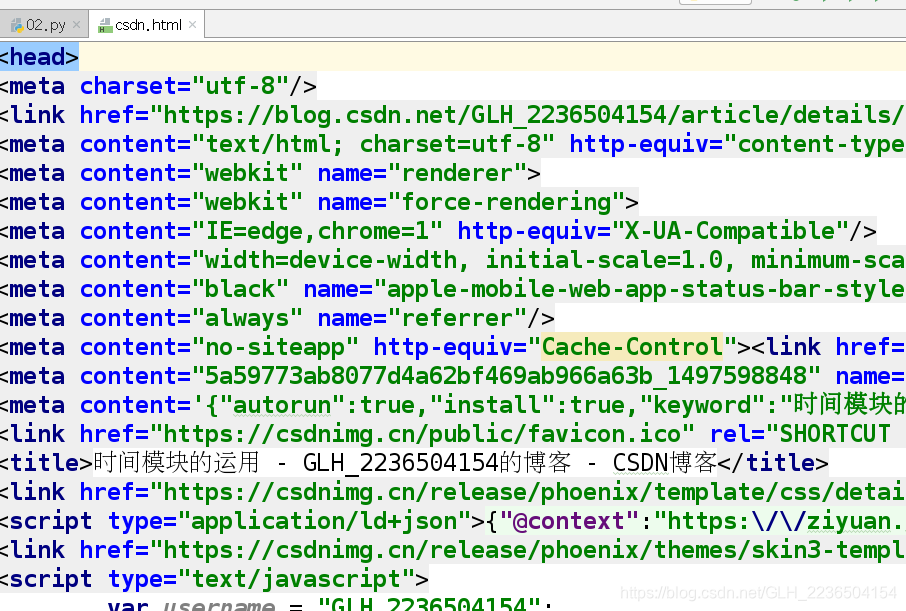

-爬取个人博客_去掉广告与导航栏

1.解析url地址

2.分析解析后的页面信息,查找自己需要的信息

3.保存为html格式

"""

import requests

from bs4 import BeautifulSoup

#解析url地址,

def get_content(url):

try:

#获得浏览器,并以浏览器的方式爬去网页

user_agent='Mozilla/5.0 (X11; Linux x86_64; rv:38.0) Gecko/20100101 Firefox/38.0'

#,解析url地址,获得反馈,设置头部信息

response=requests.get(url,headers={'User-Agent':user_agent})

# 如果返回的状态码不是200, 则抛出异常

response.raise_for_status()

# 判断网页的编码格式, 便于respons.text知道如何解码;

response.encoding=response.apparent_encoding

except Exception as e:

print('爬取错误')

print(e)

else:

print('爬取成功')

#返回的是bytes类型的数据

return response.content

#返回的是str类型的数据

#return response.text

#解析页面信息

def parser_content(html):

# 实例化soup对象, 便于处理;

soup=BeautifulSoup(html,'html.parser')

# 提取页面的头部信息, 解决乱码问题

headobj=soup.head

# 提取需要的内容,第0个索引是把他从列表里拿出来;

divobj=soup.find_all('div',class_='blog-content-box')[0]

#提取连接外部JS的信息

scritobj=soup.script

with open ('doc/csdn.html','w') as f:

# 写入头部信息(指定编码格式和标题)

f.write(str(headobj))

# 写入博客正文;

f.write(str(divobj))

# 写入js信息

f.write(str(scritobj))

print('下载成功...')

if __name__ == '__main__':

url='https://blog.csdn.net/GLH_2236504154/article/details/87119849'

html=get_content(url)

parser_content(html)

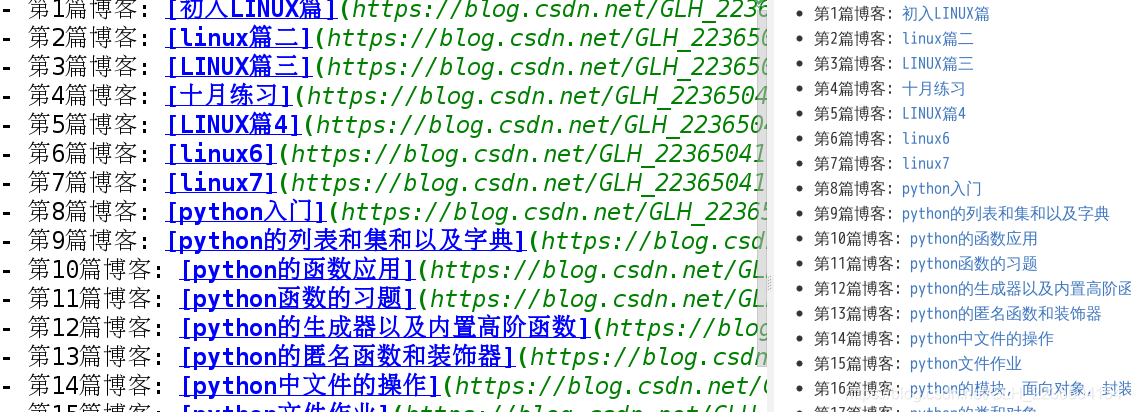

个人博客的整理

import requests

from bs4 import BeautifulSoup

#解析url地址,

def get_content(url):

try:

#获得浏览器,并以浏览器的方式爬去网页

user_agent='Mozilla/5.0 (X11; Linux x86_64; rv:38.0) Gecko/20100101 Firefox/38.0'

#,解析url地址,获得反馈,设置头部信息

response=requests.get(url,headers={'User-Agent':user_agent})

# 如果返回的状态码不是200, 则抛出异常

response.raise_for_status()

# 判断网页的编码格式, 便于respons.text知道如何解码;

response.encoding=response.apparent_encoding

except Exception as e:

print('爬取错误')

print(e)

else:

print('爬取成功')

#返回的是bytes类型的数据

return response.content

#返回的是str类型的数据

#return response.text

def parser_content(html):

# 实例化soup对象, 便于处理;

soup=BeautifulSoup(html,'html.parser')

# 1). 获取每个博客的大盒子:

# 特征: div标签, class名称一致article-item-box csdn-tracking-statistics

divobjs=soup.find_all('div',class_='article-item-box csdn-tracking-statistics')

# 2). 依次遍历每一个div标签, 获取博客标题

# 博客标题的特征: h4里面的a标签里面的内容

# 去掉默认的广告, 留下个人的博客内容;

for divobj in divobjs[1:]:#对象内第一个是广告

#获取博客标题: 去掉原创或者转载的信息, 只需要博客名称;

title=divobj.h4.a.get_text().split()[1]

#获取博客链接, 也就是获取a链接中href对应的值;

blogurl=divobj.h4.a.get('href')

#将爬取的所有内容都保存的到列表中

bloginfo.append((title,blogurl))

return bloginfo

def save_parser(bloginfo):

with open ('doc/mybolg.md','a') as f:

#博客是从最新的开始,第一篇博客在最后,所以需要反转

for index,info in enumerate(bloginfo[::-1]):

f.write('- 第%d篇博客: [%s](%s)\n'%(index+1,info[0],info[1]))

print('第写入完成..')

if __name__ == '__main__':

blogpage=2

# 全局变量, 用于保存所有博客信息;

bloginfo=[]

for page in range(1,blogpage+1):

url='https://blog.csdn.net/GLH_2236504154/article/list/%d?' %page

html=get_content(url)

parser_content(html)

save_parser(bloginfo)

csv的写入和读取

csv格式存储: csv文件格式是一种通用的电子表格和数据库导入导出格式。

1:西安邮电:西安:90

1,西安邮电,西安,90

# 读取csv文件

import csv

with open('some.csv', 'rb') as f: # 采用b的方式处理可以省去很多问题

reader = csv.reader(f)

for row in reader:

# do something with row, such as row[0],row[1]

import csv

with open('some.csv', 'wb') as f: # 采用b的方式处理可以省去很多问题

writer = csv.writer(f)

writer.writerows(someiterable)

"""

import csv

with open('doc/example.csv', 'w') as f:

writer = csv.writer(f)

# 将列表的每条数据依次写入csv文件, 并以逗号分隔

writer.writerows([['1', '2', '3'], ['4', '5', '6']])

with open('doc/example.csv', 'r') as f:

reader = csv.reader(f)

for row in reader:

print(row)

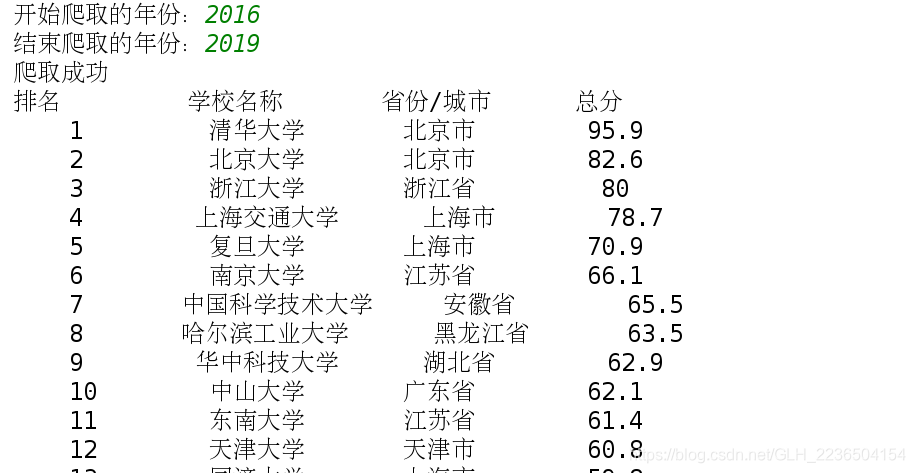

中国最好大学排名信息爬取

import csv

import requests

from bs4 import BeautifulSoup

import bs4

#解析url地址,

def get_content(url):

try:

#获得浏览器,并以浏览器的方式爬去网页

user_agent='Mozilla/5.0 (X11; Linux x86_64; rv:38.0) Gecko/20100101 Firefox/38.0'

#,解析url地址,获得反馈,设置头部信息

response=requests.get(url,headers={'User-Agent':user_agent})

# 如果返回的状态码不是200, 则抛出异常

response.raise_for_status()

# 判断网页的编码格式, 便于respons.text知道如何解码;

response.encoding=response.apparent_encoding

except Exception as e:

print('爬取错误')

print(e)

else:

print('爬取成功')

#返回的是bytes类型的数据

return response.content

#返回的是str类型的数据

#return response.text

def parser_content(html):

"""解析页面内容, 需要获取: 学校排名, 学校名称, 省份, 总分"""

soup=BeautifulSoup(html,'lxml')

# 该页面只有一个表格, 也只有一个tbody标签;

# 获取tbosy里面的所有子标签, 返回的是生成器: soup.find('tbody').children

# 获取tbosy里面的所有子标签, 返回的是列表: soup.find('tbody').contents

messages=[]

for tr in soup.find('tbody').children:

# 有可能没有内容, 获取的tr标签不存在, 判断是否为标签对象?

if isinstance(tr,bs4.element.Tag):

# 返回tr里面的所有td标签;

tds=tr('td')

# 将每个学校信息以元组的方式存储到列表变量messages中;

messages.append((tds[0].string,tds[1].string,tds[2].string,tds[3].string))

return messages

def printmessages(messages):

#打印学校信息

# format的使用: {0} 变量的位置, 冒号后面执行属性信息: ^10占10个字节位置, 并且居中

print('{0:10} {1:10} {2:10} {3:10}'.format("排名", '学校名称', "省份/城市", "总分"))

for item in messages:

print("{0:^10} {1:^10} {2:^10} {3:^10}".format(item[0], item[1], item[2], item[3]))

def save_csv(messages,year):

with open('doc/colloge_%s.csv'%year,'w') as f:

writer=csv.writer(f)

# 将列表的每条数据依次写入csv文件, 并以逗号分隔

writer.writerows(messages)

if __name__ == '__main__':

start_year=int(input('开始爬取的年份:'))

end_year=int(input('结束爬取的年份:'))

#爬取多年的排名信息并分别保存

for year in range(start_year,end_year+1):

url='http://www.zuihaodaxue.com/zuihaodaxuepaiming%s.html'%year

html=get_content(url)

messages=parser_content(html)

printmessages(messages)

save_csv(messages,year)

print("%s年信息爬取成功......" %(year))