版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/Triple_WDF/article/details/87732497

定义:

:步长

:第(l-1)层隐藏层的第i个神经元------------>第(l)层隐藏层的第j个神经元的连线的权值

:第(l)层隐藏层的第j个神经元的偏量bias,下面的图片中的

就是

:

一、目标函数:

此处的y是向量(样本提供的标准答案),

是神经网络的输出向量。

由于神经网络是每注入一个样例,更新一次参数的,所以,考虑到注入一个样例的情况,其目标函数是: ,其中outputs表示神经网路的最终结果的可能性个数。

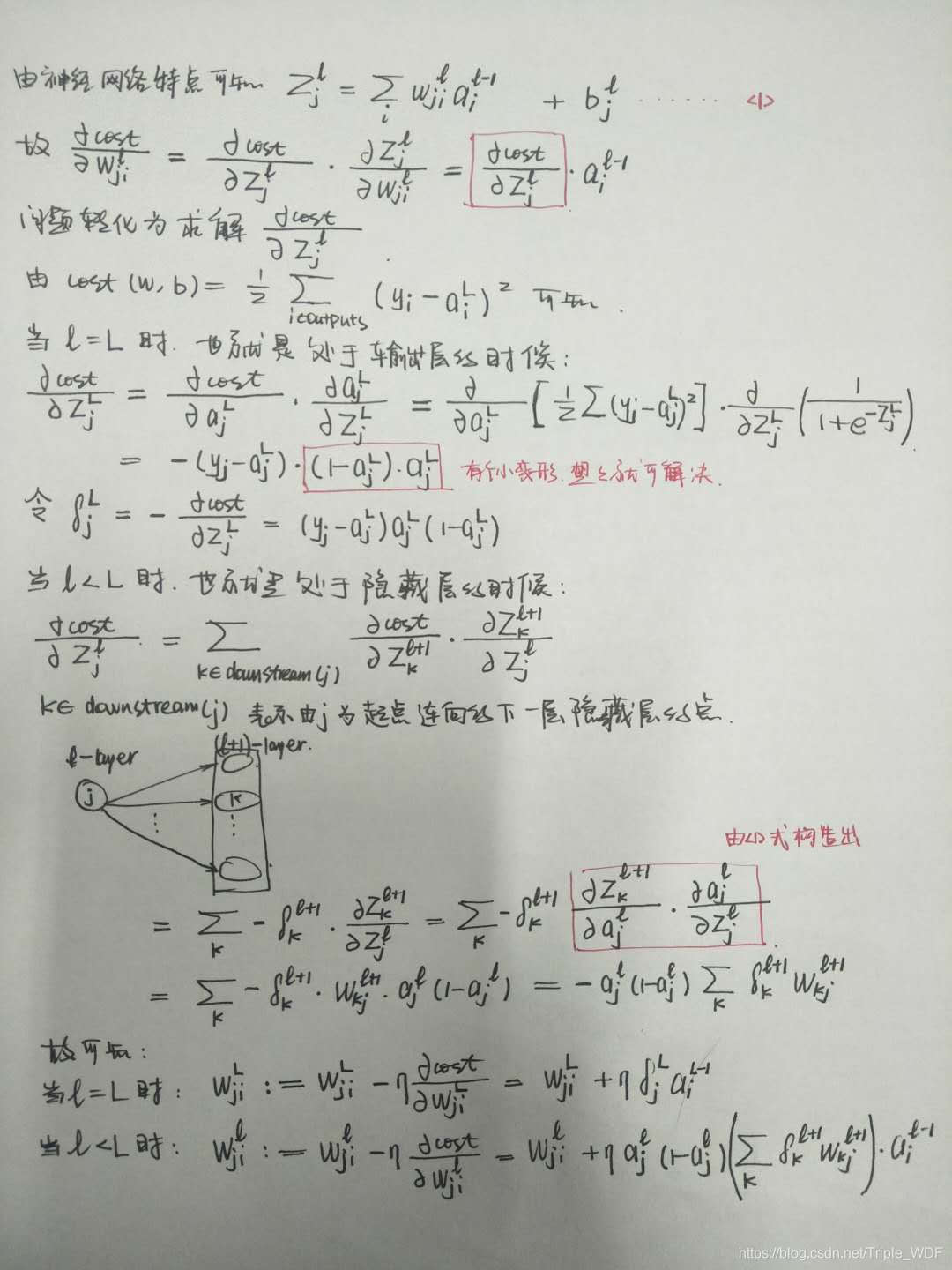

二、两个参数的更新方程:

现在为题转化为如果求解,

,下面给出详细求解过程:

至此BackPropagation算法推导完毕。