信息基础Homework3

1.实验作业:

在LeNet-5网络中的C1卷积层中,尝试使用不同的卷积核。对比5✖5和3✖3的实验效果。

本周实验作业实现LeNet-5的前向传播过程,不使用其他框架,从底层写起。建立自己的库。

2.分享:MNIST库实现手写数字识别的可视化操作(双击666)

http://scs.ryerson.ca/~aharley/vis/conv/

3.在神经网络中对参数进行初始化时全部设置为0是否可行?

https://zhuanlan.zhihu.com/p/27190255

简而言之就是参数初始化不仅仅时不能全部设为0,而是不能初始化为一个相同的值,因为这样反向BP算法求解的时候,梯度计算的都是一样的,权重更新也是相同的。将会导致模型失效,无法收敛。

4.max 函数的导数

一:导数的定义:

https://zh.wikipedia.org/zh-hans/导数

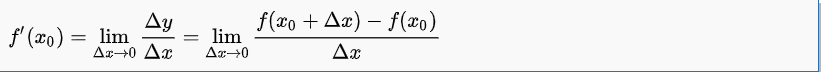

一个函数在某一点的导数描述了这个函数在这一点附近的变化率。导数的本质是通过极限的概念对函数进行局部的线性逼近。当函数f的自变量在一点x_{0}上产生一个增量h时,函数输出值的增量与自变量增量h的比值在h趋于0时的极限如果存在,即为f在x_{0}处的导数。

二:L1正则和max函数的可导性?

https://www.zhihu.com/question/275630890

max的求导就是max(a, 0), a>=0, 求导为1,否则为0。

5.求解深度网络的方法:

一:浅谈神经网络训练方法

https://www.leiphone.com/news/201609/8tIJfoZ7URpUBhPc.html

二:一文弄懂神经网络中的反向传播法——BackPropagation

https://www.cnblogs.com/charlotte77/p/5629865.html

三:MIT最新算法,双向传播比BP快25倍深度学习

https://blog.csdn.net/AMDS123/article/details/70667554

6.VGG16中3个3×3卷积核对AlexNet中7×7卷积核的替代性分析

https://zhuanlan.zhihu.com/p/41423739 (同时对VGG 做了很详细的分析)

- VGG16和VGG19的对比图

PPT的图是不对的

VGG全连接层有3层,根据卷积层+全连接层总数目的不同可以从VGG11 ~ VGG19,最少的VGG11有8个卷积层与3个全连接层,VGG16有13个卷积层+3个全连接层,最多的VGG19有16个卷积层+3个全连接层,此外VGG网络并不是在每个卷积层后面跟上一个池化层,还是总数5个池化层,分布在不同的卷积层之下,下图是VGG11 ~GVV19的结构图: